谷歌:假如AI大模型支持无限长上下文,会如何?

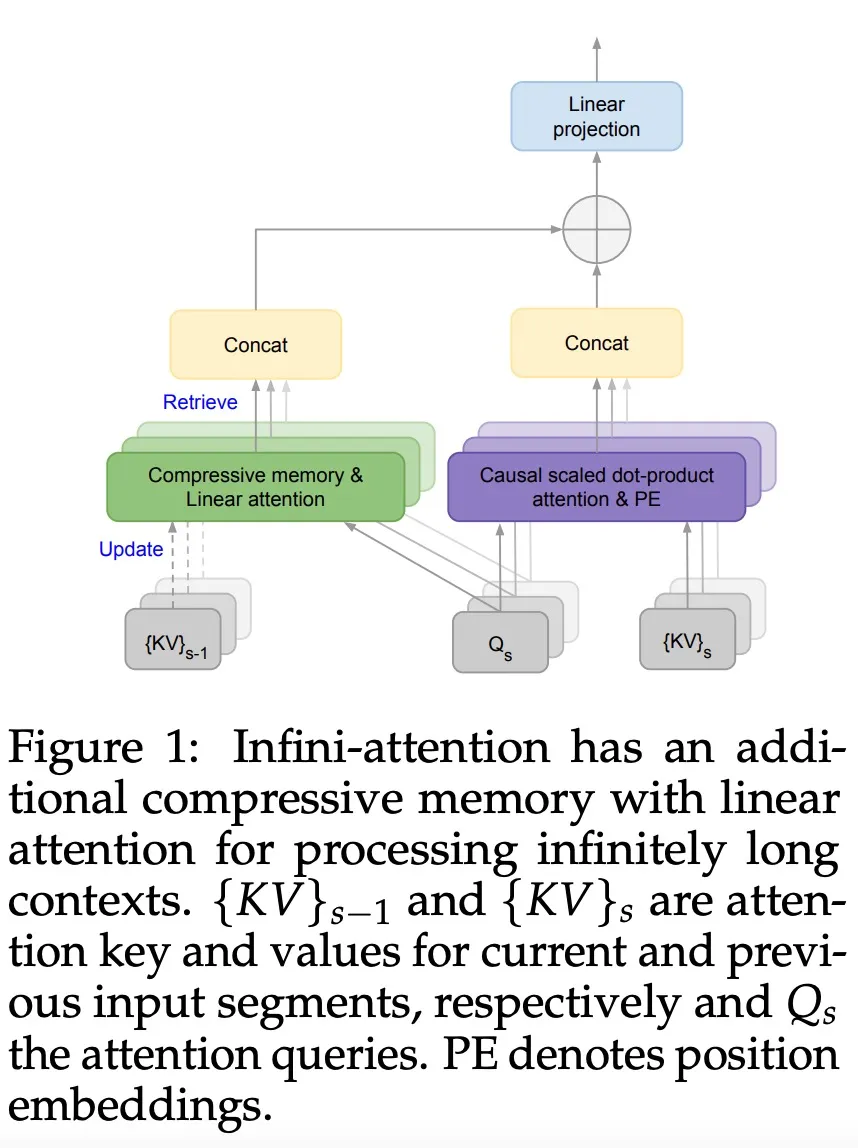

谷歌:假如AI大模型支持无限长上下文,会如何?为解决大模型(LLMs)在处理超长输入序列时遇到的内存限制问题,本文作者提出了一种新型架构:Infini-Transformer,它可以在有限内存条件下,让基于Transformer的大语言模型(LLMs)高效处理无限长的输入序列。实验结果表明:Infini-Transformer在长上下文语言建模任务上超越了基线模型,内存最高可节约114倍。

为解决大模型(LLMs)在处理超长输入序列时遇到的内存限制问题,本文作者提出了一种新型架构:Infini-Transformer,它可以在有限内存条件下,让基于Transformer的大语言模型(LLMs)高效处理无限长的输入序列。实验结果表明:Infini-Transformer在长上下文语言建模任务上超越了基线模型,内存最高可节约114倍。

它通过将压缩记忆(compressive memory)整合到线性注意力机制中,用来处理无限长上下文

随着大模型的参数量日益增长,微调整个模型的开销逐渐变得难以接受。 为此,北京大学的研究团队提出了一种名为 PiSSA 的参数高效微调方法,在主流数据集上都超过了目前广泛使用的 LoRA 的微调效果。

谷歌又放大招了,发布下一代 Transformer 模型 Infini-Transformer。

今天起,最新版的GPT-4 Turbo,正式向ChatGPT Plus用户开放了

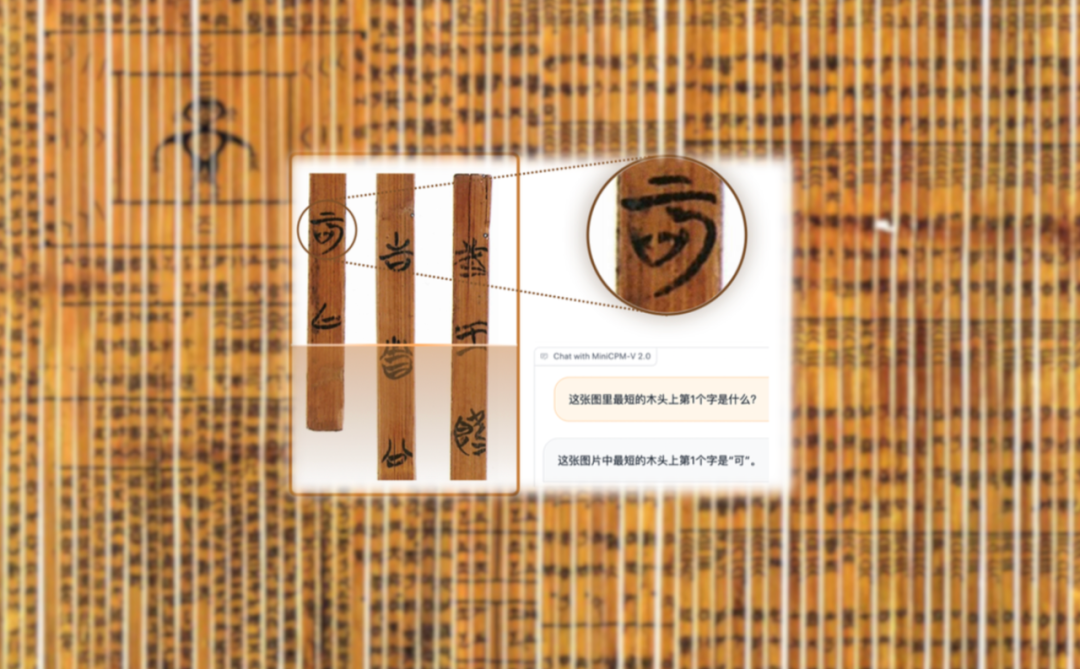

识读距今2300多年战国时期的上古竹简,AI正在立功。 而且在这背后的“大功臣”,竟是只有2B大小的多模态大模型!

一年多来,大模型技术的进步日新月异,模型能力的上限不断抬高。但从产业变革的角度看,大模型的落地或许刚刚处于开端阶段。如何才能发挥出大模型的巨大潜力,并推动生产力更快更好地变革,仍然是一个充满探索空间的课题。

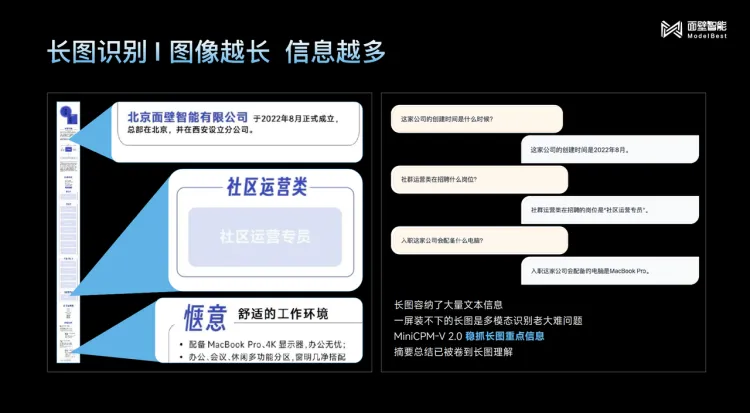

时隔七十多天,面壁在发布了MiniCPM-2B后又带来四个特性鲜明的模型,同时它还官宣了数亿元的新融资。

李彦宏对大模型开源与闭源的路线选择以及AI创业者应该专注模型还是应用等业界焦点话题,发表了自己的看法

AI“复活”正从一个体验式的产品,逐渐成为一条产业链