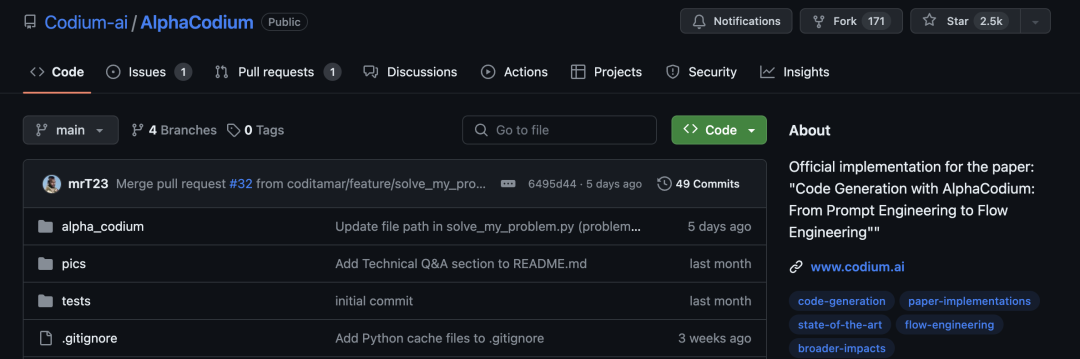

Github2.5k星,Karpathy转赞,「流程工程」让LLM代码能力瞬间翻倍,直接淘汰提示工程

Github2.5k星,Karpathy转赞,「流程工程」让LLM代码能力瞬间翻倍,直接淘汰提示工程Karpathy力推代码生成任务增强流程,让GPT-4在CodeContests从19%提升到44%,不用微调不用新数据集训练,让大模型代码能力大幅提升。

Karpathy力推代码生成任务增强流程,让GPT-4在CodeContests从19%提升到44%,不用微调不用新数据集训练,让大模型代码能力大幅提升。

奥特曼称,OpenAI计划将部分大模型开源,还谈到了GPT-5。他称人工智能将“像手机一样”改变世界,OpenAI将开源更多大模型,ChatGPT 5将变得更加智能,同时呼吁将阿联酋打造为全球监管人工智能的试验场。

人工智能诈骗已成现实,引人忧虑。近几个月来,人工智能接连浮现,我们频繁在新闻标题中看到如下字眼:AI 泄露了公司代码,还根本就删不掉;AI 软件侵犯了用户的人脸信息隐私;某大模型产品被曝泄露私密对话……等等。

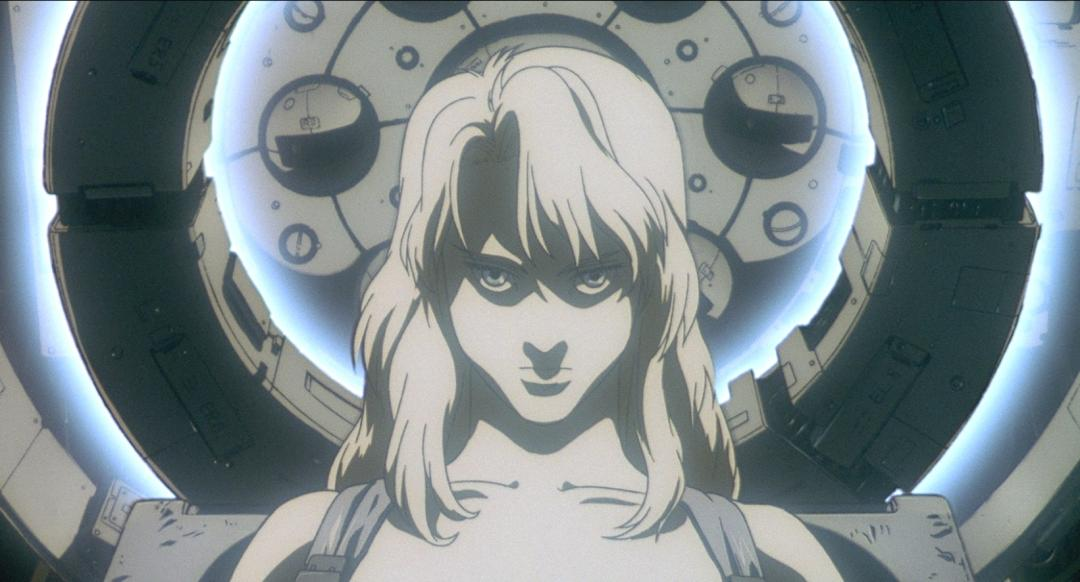

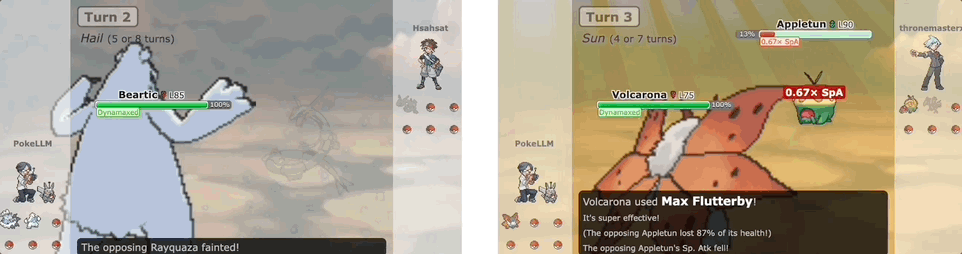

基于大模型的Agent会玩宝可梦了,人类水平的那种!名为PokéLLMon,现在它正在天梯对战中与人类玩家一较高下:

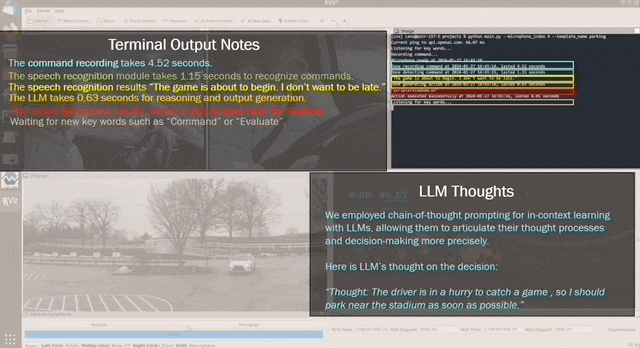

现在一句口令,就能指挥汽车了。比如说声“我开会要迟到了”“我不想让我朋友等太久”等等,车就能理解,并且自动加速起来。

大模型的新考验来了!近日,来自卡内基梅隆大学的研究人员发布了评估LLM多模态Web代理性能的基准测试。

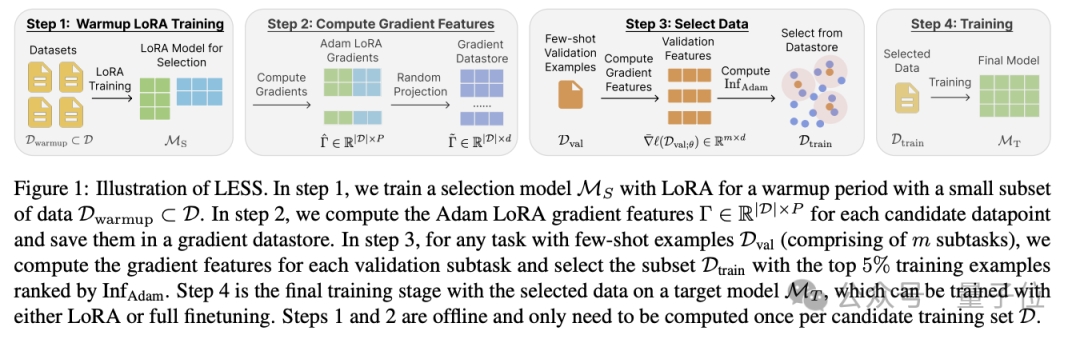

造大模型的成本,又被打下来了!这次是数据量狂砍95%的那种。陈丹琦团队最新提出大模型降本大法——数据选择算法LESS, 只筛选出与任务最相关5%数据来进行指令微调,效果比用整个数据集还要好。

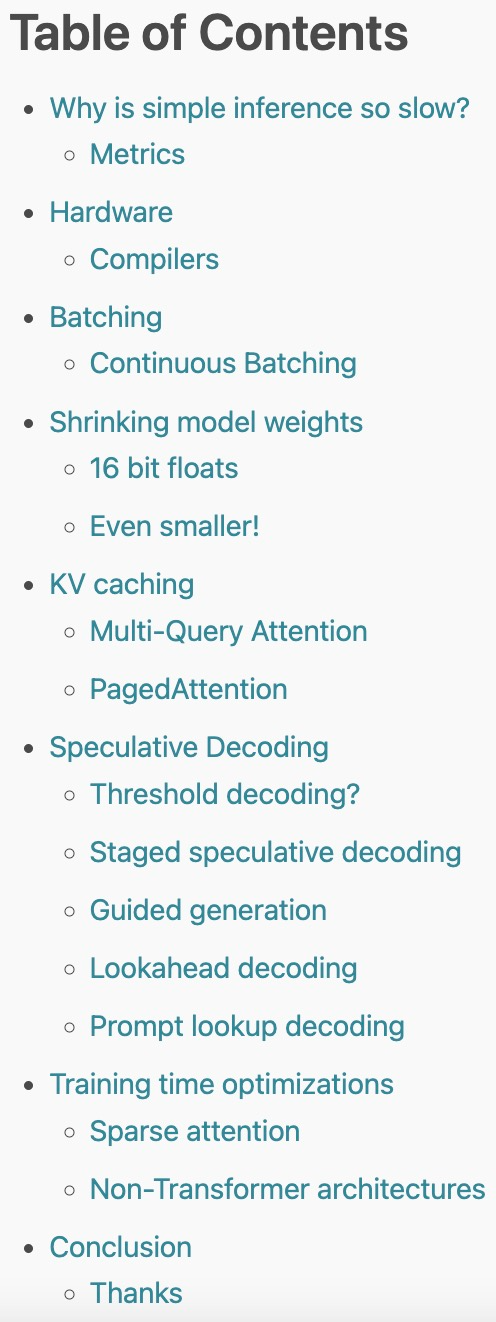

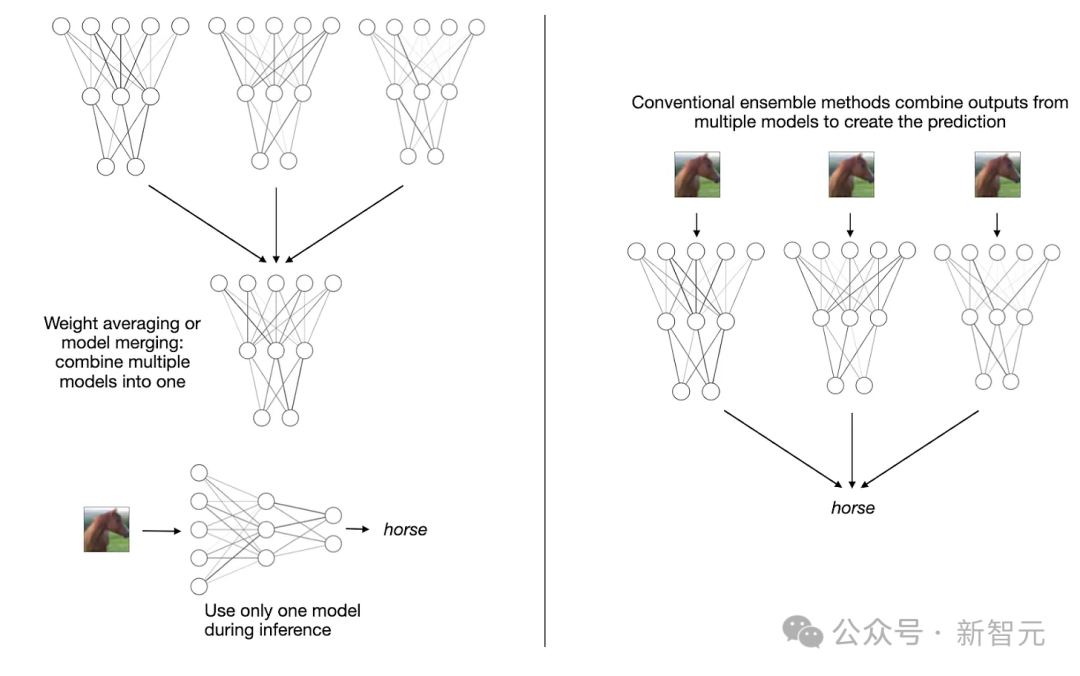

2023 年,大型语言模型(LLM)以其强大的生成、理解、推理等能力而持续受到高度关注。然而,训练和部署 LLM 非常昂贵,需要大量的计算资源和内存,因此研究人员开发了许多用于加速 LLM 预训练、微调和推理的方法。

混合专家(MoE)架构已支持多模态大模型,开发者终于不用卷参数量了!北大联合中山大学、腾讯等机构推出的新模型MoE-LLaVA,登上了GitHub热榜。

AI大模型并非越大越好?过去一个月,关于大模型变小的研究成为亮点,通过模型合并,采用MoE架构都能实现小模型高性能。