多模态大模型学杂了能力反下降?新研究:MoE+通用专家解决冲突

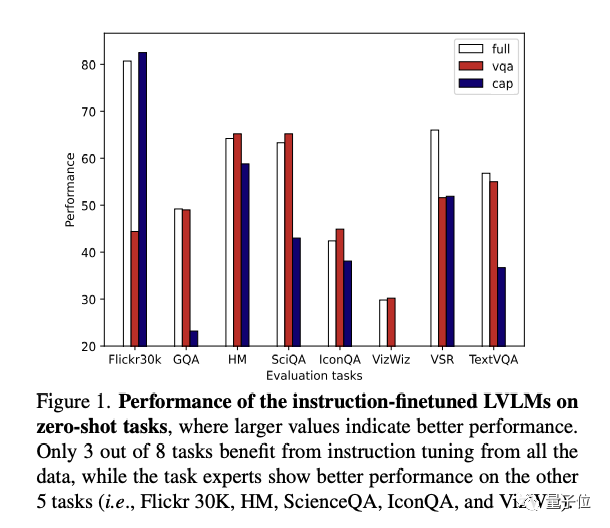

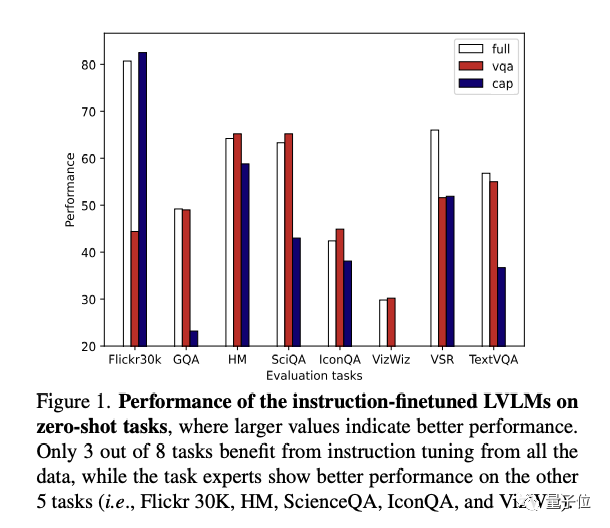

多模态大模型学杂了能力反下降?新研究:MoE+通用专家解决冲突多模态大模型做“多任务指令微调”,大模型可能会“学得多错得多”,因为不同任务之间的冲突,导致泛化能力下降。

多模态大模型做“多任务指令微调”,大模型可能会“学得多错得多”,因为不同任务之间的冲突,导致泛化能力下降。

向量存储检索是个真需求,然而专用向量数据库已经凉了。

价格战、估值缩水、市值腰 斩、持续亏损、股价暴跌、资本退潮,入局一家亏损一家成为常态。 国内 SaaS产业从2015年至今历经8年探索,且在大量资本热钱涌入下,仍未找到清晰的盈利模型。

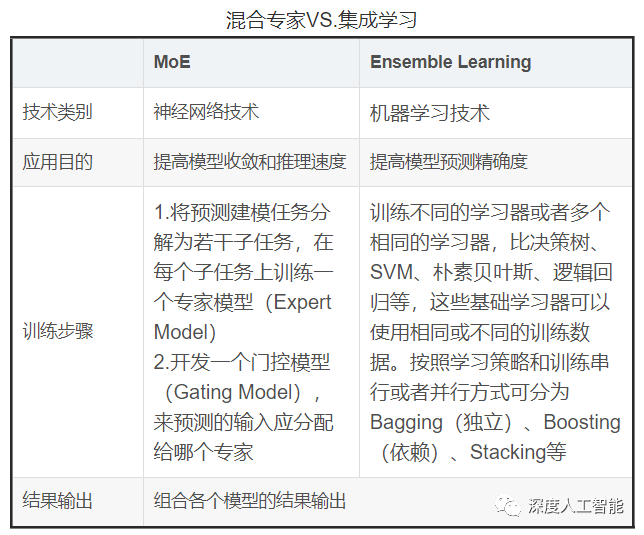

混合专家模型(MoE)成为最近关注的热点。

2024年,优化训练和部署大模型仍然非常重要,大模型的生态加速形成,应用开始在一些领域大规模展开,主要表现在如下十个领域:

在即将过去的2023年里,“大模型”无疑是最能挑动神经的话题,AI还在进化但已经成为显学。“百模大战”让很多创业项目的估值水涨船高,行业直接进入大厂竞争时代。

2023年12月13日,全球科技顶刊《Nature》发布年度十大人物,与以往不同的是,今年的Nature’s 10额外增加了一个非人类,ChatGPT。

智能搜索AI创新健康领域,减低大模型幻觉率,提供更专业、准确的健康信息

李开复表示,中国人工智能领域的竞争仍然处在预选赛阶段,大多数企业要么半途而废,要么转向更实际的目标。他认为中国大模型公司需要证明自己有能力开发高质量的模型,并实现盈利。

今年国产大模型的最后一声枪响,属于百度:发布仅2个月,文心大模型4.0,能力又提升了32%。