Transformer大杀器进入蛋白质组学,一文梳理LLM如何助力生命科学领域大变革

Transformer大杀器进入蛋白质组学,一文梳理LLM如何助力生命科学领域大变革科学家们把Transformer模型应用到蛋白质序列数据中,试图在蛋白质组学领域复制LLM的成功。本篇文章能够带你了解蛋白质语言模型(pLM)的起源、发展,以及那些尚待解决的问题。

科学家们把Transformer模型应用到蛋白质序列数据中,试图在蛋白质组学领域复制LLM的成功。本篇文章能够带你了解蛋白质语言模型(pLM)的起源、发展,以及那些尚待解决的问题。

最近几年,随着大语言模型的飞速发展与迭代,科技巨头们都竞相投入巨额财力打造超级计算机(或大规模 GPU 集群)。他们认为,更强大的计算能力是实现更强大 AI 的关键。

36氪从多个独立信源处获悉,字节跳动大语言模型研发技术专家杨红霞,已于近日从字节跳动离职,并开始筹备AI创业项目。

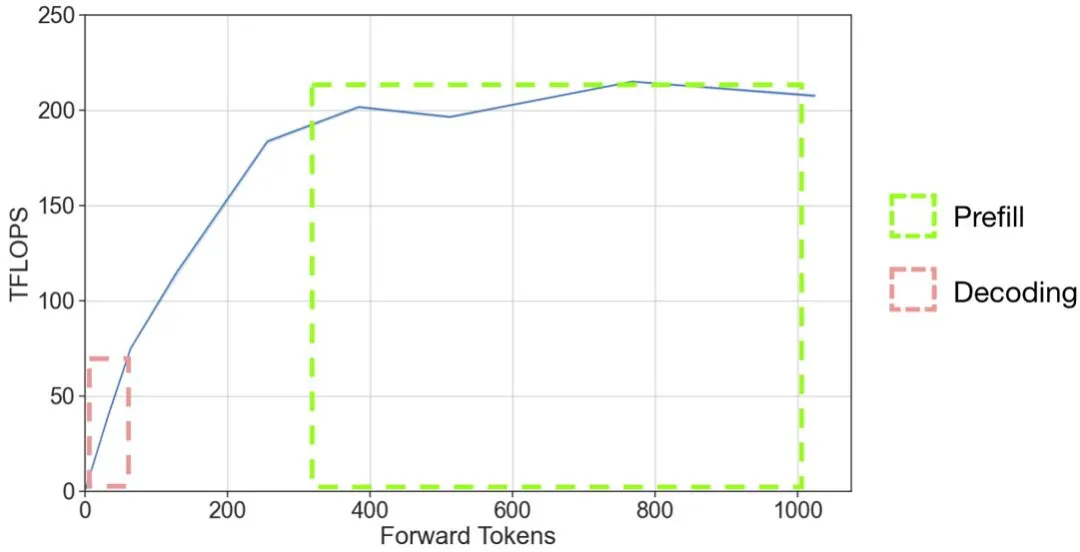

以 OpenAI 的 GPT 系列模型为代表的大语言模型(LLM)掀起了新一轮 AI 应用浪潮,但是 LLM 推理的高昂成本一直困扰着业务团队。

近日,西交微软北大联合提出信息密集型训练大法,使用纯数据驱动的方式,矫正LLM训练过程产生的偏见,在一定程度上治疗了大语言模型丢失中间信息的问题。

此次,苹果提出的多模态大语言模型(MLLM) Ferret-UI ,专门针对移动用户界面(UI)屏幕的理解进行了优化,其具备引用、定位和推理能力。

5月14日,开源的大语言模型Falcon 2发布,性能超越Llama 3,消息登上了Hacker News热榜第一。「猎鹰」归来,开源宇宙将会迎来新的霸主吗?

大语言模型可谓是迄今为止对人类行为最大的建模,如何借助大语言模型工具,让科技发展更好地应用到真实人类社会中去?从哈佛物理系到大语言模型结合社会学和经济学的研究,朱科航的思考路径,聚焦在对人类行为的深度学习和理解。在开始今天阅读之前,大家不妨先猜一猜,大语言模型之前人类应用最广的 TOP2 机器学习是什么?Enjoy

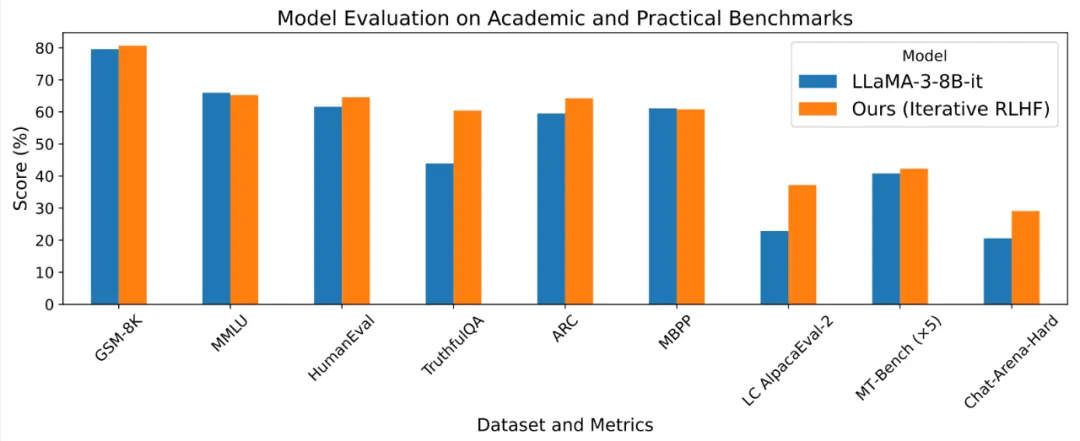

基于人类反馈的强化学习 (RLHF) 使得大语言模型的输出能够更加符合人类的目标、期望与需求,是提升许多闭源语言模型 Chat-GPT, Claude, Gemini 表现的核心方法之一。

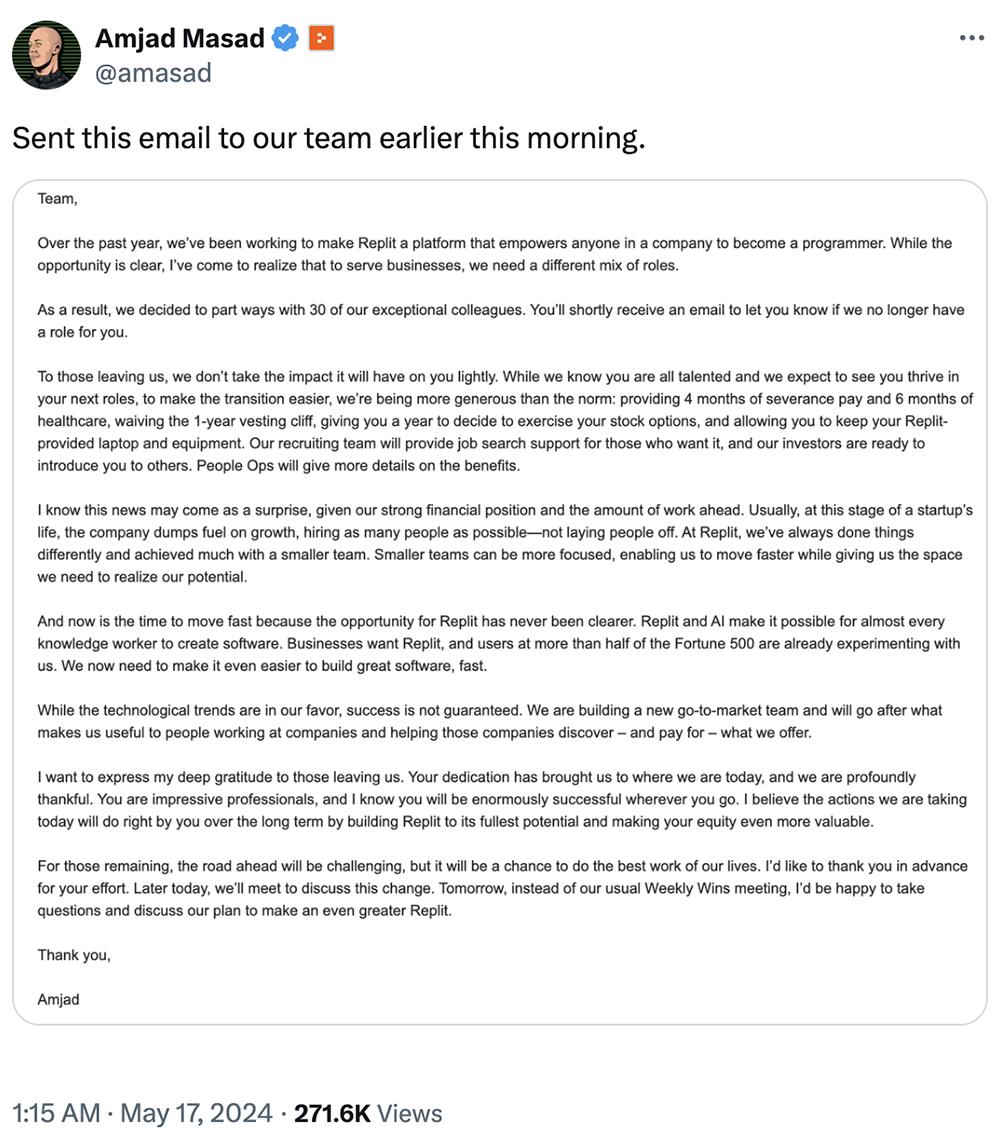

智东西5月17日消息,一夜之间,多家美国生成式AI创企被曝身陷资金短缺危机:美国旧金山AI编程独角兽Replit今日凌晨宣布裁员20%,共30人.大语言模型创企Reka AI被曝可能以10亿美元被数据存储和分析公司Snowflake收购。