OpenAI真的开源了!这波「实时语音」操作,让万物开口说话,我爱了

OpenAI真的开源了!这波「实时语音」操作,让万物开口说话,我爱了家人们!OpenAI 这 12 天的连续剧大家都追完了吗?别急着下线!

家人们!OpenAI 这 12 天的连续剧大家都追完了吗?别急着下线!

你是不是以为发了GPT4.5?但很抱歉,今天只是发布了o1的API以及实时语音的新玩意。 还记得前段时间的OpenAI的DevDay吗?那上面曾经说过会更新OpenAI的API,现在期货交割了!这次OpenAI表现很好,才用了短短的一个多月就完成了交割,值得鼓励!(我是在吹不下去了。。。)

今天是美国的周一,本来以为会跟上周一样,挑选周一发个大货,毕竟上周就有爱好探索的网友发现 GPT4o 好像有了更新,已经开始说自己是 GPT4.5 了。

“它前进着,又跨过了新的一级台阶,耳边仿佛传来由远及近的低语:前方,即是世界。”

OpenAI的实时API支持低延迟、双向音频流,使得多模态AI应用(如语音对话Agent)得以实现。它通过WebSocket连接管理对话状态,并提供短语结束检测和语音活动检测(VAD)功能,大大简化了实时语音应用的开发。

算起来,距离 5 月 14 日 OpenAI 发布 GPT-4o 高级语音模式已经过去了半年时间。在这期间,AI 实时语音对话已经成为了有能力大厂秀肌肉、拼实力的新战场。

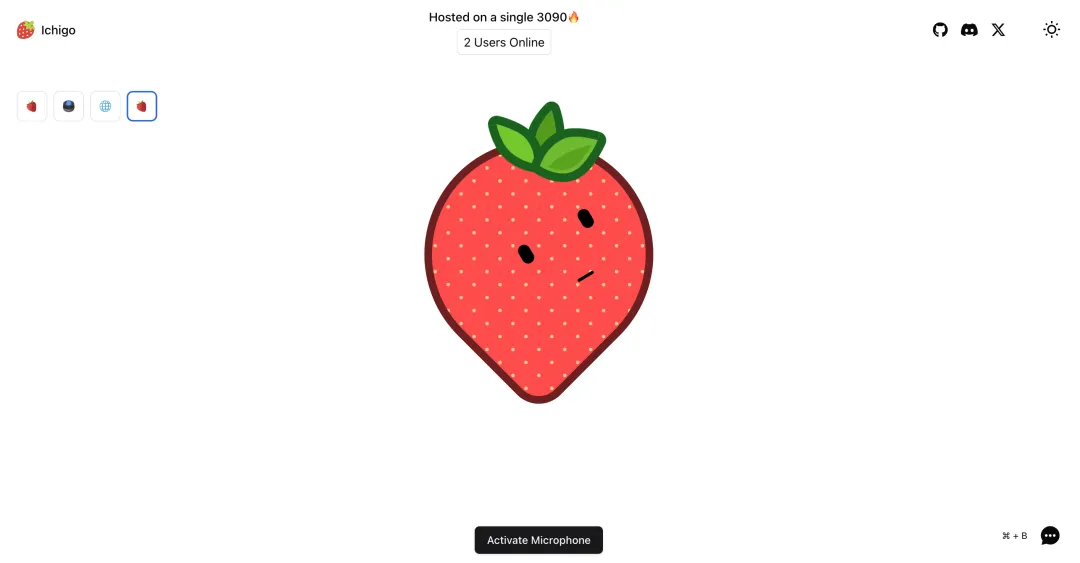

Ichigo[1] 是一个开放的、持续进行的研究项目,目标是将基于文本的大型语言模型(LLM)扩展,使其具备原生的“听力”能力。

10 月 25 日, RTE 年度场景 Showcase 暨第四届 RTE 创新大赛,Founder Park 作为核心生态合作伙伴应邀出席。

十一假期第1天, OpenAI一年一度的开发者大会又来了惹!今年的开发者大会分成三部分分别在美国、英国、新加坡三个地点举办,刚刚结束的是第一场。

今天,OpenAI 2024年首场DevDay在旧金山2号码头的Gateway Pavilion低调举办。