当AI接管一切,人类存在的意义还剩什么?教皇警醒世人

当AI接管一切,人类存在的意义还剩什么?教皇警醒世人教皇利奥十四世近日警告, AI发展不应沦为少数人的敛财工具,而须服务共同利益。他呼吁在AI时代重申「何谓为人」,警惕技术侵蚀人类尊严与思考能力,敦促全社会守护年轻一代的心灵自由,确保由人类主导技术的未来。

教皇利奥十四世近日警告, AI发展不应沦为少数人的敛财工具,而须服务共同利益。他呼吁在AI时代重申「何谓为人」,警惕技术侵蚀人类尊严与思考能力,敦促全社会守护年轻一代的心灵自由,确保由人类主导技术的未来。

Anthropic发布了Programmatic Tool Calling(PTC)特性,让Claude通过代码编排工具执行,降低token消耗、减少延迟并提升准确性。

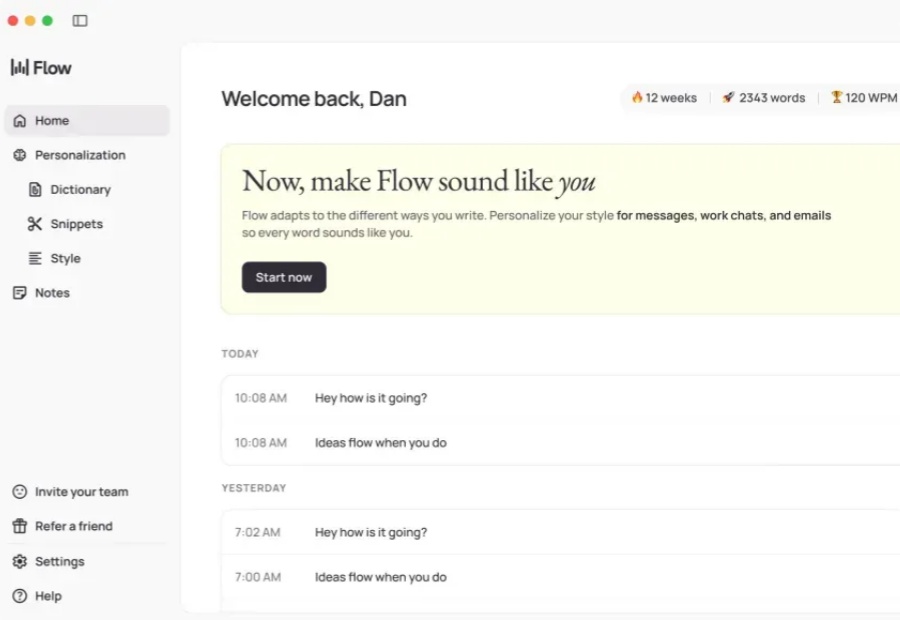

键盘作为人机交互的主要工具,实质上是一个巨大且不自然的「输入、输出瓶颈」。在「后键盘时代(post-keyboard future)」,语音或许才是最好地交互方式。

当别人还在做工具,他已经带着生态向我们走来

记忆,或是 AI 从「即时回答工具」迈向「个性化超级助手」的关键突破

当地时间 12 月 2 日,Anthropic 宣布收购了热门开发者工具初创公司 Bun。这项交易的财务条款尚不清楚,但它标志着 Anthropic 向开发者工具领域迈出了重要一步。

「创业公司本质上是一场寻找产品与市场契合点(PMF)的宏大实验。」这句话的含金量还在上升。

突袭!ChatGPT发布三周年,DeepSeek嚯一下发出两个模型:DeepSeek-V3.2和DeepSeek-V3.2-Speciale。前者聚焦平衡实用,适用于日常问答、通用Agent任务、真实应用场景下的工具调用。

随着大语言模型与开发工具链的深度融合,命令行终端正被重塑为开发者的AI协作界面。本文以 Google gemini-cli 为范本,通过源码解构,系统性分析其 Agent 内核、ReAct 工作流、工具调用与上下文管理等核心模块的实现原理。为希望构建终端 Agent 的开发者,提供工程实现的系统化参考。

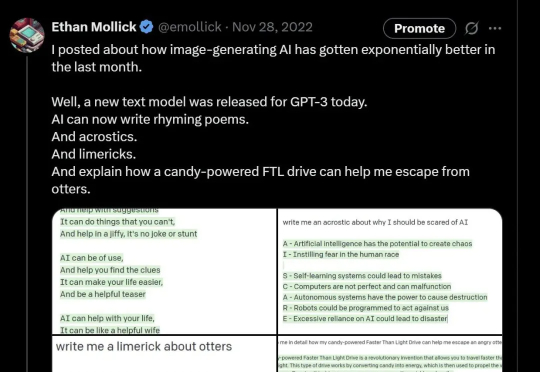

不到1000天,AI已从会聊天,进化到能读文件、跑任务、写论文。它开始介入实际工作流程,人类与AI的分工,也在悄悄重写。