都有混合检索与智能路由了,谁还在给RAG赛博哭坟?

都有混合检索与智能路由了,谁还在给RAG赛博哭坟?最近一年,互联网上各种为RAG赛博哭坟的帖子不胜枚举。

最近一年,互联网上各种为RAG赛博哭坟的帖子不胜枚举。

提起“AI战胜人类”,很多人第一反应是1997年IBM的“深蓝”击败国际象棋世界冠军卡斯帕罗夫。那场人机大战轰动全球,被视为人工智能的里程碑。

是你的、是我的、是每个人的黄金时代。

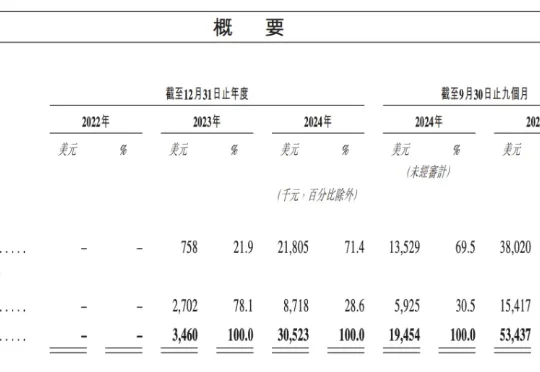

即将于 1 月 9 日敲钟上市的大模型公司 MiniMax,创下近年来港股 IPO 机构认购历史记录。此次参与 MiniMaxIPO 认购的机构超过 460 家,超额认购达 70 多倍。此前的认购记录属于宁德时代,其在 2025 年登陆港股市场时,剔除基石后超额认购 30 倍。

刚刚,谷歌母公司成为全球市值TOP 2,市值已达3.885万亿美元!在2026首个全球AI追踪报告中,Gemini的市场份额也在疯涨。被逼急的OpenAI,干脆甩出500亿美元的员工股票池,据说Ilya就分走了40亿。

CES 2026新AI硬件巡礼:中国团队抢眼,“深圳军团”把性价比打到新高度。智东西1月7日报道,在国际消费电子展CES 2026上,AI正在以更隐蔽、也更具体的方式进入硬件世界,一批新型AI硬件和创意展品刷足了存在感。

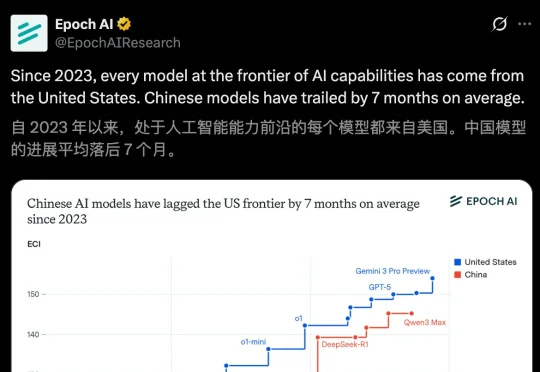

一张来自Epoch AI图表给出了一个冷静却尖锐的结论:中国AI平均落后7个月。一张图揭示真相:自2023年以来,前沿AI全部来自美国!最近,Epoch AI一份报告指出,中国AI模型的进展平均落后于美国7个月——最小差距为4个月,最大差距为14个月。

在人工智能飞速发展的今天,我们的社交媒体动态似乎被精心净化,然而在这光鲜背后,一支隐形的全球劳动力正默默承受着难以言喻的创伤。

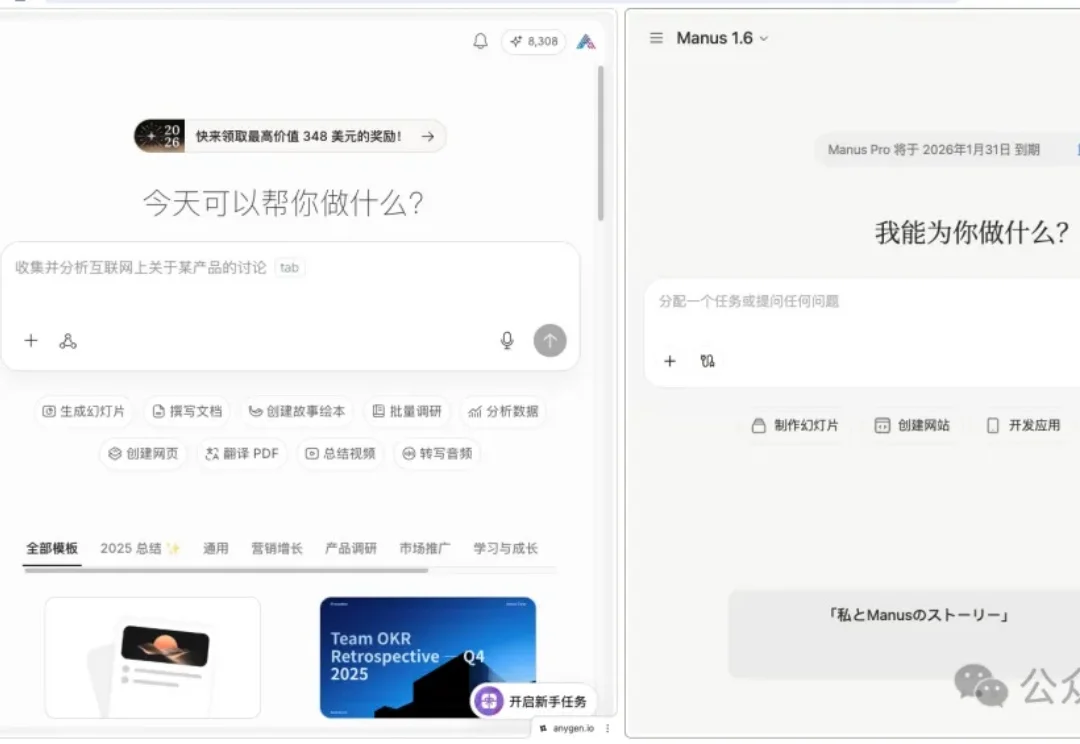

Manus 卖给 Meta 这事儿,最近闹得沸沸扬扬。

本文为《2025 年度盘点与趋势洞察》系列内容之一,由 InfoQ 技术编辑组策划。本系列覆盖大模型、Agent、具身智能、AI Native 开发范式、AI 工具链与开发、AI+ 传统行业等方向,通过长期跟踪、与业内专家深度访谈等方式,对重点领域进行关键技术进展、核心事件和产业趋势的洞察盘点。