斯坦福AI团队“套壳”清华系开源大模型被实锤,被揭穿后全网删库跑路

斯坦福AI团队“套壳”清华系开源大模型被实锤,被揭穿后全网删库跑路大模型抄袭丑闻总是不断。

大模型抄袭丑闻总是不断。

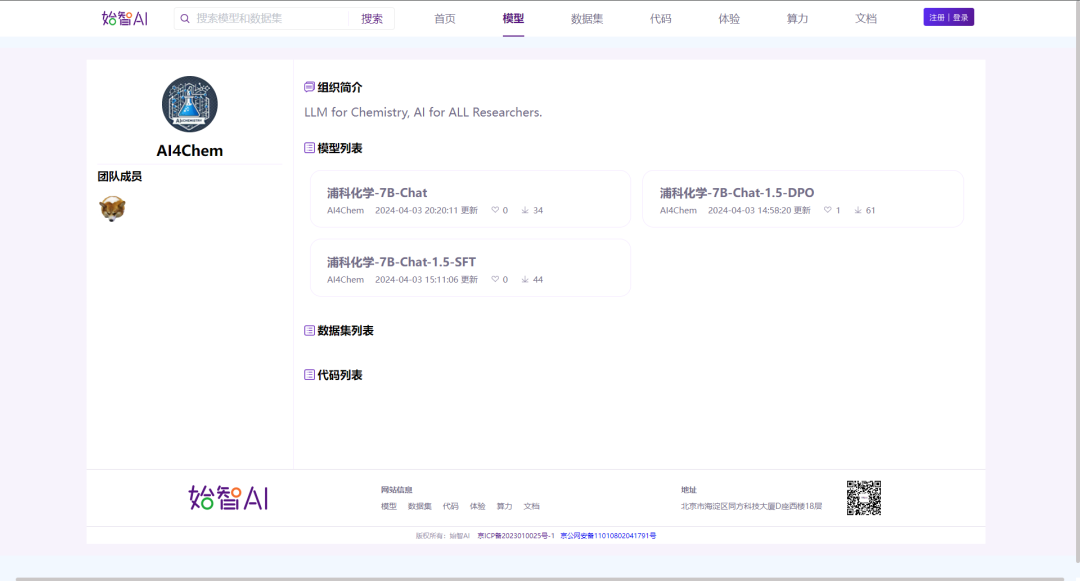

ChemLLM系列模型是由上海人工智能实验室开发的首个兼备推理、对话等通用能力和化学专业能力的开源大模型。相比于现有的其他大模型,ChemLLM对化学空间进行了有效建模,在产物预测、名称转化和化学性质预测等核心化学任务上表现优异。ChemLLM系列模型已经发布到了始智AI wisemodel.cn开源社区,并且无需任何代码,两步即可完成模型的在线体验。

随着深度学习大语言模型的越来越火爆,大语言模型越做越大,使得其推理成本也水涨船高。模型量化,成为一个热门的研究课题。

最近在许多美国开发者的口中,一个开源模型经常被提及,它的发音听起来是“困”。乍一听到总让人一头雾水。哪个开发者天天用中文说困啊。

两周前,OpenBMB开源社区联合面壁智能发布领先的开源大模型「Eurux-8x22B 」。相比口碑之作 Llama3-70B,Eurux-8x22B 发布时间更早,综合性能相当,尤其是拥有更强的推理性能——刷新开源大模型推理性能 SOTA,堪称开源大模型中「理科状元」。

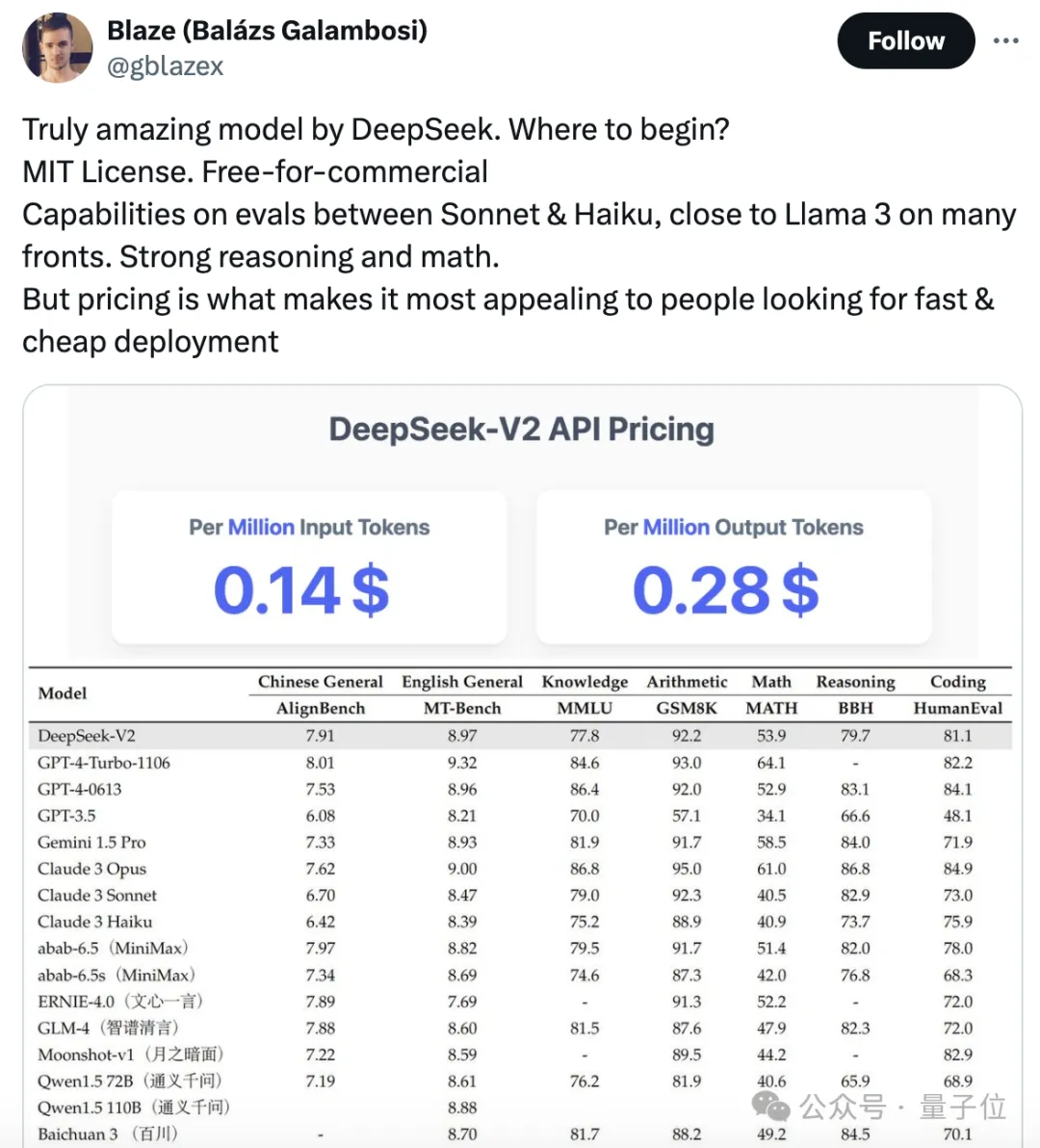

开源大模型领域,又迎来一位强有力的竞争者。

最新国产开源MoE大模型,刚刚亮相就火了。

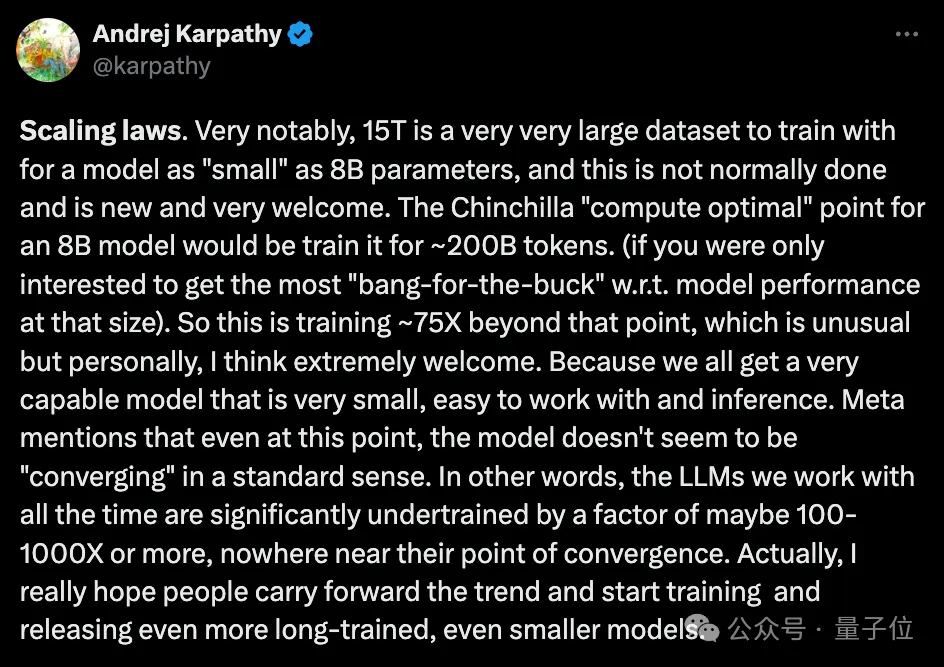

大模型力大砖飞,让LLaMA3演绎出了新高度: 超15T Token数据上的超大规模预训练,既实现了令人印象深刻的性能提升,也因远超Chinchilla推荐量再次引爆开源社区讨论。

最近,Meta 推出了 Llama 3,为开源大模型树立了新的标杆。

要说 ChatGPT 拉开了大模型竞赛的序幕,那么 Meta 开源 Llama 系列模型则掀起了开源领域的热潮。在这当中,苹果似乎掀起的水花不是很大。