人形机器人优雅漫步,强化学习新成果!独角兽Figure创始人:之前大家吐槽太猛

人形机器人优雅漫步,强化学习新成果!独角兽Figure创始人:之前大家吐槽太猛注意看,机器人像人一样从容地走出大门了!人形机器人独角兽Figure,再次带来他们的新成果——利用强化学习实现自然人形行走。跟之前版本的机器人相比,确实更像人了许多,而且步态更加轻盈,速度也更快。

注意看,机器人像人一样从容地走出大门了!人形机器人独角兽Figure,再次带来他们的新成果——利用强化学习实现自然人形行走。跟之前版本的机器人相比,确实更像人了许多,而且步态更加轻盈,速度也更快。

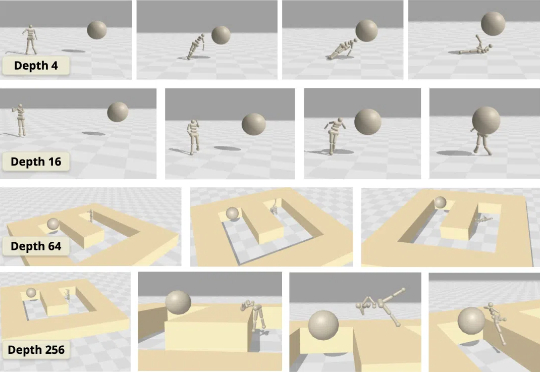

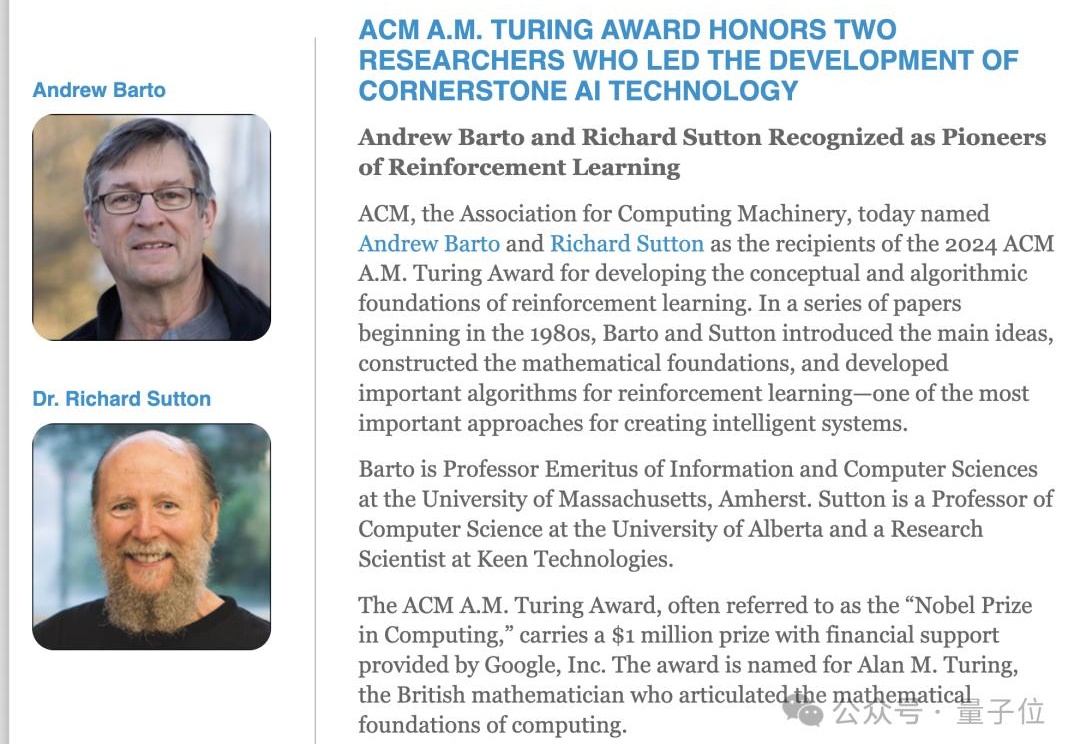

虽然大多数强化学习(RL)方法都在使用浅层多层感知器(MLP),但普林斯顿大学和华沙理工的新研究表明,将对比 RL(CRL)扩展到 1000 层可以显著提高性能,在各种机器人任务中,性能可以提高最多 50 倍。

波士顿动力的Atlas机器人又双叒叕来了!从最初的液压「电缆尾巴」到现在全电动AI增强版,这个机器人不仅会翻跟头、跳街舞,还学会了倒立侧翻,甚至开始「进厂打工」搬零件。动作捕捉技术与强化学习的加持,让Atlas的动作越来越像人类,而它的目标也从炫技转向实用。

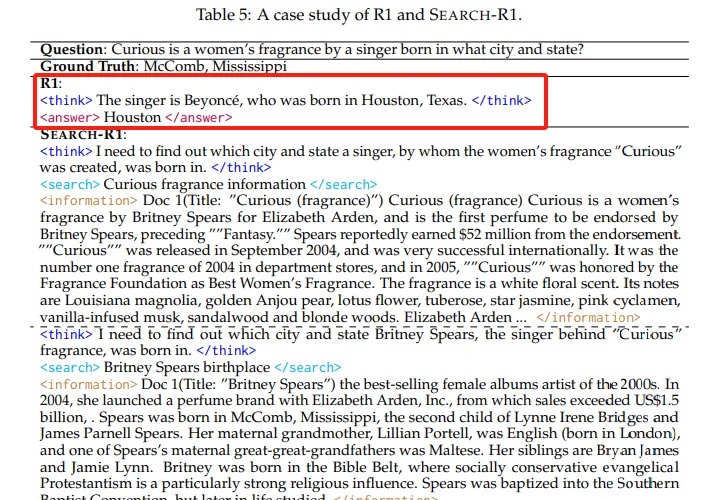

本文介绍了Search-R1技术,这是一项通过强化学习训练大语言模型进行推理并利用搜索引擎的创新方法。实验表明,Search-R1在Qwen2.5-7B模型上实现了26%的性能提升,使模型能够实时获取准确信息并进行多轮推理。本文详细分析了Search-R1的工作原理、训练方法和实验结果,为AI产品开发者提供了重要参考。

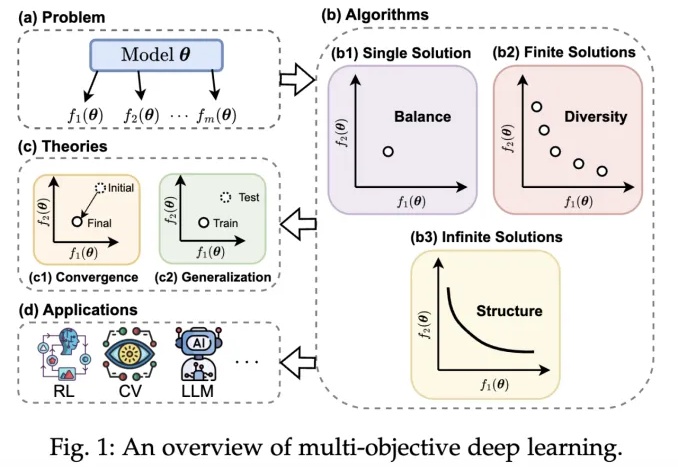

近年来,深度学习技术在自动驾驶、计算机视觉、自然语言处理和强化学习等领域取得了突破性进展。然而,在现实场景中,传统单目标优化范式在应对多任务协同优化、资源约束以及安全性 - 公平性权衡等复杂需求时,逐渐暴露出其方法论的局限性。

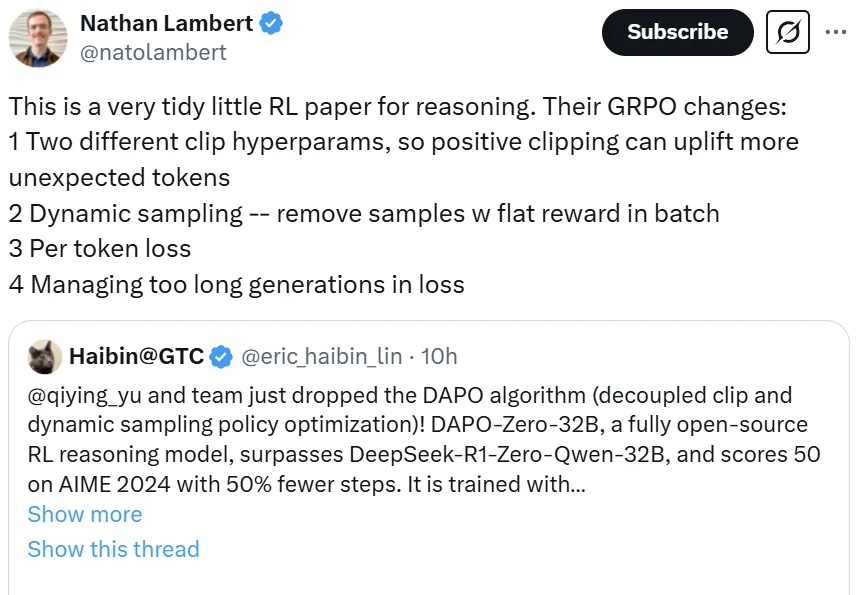

DeepSeek 提出的 GRPO 可以极大提升 LLM 的强化学习效率,不过其论文中似乎还缺少一些关键细节,让人难以复现出大规模和工业级的强化学习系统。

没有任何冷启动数据,7B 参数模型能单纯通过强化学习学会玩数独吗?

在面对复杂的推理任务时,SFT往往让大模型显得力不从心。最近,CMU等机构的华人团队提出了「批判性微调」(CFT)方法,仅在 50K 样本上训练,就在大多数基准测试中优于使用超过200万个样本的强化学习方法。

见识过32B的QwQ追平671的DeepSeek R1后——刚刚,7B的DeepSeek蒸馏Qwen模型超越o1又是怎么一回事?新方法LADDER,通过递归问题分解实现AI模型的自我改进,同时不需要人工标注数据。

他们为ChatGPT/AlphaGo奠定基石