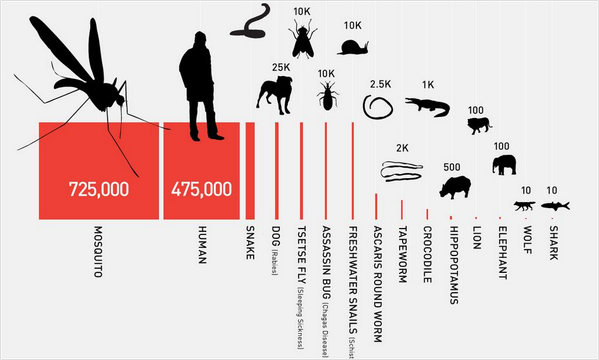

比尔·盖茨要用AI对付蚊子,人类和蚊子的“战争”迎来终局?

比尔·盖茨要用AI对付蚊子,人类和蚊子的“战争”迎来终局?在致人死亡的动物中,蚊子排名第一。

在致人死亡的动物中,蚊子排名第一。

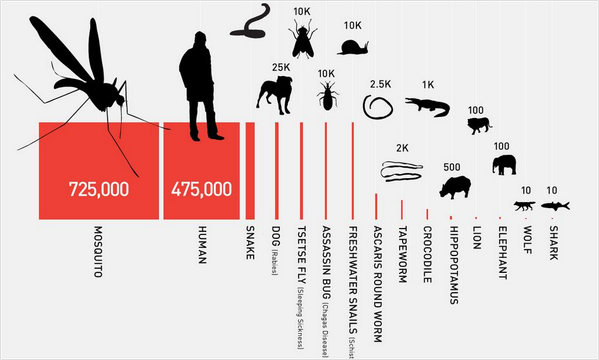

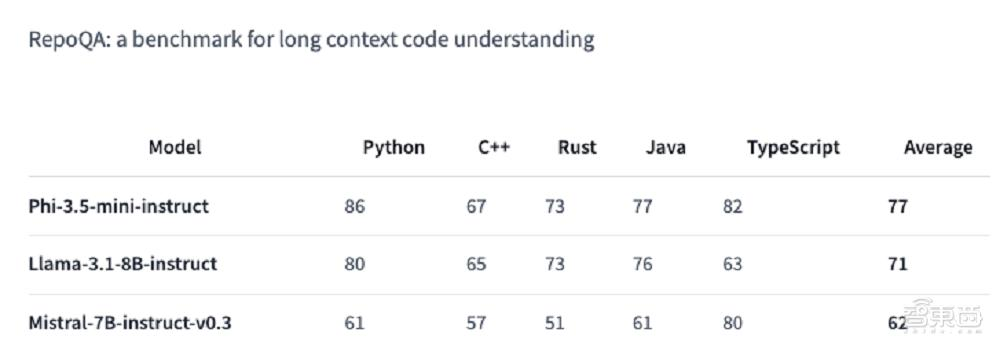

轻量级模型的春天要来了吗?

微软Phi 3.5系列上新了!mini模型小而更美,MoE模型首次亮相,vision模型专注多模态。

合成数据2.0秘诀曝光了!来自微软的研究人员们提出了智能体框架AgentInstruct,能够自动创建大量、多样化的合成数据。经过合成数据微调后的模型Orca-3,在多项基准上刷新了SOTA。

AI智能体遍布整个网络,未来如何防止被骗?如何保护隐私?OpenAI微软MIT等25个机构联手提出「人格凭证」,可以证明自己是真人,还不用披露任何个人信息。

非凡产研为大家整理编辑了近期微软CTO凯文·斯科特(Kevin Scott)接受红杉资本、Stratechery 采访回应关于大模型scaling laws、人工智能平台转变等焦点话题的精华内容。

互相检查,让小模型也能解决大问题。

AI 除了更懂和你对话外,也更懂天气了。

AI在现实工作环境中如何影响了工作效率?微软发起一项最大规模的调查研究,AI工具在工作场景中最大提效30%。

你有没有想过,或许未来某天,AI大军完全能够承担公司重任,人类是否会沦为配角? 小扎坚信,「未来世界上AI智能体,将比人类还要多」。