DeepSeek V3“小版本升级”实测堪比V3.5,非推理模型也有“啊哈时刻”,7米甘蔗过2米门想通了

DeepSeek V3“小版本升级”实测堪比V3.5,非推理模型也有“啊哈时刻”,7米甘蔗过2米门想通了DeepSeek V3升级了,新版本V3-0324。

DeepSeek V3升级了,新版本V3-0324。

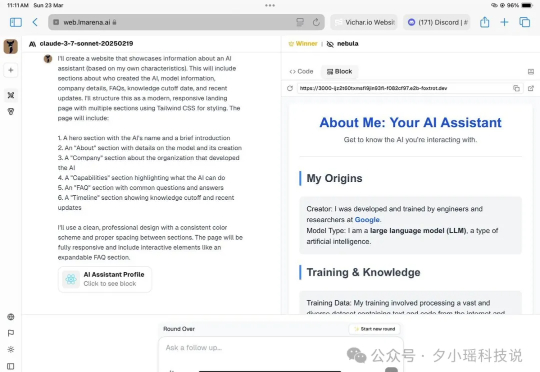

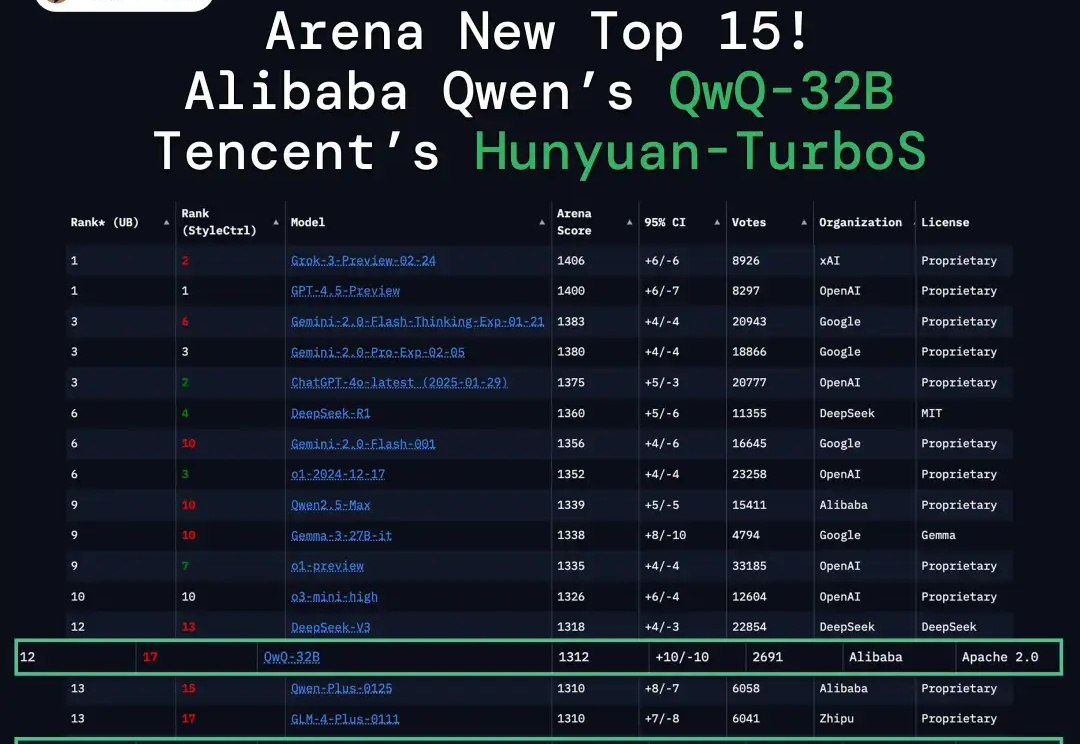

哎!最近推特上的网友在LMSYS Arena 发现了个泄漏的大模型 Nebula,效果据说特别好,打败了o1、o3mini、Claude3.7 Thinking等等模型:网友们通过询问和分析 API,发现这似乎是谷歌正在秘密演练的新推理模型!推测可能是 Google Gemini 2.0 Pro Thinking:

我发现对于 o1、R1 等推理模型们大家是又爱又恨,

首个基于混合Mamba架构的超大型推理模型来了!就在刚刚,腾讯宣布推出自研深度思考模型混元T1正式版,并同步在腾讯云官网上线。对标o1、DeepSeek R1之外,值得关注的是,混元T1正式版采用的是Hybrid-Mamba-Transformer融合模式——

全球首个开源多模态推理大模型来了!38B参数模型性能直逼DeepSeek-R1,同尺寸上横扫多项SOTA。而这家中国公司之所以选择无偿将技术思路开源,正是希望同DeepSeek一样,打造开源界的技术影响力。

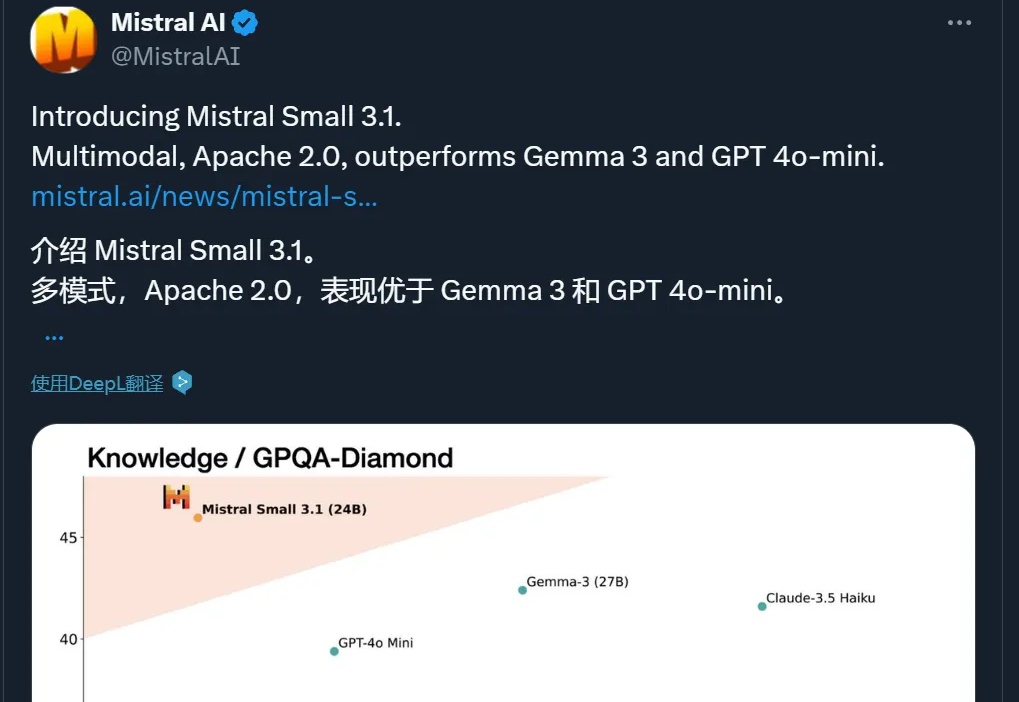

多模态,性能超 GPT-4o Mini、Gemma 3,还能在单个 RTX 4090 上运行,这个小模型值得一试。

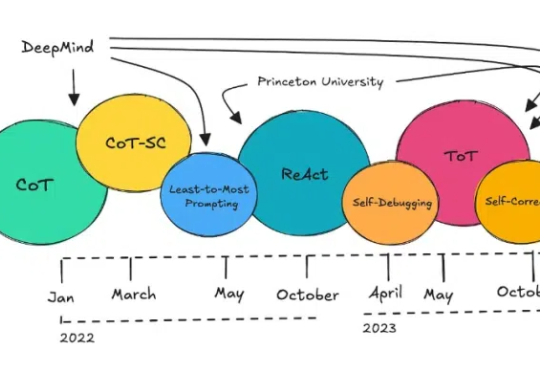

近段时间,推理模型 DeepSeek R1 可说是 AI 领域的头号话题。用过的都知道,该模型在输出最终回答之前,会先输出一段思维链内容。这样做可以提升最终答案的准确性。

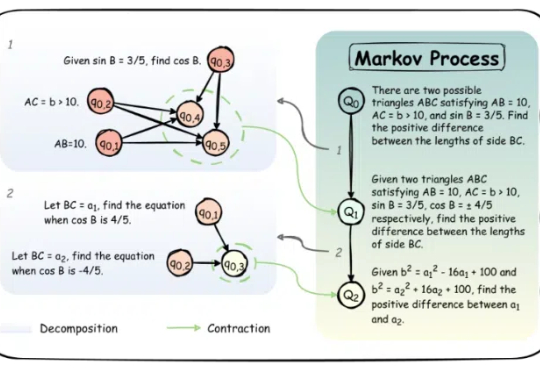

大语言模型(LLM)近年来凭借训练时扩展(train-time scaling)取得了显著性能提升。然而,随着模型规模和数据量的瓶颈显现,测试时扩展(test-time scaling)成为进一步释放潜力的新方向。

谷歌把推理大模型带入物理世界,机器人可以一边思考一边动作了!

不怕推理模型简单问题过度思考了,能动态调整CoT的新推理范式SCoT来了!