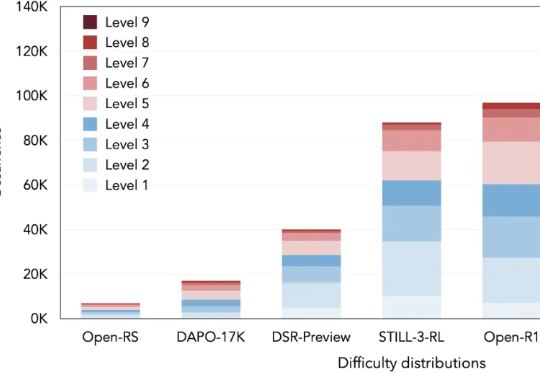

103K「硬核」题,让大模型突破数学推理瓶颈

103K「硬核」题,让大模型突破数学推理瓶颈本文将介绍 DeepMath-103K 数据集。该工作由腾讯 AI Lab 与上海交通大学团队共同完成。

本文将介绍 DeepMath-103K 数据集。该工作由腾讯 AI Lab 与上海交通大学团队共同完成。

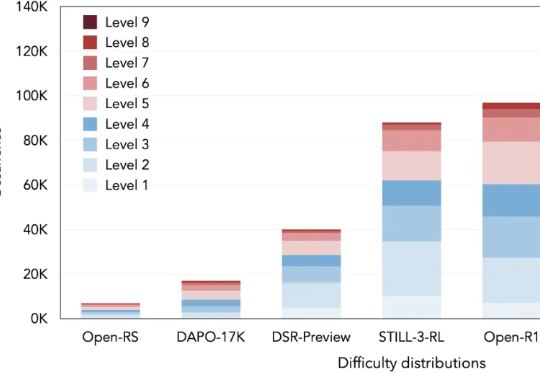

推理模型常常表现出类似自我反思的行为,但问题是——这些行为是否真的能有效探索新策略呢?

就在刚刚,中兴通讯星云大模型获推理榜总分第一,总榜并列第二!而在数学推理、科学推理、代码生成的细分赛道上,它同样表现抢眼。更难得的是,它是业内少数通过国家级权威安全认证的大模型。

最强AI模型面对5560道数学难题,成功率仅16.46%?背后真相大揭秘。

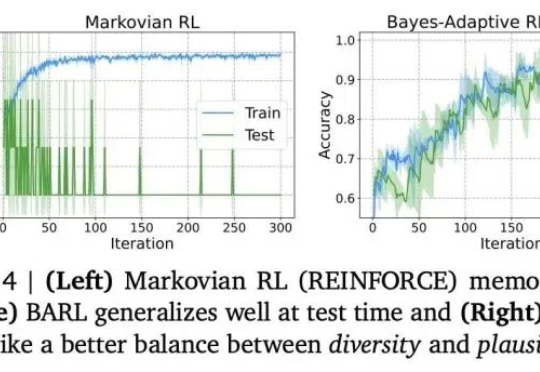

就在刚刚,DeepSeek-Prover-V2技术报告也来了!34页论文揭秘了模型的训练核心——递归+强化学习,让数学推理大提升。有人盛赞:DeepSeek已找到通往AGI的正确路径!

在大模型迈向推理时代的当下,数学推理能力已成为衡量语言模型智能上限的关键指标。

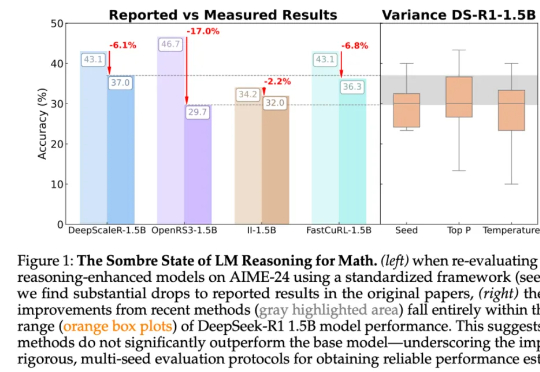

尽管这些论文的结论统统指向了强化学习带来的显著性能提升,但来自图宾根大学和剑桥大学的研究者发现,强化学习导致的许多「改进」可能只是噪音。「受推理领域越来越多不一致的经验说法的推动,我们对推理基准的现状进行了严格的调查,特别关注了数学推理领域评估算法进展最广泛使用的测试平台之一 HuggingFaceH4,2024;AI - MO。」

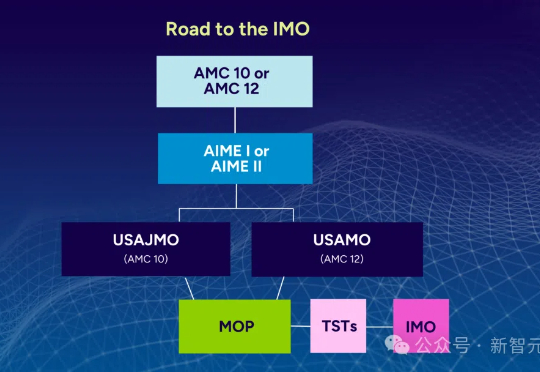

在数学推理中,大语言模型存在根本性局限:在美国数学奥赛,顶级AI模型得分不足5%!来自ETH Zurich等机构的MathArena团队,一下子推翻了AI会做数学题这个神话。

685B的DeepSeek-V3新版本,就在昨夜悄悄上线了。参数量685B的V3,代码数学推理再次显著提升,甚至代码追平Claude 3.7,网友们实测后大呼强到离谱!有人预测说,按照此前的节奏,DeepSeek-R2大概率几周内就将上线。

就在DeepSeek-V3更新的同一夜,阿里通义千问Qwen又双叒叕一次梦幻联动了——