大模型“记性差一点”反而更聪明!金鱼损失随机剔除token,让AI不再死记硬背

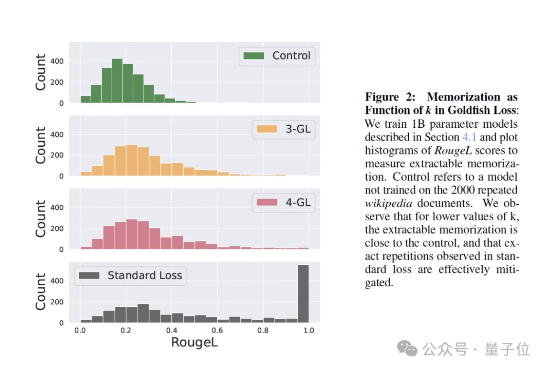

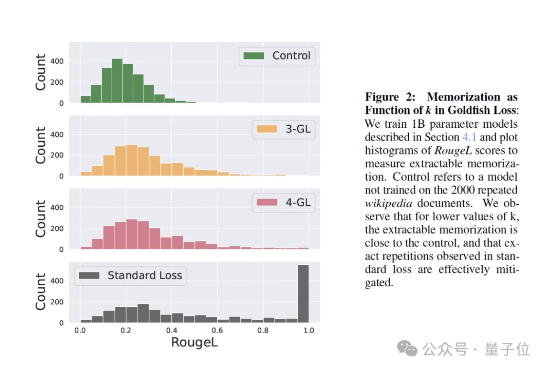

大模型“记性差一点”反而更聪明!金鱼损失随机剔除token,让AI不再死记硬背训练大模型时,有时让它“记性差一点”,反而更聪明! 大语言模型如果不加约束,很容易把训练数据原封不动地复刻出来。为解决这个问题,来自马里兰大学、图宾根大学和马普所的研究团队提出了一个新方法——金鱼损失(Goldfish Loss)。

训练大模型时,有时让它“记性差一点”,反而更聪明! 大语言模型如果不加约束,很容易把训练数据原封不动地复刻出来。为解决这个问题,来自马里兰大学、图宾根大学和马普所的研究团队提出了一个新方法——金鱼损失(Goldfish Loss)。

最近,工业界“RAG已死”甚嚣尘上。过去几年,AI领域的主旋律是“规模定律”(Scaling Law),即更大的模型、更多的数据会带来更好的性能。即便偶然有瑕疵,也认为只是工程上的不足,并非数学上的不可能。

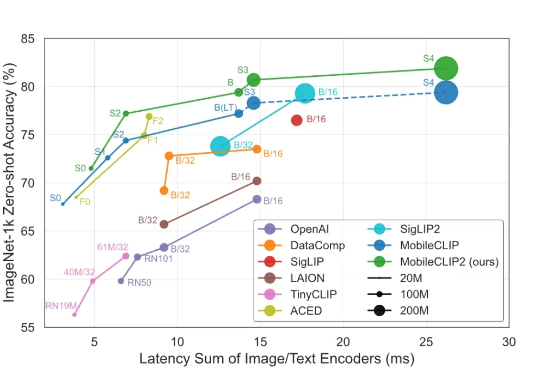

智东西9月1日消息,苹果又公布了大模型研发新进展! 8月28日,苹果在arXiv发布新论文,介绍新一代多模态基础模型MobileCLIP2及其背后的多模态强化训练机制,同天在GitHub、Hugging Face上开源了模型的预训练权重和数据生成代码。

OpenAI计划在印度建设至少1GW规模的数据中心,这是「星际之门」计划首次大规模进入亚洲。印度之所以重要,不仅因其庞大的用户增长潜力与低价特供服务,还因多语言应用场景。奥特曼虽淡出CEO角色,却亲自推动全球算力布局,印度成为其展现野心的关键起点。

近期,AI营销公司橙果视界(PhotoG母公司)宣布完成数千万元新一轮融资,由云天使基金领投,力合创投和金沙江联合资本跟投。本轮融资将用于进一步扩大行业数据规模,推进垂直行业后训练模型迭代,进一步加快全链路营销智能体在多行业的业务落地,持续探索能感知、决策、创造并执行的商业大脑。

昨天,美团低调地开源了其560B参数的混合专家(MoE)模型——LongCat-Flash。 一时间,大家的目光都被吸引了过去,行业内的讨论大多围绕着它在公开基准测试中媲美顶尖模型的性能数据,以及其精巧的MoE架构设计。

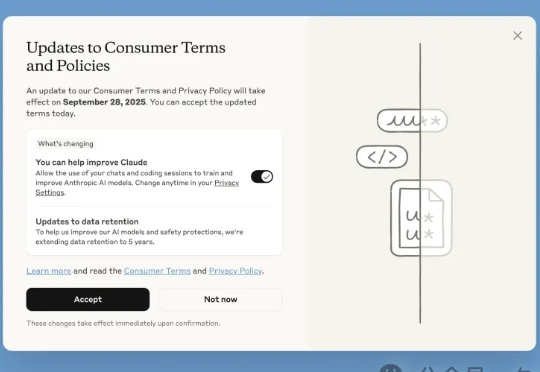

近日,Anthropic更新了它的消费者条款,没想竟把网友惹怒了,有的还把以往的「旧账」都翻了出来。这次网友的反应为啥这么激烈?大家可能还记得在Claude上线之初,Anthropic就坚决表示不会拿用户数据来训练模型。这次变化不仅自己打脸,还把以往一些「背刺」用户的往事都抖搂出来了。

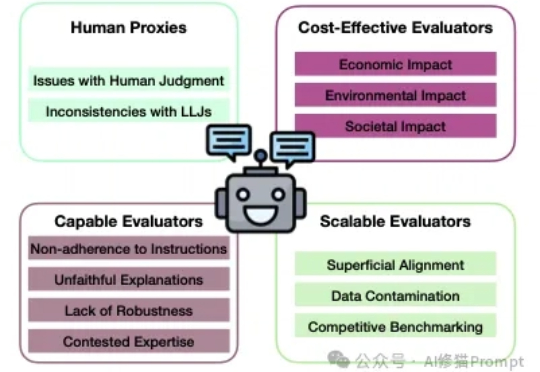

让LMM作为Judge,从对模型的性能评估到数据标注再到模型的训练和对齐流程,让AI来评判AI,这种模式几乎已经是当前学术界和工业界的常态。

这是 Claude(Anthropic 的 AI 助手)今天更新了用户条款和隐私政策: 允许 Claude 使用你的聊天内容和编程会话,用于训练和改进 AI 模型。 默认是“同意”,可以手动去设置关闭。而且是要求用户在 2025 年 9 月 28 日前作出选择。

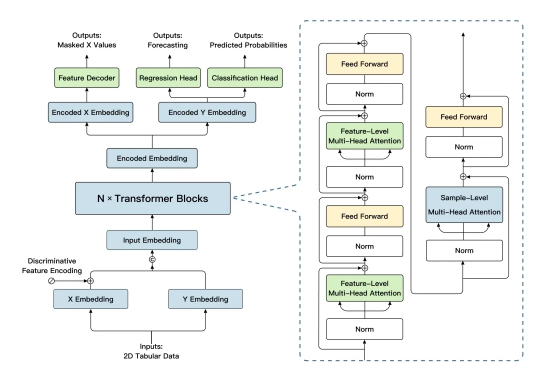

2025 年 8 月 29 日,由清华大学计算机系崔鹏教授团队联合稳准智能共同研发的结构化数据通用大模型「极数」(LimiX)正式宣布开源。