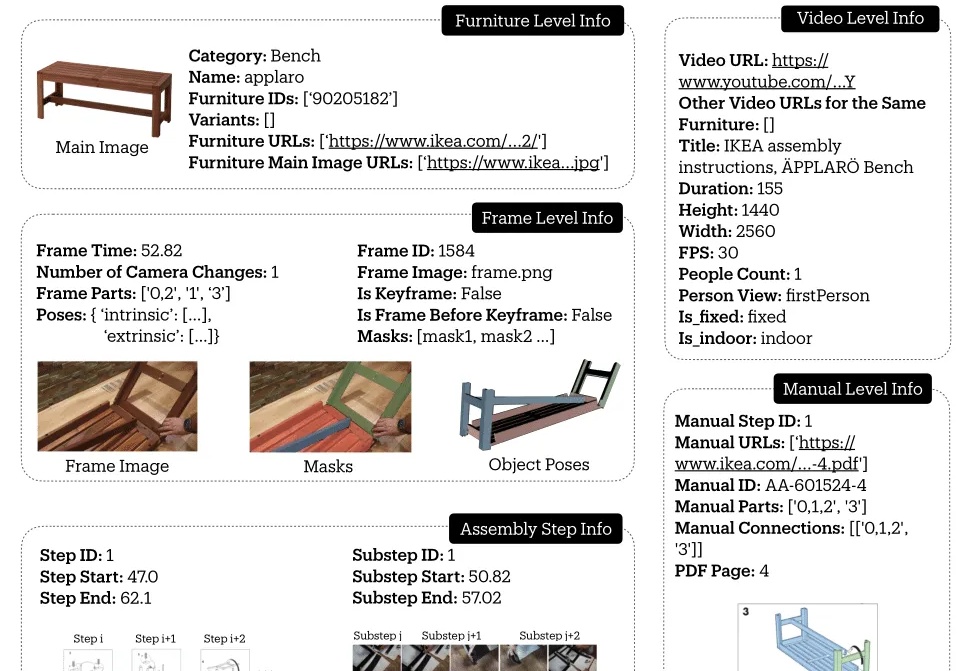

空间智能新进展:教机器人组装宜家家具,首次实现操作步骤与真实视频对齐 | NeurIPS

空间智能新进展:教机器人组装宜家家具,首次实现操作步骤与真实视频对齐 | NeurIPS斯坦福吴佳俊团队,给机器人设计了一套组装宜家家具的视频教程!

斯坦福吴佳俊团队,给机器人设计了一套组装宜家家具的视频教程!

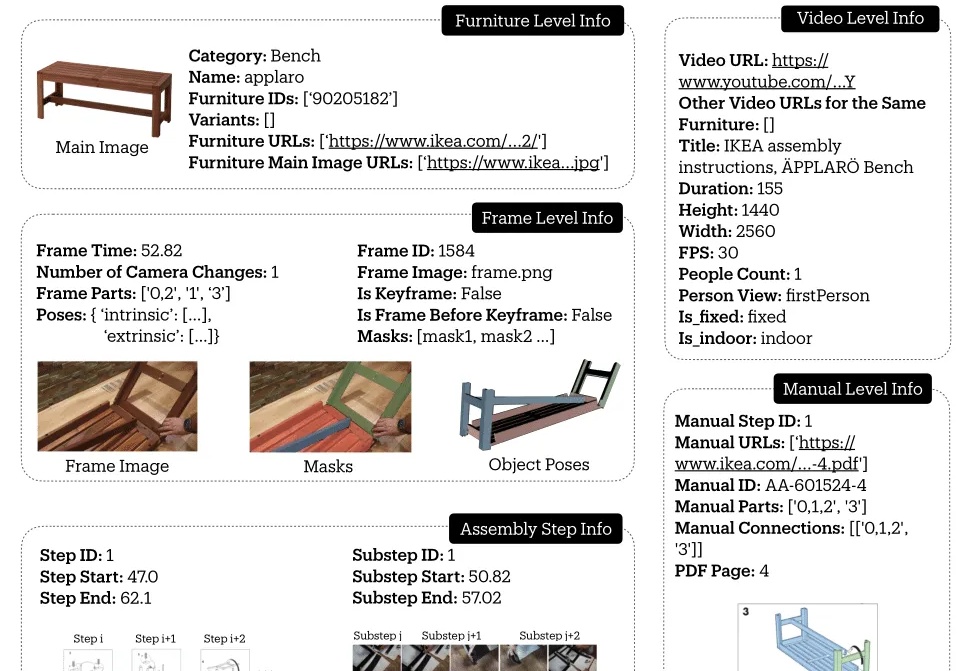

Ai2和华盛顿大学联合Meta、CMU、斯坦福等机构发布了最新的OpenScholar系统,使用检索增强的方法帮助科学家进行文献搜索和文献综述工作,而且做到了数据、代码、模型权重的全方位开源。

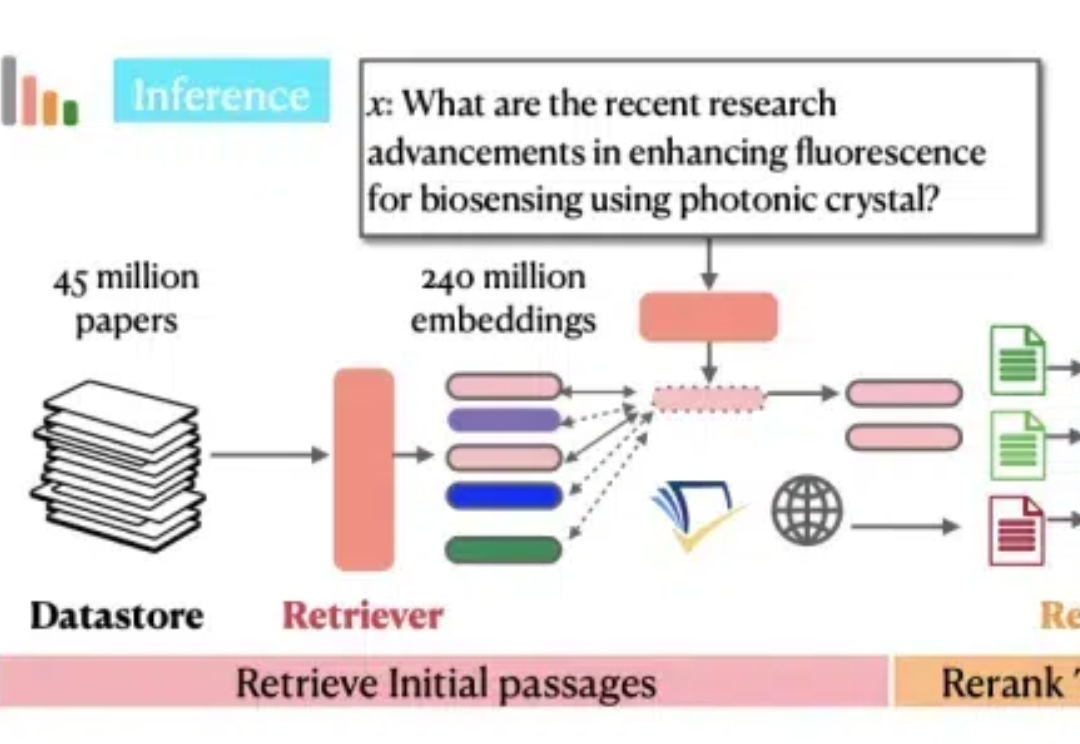

在人工智能领域,大语言模型(LLM)的向量嵌入能力一直被视为处理文本数据的利器。然而,斯坦福大学和Google DeepMind的研究团队带来了一个颠覆性发现:LLM的向量嵌入能力可以有效应用于回归任务。

Jiaming Song详细介绍了Diffusion模型在视觉生成领域的前沿研究,强调其在提升生成视觉模型质量中的关键作用。他分享了自己从斯坦福大学的博士研究到加入NVIDIA和Luma AI的历程,展示了如何将贝叶斯非参数模型的知识应用到生成式AI中,推动了视觉模型在生成质量和速度上的显著提升。

近日,来自斯坦福、MIT等机构的研究人员推出了低秩线性转换方法,让传统注意力无缝转移到线性注意力,仅需0.2%的参数更新即可恢复精度,405B大模型两天搞定!

哈佛斯坦福MIT等机构首次提出「精度感知」scaling law,揭示了精度、参数规模、数据量之间的统一关系。数据量增加,模型对量化精度要求随之提高,这预示着AI领域低精度加速的时代即将结束!

本期我们邀请到了 Hedra 的联合创始人兼 CEO Michael。他曾在斯坦福大学攻读博士学位,由吴教授和李飞飞教授共同指导,专注于物理世界建模与具身智能的交叉研究。在 NVIDIA 的 Omniverse 团队实习期间,他参与了 Omni-Gibson 的研究,对模拟物理与真实感表现系统的结合有深入探索,同时对电影、电视剧和动画等娱乐行业充满热情。

从文字生成三维世界的场景有多难?

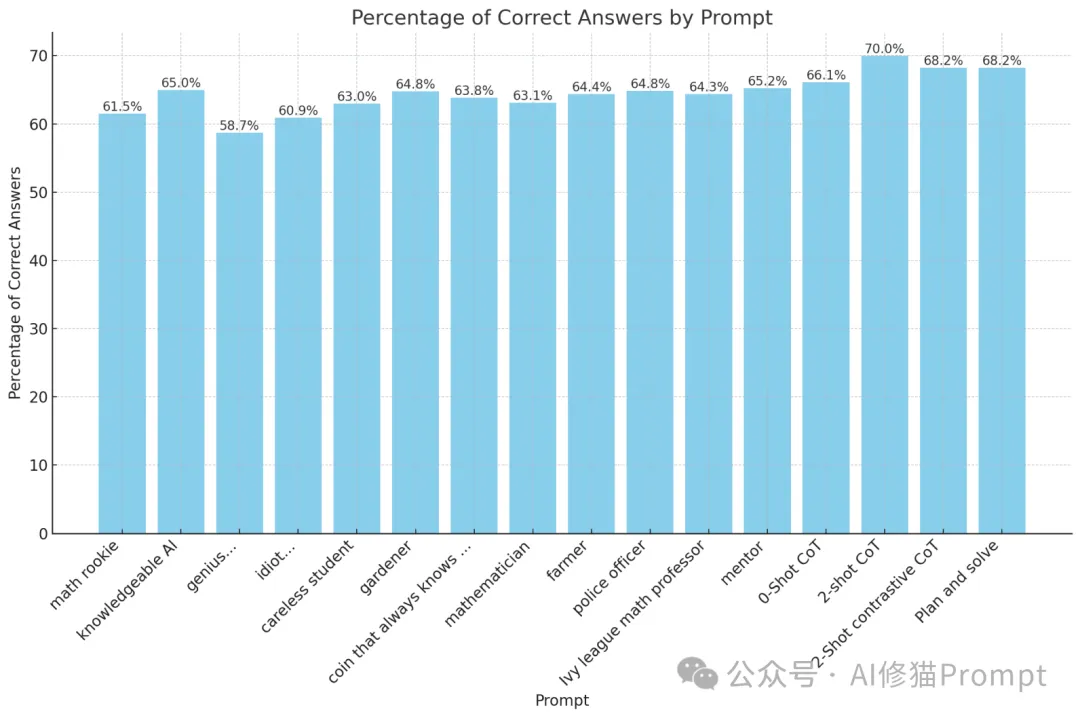

在Prompt工程领域,角色扮演提示是否能够有效提高大型语言模型(LLM)的性能一直是一个备受关注的话题。

空间智能版ImageNet来了,来自斯坦福李飞飞吴佳俊团队!