中科大/华为诺亚出手!芯片性能≠布局评分,EDA物理设计框架全面开源

中科大/华为诺亚出手!芯片性能≠布局评分,EDA物理设计框架全面开源芯片物理布局,有了直指性能指标的新测评标准!

芯片物理布局,有了直指性能指标的新测评标准!

2017 年,谷歌在论文《Attention is all you need》中提出了 Transformer,成为了深度学习领域的重大突破。该论文的引用数已经将近 13 万,后来的 GPT 家族所有模型也都是基于 Transformer 架构,可见其影响之广。 作为一种神经网络架构,Transformer 在从文本到视觉的多样任务中广受欢迎,尤其是在当前火热的 AI 聊天机器人领域。

LLM数学水平不及小学生怎么办?CMU清华团队提出了Lean-STaR训练框架,在语言模型进行推理的每一步中都植入CoT,提升了模型的定理证明能力,成为miniF2F上的新SOTA。

该论文的第一作者和通讯作者均来自北京大学王选计算机研究所的 MIPL实验室,第一作者为博士生徐铸,通讯作者为博士生导师刘洋。MIPL 实验室近年来在 IJCV、CVPR、AAAI、ICCV、ICML、ECCV 等顶会上有多项代表性成果发表,多次荣获国内外 CV 领域重量级竞赛的冠军奖项,和国内外知名高校、科研机构广泛开展合作。

Transformer架构层层堆叠,包含十几亿甚至几十亿个参数,这些层到底是如何工作的?当一个新奇的比喻——「画家流水线」,被用于类比并理解Transformer架构的中间层,情况突然变得明朗起来,并引出了一些有趣的发现。

打造终身学习智能体,是研究界以来一直追求的目标。最近,帝国理工联手谷歌DeepMind打造了创新联合框架扩散增强智能体(DAAG),利用LLM+VLM+DM三大模型,让AI完成迁移学习、高效探索。

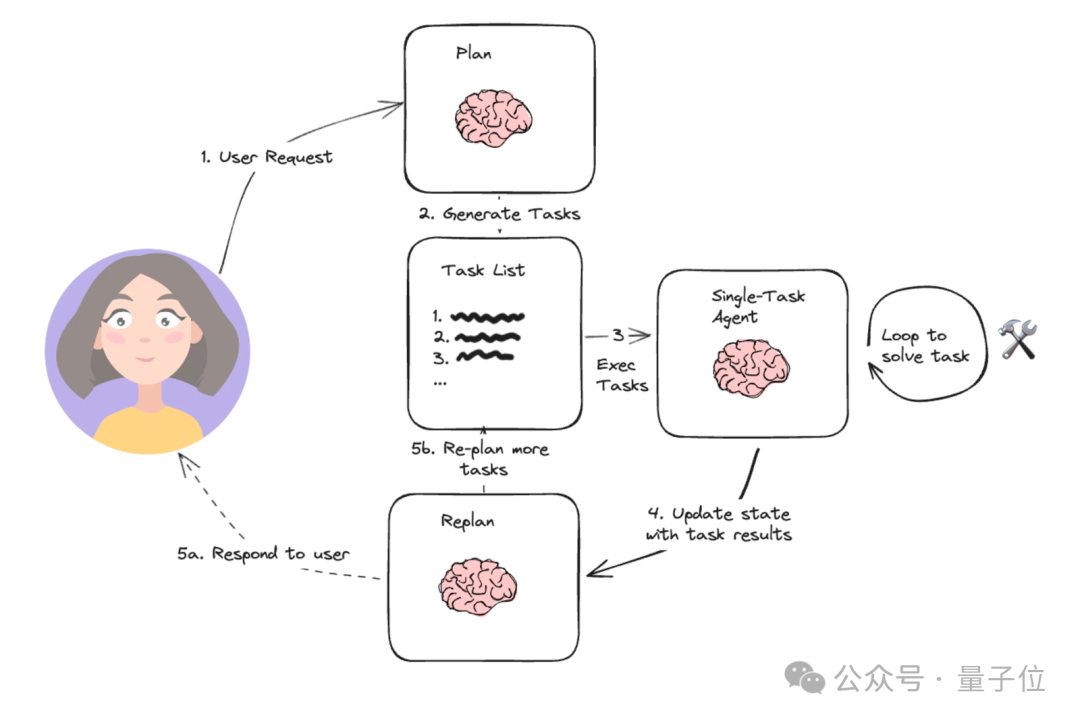

基于开源Agent框架,可自动解决复杂数据科学问题的Agent来了!

七年前,论文《Attention is all you need》提出了 transformer 架构,颠覆了整个深度学习领域。

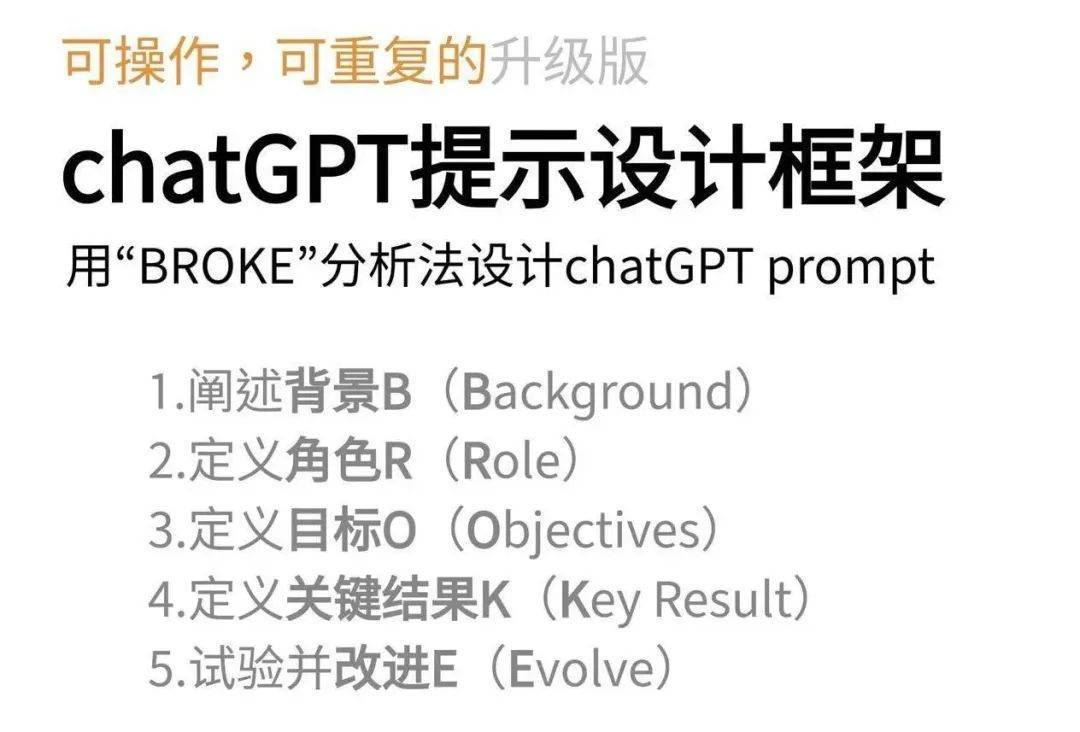

新加坡举办了首届GPT-4提示工程竞赛,Sheila Teo取得了冠军,我们来学习借鉴她采用的三项提示技巧: 使用CO-STAR框架构建提示词 2.使用分隔符将提示词分段 3.使用LLM系统提示

Transformer大模型尺寸变化,正在重走CNN的老路!