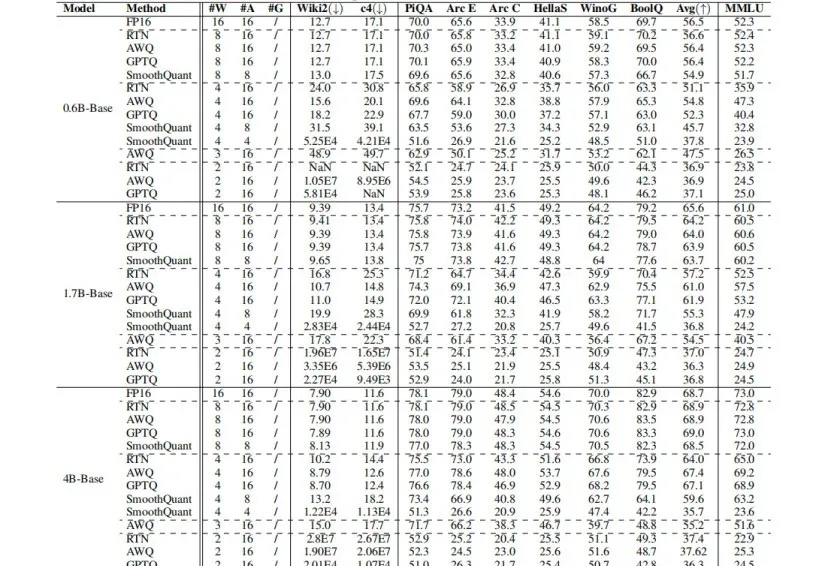

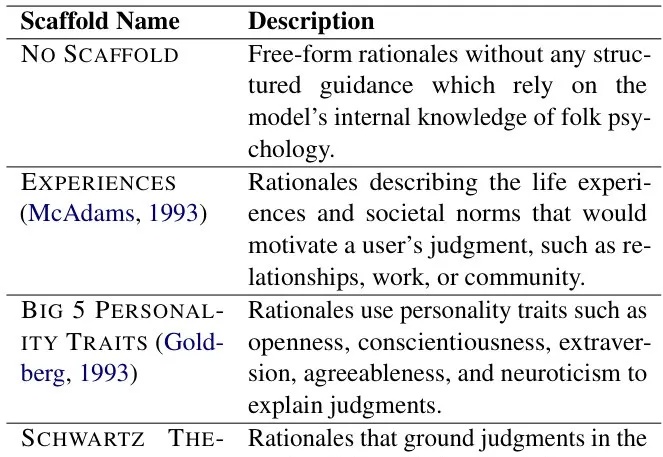

首次系统评估Qwen3在后训练量化下的鲁棒性:8bit下仍保持近乎无损性能

首次系统评估Qwen3在后训练量化下的鲁棒性:8bit下仍保持近乎无损性能Qwen3强势刷新开源模型SOTA,但如何让其在资源受限场景中,既能实现低比特量化,又能保证模型“智商”不掉线?

Qwen3强势刷新开源模型SOTA,但如何让其在资源受限场景中,既能实现低比特量化,又能保证模型“智商”不掉线?

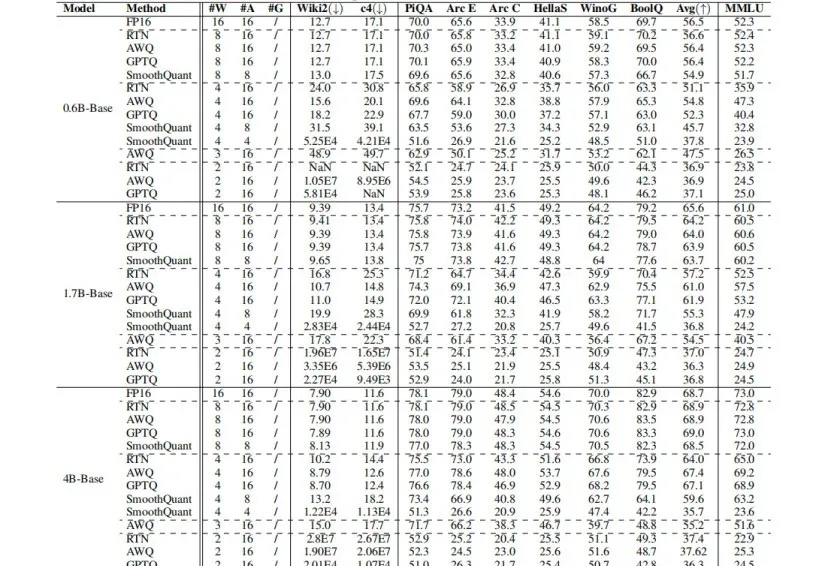

因为大家太过热情, Gemini 2.5提前重磅更新—— 史上最强编码模型Gemini 2.5 Pro Preview的I/O版。

随着大模型加速渗透核心行业,其安全可控性正从技术议题升级为产业落地的先决条件。

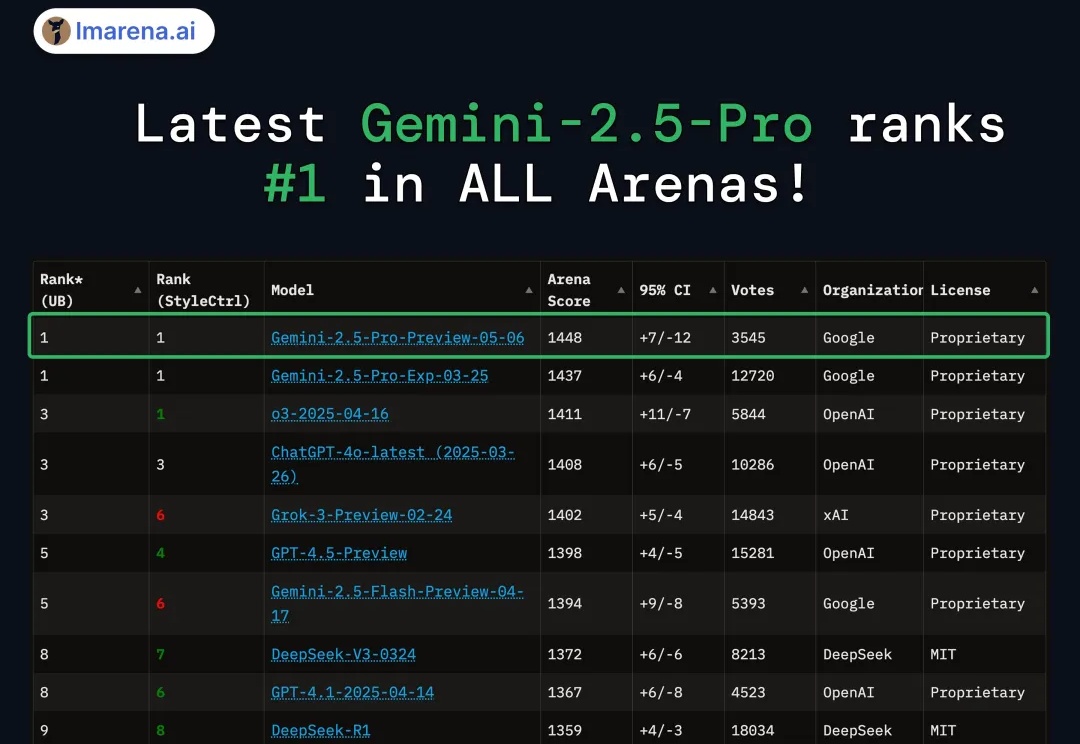

照这个发展速度,不远的将来AI不仅能模仿你的行为,还能理解你为何做出这些选择。PB&J框架正是这一突破性技术的代表,它通过引入心理学中的"支架"概念,使AI能够构建合理化解释,深入理解人类决策背后的动机。

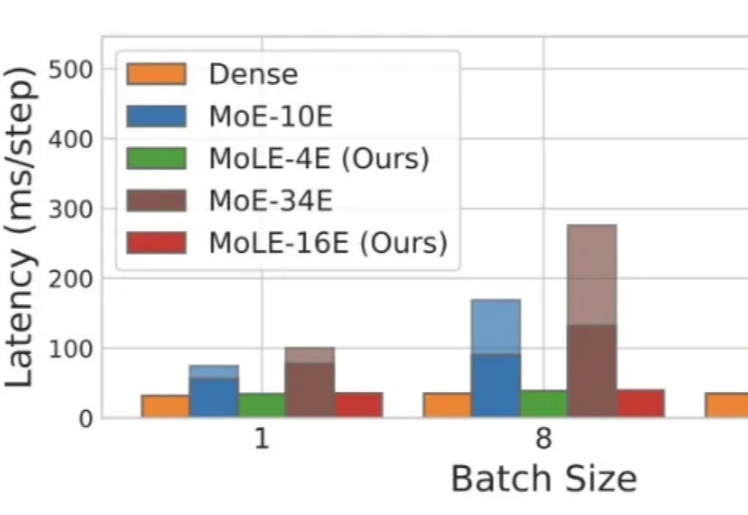

Mixture-of-Experts(MoE)在推理时仅激活每个 token 所需的一小部分专家,凭借其稀疏激活的特点,已成为当前 LLM 中的主流架构。然而,MoE 虽然显著降低了推理时的计算量,但整体参数规模依然大于同等性能的 Dense 模型,因此在显存资源极为受限的端侧部署场景中,仍然面临较大挑战。

“活过眼前的数据治理‘脏活累活’,未来五年,这个赛道遍布机遇。”深耕半导体赛道的喆塔科技创始人兼 CEO 赵文政对这个方向充满信心,他如今正在半导体软件领域引入 AI 技术。

你的默认编程模型是什么?或许可以换一换了。刚刚,Google DeepMind 发布了 Gemini 2.5 Pro 的最新更新版本:Gemini 2.5 Pro (I/O edition)。其最大的进步是编程能力大幅提升,不仅在 LMArena 编程排行榜上名列第一,同时也在 WebDev Arena 排行榜上更是以显著优势超过了昔日霸

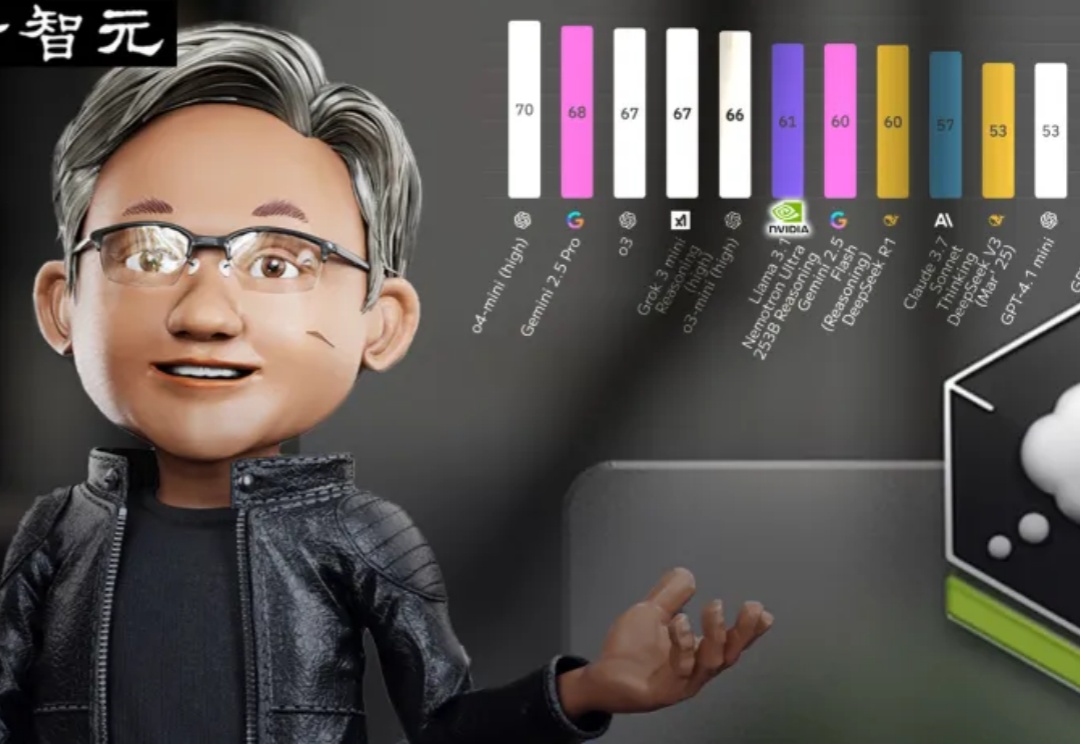

超越DeepSeek-R1的英伟达开源新王Llama-Nemotron,是怎么训练出来的?刚刚放出的论文,把一切细节毫无保留地全部揭秘了!

据 TechCrunch 报道,Recraft,这家神秘图像模型背后的初创公司,去年在一个备受尊敬的行业基准测试中击败了 OpenAI 的 DALL-E 和 Midjourney,已完成由 Accel 领投的 3000 万美元 B 轮融资。

随着 Deepseek 等强推理模型的成功,强化学习在大语言模型训练中越来越重要,但在视频生成领域缺少探索。复旦大学等机构将强化学习引入到视频生成领域,经过强化学习优化的视频生成模型,生成效果更加自然流畅,更加合理。并且分别在 VDC(Video Detailed Captioning)[1] 和 VBench [2] 两大国际权威榜单中斩获第一。