搞定Agent的"失忆症",TME树状记忆引擎让Agent再也不会"忘记"之前做过什么。| 最新

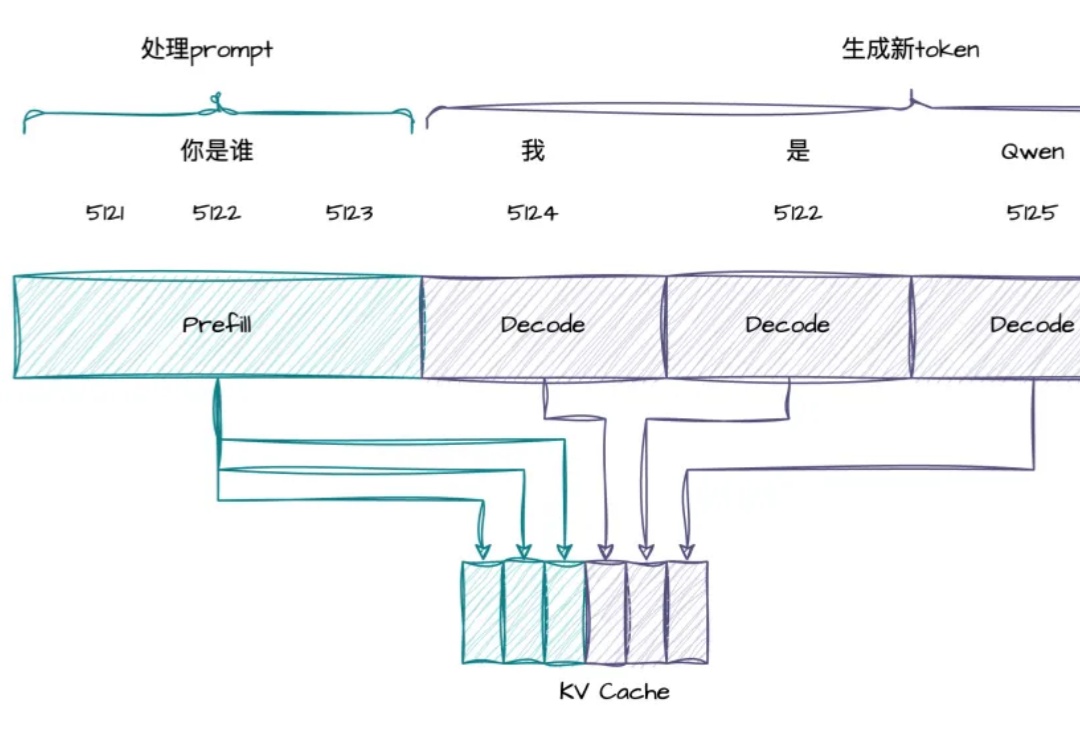

搞定Agent的"失忆症",TME树状记忆引擎让Agent再也不会"忘记"之前做过什么。| 最新开发Agent的工程师们都曾面临同一个棘手问题:当任务步骤增多,你的Agent就像患上"数字健忘症",忘记之前做过什么,无法处理用户的修改请求,甚至在多轮对话中迷失自我。不仅用户体验受损,token开销也居高不下。TME树状记忆引擎通过结构化状态管理方案,彻底解决了这一痛点,让你的Agent像拥有完美记忆力的助手,在复杂任务中游刃有余,同时将token消耗降低26%。