AI大模型的风,正在吹进情趣用品市场

AI大模型的风,正在吹进情趣用品市场2025年伊始,DeepSeek的落地引起了时代的科技大震荡,而随着其爆红,国内网友也玩出了各种新花样:年轻人深夜用它算命、股民根据它的建议炒股、单身贵族把它当“赛博月老”寻姻缘......不少人甚至和其谈起了恋爱。他(她)们把自己的理想型输入AI模型,用话术和AI“产崽”,打造一个私人订制版的“完美恋人”。

2025年伊始,DeepSeek的落地引起了时代的科技大震荡,而随着其爆红,国内网友也玩出了各种新花样:年轻人深夜用它算命、股民根据它的建议炒股、单身贵族把它当“赛博月老”寻姻缘......不少人甚至和其谈起了恋爱。他(她)们把自己的理想型输入AI模型,用话术和AI“产崽”,打造一个私人订制版的“完美恋人”。

谷歌DeepMind 研究科学家 Nicholas Carlini,一位机器学习和计算机安全领域的大牛。以最贴近现实实用的角度,分享了他对大模型的看法,以及自己对大模型应用的50个案例。

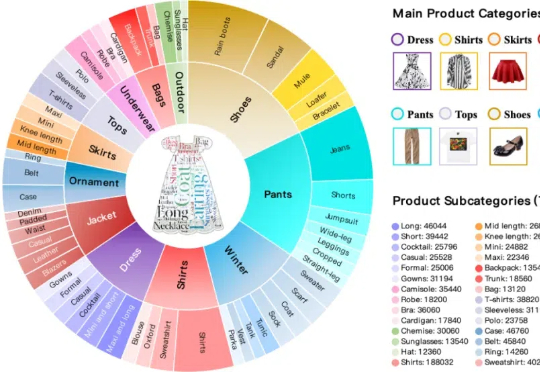

本文构建了新的多轮组合图像检索数据集和评测基准FashionMT。其特点包括:(1)回溯性:每轮修改文本可能涉及历史参考图像信息(如保留特定属性),要求算法回溯利用多轮历史信息;(2)多样化:FashionMT包含的电商图像数量和类别分别是MT FashionIQ的14倍和30倍,且交互轮次数量接近其27倍,提供了丰富的多模态检索场景。

满血版DeepSeek R1部署A100,基于INT8量化,相比BF16实现50%吞吐提升! 美团搜推机器学习团队最新开源,实现对DeepSeek R1模型基本无损的INT8精度量化。

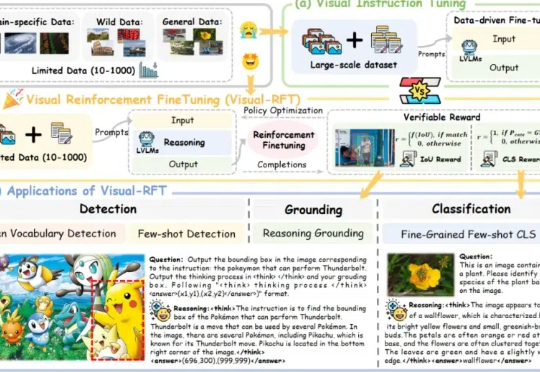

通过针对视觉的细分类、目标检测等任务设计对应的规则奖励,Visual-RFT 打破了 DeepSeek-R1 方法局限于文本、数学推理、代码等少数领域的认知,为视觉语言模型的训练开辟了全新路径!

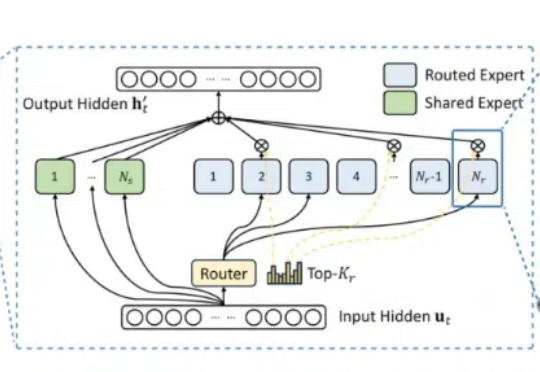

DeepSeek MoE“变体”来了,200美元以内,内存需求减少17.6-42%! 名叫CoE(Chain-of-Experts),被认为是一种“免费午餐”优化方法,突破了MoE并行独立处理token、整体参数数量较大需要大量内存资源的局限。

基于内置思维链的思考方法为解决多轮会话中存在的问题提供了研究方向。按照思考方法收集训练数据集,通过有监督学习微调大语言模型;训练一个一致性奖励模型,并将该模型用作奖励函数,以使用强化学习来微调大语言模型。结果大语言模型的推理能力和计划能力,以及执行计划的能力得到了增强。

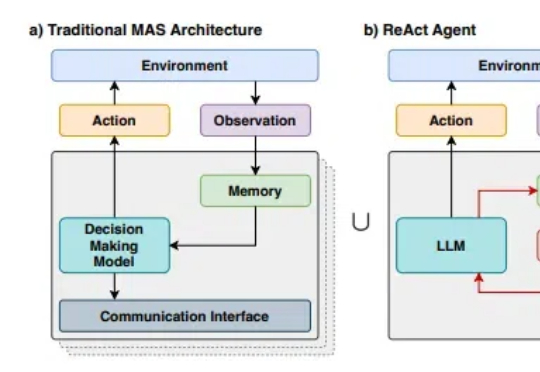

随着R1等先进推理模型展现出接近人类的推理能力,多代理系统(Multi-Agent Systems,MAS)的发展也出现了前所未有的机遇。然而,随着我们尝试构建越来越复杂的多代理系统,一个核心问题日益凸显:如何在保持系统灵活性的同时,降低开发和维护的复杂度?

上周DeepSeek连续5天开源硬核技术,阿里开源万相2.1,Qwen的推理模型推出预览版,但是肯定马上也要开源。而今天,智谱这个曾经的开源之光,在昨天官宣拿了杭州10亿融资之后,在官宣文章里如此写道:

要知道,过去几年,各种通用评测逐渐同质化,越来越难以评估模型真实能力。GPQA、MMLU-pro、MMLU等流行基准,各家模型出街时人手一份,但局限性也开始暴露,比如覆盖范围狭窄(通常不足 50 个学科),不含长尾知识;缺乏足够挑战性和区分度,比如 GPT-4o 在 MMLU-Pro 上准确率飙到 92.3%。