「小模型」有更多机会点

「小模型」有更多机会点大厂为什么追求大模型? 昨天有提到,为什么要研究语言模型。

大厂为什么追求大模型? 昨天有提到,为什么要研究语言模型。

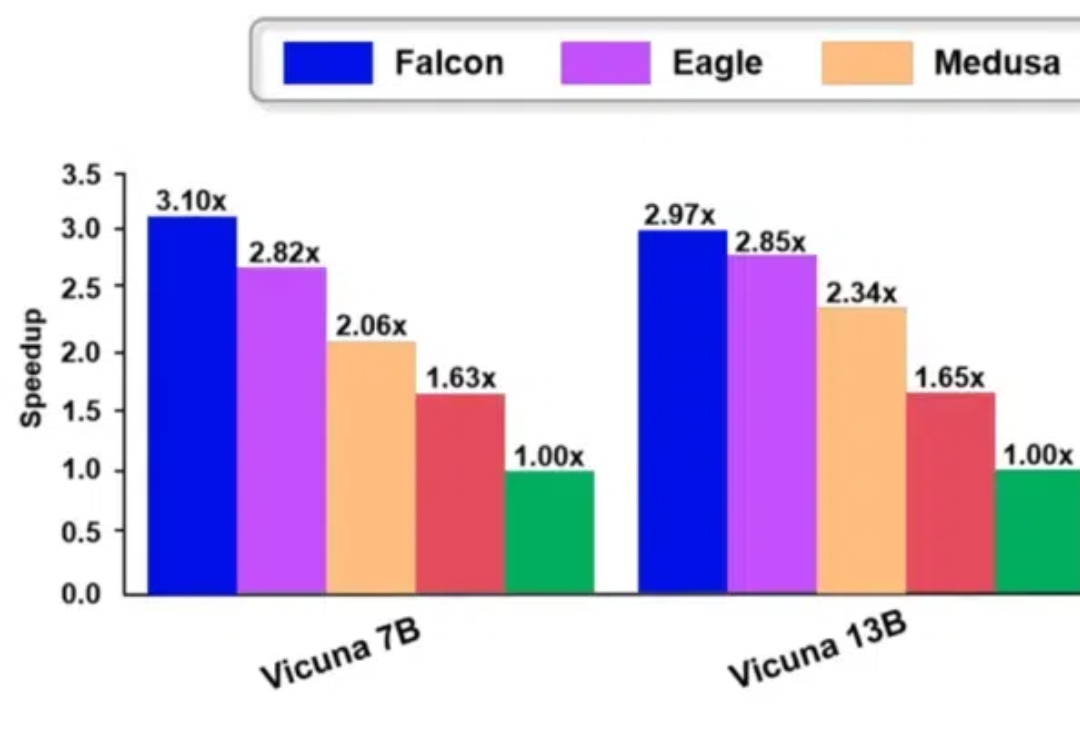

Falcon 方法是一种增强半自回归投机解码框架,旨在增强 draft model 的并行性和输出质量,以有效提升大模型的推理速度。Falcon 可以实现约 2.91-3.51 倍的加速比,在多种数据集上获得了很好的结果,并已应用到翼支付多个实际业务中。

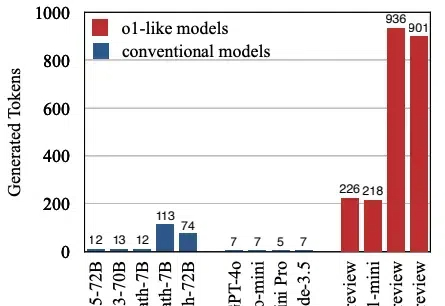

本文将介绍首个关于 o1 类长思维链模型过度思考现象。该工作由腾讯 AI Lab 与上海交通大学团队共同完成。

大模型引发的科技和创业热潮,已经迈入了第三年。

1/10训练数据激发高级推理能力!近日,来自清华的研究者提出了PRIME,通过隐式奖励来进行过程强化,提高了语言模型的推理能力,超越了SFT以及蒸馏等方法。

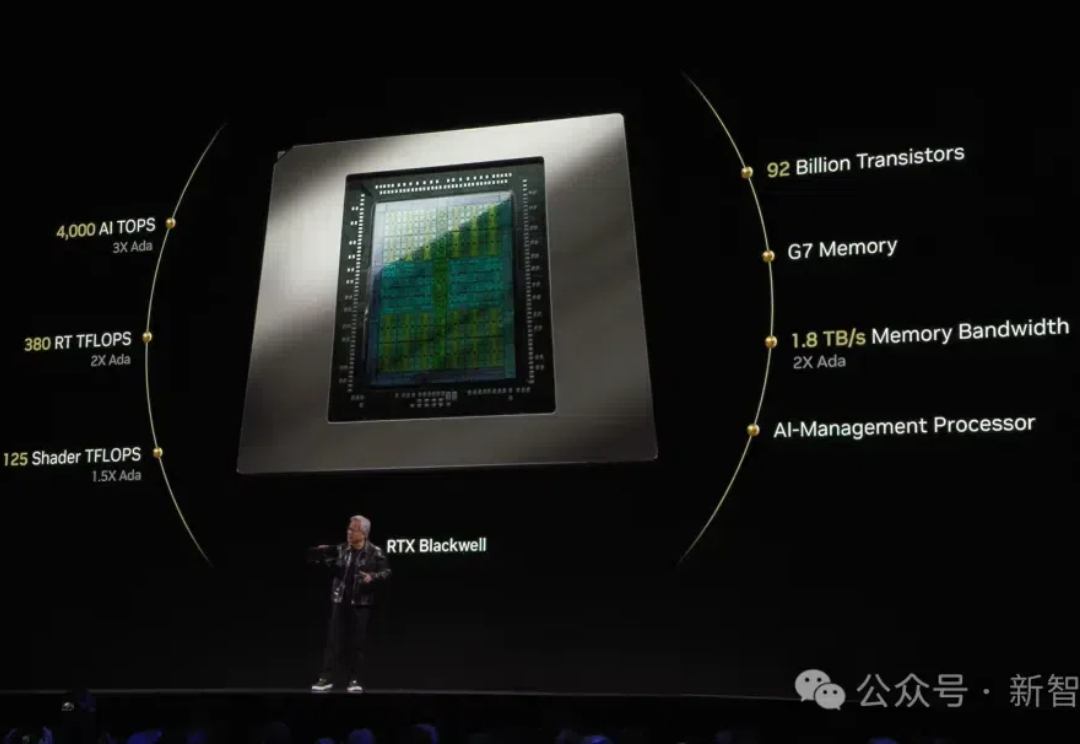

就在刚刚,RTX 5090震撼发布,国行版定价16499元!同时震撼亮相的,还有全球最小AI超算Project Digits,在办公桌上就能跑出数据中心级算力!这一刻老黄摆出别致pose,吸引了全球目光。

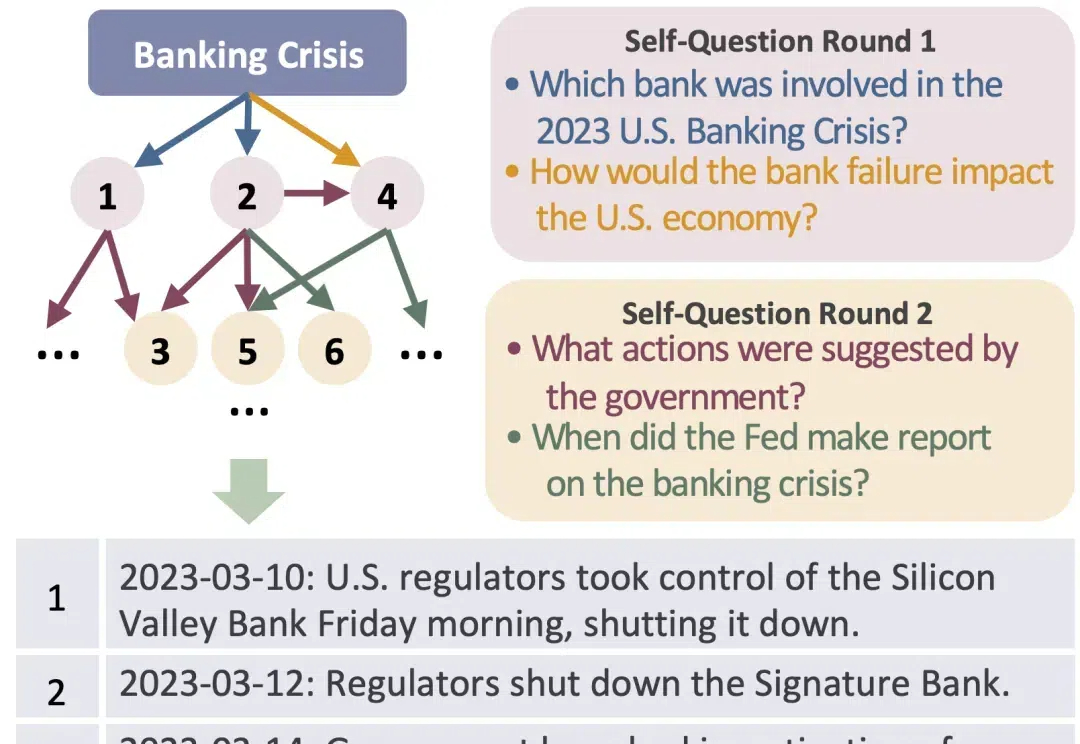

现在,大模型可以帮你梳理新闻时间线了,以后吃瓜就更方便了! AI Agent的风,咱们赛博乐子人也得吹吹。 这就是来自阿里巴巴通义实验室与上海交通大学的新研究,他们提出了一种基于Agent的新闻时间线摘要新框架——CHRONOS。

陈丹琦团队又带着他们的降本大法来了—— 数据砍掉三分之一,大模型性能却完全不减。 他们引入了元数据,加速了大模型预训练的同时,也不增加单独的计算开销。

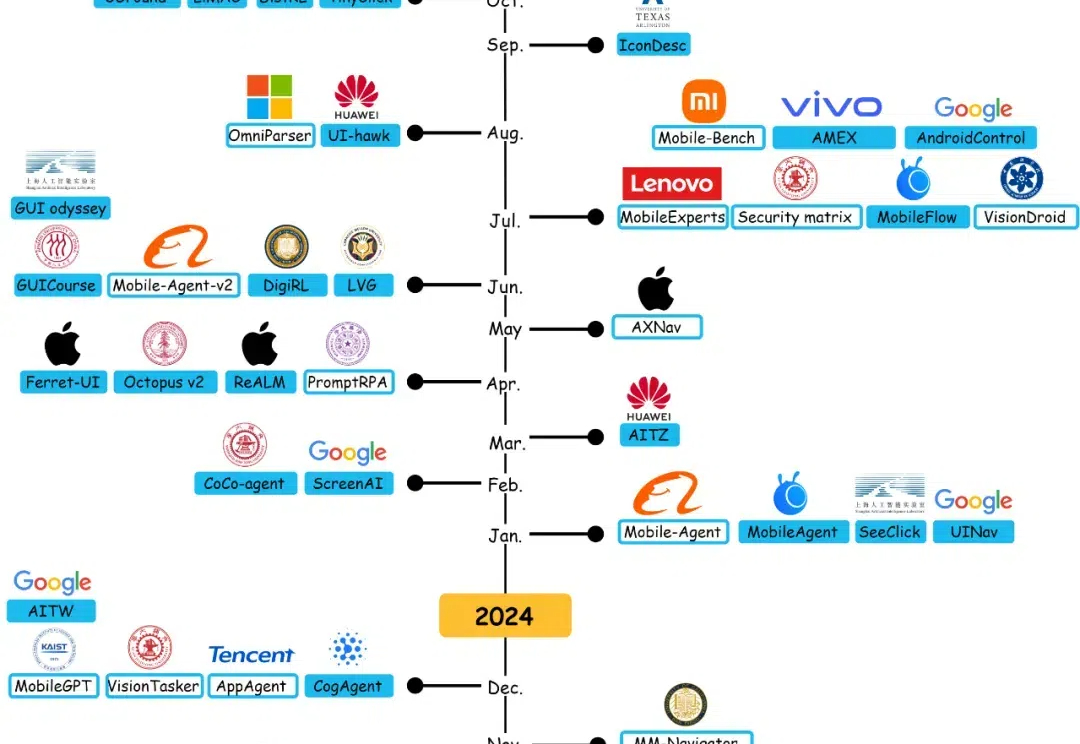

最近国内外的手机厂商和 AI 公司纷纷发布了手机 AI 智能体相关产品,让曾经的幻想逐渐有了可行性。

游戏玩家最为关心得为英伟达献出多少大洋,黄仁勋却寥寥几页带过了消费级显卡,把大段叙述留给了AI,以及智能体、世界模型、机器人、自动驾驶、超算等因AI渗透发生进展的领域,未来又将如何被英伟达改变。