不是RNN的锅!清华团队深入分析长上下文建模中的状态崩溃,Mamba作者点赞

不是RNN的锅!清华团队深入分析长上下文建模中的状态崩溃,Mamba作者点赞RNN模型在长上下文中表现不佳?近日,来自清华的研究团队对此进行了深入的实验分析,结果表明:不是RNN的锅。

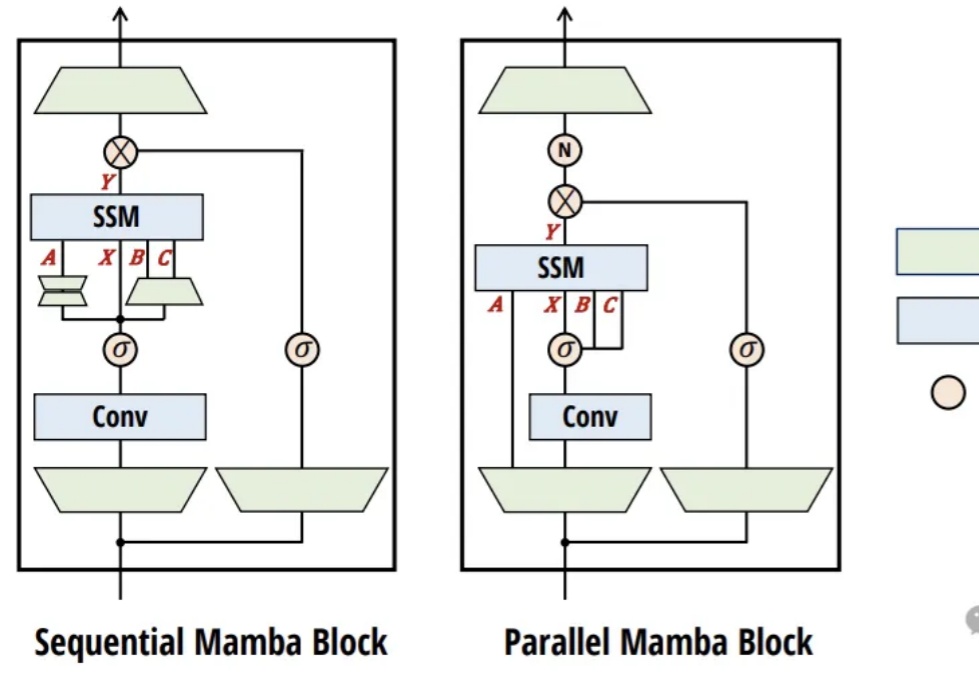

RNN模型在长上下文中表现不佳?近日,来自清华的研究团队对此进行了深入的实验分析,结果表明:不是RNN的锅。

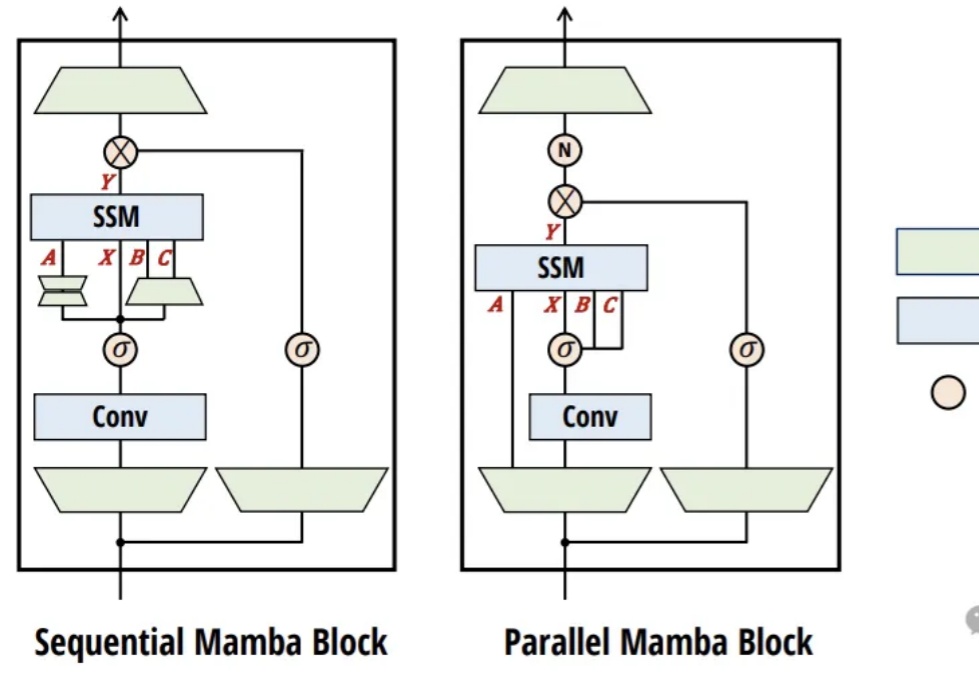

Meta最近开源了多个AI项目,包括图像分割模型SAM 2.1、多模态语言模型Spirit LM、自学评估器和改进的跨语言句子编码器Mexma等,提升了AI在图像处理和语音识别领域的能力,进一步推动了AI研究的进展。

近日,面对EDA界对于自家AlphaChip的质疑,谷歌首席科学家Jeff Dean以论文回应论文,并表示:大家注意,这是同行竞争!

一个有效的复杂系统总是从一个有效的简单系统演化而来的。——John Gall

完蛋了,高考落榜了!

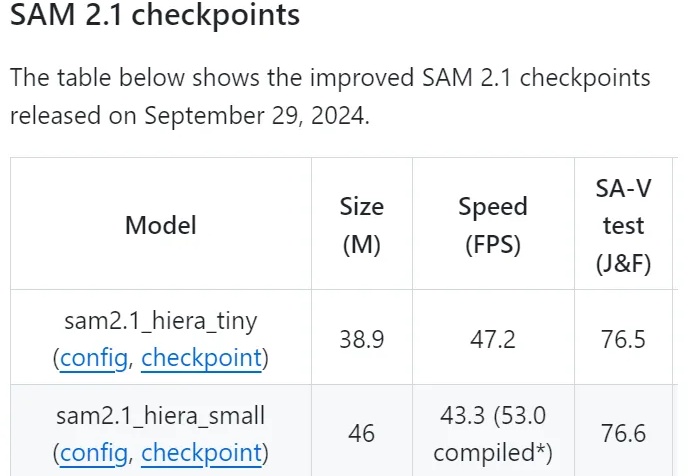

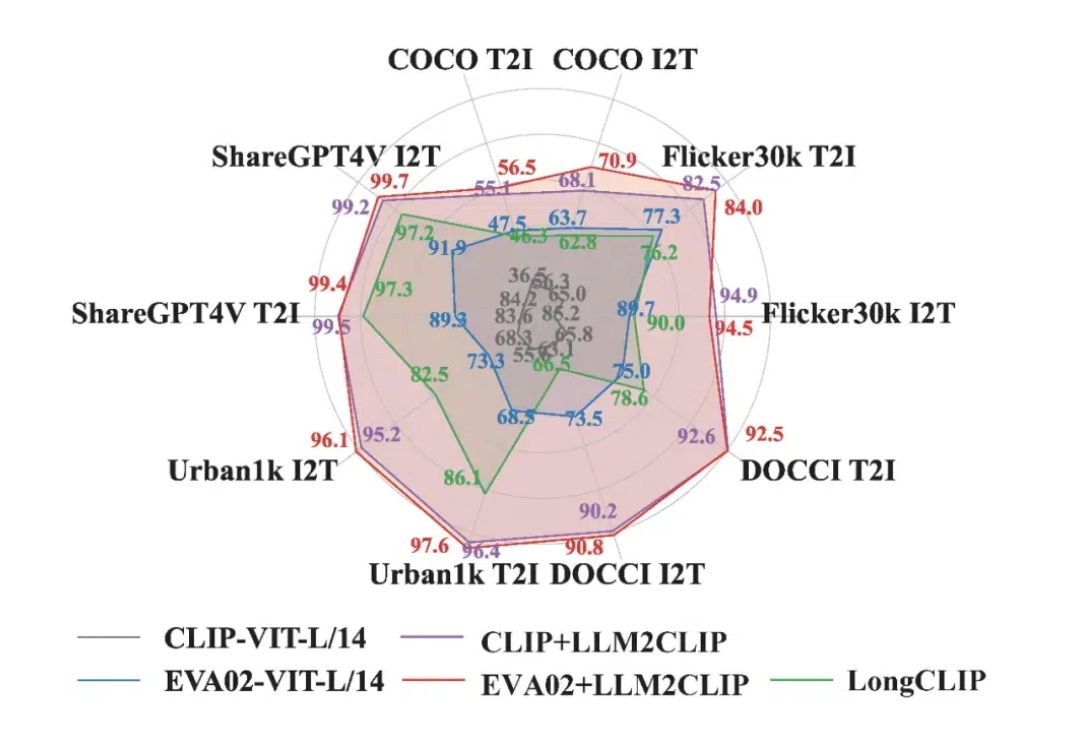

在当今多模态领域,CLIP 模型凭借其卓越的视觉与文本对齐能力,推动了视觉基础模型的发展。CLIP 通过对大规模图文对的对比学习,将视觉与语言信号嵌入到同一特征空间中,受到了广泛应用。

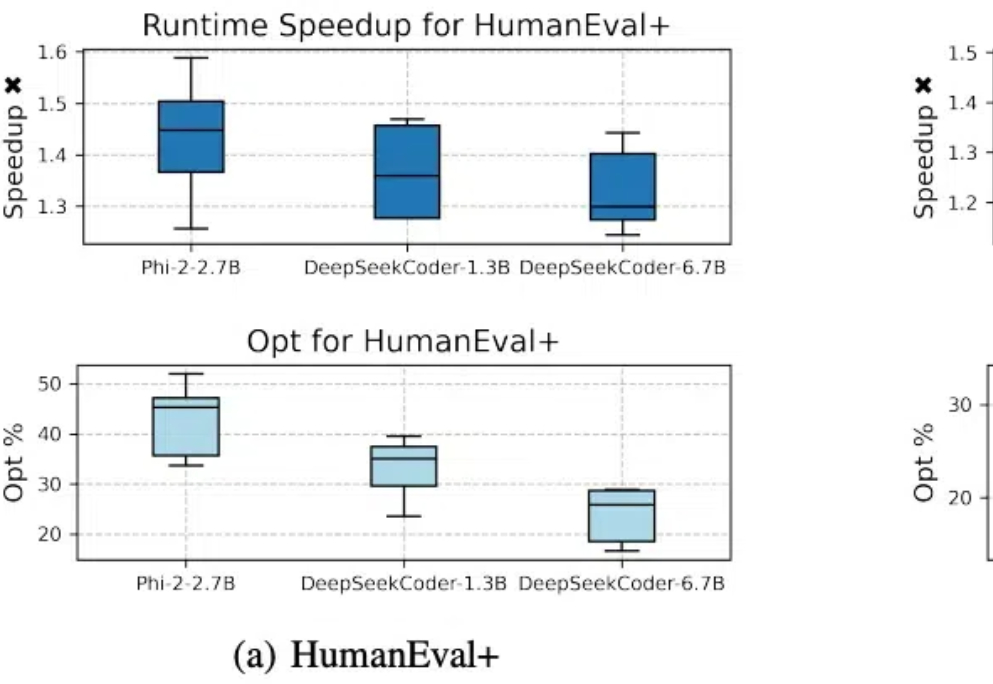

代码模型SFT对齐后,缺少进一步偏好学习的问题有解了。 北大李戈教授团队与字节合作,在模型训练过程中引入偏好学习,提出了一个全新的代码生成优化框架——CodeDPO。

只要改一行代码,就能让大模型训练效率提升至1.47倍。

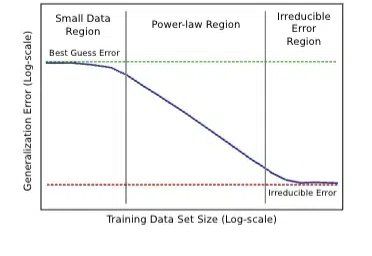

什么?Scaling Law最早是百度2017年提的?! Meta研究员翻出经典论文: 大多数人可能不知道,Scaling law原始研究来自2017年的百度,而非三年后(2020年)的OpenAI。

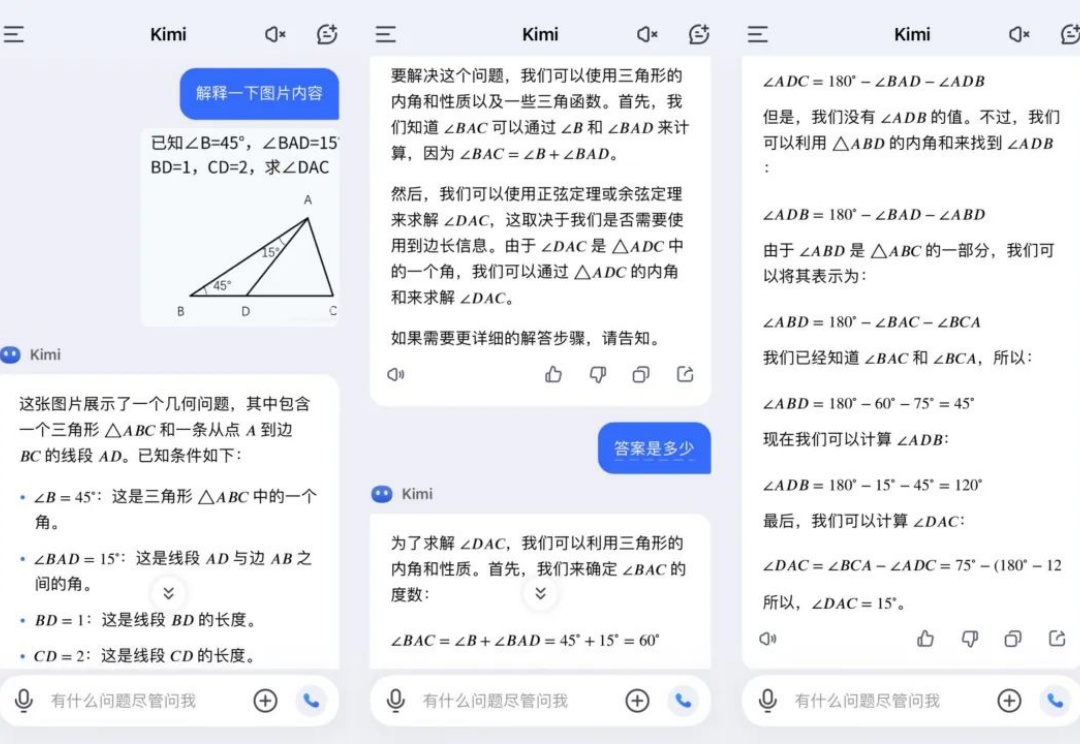

家人们,国产o1大模型,最近着实是有点火啊。 就在今天,昆仑万维的Skywork o1也开启了邀测。 那一波实测,这不就得安排一下么。