一张图,快速生成可拆分3D角色!腾讯清华新SOTA | CVPR 2025

一张图,快速生成可拆分3D角色!腾讯清华新SOTA | CVPR 2025任意一张立绘,就可以生成可拆分3D角色!

任意一张立绘,就可以生成可拆分3D角色!

一个超越DeepSeek GRPO的关键RL算法出现了!这个算法名为DAPO,字节、清华AIR联合实验室SIA Lab出品,现已开源。禹棋赢,01年生,本科毕业于哈工大,直博进入清华AIR,目前博士三年级在读。去年年中,他以研究实习生的身份加入字节首次推出的「Top Seed人才计划」。

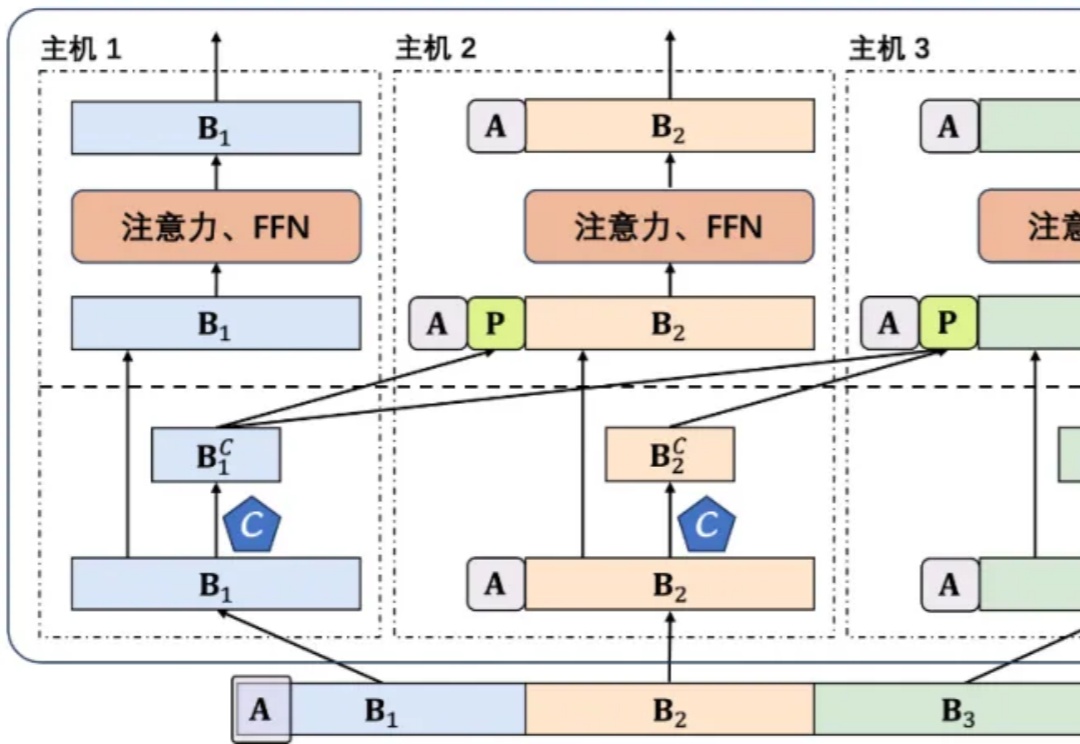

DeepSeek 提出的 GRPO 可以极大提升 LLM 的强化学习效率,不过其论文中似乎还缺少一些关键细节,让人难以复现出大规模和工业级的强化学习系统。

36氪获悉,近日人形机器人公司松延动力北京科技有限公司(以下简称「松延动力」)完成连续两轮过亿元A轮及A+轮融资。A+轮由彬复领投,华强资本跟投;A轮投资方包括神骐资本、北京未来科学城基金、天启资本、泽然资本、教育科技集团战略方等机构。

Neurobo(弈智交互)是一家位于上海的创业公司,获得前百度总裁、微软副总裁陆奇博士创办的奇绩创坛的投资。团队核心成员来自清华大学与日本筑波大学等海内外名校,致力于结合 LLM 与现实场景数据,让二次元用户可以将「谷子」变为随身相伴,随时触达的实体情感伴侣。

Transformer架构迎来历史性突破!刚刚,何恺明LeCun、清华姚班刘壮联手,用9行代码砍掉了Transformer「标配」归一化层,创造了性能不减反增的奇迹。

「国产大模型 + 国产引擎 + 国产芯片」的完整技术闭环正在加速形成。

AI智能体,确实到了爆发时刻。

开年以来,DeepSeek的梁文锋、Manus的肖弘,成为中国AI圈冉冉升起的新星。培养他们的母校浙江大学和华中科技大学也一并沾光。

在 ChatGPT 爆火两年多的时间里,大语言模型的上下文窗口长度基准线被拉升,以此为基础所构建的长 CoT 推理、多 Agent 协作等类型的高级应用也逐渐增多。