论文党狂喜!alphaXiv推出Deep Research一秒搜遍arXiv,研究效率直接爆表

论文党狂喜!alphaXiv推出Deep Research一秒搜遍arXiv,研究效率直接爆表刚刚,alphaXiv 推出了新功能「Deep Research for arXiv」,该功能可协助研究人员更高效地在 arXiv 平台上进行学术论文的检索与阅读,显著提升文献检索及研究效率。

刚刚,alphaXiv 推出了新功能「Deep Research for arXiv」,该功能可协助研究人员更高效地在 arXiv 平台上进行学术论文的检索与阅读,显著提升文献检索及研究效率。

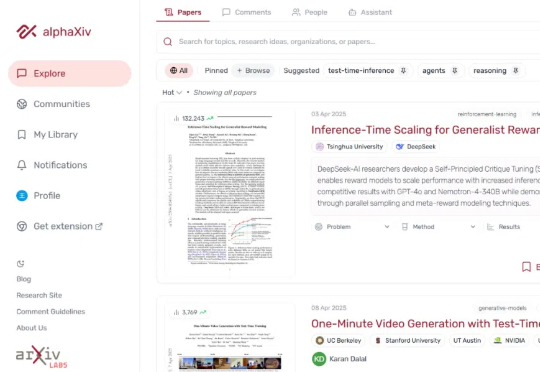

面对大模型,三家大厂有相同的目标,选了不同的路径。

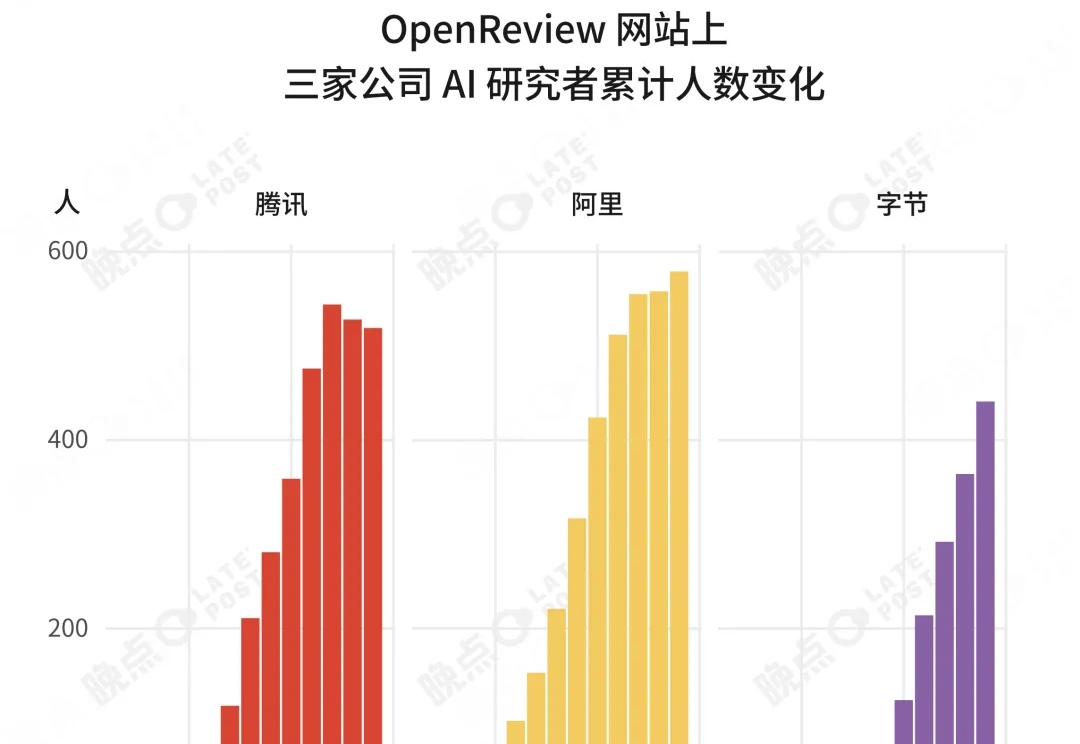

路由LLM是指一种通过router动态分配请求到若干候选LLM的机制。论文提出且开源了针对router设计的全面RouterEval基准,通过整合8500+个LLM在12个主流Benchmark上的2亿条性能记录。将大模型路由问题转化为标准的分类任务,使研究者可在单卡甚至笔记本电脑上开展前沿研究。

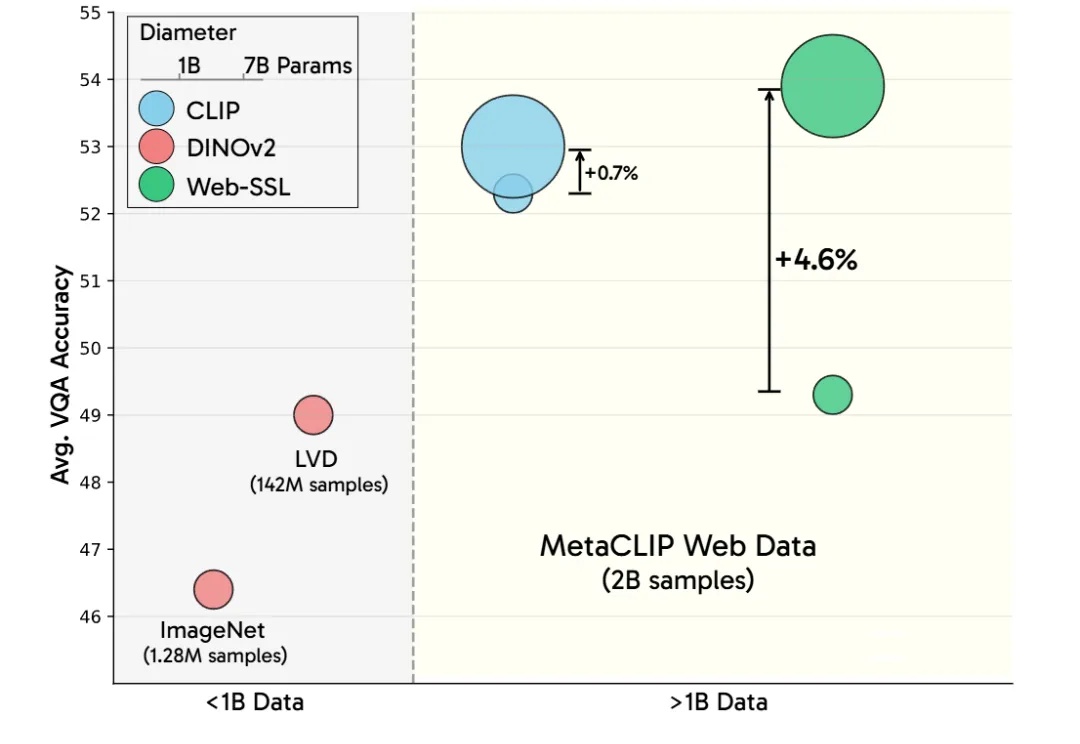

LeCun谢赛宁等研究人员通过新模型Web-SSL验证了SSL在多模态任务中的潜力,证明其在扩展模型和数据规模后,能媲美甚至超越CLIP。这项研究为无语言监督的视觉预训练开辟新方向,并计划开源模型以推动社区探索。

来自UIUC等大学的华人团队,从LLM的基础机制出发,揭示、预测并减少幻觉!通过实验,研究人员揭示了LLM的知识如何相互影响,总结了幻觉的对数线性定律。更可预测、更可控的语言模型正在成为现实。

今天我兴奋地跟大家分享一个超级实用的新资源——Claude团队刚刚发布了一份全面的Prompt Engineering指南!作为一个每天都在摸索各种AI提示技巧的科技爱好者,我第一时间深入研究了这份指南,发现这简直就是AI无代码开发的宝典啊!

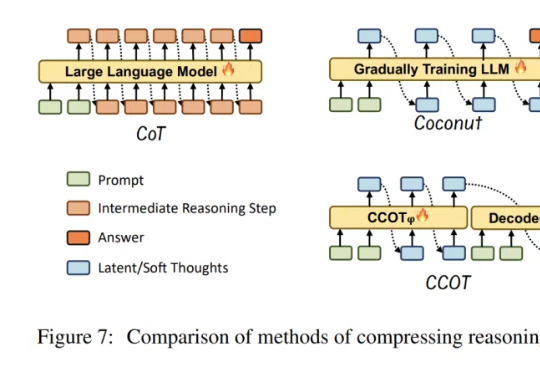

近年来,大语言模型(LLM)的性能提升逐渐从训练时规模扩展转向推理阶段的优化,这一趋势催生了「测试时扩展(test-time scaling)」的研究热潮。

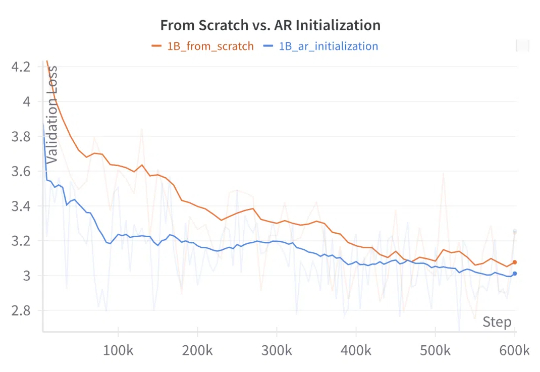

语言是离散的,所以适合用自回归模型来生成;而图像是连续的,所以适合用扩散模型来生成。在生成模型发展早期,这种刻板印象广泛存在于很多研究者的脑海中。

最新研究发现,LLM在面对人格测试时,会像人一样「塑造形象」,提升外向性和宜人性得分。AI的讨好倾向,可能导致错误的回复,需要引起警惕。

大模型虽然推理能力增强,却常常「想太多」,回答简单问题也冗长复杂。Rice大学的华人研究者提出高效推理概念,探究了如何帮助LLM告别「过度思考」,提升推理效率。