会用AI才能多发论文,LLM助力科研效率提升!新研究登Nature子刊

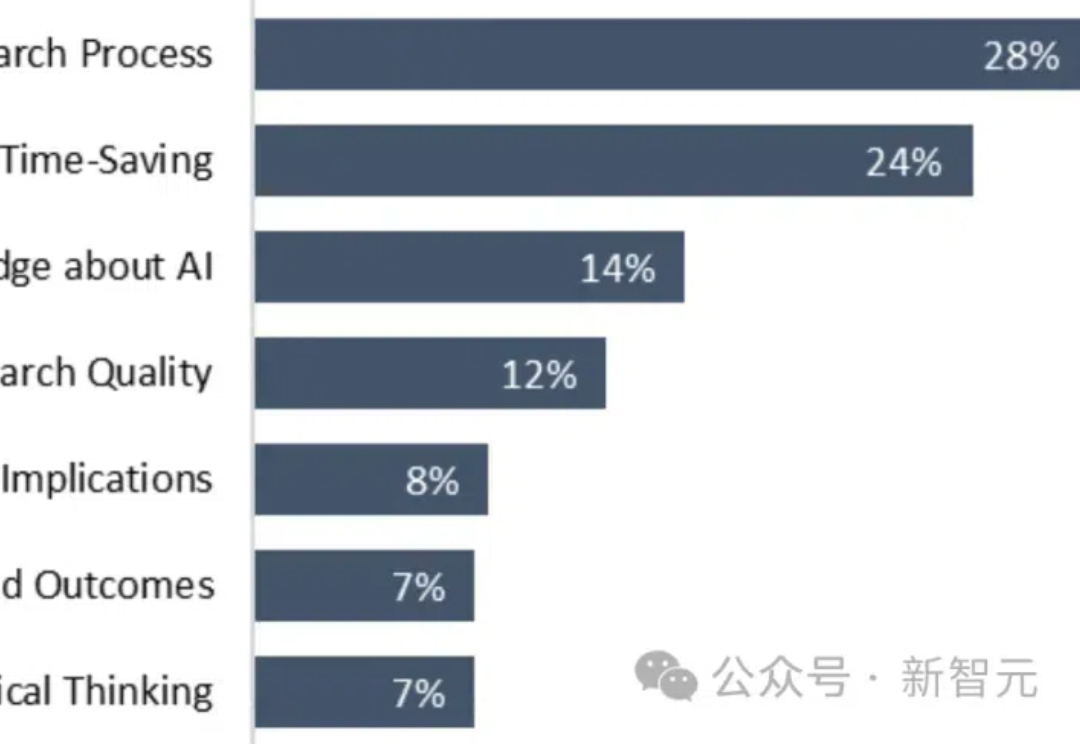

会用AI才能多发论文,LLM助力科研效率提升!新研究登Nature子刊Nature子刊近日发布了一项研究,针对学术写作中大模型的使用。他们发现,那些了解LLM以及大模型相关技术的受访者有更多的发表文章数量。

Nature子刊近日发布了一项研究,针对学术写作中大模型的使用。他们发现,那些了解LLM以及大模型相关技术的受访者有更多的发表文章数量。

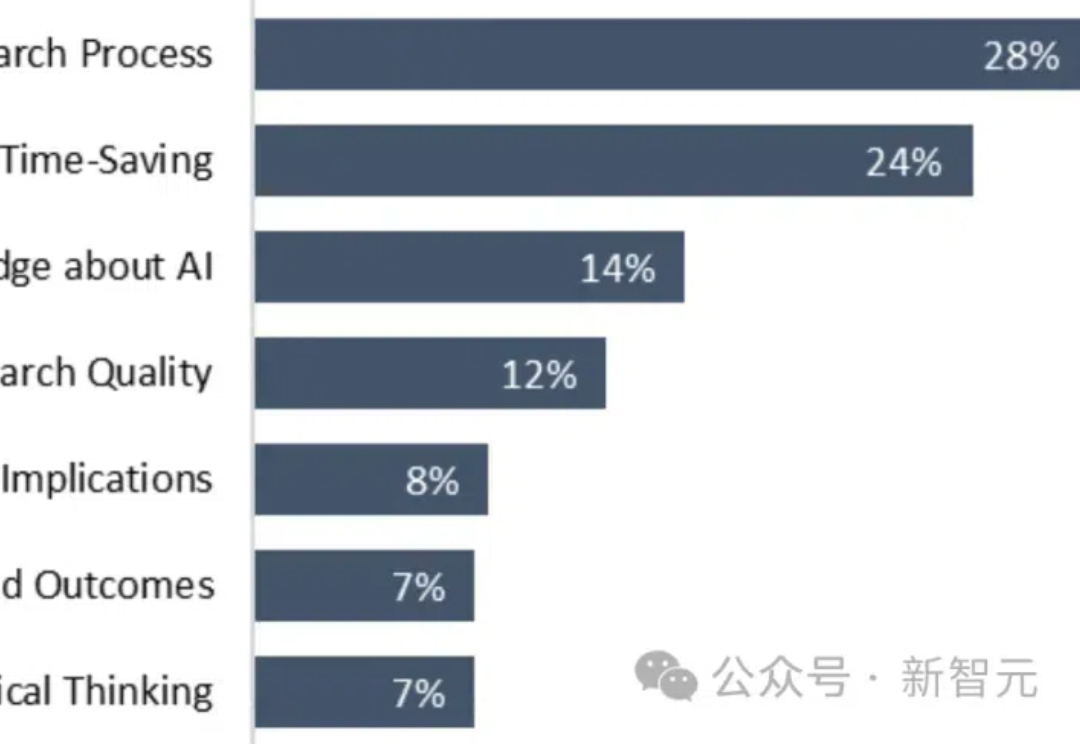

2024年11月15日,加州理工学院生物学和生物工程系的Jieyu Zheng和Markus Meister发表了一篇震撼学界的论文《The Unbearable Slowness of Being: Why do we live at 10 bit/s?》[1]。这项研究揭示了一个令人不安的事实:人类大脑每秒仅能处理大约10比特信息。

在央视市场研究(CTR)、中国传媒大学广告学院和国家广告研究院联合发布的《2024中国广告主营销趋势调查报告》中,有一组数据非常残酷——75%的广告主计划不增加广告预算,投入维稳。

GAN已死?不,它卷土重来了!布朗大学和康奈尔大学的研究者刚刚提出了R3GAN,充分利用现代架构设计,彻底摒弃临时技巧,一半参数就能碾压扩散模型。网友惊呼:游戏规则要改变了!

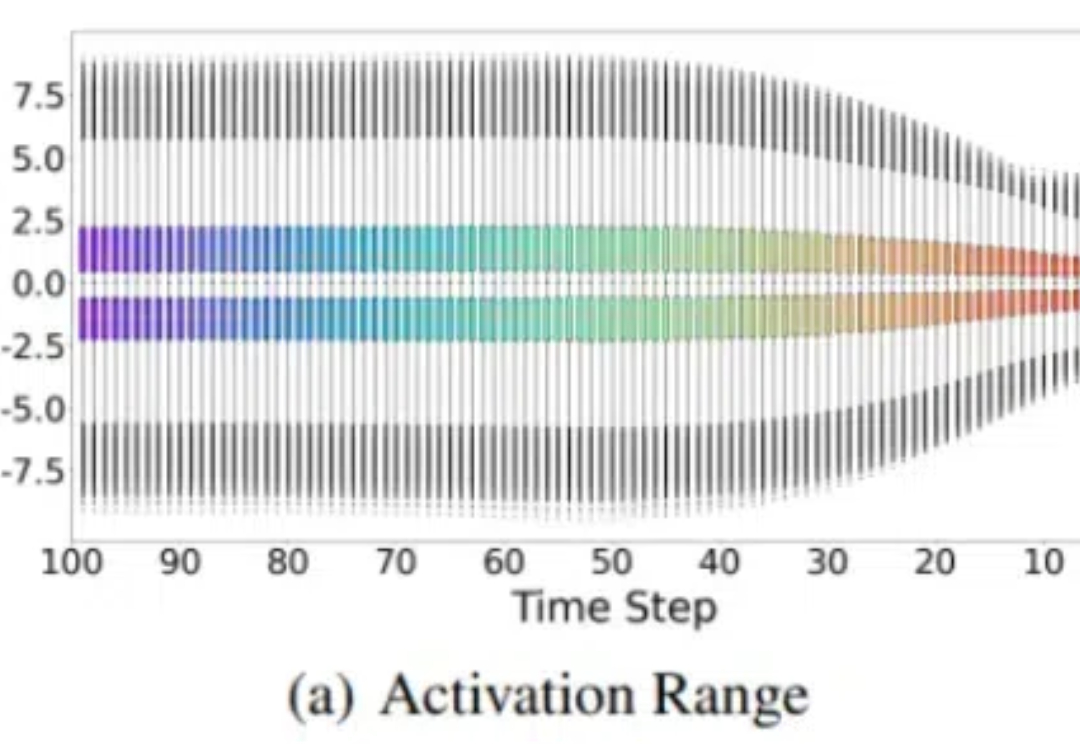

将扩散模型量化到1比特极限,又有新SOTA了! 来自北航、ETH等机构的研究人员提出了一种名为BiDM的新方法,首次将扩散模型(DMs)的权重和激活完全二值化。

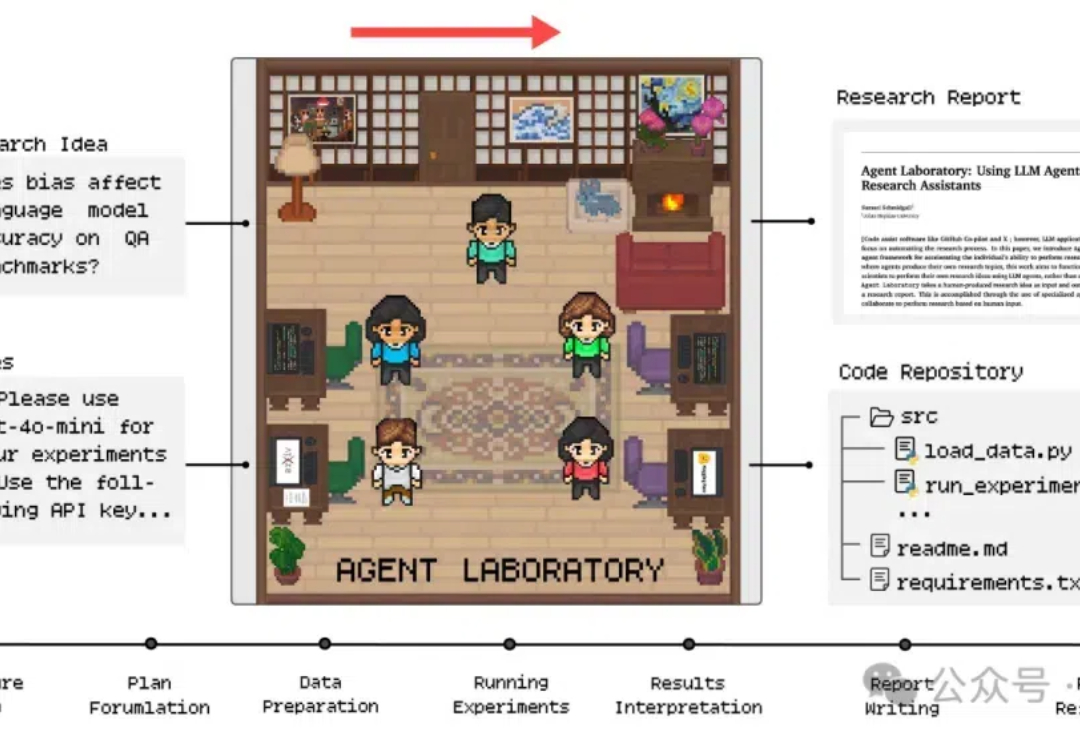

芯片强者AMD最新推出科研AI,o1-preview竟成天选打工人?! 注意看,只需将科研idea和相关笔记一股脑丢给AI,研究报告甚至是代码就能立马出炉了。

大连理工大学的研究人员提出了一种基于Wasserstein距离的知识蒸馏方法,克服了传统KL散度在Logit和Feature知识迁移中的局限性,在图像分类和目标检测任务上表现更好。

1月8日,环球时报社、中国科协新技术开发中心和清华大学技术创新研究中心联合发布了50大“新质生产力产业实践示范案例”,华为云盘古大模型凭借在技术能力、应用实践等方面的突出表现,成功入选“人工智能”示范案例TOP5。

最新综述论文探讨了知识蒸馏在持续学习中的应用,重点研究如何通过模仿旧模型的输出来减缓灾难性遗忘问题。通过在多个数据集上的实验,验证了知识蒸馏在巩固记忆方面的有效性,并指出结合数据回放和使用separated softmax损失函数可进一步提升其效果。

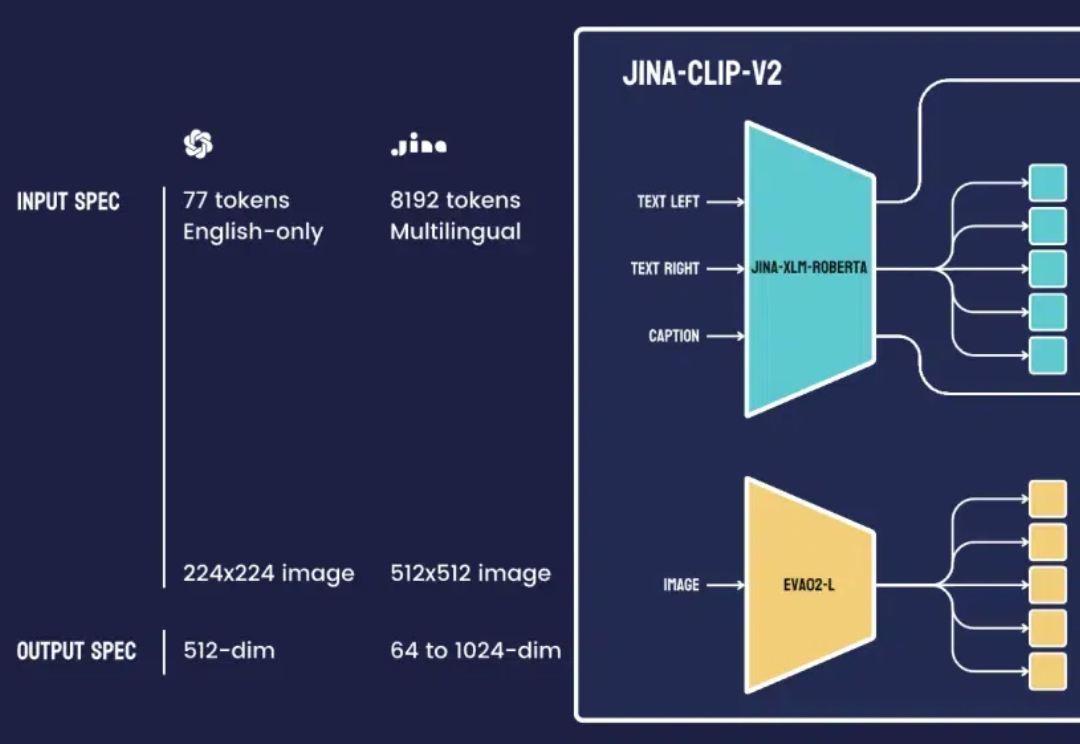

最近,我们团队的一位工程师在研究类 ColPali 模型时,受到启发,用新近发布的 jina-clip-v2 模型做了个颇具洞察力的可视化实验。