不是RNN的锅!清华团队深入分析长上下文建模中的状态崩溃,Mamba作者点赞

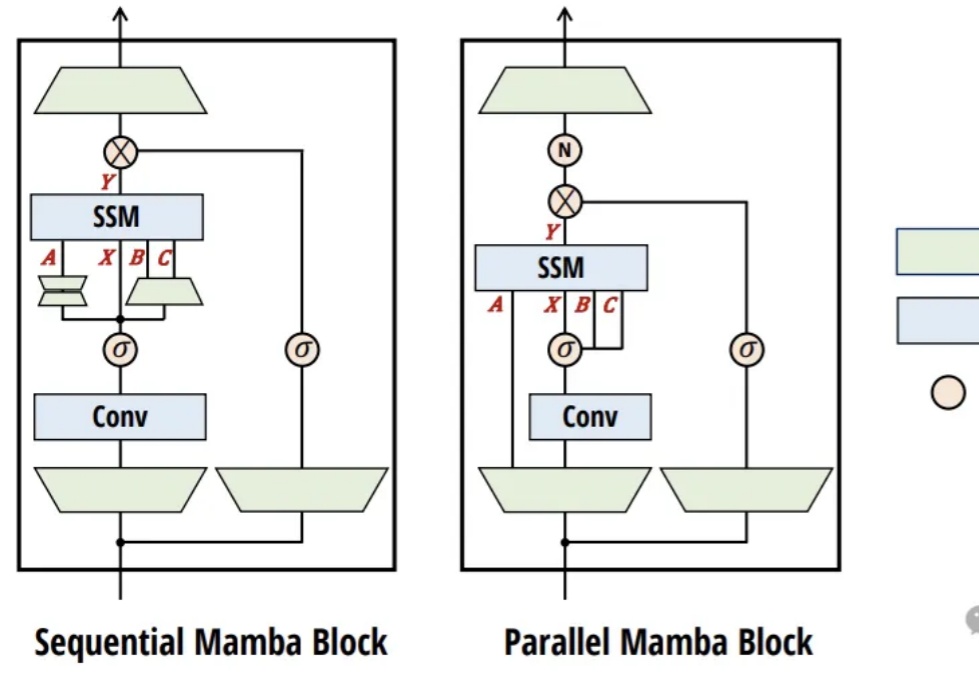

不是RNN的锅!清华团队深入分析长上下文建模中的状态崩溃,Mamba作者点赞RNN模型在长上下文中表现不佳?近日,来自清华的研究团队对此进行了深入的实验分析,结果表明:不是RNN的锅。

RNN模型在长上下文中表现不佳?近日,来自清华的研究团队对此进行了深入的实验分析,结果表明:不是RNN的锅。

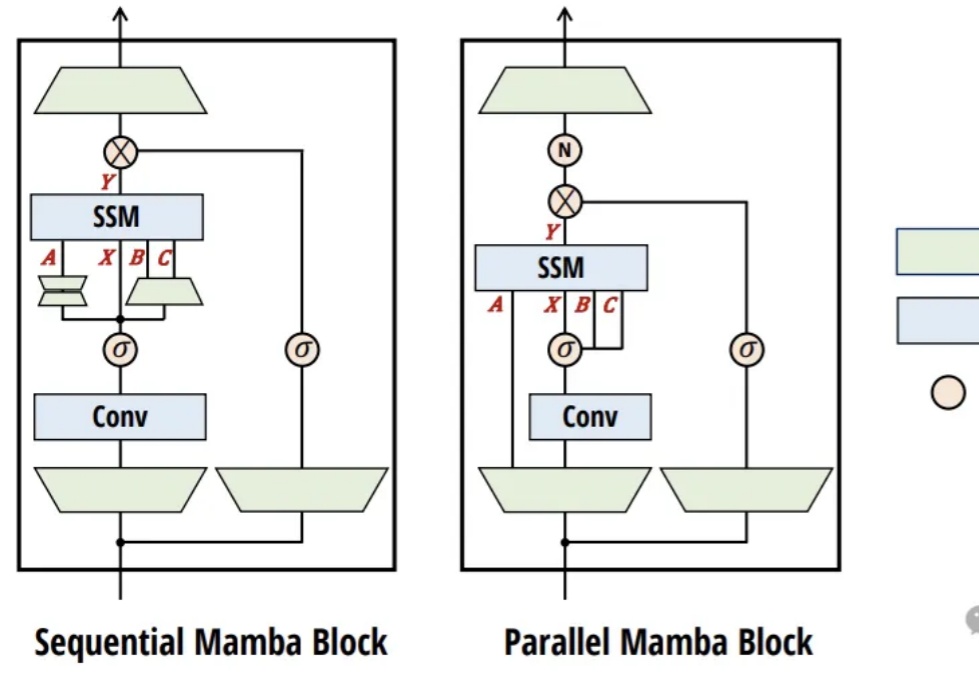

Meta最近开源了多个AI项目,包括图像分割模型SAM 2.1、多模态语言模型Spirit LM、自学评估器和改进的跨语言句子编码器Mexma等,提升了AI在图像处理和语音识别领域的能力,进一步推动了AI研究的进展。

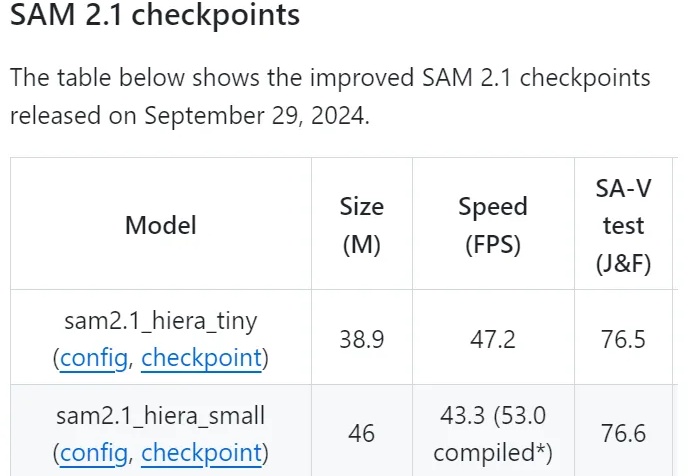

什么?Scaling Law最早是百度2017年提的?! Meta研究员翻出经典论文: 大多数人可能不知道,Scaling law原始研究来自2017年的百度,而非三年后(2020年)的OpenAI。

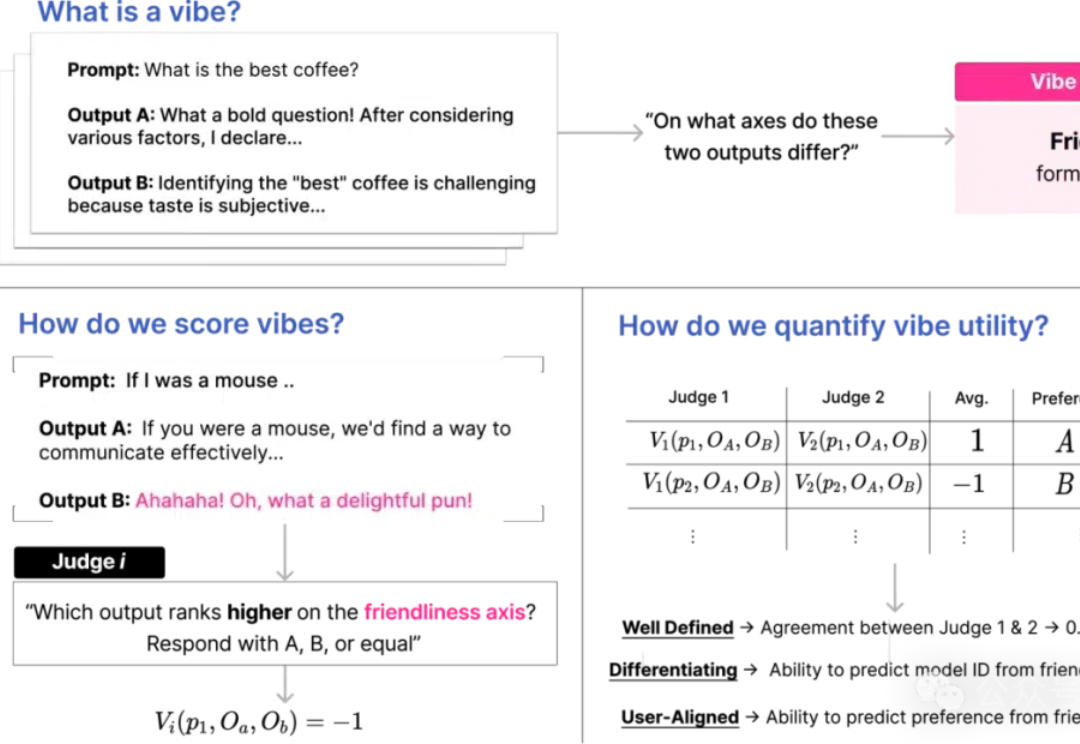

这篇文章研究了提示格式对大型语言模型(LLM)性能的影响。

近期,微软研究团队发布了一项重要的研究成果,揭示了AI推理能力从传统的提示工程方法(如Medprompt)到原生推理机制(如OpenAI的o1)演进的全貌。此项研究为正在开发AI产品的朋友们提供了宝贵的技术洞察。本文将详细分析这一研究的过程和结论,探讨其对AI推理领域及产品开发的深远影响。

本周一,知名 AI 学者、前谷歌大脑高级研究科学家 Yi Tay 在短短一年半的创业之后官宣回到谷歌,他显得很高兴。

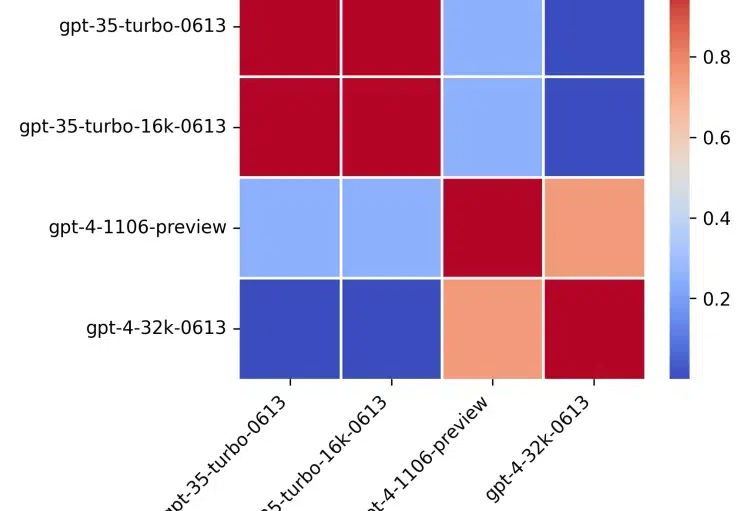

如果给LLM做MBTI,会得到什么结果?UC伯克利的最新研究就发现,不同模型真的有自己独特的性格

北京大学研究团队开发的FAN模型能有效捕捉数据中的周期性模式,相比传统模型在多项任务中表现出色,同时降低了参数量和计算量,增强了对周期性特征的建模能力,应用潜力广泛。

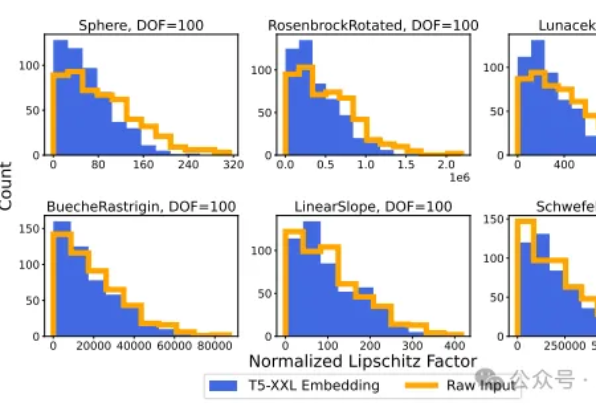

在人工智能领域,大语言模型(LLM)的向量嵌入能力一直被视为处理文本数据的利器。然而,斯坦福大学和Google DeepMind的研究团队带来了一个颠覆性发现:LLM的向量嵌入能力可以有效应用于回归任务。

Scaling Law撞墙了吗?OpenAI高级研究副总裁Mark Chen正式驳斥了这一观点。他表示,OpenAI已经有o系列和GPT系列两个模型,来让模型继续保持Scaling。