一夜落幕!AWS上海AI研究院解散,首席应用科学家告别

一夜落幕!AWS上海AI研究院解散,首席应用科学家告别刚刚,AWS亚马逊云科技上海AI研究院被曝解散!AI研究院首席应用科学家王敏捷在朋友圈中写道:「过去六年领导这个团队,正值外国研究机构在中国的黄金时期。」

刚刚,AWS亚马逊云科技上海AI研究院被曝解散!AI研究院首席应用科学家王敏捷在朋友圈中写道:「过去六年领导这个团队,正值外国研究机构在中国的黄金时期。」

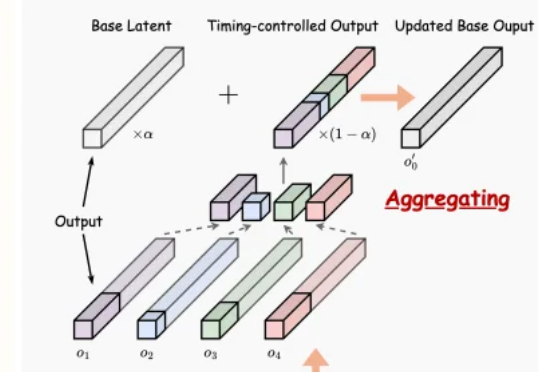

文生音频系统最新突破,实现精确时间控制与90秒长时音频生成!

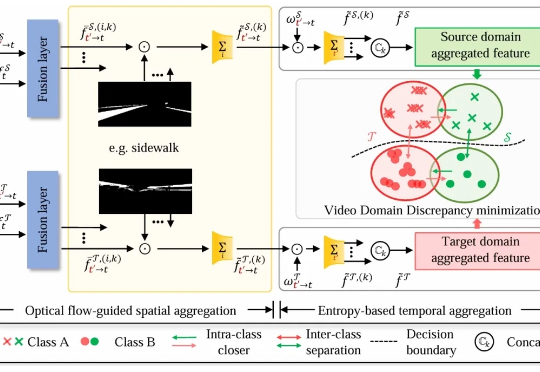

东北大学、武汉大学等的研究人员首次提出统一处理图像与视频的无监督领域自适应语义分割框架,通过四向混合机制(QuadMix)和光流引导的时空聚合模块,有效缩小跨域差异,显著提升模型性能,刷新多项基准记录。该方法不仅解决了图像与视频任务割裂的问题,还为未来多模态感知系统奠定了基础。

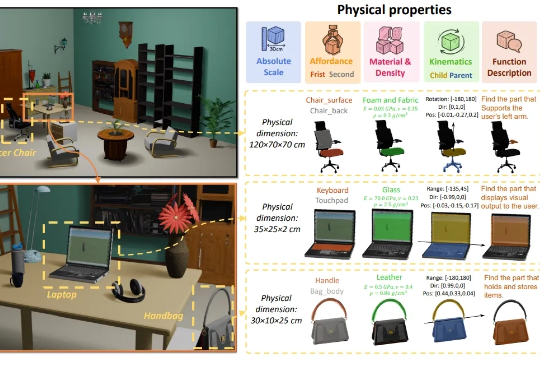

3D生成又补齐了一块重要拼图——物理属性! 南洋理工大学-商汤联合研究中心S-Lab,及上海人工智能实验室合作提出了PhysXNet,号称首个系统性标注的物理基础3D数据集。

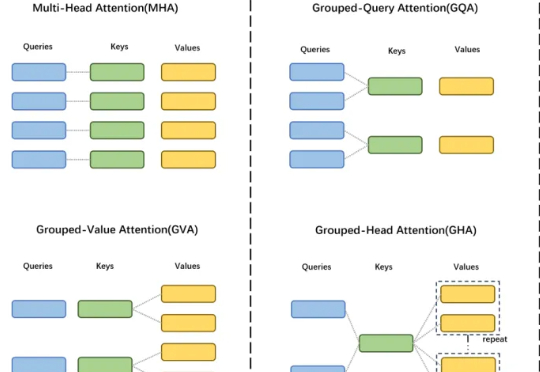

GTA 工作由中国科学院自动化研究所、伦敦大学学院及香港科技大学(广州)联合研发,提出了一种高效的大模型框架,显著提升模型性能与计算效率。

百度再推AI搜索一、百度再推AI搜索APP DataEye研究院发现,日前,百度再度推出一款AI搜索应用“Tizzy.AI”

本文的主要作者来自复旦大学和南洋理工大学 S-Lab,研究方向聚焦于视觉推理与强化学习优化。

让机器人像人一样边看边理解,来自浙江大学和vivo人工智能实验室的研究团队带来了新进展。

7月21日,《朝鲜新报》发布了对金日成综合大学信息科学部人工智能技术研究所所长金光赫(김광혁)的专访。7月21日,《朝鲜新报》发布了对金日成综合大学信息科学部人工智能技术研究所所长金光赫(김광혁)的专访。

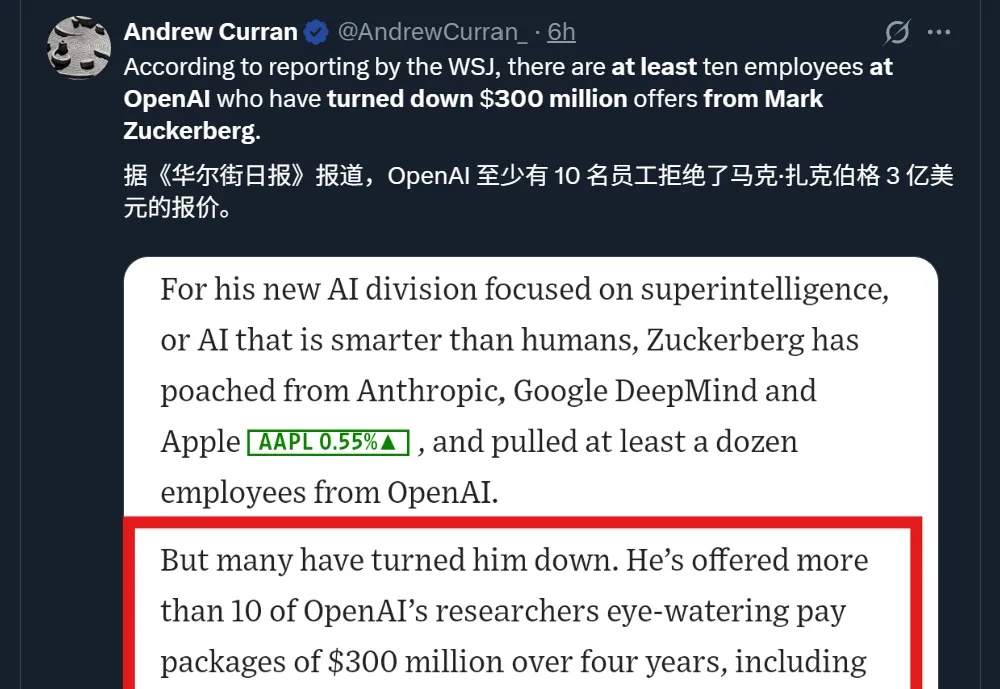

在OpenAI挖人挖到奥特曼破防,但小扎也是没少被发好人卡。