时隔多年,AI芯片又是华为发布会主角了

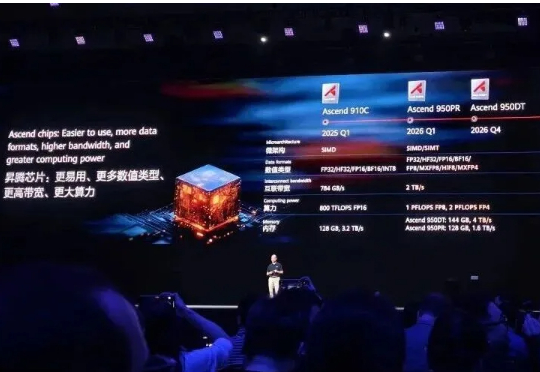

时隔多年,AI芯片又是华为发布会主角了继余承东三折叠手机发布会上亮相麒麟芯片后,AI算力芯片也有了最新进展。就在华为全联接大会上,轮值董事长徐直军,带来了全球最强算力超节点和集群!Atlas 950 SuperPoD和Atlas 960 SuperPoD超节点,分别支持8192及15488张昇腾卡。

继余承东三折叠手机发布会上亮相麒麟芯片后,AI算力芯片也有了最新进展。就在华为全联接大会上,轮值董事长徐直军,带来了全球最强算力超节点和集群!Atlas 950 SuperPoD和Atlas 960 SuperPoD超节点,分别支持8192及15488张昇腾卡。

马斯克“巨硬计划”(MACROHARD)新动作曝光: 6个月从0建起算力集群,已完成200MW供电规模,足以支持11万台英伟达GB200 GPU NVL72。仅用6个时间,完成了OpenAI和甲骨文等合作花费15个月完成的工作,再次创造纪录。

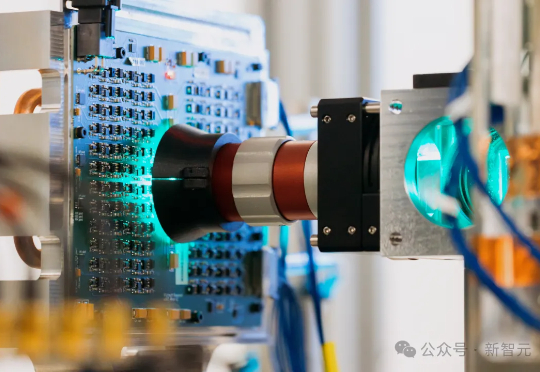

芯片再快,也快不过光!微软研究院在剑桥拼出了一台模拟光学计算机:用手机摄像头、Micro LED和透镜拼成,却在实验里跑出了速度快100倍、能效高100倍的潜力。这一成果如今登上Nature,或许,算力格局将被改写。

AI是否会在5年内破解黎曼猜想?是否会保持每年5x的算力扩张节奏?十年后,AI将把我们带向一个什么样的世界?近日,Epoch AI负责人Jaime Sevilla,与数据与分析负责人Yafah Edelman在对话中,为我们揭示了未来十年AI发展的路线图。

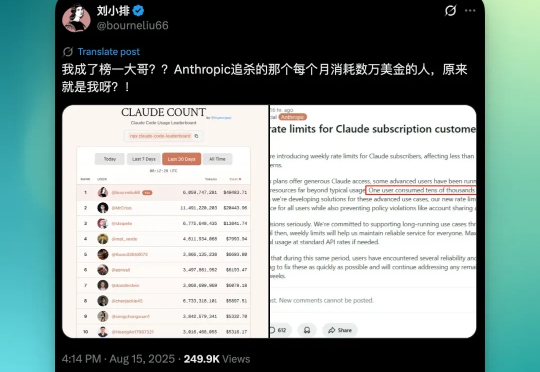

故事是这样的,两周前,Anthropic 上周发布一个公告:他们的工程师在后台数据中发现了一个异常账户,正在以一种不可思议的速度,7x24 小时消耗着 Claude 模型的算力。公告中提到:”有一位用户,在每月200美元的套餐中,消耗了价值 5 万美元的模型使用量。“ 这个消耗量大到,Anthropic 不得不公开发布声明调整全球用户的速率限制。

刚刚,据华尔街日报报道,OpenAI 正在为一部名为《Critterz》的动画长片提供工具和算力支持,预计将在明年 5 月的戛纳电影节上首映。《Critterz》讲的是一群森林小生物在陌生人打扰村庄后踏上冒险的故事。OpenAI 的创意专家 Chad Nelson 三年前在尝试用刚推出的 DALL-E 图像生成工具制作短片时

AI界奥数杯,重启了!OpenAI o3首次杀入赛场,在算力拉满的情况下,直接以最高47分的逆天成绩炸翻全场。值得一提的是,前五模型合并得分仅与o3差5分,开源与闭源差距再次缩小。

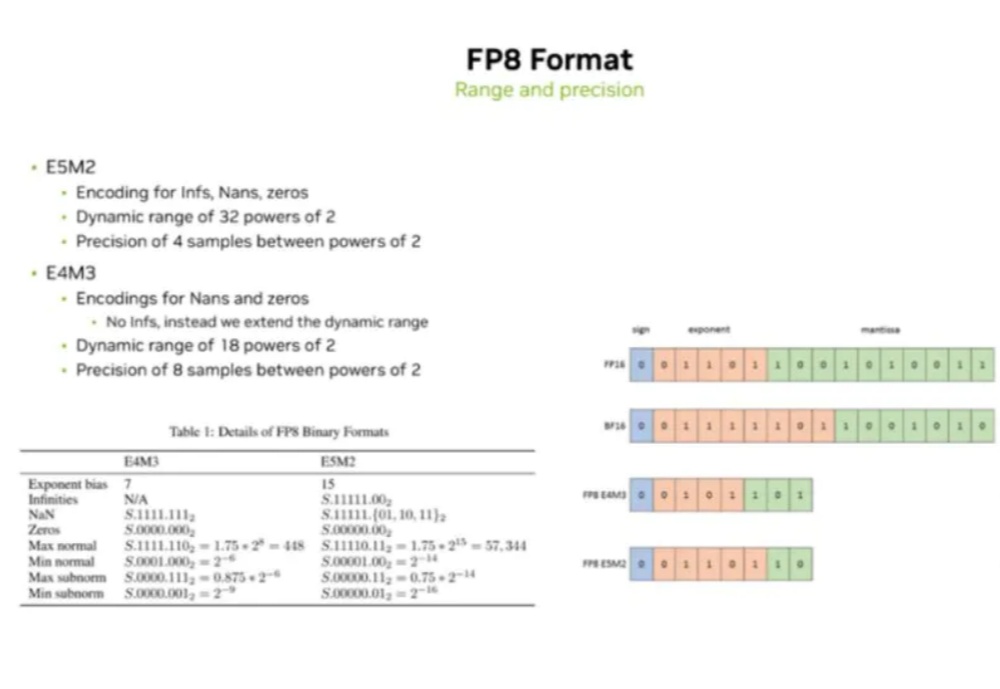

当前AI大模型(LLM)训练与推理对算力的巨大需求,以及传统计算精度(如FP16/BF16)面临的功耗、内存带宽和计算效率瓶颈。

OpenAI计划在印度建设至少1GW规模的数据中心,这是「星际之门」计划首次大规模进入亚洲。印度之所以重要,不仅因其庞大的用户增长潜力与低价特供服务,还因多语言应用场景。奥特曼虽淡出CEO角色,却亲自推动全球算力布局,印度成为其展现野心的关键起点。

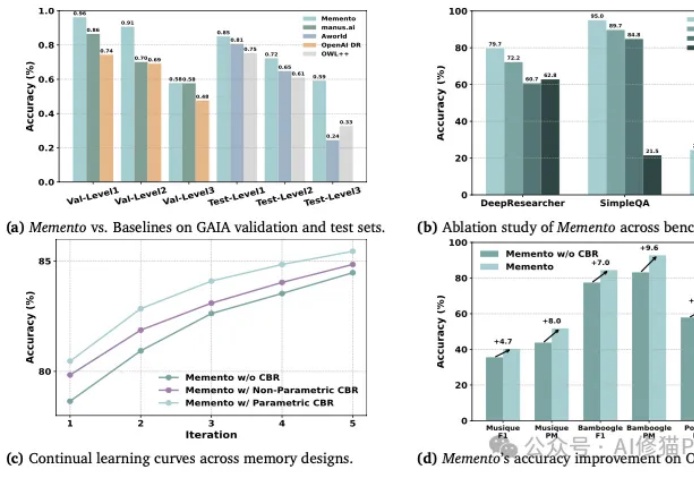

你或许也有过这样的猜想,如何让AI智能体(Agent)变得更聪明、更能干,同时又不用烧掉堆积如山的算力去反复微调模型?