NeurIPS Spotlight | 基于信息论,决策模型有了全新预训练范式统一框架

NeurIPS Spotlight | 基于信息论,决策模型有了全新预训练范式统一框架现如今,以 GPT 为代表的大语言模型正深刻影响人们的生产与生活,但在处理很多专业性和复杂程度较高的问题时仍然面临挑战。在诸如药物发现、自动驾驶等复杂场景中,AI 的自主决策能力是解决问题的关键,而如何进行决策大模型的高效训练目前仍然是开放性的难题。

现如今,以 GPT 为代表的大语言模型正深刻影响人们的生产与生活,但在处理很多专业性和复杂程度较高的问题时仍然面临挑战。在诸如药物发现、自动驾驶等复杂场景中,AI 的自主决策能力是解决问题的关键,而如何进行决策大模型的高效训练目前仍然是开放性的难题。

wwAutoLabeler2.0助力自动驾驶高效数据标注。

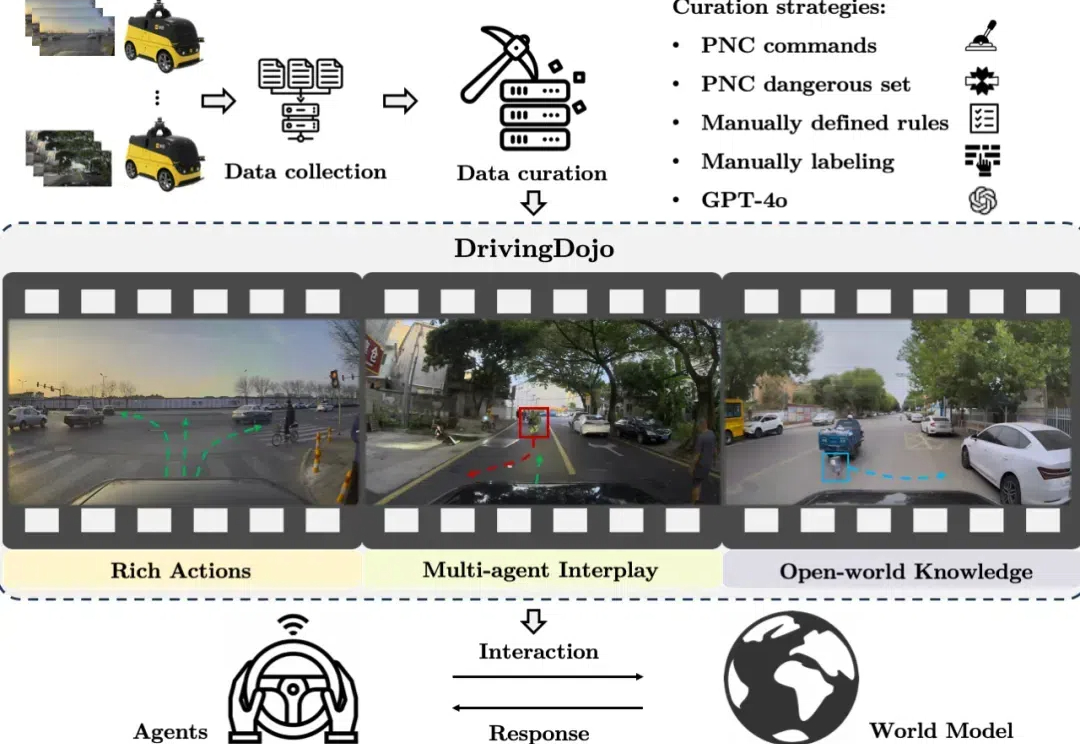

在自动驾驶领域,世界模型的应用尤为引人注目。然而,现有数据集在视频多样性和行为复杂性方面的不足,限制了世界模型潜力的全面发挥。为了解决这一瓶颈,中国科学院自动化研究所联合美团无人车团队推出了 DrivingDojo 数据集 —— 全球规模最大、专为自动驾驶世界模型研究设计的高质量视频数据集。该数据集已被 NeurIPS 2024 的 Dataset Track 接收。

刚刚,智谱来了一波大的—— 你的手机、PC等设备,统统都是可以让AI来自动驾驶了。

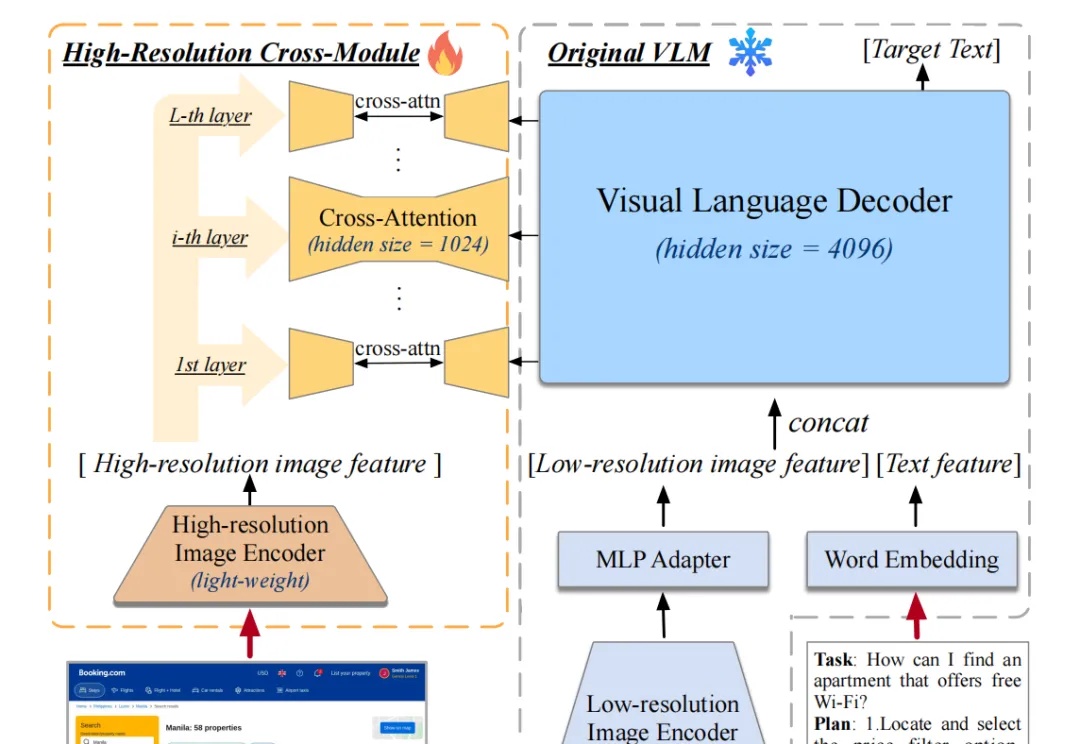

在人工智能(AI)技术飞速发展的今天,其在各个领域的应用不断拓展,从自动驾驶到智能助手,AI的身影无处不在。然而,在UI界面设计这一领域,尽管AI技术被寄予厚望,但其实际应用效果却远未达到预期。本文将探讨AI在UI界面设计中的影响、挑战,并结合具体工具案例进行分析。

在人工智能(AI)技术飞速发展的今天,其在各个领域的应用不断拓展,从自动驾驶到智能助手,AI的身影无处不在。然而,在UI界面设计这一领域,尽管AI技术被寄予厚望,但其实际应用效果却远未达到预期。本文将探讨AI在UI界面设计中的影响、挑战,并结合具体工具案例进行分析。

随着汽车进入“AI驱动”的时代,不止各大品牌新车拼智能,出行平台也在布局面向智驾产业的“自动驾驶工具链”。

近日,中科大王杰教授团队 (MIRA Lab) 针对离线强化学习数据集存在多类数据损坏这一复杂的实际问题,提出了一种鲁棒的变分贝叶斯推断方法,有效地提升了智能决策模型的鲁棒性,为机器人控制、自动驾驶等领域的鲁棒学习奠定了重要基础。论文发表在 CCF-A 类人工智能顶级会议 Neural Information Processing Systems(NeurIPS 2024)。

今年的机器人顶会 CoRL 杰出论文,竟然帮自动驾驶车稳稳地完成了漂移。

近期,智驾行业出现了一个融合了视觉、语言和动作的多模态大模型范式——VLA(Vision-Language-Action Model,即视觉-语言-动作模型),拥有更高的场景推理能力与泛化能力。不少智驾人士都将VLA视为当下“端到端”方案的2.0版本。