科技六巨头共话AI之际,我们对智能体也有一些思考

科技六巨头共话AI之际,我们对智能体也有一些思考在西雅图10月15日的联想科技创新大会上,罕见地汇聚了当前硅谷芯片三巨头,包括最近风头正盛的英伟达CEO黄仁勋、AMD CEO苏姿丰,以及英特尔CEO帕特·基辛格;另外,Meta CEO马克·扎克伯格、微软CEO萨提亚·纳德拉和高通CEO安蒙也通过远程连线的方式参与到活动中来。

在西雅图10月15日的联想科技创新大会上,罕见地汇聚了当前硅谷芯片三巨头,包括最近风头正盛的英伟达CEO黄仁勋、AMD CEO苏姿丰,以及英特尔CEO帕特·基辛格;另外,Meta CEO马克·扎克伯格、微软CEO萨提亚·纳德拉和高通CEO安蒙也通过远程连线的方式参与到活动中来。

禧玛诺将推AI变速系统Q'AUTO,挑战电助车市场。

华业天成A轮领投项目——芯丰精密近日宣布,其自主研发的环切机实现量产,装机量超两位数,稳定生产超10万片晶圆,为AI大算力芯片制造设备的国产替代提供支撑。

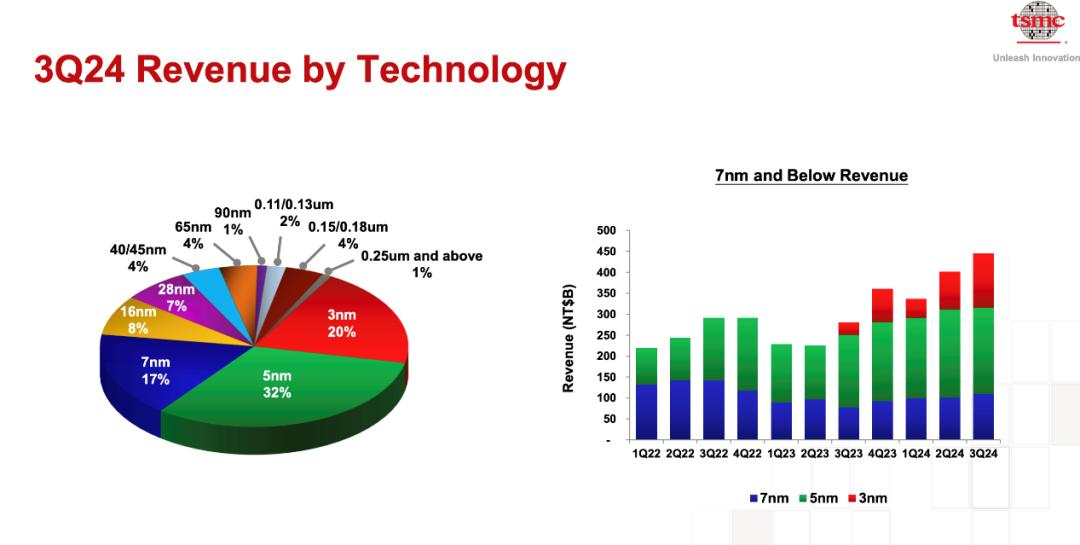

台积电3nm工艺引领AI芯片革新,营收激增。

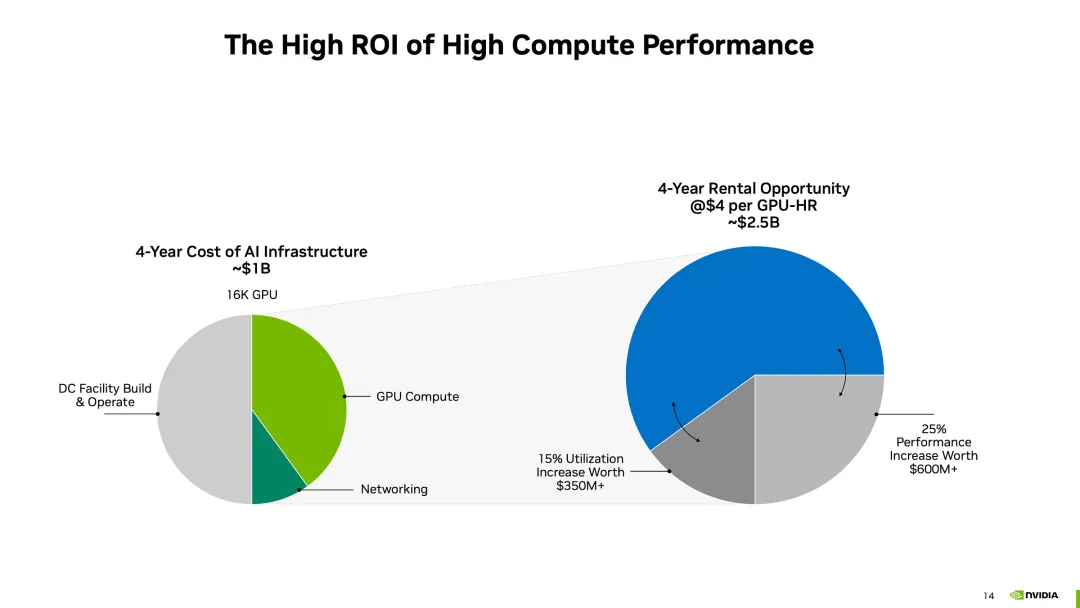

红杉资本的报告曾指出,AI产业的年产值超过6000亿美元,才够支付数据中心、加速GPU卡等AI基础设施费用。而现在一种普遍说法认为,基础模型训练的资本支出是“历史上贬值最快的资产”,但关于GPU基础设施支出的判定仍未出炉,GPU土豪战争仍在进行。

AI浪潮中的“定海神针”

安卓首款3nm、PC级Arm V9架构、第八代NPU——天玑9400,成为了移动AI芯片的最新最强成果! 相比上一代生成式AI芯片天玑9300,其AI能力更上一层楼,荣登苏黎世ETHZ移动SoC AI性能榜单之首。

一周全球AI热点

器官芯片结合AI技术推动药物开发进步。

杨立昆认为人工智能还有很长的路要走。