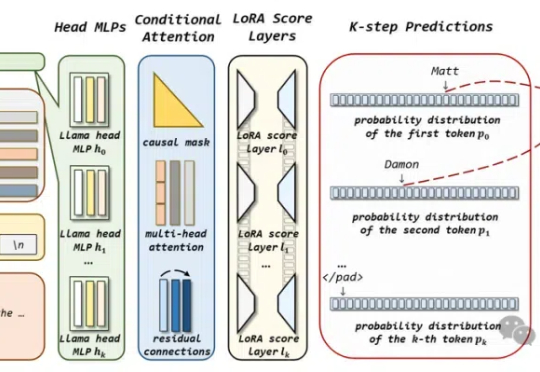

如何让大模型感知知识图谱知识?蚂蚁联合实验室:利用多词元并行预测给它“上课”

如何让大模型感知知识图谱知识?蚂蚁联合实验室:利用多词元并行预测给它“上课”如何让大模型感知知识图谱知识?

如何让大模型感知知识图谱知识?

最近,扩散模型在生成模型领域异军突起,凭借其独特的生成机制在图像生成方面大放异彩,尤其在处理高维复杂数据时优势明显。然而,尽管扩散模型在图像生成任务中表现优异,但在图像目标移除任务中仍然面临诸多挑战。现有方法在移除前景目标后,可能会留下残影或伪影,难以实现与背景的自然融合。

DeepSeek开源周第一天就放大招!FlashMLA强势登场,这是专为英伟达Hopper GPU打造MLA解码内核。注意,DeepSeek训练成本极低的两大关键,一个是MoE,另一个就是MLA。

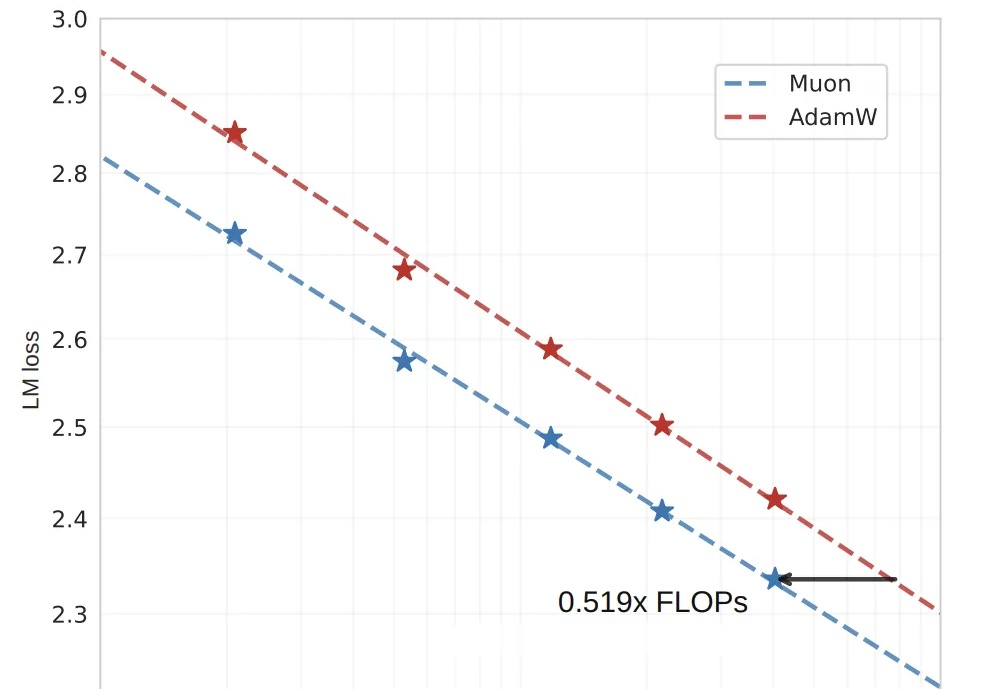

算力需求比AdamW直降48%,OpenAI技术人员提出的训练优化算法Muon,被月之暗面团队又推进了一步!

随着AI工具越来越普及,类似Deep Researh这样的工具越来越好用,科学研究成果呈现爆炸式增长。以arXiv为例,仅2024年10月就收到超过24,000篇论文提交。

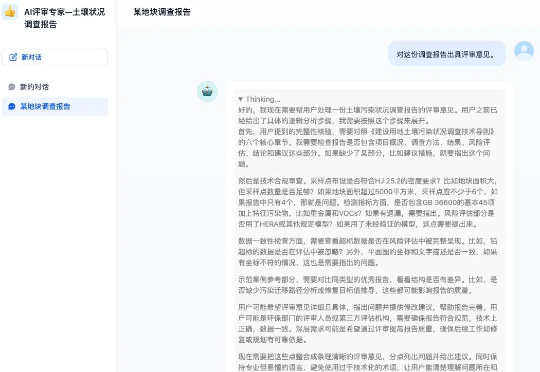

国内首个生态环境“AI报告评审专家”已完成土壤污染状况调查报告领域的前期训练,启动上线试运行。日前,无锡市梁溪生态环境局已完成DeepSeek-R1“满血版”大模型本地化部署,通过AI与生态环境业务深度融合,

“放弃生成式模型,不研究LLM(大语言模型),我们没办法只通过文本训练让AI达到人类的智慧水平。”近日,Meta首席AI科学家杨立昆(Yann LeCun)在法国巴黎的2025年人工智能行动峰会上再一次炮轰了生成式AI。

OpenAI o1视觉能力还是最强,模型们普遍“过于自信”!

把扩散模型的生成能力与 MCTS 的自适应搜索能力相结合,会是什么结果?

2 月 18 日,月之暗面发布了一篇关于稀疏注意力框架 MoBA 的论文。MoBA 框架借鉴了 Mixture of Experts(MoE)的理念,提升了处理长文本的效率,它的上下文长度可扩展至 10M。并且,MoBA 支持在全注意力和稀疏注意力之间无缝切换,使得与现有的预训练模型兼容性大幅提升。