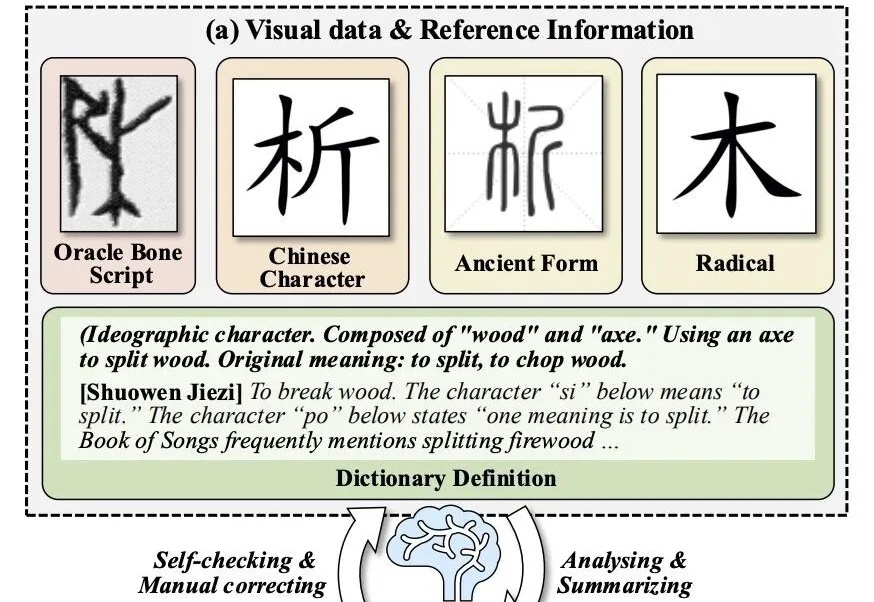

大模型破译甲骨文创下新SOTA!复旦团队推出新框架

大模型破译甲骨文创下新SOTA!复旦团队推出新框架让大模型破译从未见过的甲骨文,准确率拿下新SOTA!

让大模型破译从未见过的甲骨文,准确率拿下新SOTA!

周末在家扒拉上周更新的论文的时候,看到一篇我自己一直非常关心的领域的论文,而且还是来自发论文发的越来越少的OpenAI。

最新消息,AI 初创公司 Anthropic 同意支付至少 15 亿美元,来和解一起作家集体诉讼案件。此前,这些作家联合指控 Anthropic 盗版了他们的作品来训练其聊天机器人 Claude。

为了降低大模型预训练成本,最近两年,出现了很多新的优化器,声称能相比较AdamW,将预训练加速1.4×到2×。但斯坦福的一项研究,指出不仅新优化器的加速低于宣称值,而且会随模型规模的增大而减弱,该研究证实了严格基准评测的必要性。

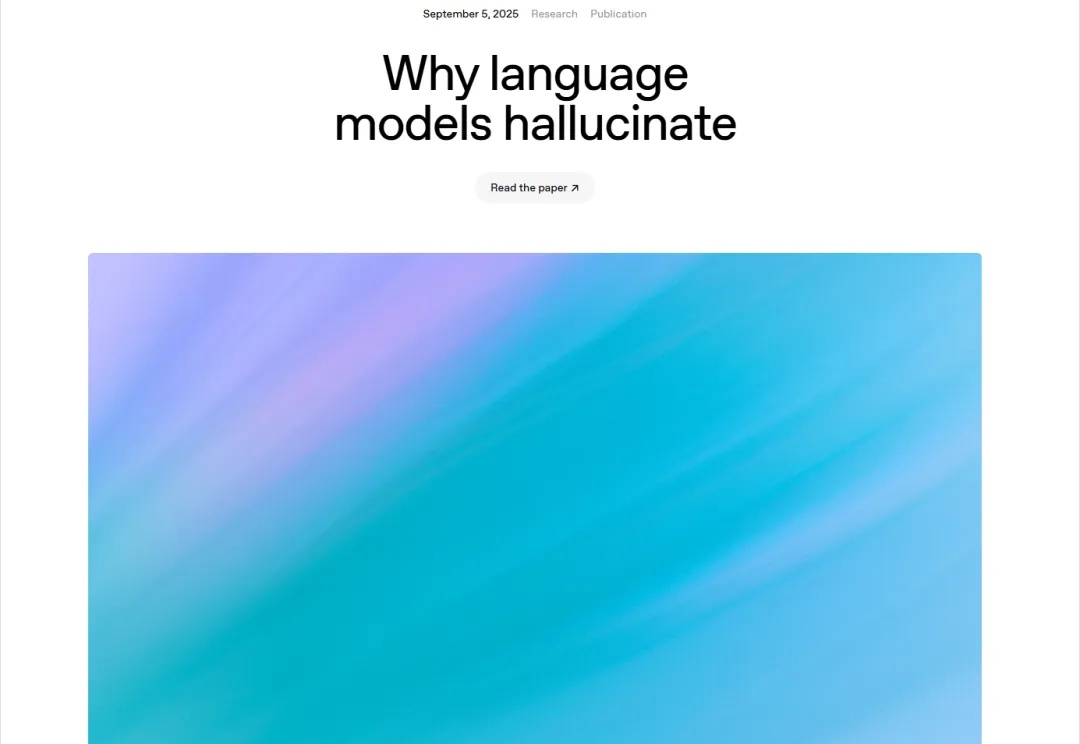

好家伙,我直呼好家伙。 号称「赛博白月光」的 GPT-4o,在它的知识体系里,对日本女优「波多野结衣」的熟悉程度,竟然比中文日常问候语「您好」还要高出 2.6 倍。

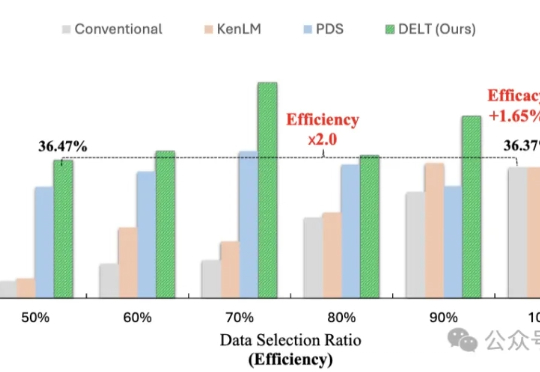

模型训练重点在于数据的数量与质量?其实还有一个关键因素—— 数据的出场顺序。

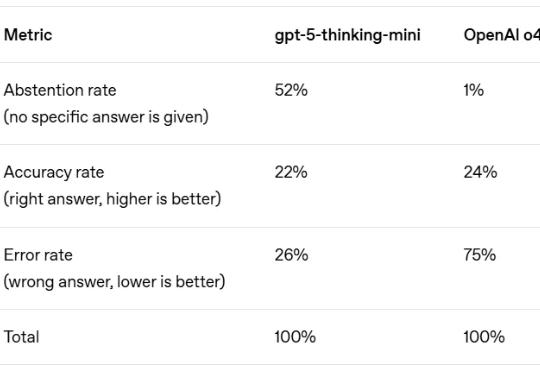

AI 最臭名昭著的 Bug 是什么?不是代码崩溃,而是「幻觉」—— 模型自信地编造事实,让你真假难辨。这个根本性挑战,是阻碍我们完全信任 AI 的关键障碍。

《金融时报》最新消息,OpenAI 正在和博通合作,自研一颗代号 “XPU” 的 AI 推理芯片,预计会在 2026 年量产,由台积电代工。不同于英伟达 的 GPU,这款芯片不会对外销售,而是专门满足 OpenAI 内部的训练与推理需求,用来支撑即将上线的 GPT-5 等更庞大的模型。

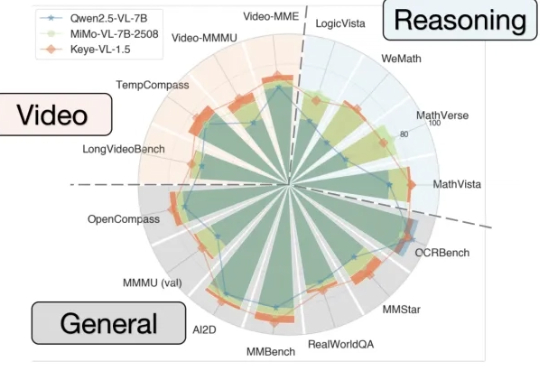

能看懂视频并进行跨模态推理的大模型Keye-VL 1.5,快手开源了。

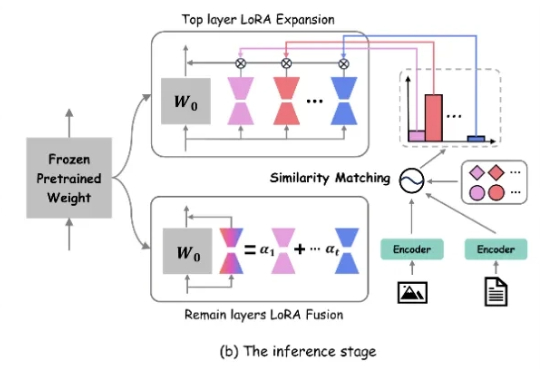

近年来,生成式 AI 和多模态大模型在各领域取得了令人瞩目的进展。然而,在现实世界应用中,动态环境下的数据分布和任务需求不断变化,大模型如何在此背景下实现持续学习成为了重要挑战