PUMA:商汤科技迈向多模态任务统一框架的多粒度视觉生成模型

PUMA:商汤科技迈向多模态任务统一框架的多粒度视觉生成模型PUMA(emPowering Unified MLLM with Multi-grAnular visual generation)是一项创新的多模态大型语言模型(MLLM),由商汤科技联合来自香港中文大学、港大和清华大学的研究人员共同开发。它通过统一的框架处理和生成多粒度的视觉表示,巧妙地平衡了视觉生成任务中的多样性与可控性。

PUMA(emPowering Unified MLLM with Multi-grAnular visual generation)是一项创新的多模态大型语言模型(MLLM),由商汤科技联合来自香港中文大学、港大和清华大学的研究人员共同开发。它通过统一的框架处理和生成多粒度的视觉表示,巧妙地平衡了视觉生成任务中的多样性与可控性。

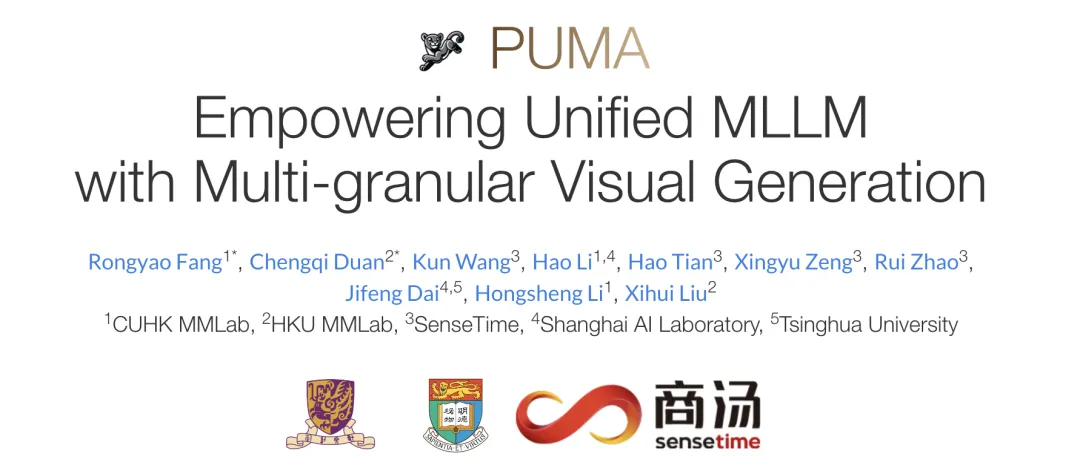

大型语言模型(LLM)的出现统一了语言生成任务,并彻底改变了人机交互。然而,在图像生成领域,能够在单一框架内处理各种任务的统一模型在很大程度上仍未得到探索。近日,智源推出了新的扩散模型架构 OmniGen,一种新的用于统一图像生成的多模态模型。

AI裁判通过反馈生成更公正报告,接近共识。

吴恩达老师提出了一种反思翻译的大语言模型 (LLM) AI 翻译工作流程

分享一篇近期由华为和阿卜杜拉国王科技大学合作完成的一项生信分析与大语言模型相结合的工作,相关成果发表在《Advanced Science》上。

10月28日,澎湃新闻记者获悉,字节跳动准备在欧洲设立AI研发中心,已开始在欧洲积极招募LLM(大语言模型)和AI领域的顶尖技术人才,以加强其在全球第二大经济体中的人工智能研发能力。

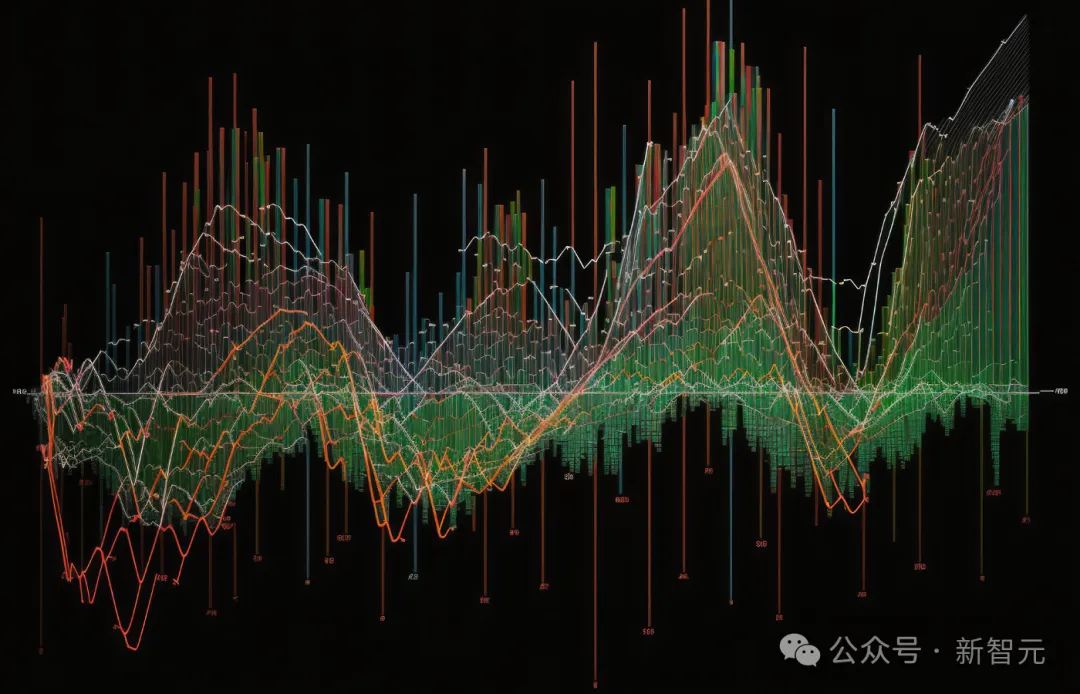

TS-Reasoner是一个创新的多步推理框架,结合了大型语言模型的上下文学习和推理能力,通过程序化多步推理、模块化设计、自定义模块生成和多领域数据集评估,有效提高了复杂时间序列任务的推理能力和准确性。实验结果表明,TS-Reasoner在金融决策、能源负载预测和因果关系挖掘等多个任务上,相较于现有方法具有显著的性能优势。

随着谷歌和 Meta 相继推出基于大语言模型的 AI 播客功能,将极大地丰富人类用户与 AI 智能体互动的体验。

AI 开发者之所以一致认为编程的重要性,是有原因的:大型语言模型编程能力越强,它回答与软件无关的其他类型问题的能力也越强。

在人工智能技术快速发展的今天,大语言模型(LLM)已经展现出惊人的能力。然而,让这些模型生成规范的结构化输出仍然是一个难以攻克的技术难题。不论是在开发自动化工具、构建特定领域的解决方案,还是在进行开发工具集成时,都迫切需要LLM能够产生格式严格、内容可靠的输出。