从豆包到 Kimi,为什么 AI 产品都在做浏览器插件

从豆包到 Kimi,为什么 AI 产品都在做浏览器插件很抱歉,但您未提供具体文章内容,无法生成相应的摘要。如果您能够提供文章的具体内容,我会很乐意帮助您整理成一个简短的摘要。

很抱歉,但您未提供具体文章内容,无法生成相应的摘要。如果您能够提供文章的具体内容,我会很乐意帮助您整理成一个简短的摘要。

卷大模型应用落地,浏览器插件已成下一个“新战场”。

当前的视觉语言模型(VLM)主要通过 QA 问答形式进行性能评测,而缺乏对模型基础理解能力的评测,例如 detail image caption 性能的可靠评测手段。

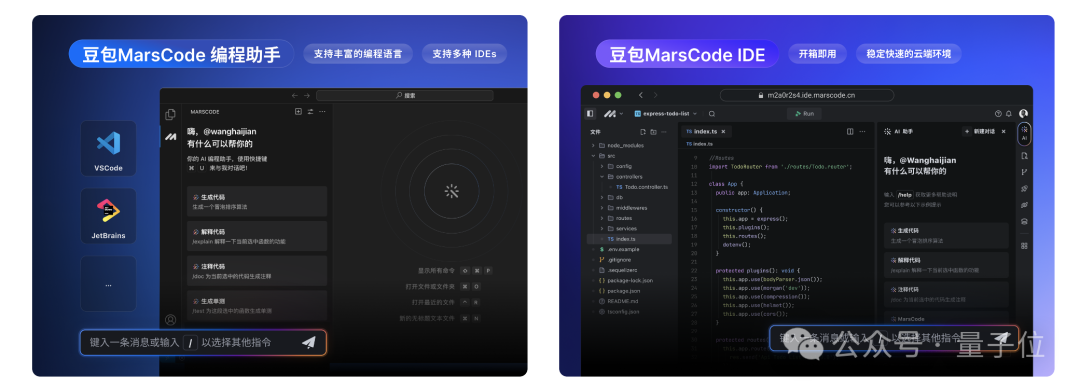

对于开发者来说,编码是一个既复杂又精细的过程。如何让这个过程变得更简单、更智能?如何进一步提升开发效率?豆包 MarsCode 近日正式发布,针对这些问题给出了新的答案。

因为 AI 为自己的工作焦虑,这件事不是一天两天了。

什么?好多大模型的文科成绩超一本线,还是最卷的河南省???

Seed-TTS 是字节跳动豆包大模型团队近期发布的语音生成大模型成果。

参加 2024 河南高考,豆包和文心 4.0 过了一本线,但比 GPT-4o 还差点。

在生成式模型的迅速发展中,Image Tokenization 扮演着一个很重要的角色,例如Diffusion依赖的VAE或者是Transformer依赖的VQGAN。这些Tokenizers会将图像编码至一个更为紧凑的隐空间(latent space),使得生成高分辨率图像更有效率。

当前主流的视觉语言模型(VLM)主要基于大语言模型(LLM)进一步微调。因此需要通过各种方式将图像映射到 LLM 的嵌入空间,然后使用自回归方式根据图像 token 预测答案。