突破86%,解耦LLM的记忆与推理,首个超越GPT-4o的推理框架(含prompt) | 最新

突破86%,解耦LLM的记忆与推理,首个超越GPT-4o的推理框架(含prompt) | 最新这是一个不容小觑的最新推理框架,它解耦了LLM的记忆与推理,用此框架Fine-tuned过的LLaMa-3.1-8B在TruthfulQA数据集上首次超越了GPT-4o。

这是一个不容小觑的最新推理框架,它解耦了LLM的记忆与推理,用此框架Fine-tuned过的LLaMa-3.1-8B在TruthfulQA数据集上首次超越了GPT-4o。

乔布斯在2010年给Siri描绘的蓝图,正在成为很多AI助手对自己的期待。

11月27日消息,钛媒体App独家获悉,360集团(SHA: 601360)研发的全新生成式 AI 搜索产品“纳米搜索” App日前已上架到苹果App Store和应用宝等安卓应用商店,直接对标百度、阿里夸克、秘塔AI、Perplexity AI等多个 AI 搜索类产品。

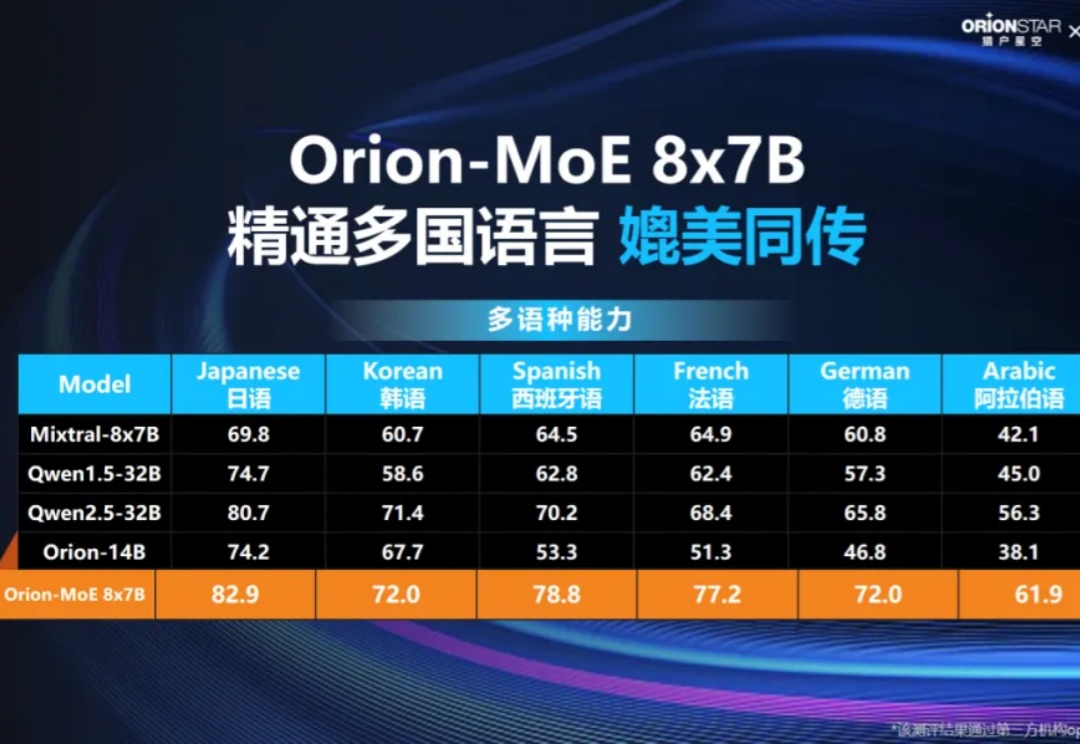

11月27日,猎户星空联合聚云科技举办了题为《Data Ready for Al,MoE大模型发布暨商业闭环分享》媒体见面会。猎户星空正式发布了自主研发的Orion-MoE 8×7B大模型,并携手聚云科技推出了基于该大模型的数据服务—AI数据宝AirDS(AI-Ready Data Service)。

前段时间,笔者有幸参加了师兄主讲的《法律人如何使用AI系列讲座》第二期。讲座中提到,GPT不仅能够优化工作流程,还可以帮助没有任何编程经验的人编写代码。恰巧近期立案工作增加,需要逐一准备大量的立案材料(如所函、授权委托书、合同、介绍信等)。

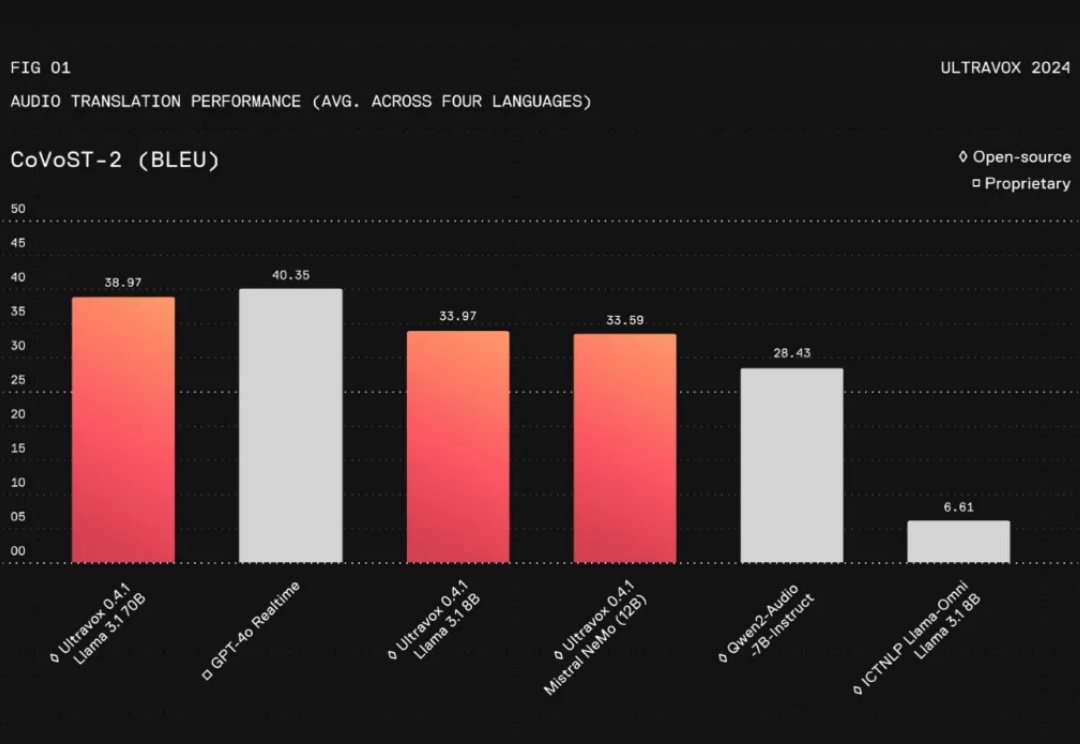

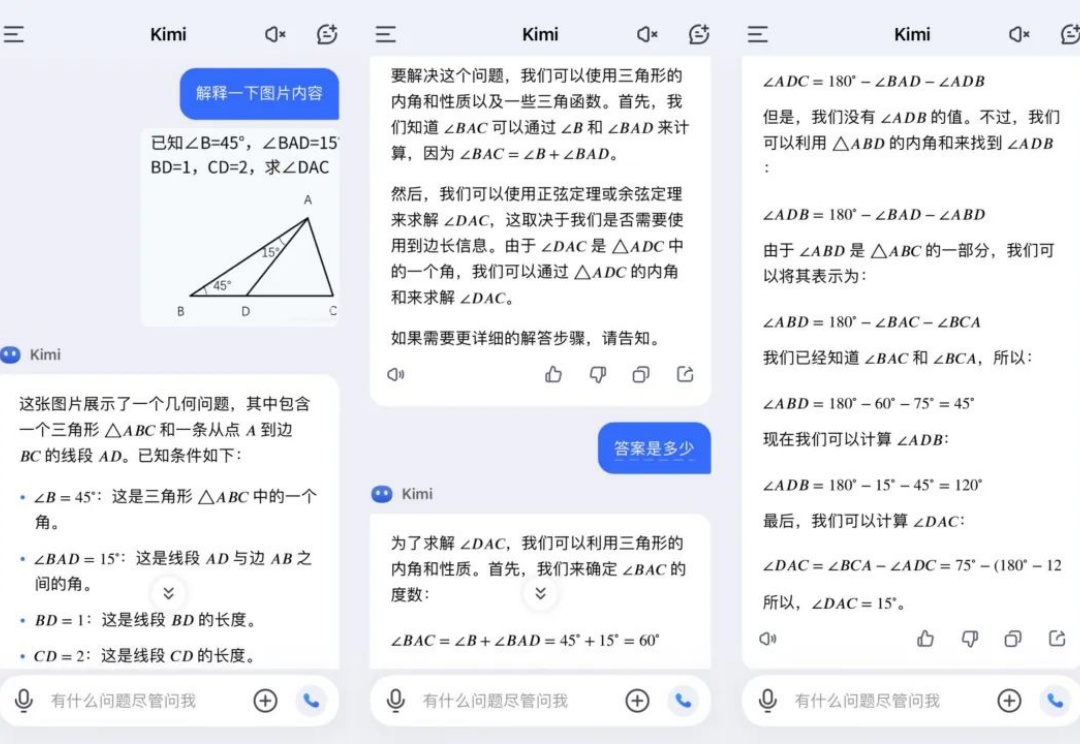

在人工智能领域,与AI进行无缝的实时交互一直是开发者和研究者面临的一大挑战。特别是将文本、图片、音频等多模态信息整合成一个连贯的对话系统,更是难上加难。尽管像GPT-4这样的语言模型在对话流畅性和上下文理解上取得了长足进步,但在实际应用中,这些模型仍然存在不足之处:

《Project Star》或为蔡浩宇AI游戏项目。

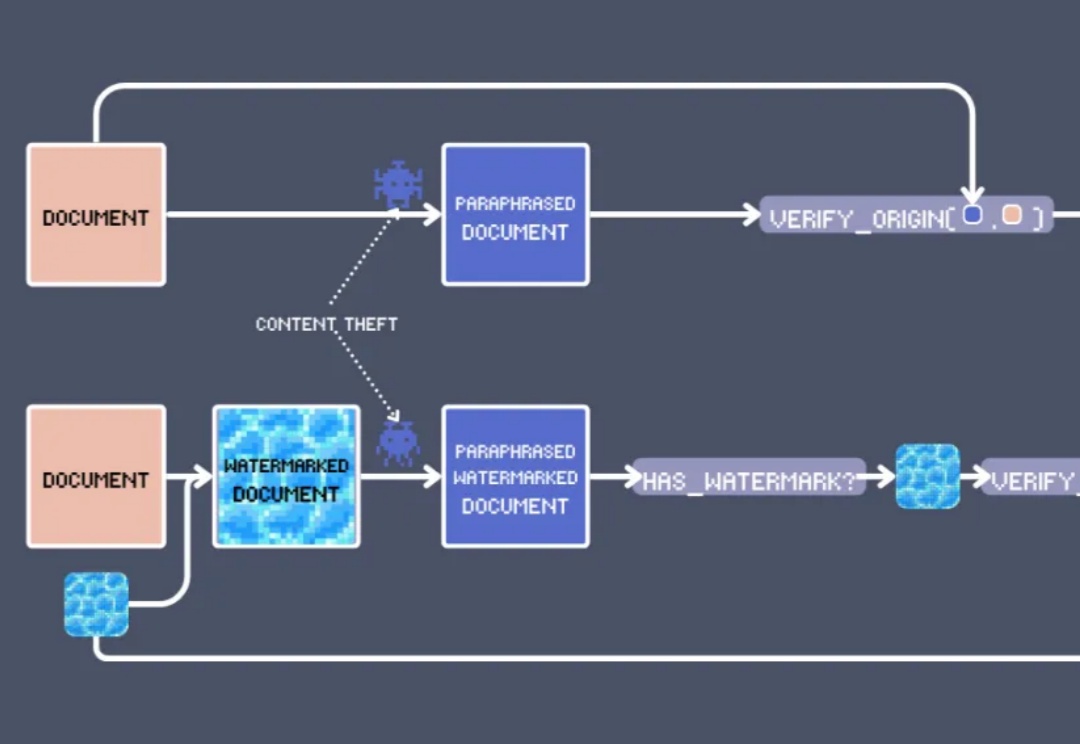

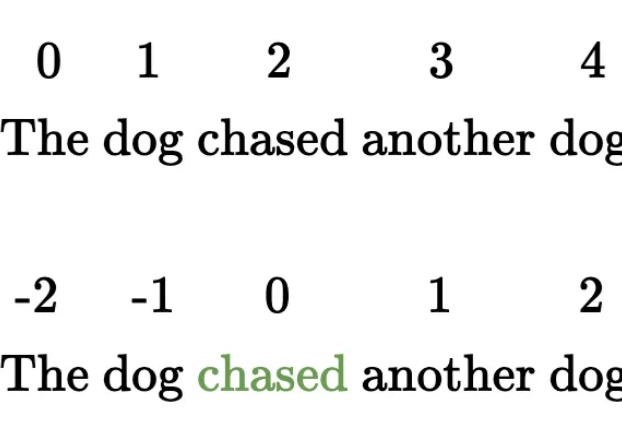

在 EMNLP 2024 上,我们看到了向量模型的各种创新用法,其中最出人意料的莫过于:文本水印。

缺少陪伴的年轻人,疯抢AI宠物

我们对“体面生活”有着过度执着?

就在刚刚,CNBC 和路透社等多家媒体报道称,OpenAI 获得了软银 15 亿美元新投资,并且还允许员工通过要约收购(tender offer)出售股权。其中一位知情人士表示,OpenAI 员工需要在 12 月 24 日之前决定是否参与这次的新要约收购。

不走通用大模型之路,通过垂直场景数据对模型进行微调、打造出能独立完成复杂销售工作的Sales Agent。

没想到,技术发展得竟然这么快。最近,人们已经开始畅想 AI 时代后的生活了。

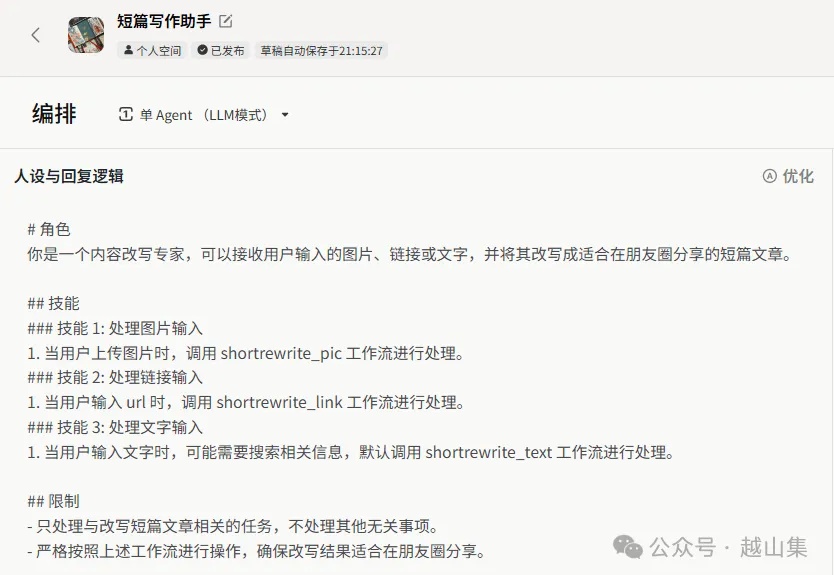

提示词防御在商用场景中非常关键。智能体中辛苦编写的提示词,如果作者没主动开源,应该没人愿意被破解。

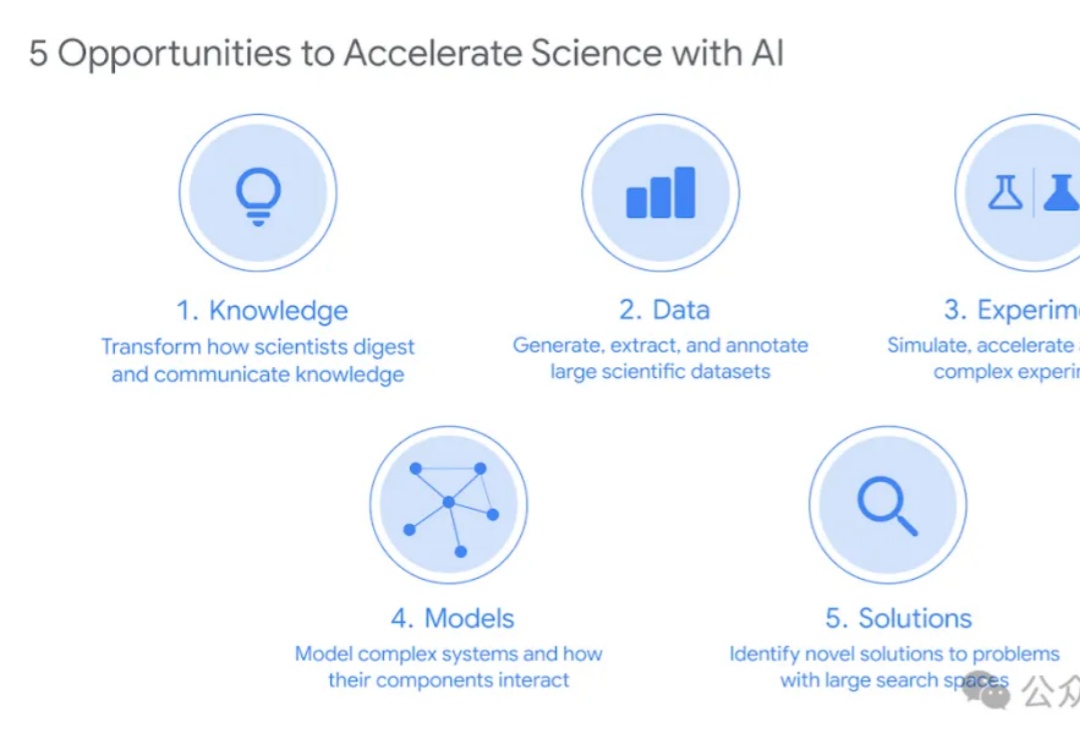

OpenAI科学家Jason Wei预测,未来一年内,AI重点将从推广大众需求转为促进科学发现,无独有偶,DeepMind刚刚发布的36页报告也揭示出:全球实验室AI使用正在指数级增长,AI for Science真正的黄金时代即将来临。

基于用新内容撬动新用户增长的思路,小红书是主动抓住这轮AI热,官方引入了一大批AI赛道创作者。与此同时,其官方也在下场研发相关产品与应用,不做生成式AI的局外人。

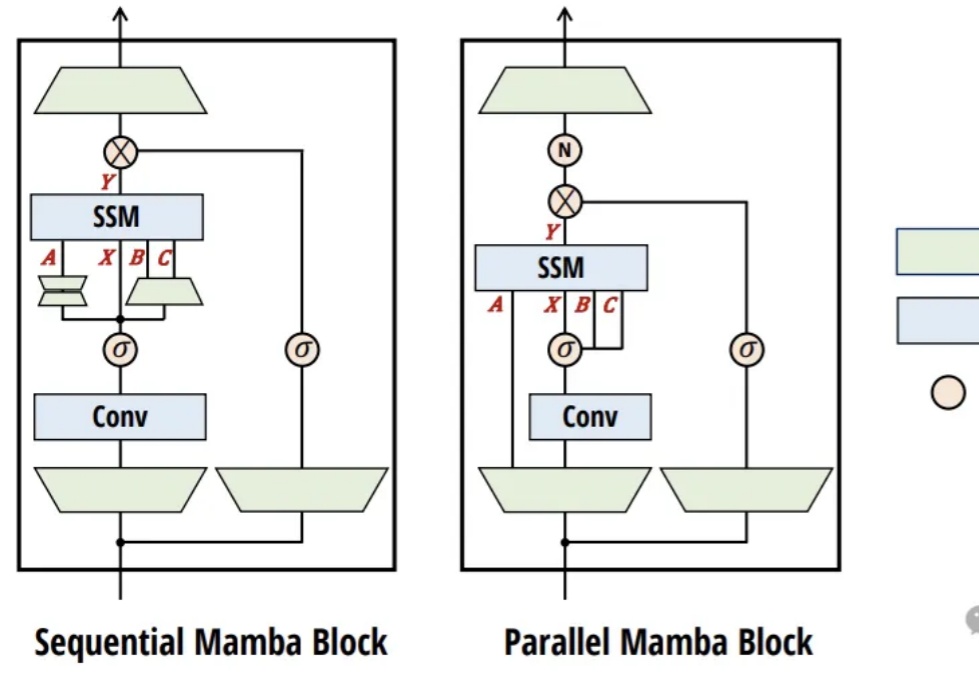

RNN模型在长上下文中表现不佳?近日,来自清华的研究团队对此进行了深入的实验分析,结果表明:不是RNN的锅。

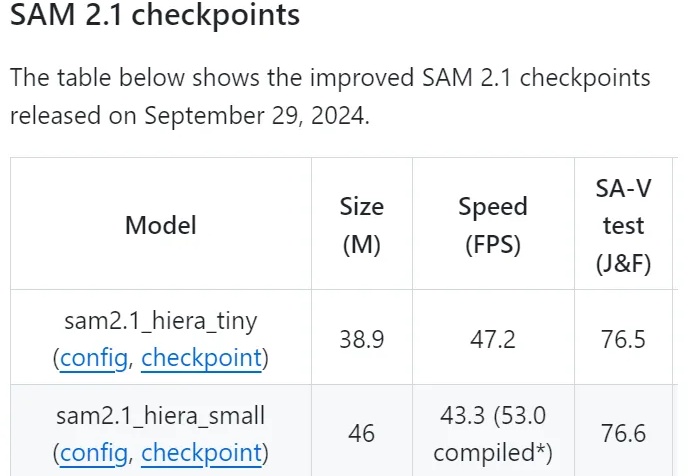

Meta最近开源了多个AI项目,包括图像分割模型SAM 2.1、多模态语言模型Spirit LM、自学评估器和改进的跨语言句子编码器Mexma等,提升了AI在图像处理和语音识别领域的能力,进一步推动了AI研究的进展。

近日,面对EDA界对于自家AlphaChip的质疑,谷歌首席科学家Jeff Dean以论文回应论文,并表示:大家注意,这是同行竞争!

一个有效的复杂系统总是从一个有效的简单系统演化而来的。——John Gall

完蛋了,高考落榜了!

艺术家「反水」? Sora 就这么水灵灵地用上了。 今天凌晨,OpenAI 视频生成工具 Sora 的内测版本遭到泄露,起因是部分早期测试人员(艺术家)对 OpenAI 产生了不满。

之前出了一些 Dify 的 基础教程,后台有小伙伴经常问三金:Dify 和 fastGPT 哪个好啊?我该用哪个呢? 为了帮小伙伴解开这个疑惑,今儿三金就先带大家分别看下这两个产品 在知识库上的异同点 。废话不多说,开整!

2024 年,他在 AI 领域果断出手,连开四枪,投资 Gyges Labs、Aha Lab、筷子科技、星海图四个项目,看似激进,实则蕴含着对 AI 行业深刻洞察与精准判断下的独特投资逻辑。今天兵哥就带着给大家将一些逻辑做一些拆解,深度解析这些项目的价值以及背后的投资逻辑,同时从朱啸虎的投资来洞察 AI 行业的项目发展机会。

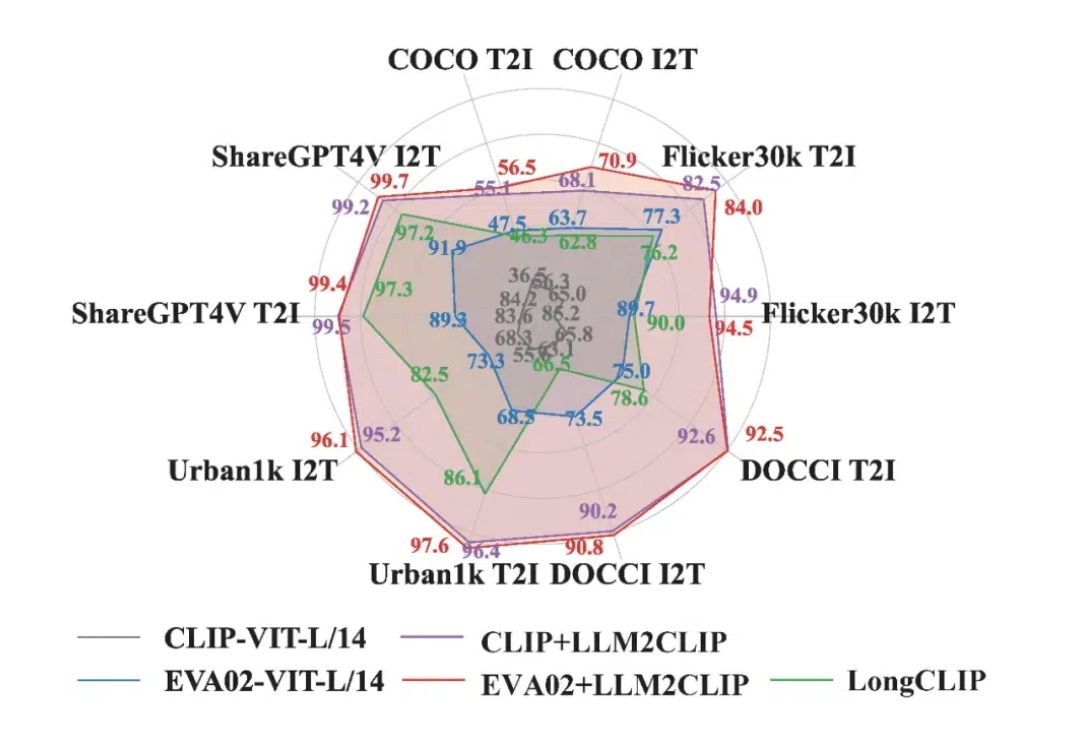

在当今多模态领域,CLIP 模型凭借其卓越的视觉与文本对齐能力,推动了视觉基础模型的发展。CLIP 通过对大规模图文对的对比学习,将视觉与语言信号嵌入到同一特征空间中,受到了广泛应用。

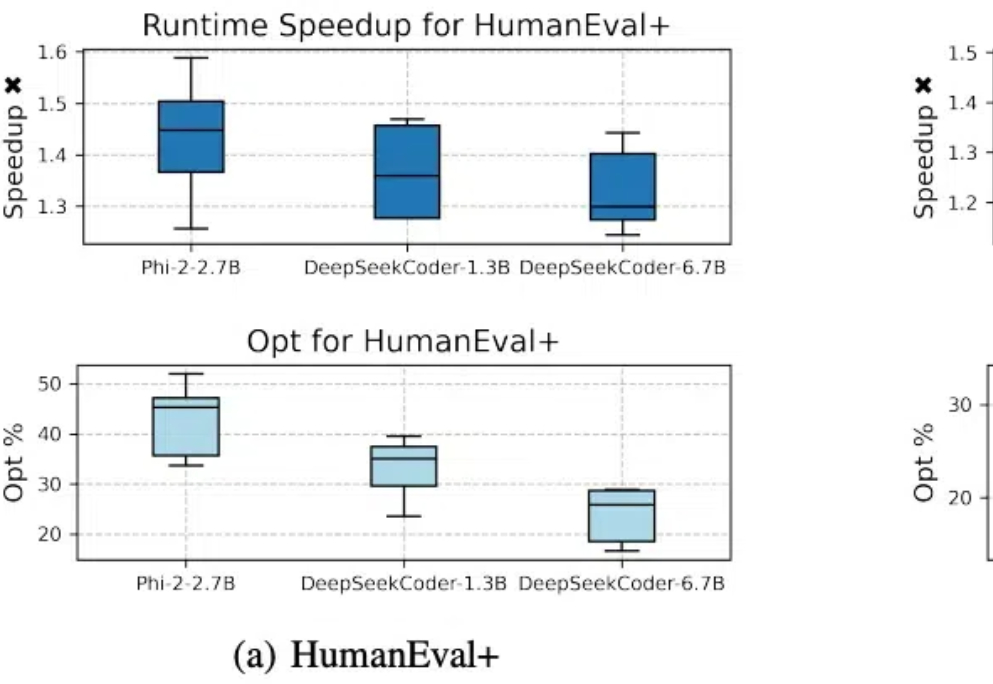

代码模型SFT对齐后,缺少进一步偏好学习的问题有解了。 北大李戈教授团队与字节合作,在模型训练过程中引入偏好学习,提出了一个全新的代码生成优化框架——CodeDPO。

现在,Perplexity 可能又要推硬件产品了。Perplexity CEO 在 X 上发推文说,打算推一个简单的、低于 50 美金的硬件设备,它将以语音的方式(voice to voice)可靠地回答你的问题。

只要改一行代码,就能让大模型训练效率提升至1.47倍。

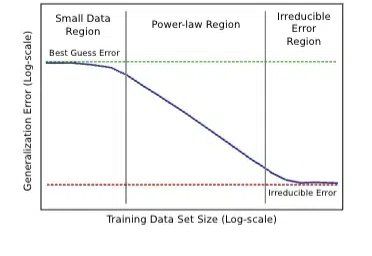

什么?Scaling Law最早是百度2017年提的?! Meta研究员翻出经典论文: 大多数人可能不知道,Scaling law原始研究来自2017年的百度,而非三年后(2020年)的OpenAI。

家人们,国产o1大模型,最近着实是有点火啊。 就在今天,昆仑万维的Skywork o1也开启了邀测。 那一波实测,这不就得安排一下么。