在人工智能领域,与AI进行无缝的实时交互一直是开发者和研究者面临的一大挑战。特别是将文本、图片、音频等多模态信息整合成一个连贯的对话系统,更是难上加难。尽管像GPT-4这样的语言模型在对话流畅性和上下文理解上取得了长足进步,但在实际应用中,这些模型仍然存在不足之处:

然而,Fixie AI 最近发布的 Ultravox v0.4.1,或许能够突破这些瓶颈,为开发者和研究者提供一种开放、高效的多模态实时交互解决方案。

Ultravox v0.4.1 是 Fixie AI 推出的新一代开源模型家族,专为实现与 AI 的实时对话而设计。它具备以下核心特性:

这款模型不仅提供了一个替代 GPT-4 的新选择,还在流畅性和多模态交互方面实现了显著提升。此外,通过开放源码,Ultravox v0.4.1 鼓励更多开发者加入社区,共同改进模型能力,推动技术普及。

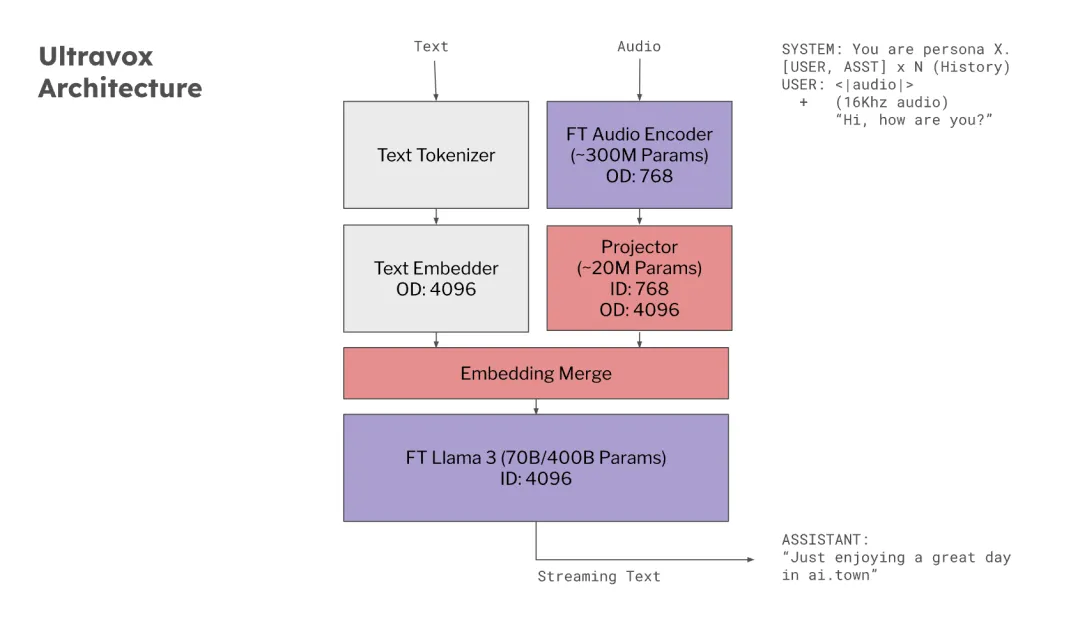

1. 高效的多模态架构

Ultravox v0.4.1 采用基于 Transformer 的架构,专注于处理多种数据类型的并行任务。通过跨模态注意力机制,模型能够同时整合和理解多种输入信息。举例来说:

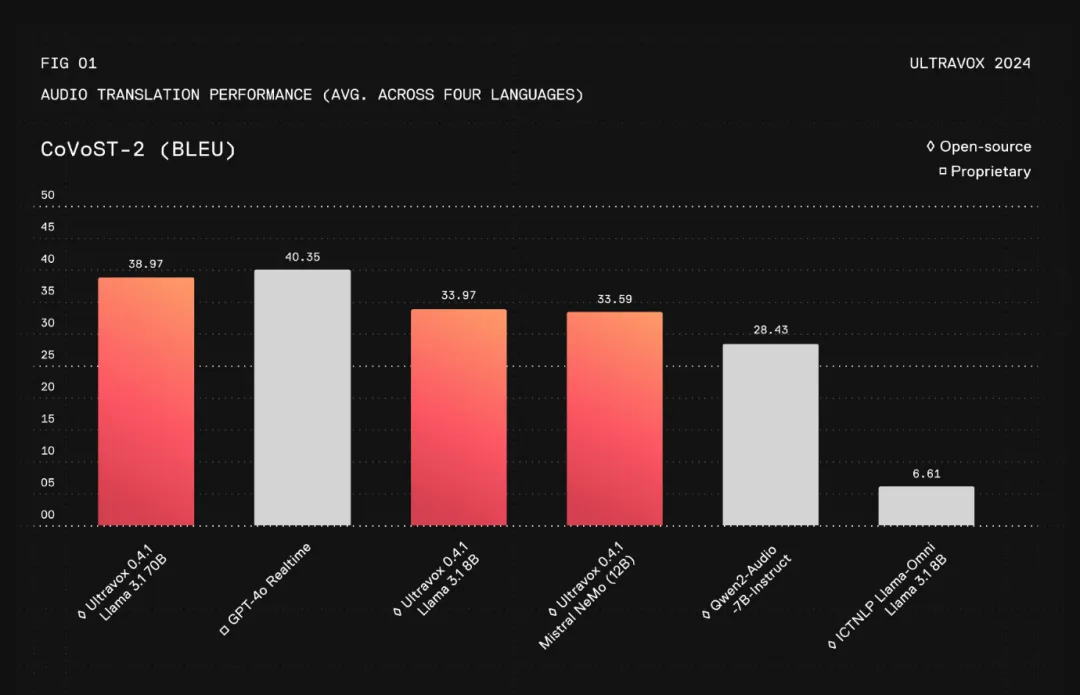

2. 出色的延迟优化

在性能上,Ultravox 比主流商业模型的响应时间快约 30%,适合用于需要实时反馈的场景,如:

3. 便捷的开发与部署

Ultravox 模型已上线 Hugging Face 平台,任何开发者都可以免费访问和使用。Fixie AI 提供了详细的 API 文档,让模型集成过程更顺畅,同时极大地降低了模型部署的技术门槛。这意味着:

Ultravox v0.4.1 的出现,不仅是技术上的突破,更为各行业带来了丰富的应用机会。以下是几个典型场景:

与许多封闭的商业模型不同,Ultravox v0.4.1 完全开源,这带来了三个重要价值:

此外,Ultravox 的低计算开销也解决了许多中小型企业和个人开发者的痛点,真正实现了“技术平权”。

Fixie AI 的 Ultravox v0.4.1,正在改变人们对实时对话 AI 的期待。凭借其强大的多模态能力、显著的响应优化以及开源的优势,Ultravox 为开发者和研究者提供了一个灵活、高效的工具箱。

未来,随着越来越多的行业引入 Ultravox,我们有理由期待更多基于实时、多模态交互的创新应用。从技术的普及到实际场景的落地,Ultravox v0.4.1 正在推动 AI 技术从实验室走向更加广阔的舞台。

如果你也想亲自体验或参与开发,不妨前往 Hugging Face 探索 Ultravox 的无限可能。

文章来自于“Halo咯咯”,作者“基咯咯”。