成立两年ARR千万美金,Benchmark投资的AI数字员工真的能替代人吗?

成立两年ARR千万美金,Benchmark投资的AI数字员工真的能替代人吗?11x.ai 开发的人工智能“数字员工”如 Alice 和 Jordan,能够自动化处理销售开发、客户服务等重复性任务,帮助企业提升效率,降低成本,释放人力专注于更具战略价值的工作。客户可以根据完成的任务量或实际取得的销售成果进行付费,提供更定制化的服务。

11x.ai 开发的人工智能“数字员工”如 Alice 和 Jordan,能够自动化处理销售开发、客户服务等重复性任务,帮助企业提升效率,降低成本,释放人力专注于更具战略价值的工作。客户可以根据完成的任务量或实际取得的销售成果进行付费,提供更定制化的服务。

1%的合成数据,就让LLM完全崩溃了? 7月,登上Nature封面一篇论文证实,用合成数据训练模型就相当于「近亲繁殖」,9次迭代后就会让模型原地崩溃。

善智者,动于九天之上。

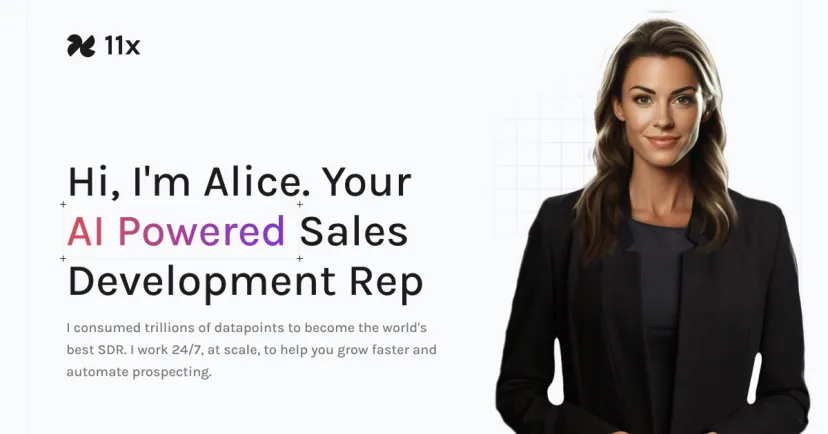

多模态大语言模型(MLLM)如今已是大势所趋。 过去的一年中,闭源阵营的GPT-4o、GPT-4V、Gemini-1.5和Claude-3.5等模型引领了时代。

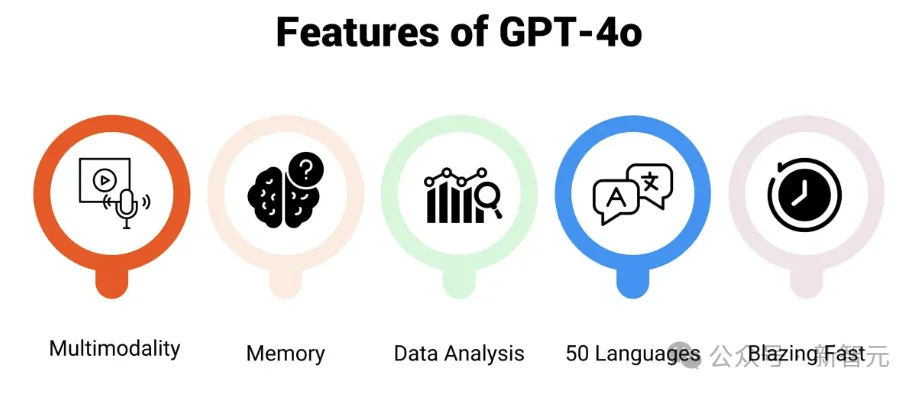

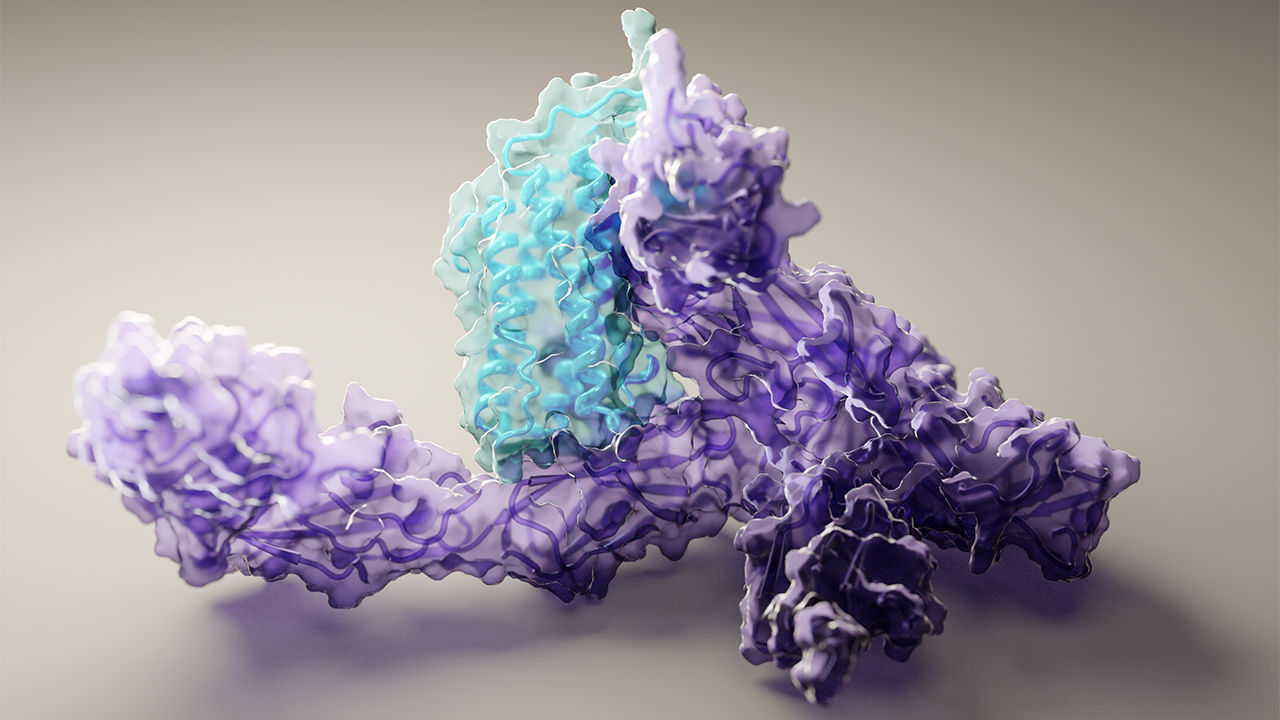

2024年的诺贝尔化学奖一半授予大卫·贝克(David Baker),“以表彰在计算蛋白质设计方面的贡献”;另一半则共同授予德米斯·哈萨比斯(Demis Hassabis)和约翰·M·詹珀(John M. Jumper),“以表彰他们在蛋白质结构预测方面的成就”。

OpenAI好不容易开源了一次,却被曝出剽窃? 就在昨天,OpenAI应用AI研究员Shyamal Anadkat ,放出了全新多智能体框架——Swarm,瞬间在全网爆火。

器官芯片结合AI技术推动药物开发进步。

三个月前我在硅谷沉浸式泡了两个多月把产品上的整体感受和几个趋势简短写在了这里,在和不同的创业者交流研究了 40 多个产品后,最终回归到了“语音”这个方向,写下“Voice is a big thing”,语音产品是我认为 AI 在 C 端领域的核心变革点。

教育大模型是真刚需。

在中国移动全球合作伙伴大会“移动爱家”展台中,用一部手机,链接AI科技、AI健康、AI学习等六个家庭场景,人们关于智慧家居的理想画面在这里被实现了。

虽然还没有 super-app 的出现,但今天的 AI,已经在很多方面开始重塑人类创作的过程,影响内容创作者与消费者之间的关系,甚至开始和人类谈恋爱了。

计算资源并非性能提升的唯一途径:Arvind Narayanan 认为,仅仅增加计算资源并不总是能带来模型性能的等比提升。目前,数据量正逐渐成为限制AI发展的主要瓶颈。

5 大证据显示,LLM 在推理复杂问题时非常脆弱。

中国AI制药企业产业迎来机遇。AI,成了2024年诺贝尔奖的最大赢家。 先是人工智能学者拿下诺贝尔物理学奖,评委会表彰他们“利用物理学工具,开发出了当今强大机器学习技术的基础方法”。

借助AI工具,研究人员有更多方法来快速筛选总结研究文献,他们又是如何正确/谨慎使用这些AI工具的?

微软、高通、苹果前高管加入, 人形机器人已实地测试。

GPT使用量在大幅上升。

对创意、创新和创造的自由探索

AI浪潮已至,威胁更要警惕

多多农研科技大赛上的一个个集装箱,或许就提供了未来农业的解题思路。

杨立昆认为人工智能还有很长的路要走。

中国厂商如何在AI浪潮中破局? 近日,在2024年诺贝尔三大科学奖项中,两大奖项与人工智能研究相关,先是物理学奖颁给了曾获图灵奖的机器学习先驱,紧接着化学奖也将一半颁给了“程序员”。

当下获得AI能力实在太过容易,可打击AI造假却有力未逮。 最近一段时间打开抖音、快手、视频号等短视频平台,总是能刷到“雷军”用他标志性的口音“锐评”网络上的热门话题。以至于在雷军的微博评论区,有用户发出了“雷总,最近你怎么在骂人”这样的灵魂拷问。

一个创立了自动驾驶公司,一个创立了股票交易平台,这两家公司的创始人凑在一起又会干出什么事儿来呢? 答案是数学超级智能(MSI)。

AI陪伴赛道持续火热...... 在当前的泛娱乐领域,头部应用如TT语音和Soul已经成功地将AI技术融入其平台,推出了诸如AI分身、AI宠物以及AI伴侣等创新玩法。

大厂在内容生态上的深耕,成为Kimi们难以企及的优势。 国内互联网行业许久不见的烧钱大战,终于在AI大模型应用的厮杀中复现。

多位投资行业人士向《智能涌现》表示,国内某大模型行业领军人物,近日加入了国内一家AI巨头,进行AI眼镜等硬件业务的探索——为此,这位大牛还放弃了自己原本的创业计划。

2023年,纽约大学法学院举办了一场主题为 “法律将会如何处理生成式AI ” 的论坛。

屏幕前的你可曾想过,如果将充满创新活力的AR技术融入到学习中,会激发出什么样的新奇体验呢?

在红杉资本在最新发布的文章《Generative AI's Act O1 :The Agentic Reasoning Era Begins》中,讨论了当下生成式AI正在从以训练时计算的快思考,向以推理时计算的慢思考发展。OpenAI 的新模型 o1便是重要的标志。慢思考的到来也将会带来新的机会,行业认知的重要性被高度重视起来,过去对于AI应用以及背后的商业理解也将被刷新。