「帷幄」获 6000 万美元融资以全球扩展其企业级 AI 产品套件

「帷幄」获 6000 万美元融资以全球扩展其企业级 AI 产品套件全球总部位于新加坡的企业级人工智能公司「帷幄」宣布连续完成 C1 轮和 C2 轮融资,总计募集超 6000 万美元。

全球总部位于新加坡的企业级人工智能公司「帷幄」宣布连续完成 C1 轮和 C2 轮融资,总计募集超 6000 万美元。

今天橘子的新产品可以一分钟将任何内容变成播客的 ListenHub发布了,照例想用提示词为他做一张长图。

Sixfold平台以生成式AI直击保险行业审核效率、风险评估、成本控制、客户个性化定制四大痛点,面向保险公司、管理总代理和再保险公司提供B2B风险分析解决方案,覆盖人寿、残疾、财产与意外伤害等多险种,致力于提升承保人处理日常工作的效率,解决保险承保过程中准确性不足的问题,并增强保险公司、保险经纪人以及再保险公司的工作透明度。

有多久没喝雪碧了,记不清了。

AI检测漏洞催生荒诞产业链

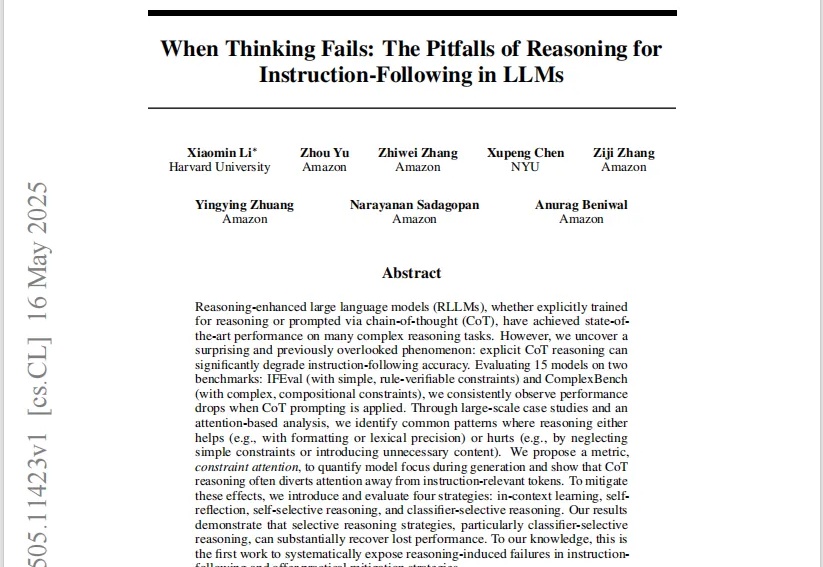

各位有没有发现,最近大家对大模型已经有些看麻了?反正我是看到相关话题的文章流量、社交平台上的热度,对模型的关注度明显有点降下来了。 比如最近 Qwen3、Gemini2.5、GPT-4.1 和 Grok-3 等这么密集的有明显新进展的优秀模型发布,要是放到 2 年前,铁定是个炸裂的一个月。

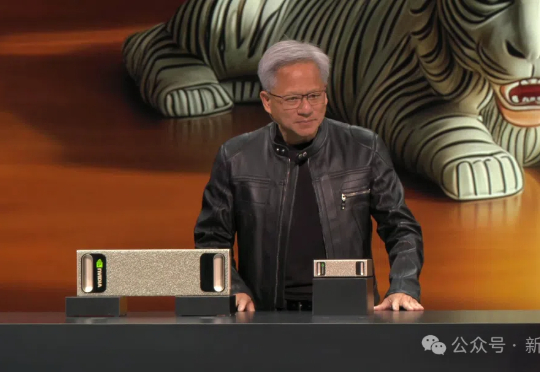

英伟达CEO黄仁勋,在Computex 2025演讲中官宣:中国台湾,将建起首台世界级的巨型AI超算,以及全新的英伟达办公室!此外,最强AI芯片GB300、个人超算DGX Station、NVLink Fusion等,也都是此次推出的最新亮点。

大家好,我是袋鼠帝前几天收到一个客朋友的咨询:“有没有什么爬虫软件推荐?”

非专业用户也能"用嘴编程"。

在最新的媒体采访中,GitHub CEO托马斯·多姆克正面battle最近甚嚣尘上的“编程无用论”。 在他的构想中,2025年是属于编程智能体的一年,但未来仍然属于全体人类程序员。

仅需5000美元就能实现人形机器人3D打印?UC伯克利这次又又又整新活了!注意看,画面中这个正在认真写名字的小家伙,就是来自UC伯克利的最新作品——人形机器人Berkeley Humanoid Lite (BHL)。

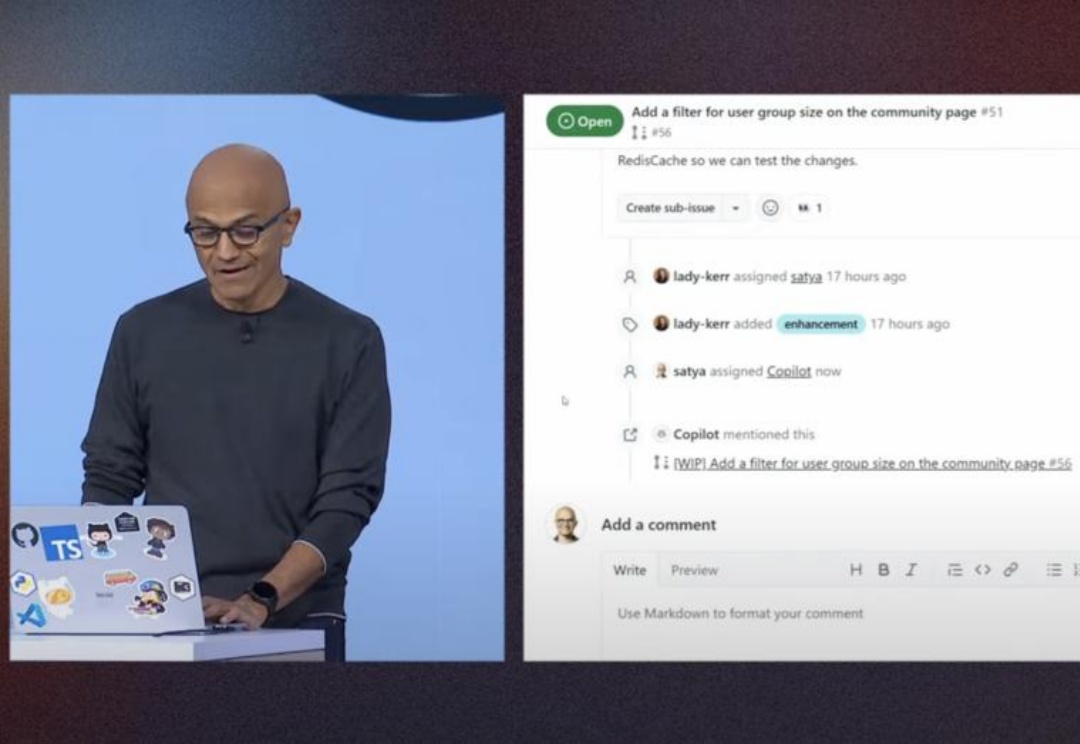

就在昨天,纳德拉带着50多个新产品和服务,震撼亮相微软Build大会。他喊出宣言:我们已进入AI智能体时代!现场连线的大佬奥特曼、黄仁勋和马斯克,让气氛推向顶峰。现在,Agent已全面渗透,编程、科研都将彻底颠覆。

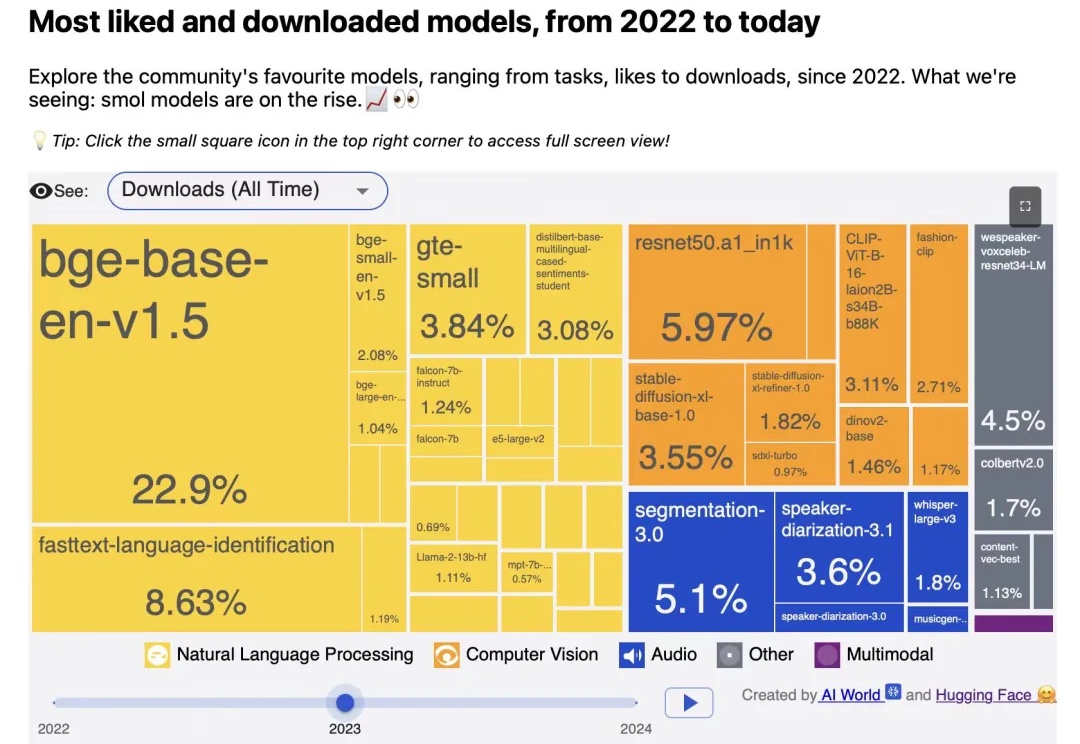

检索增强技术在代码及多模态场景中的发挥着重要作用,而向量模型是检索增强体系中的重要组成部分。

硬氪获悉,近日,武汉派呦科技有限公司(以下简称「派呦科技」)完成奇绩创坛数百万元人民币天使轮融资。本轮融资资金将主要用于硬件量产交付、技术研发及开拓全球营销渠道。

国产空间计算机已实现量产,618期间正式开售!

在基本物理任务上,前沿AI模型仍会失败!ML研究院的测试案例显示白领将被Ai替代,而制造业等蓝领工作不受影响。未来已来,只是分布得不均匀。

要问最近哪个模型最火,混合专家模型(MoE,Mixture of Experts)绝对是榜上提名的那一个。

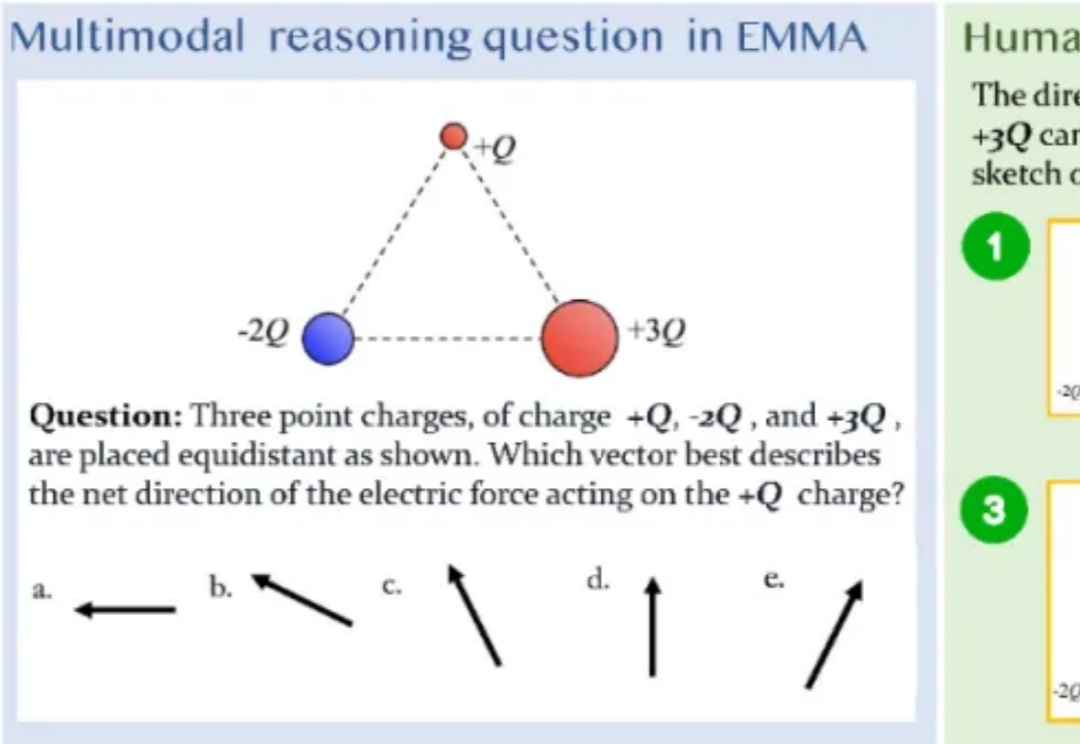

「三个点电荷 + Q、-2Q 和 + 3Q 等距放置,哪个向量最能描述作用在 + Q 电荷上的净电力方向?」

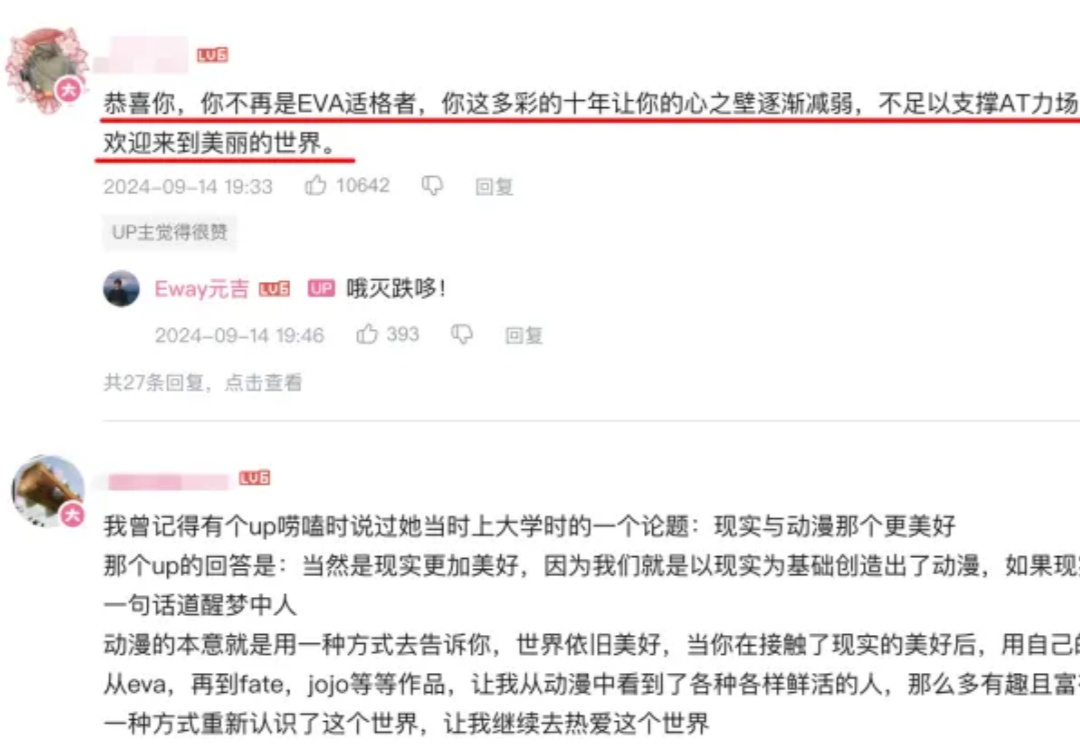

至今没有中文版

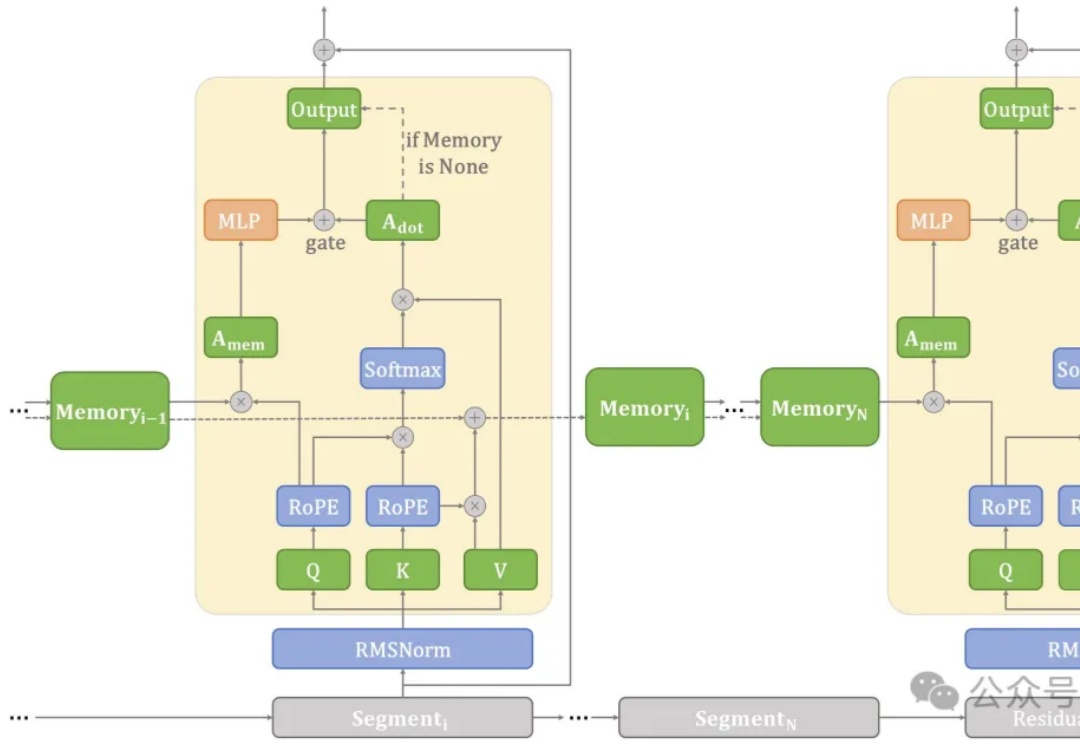

在端侧设备上处理长文本常常面临计算和内存瓶颈。

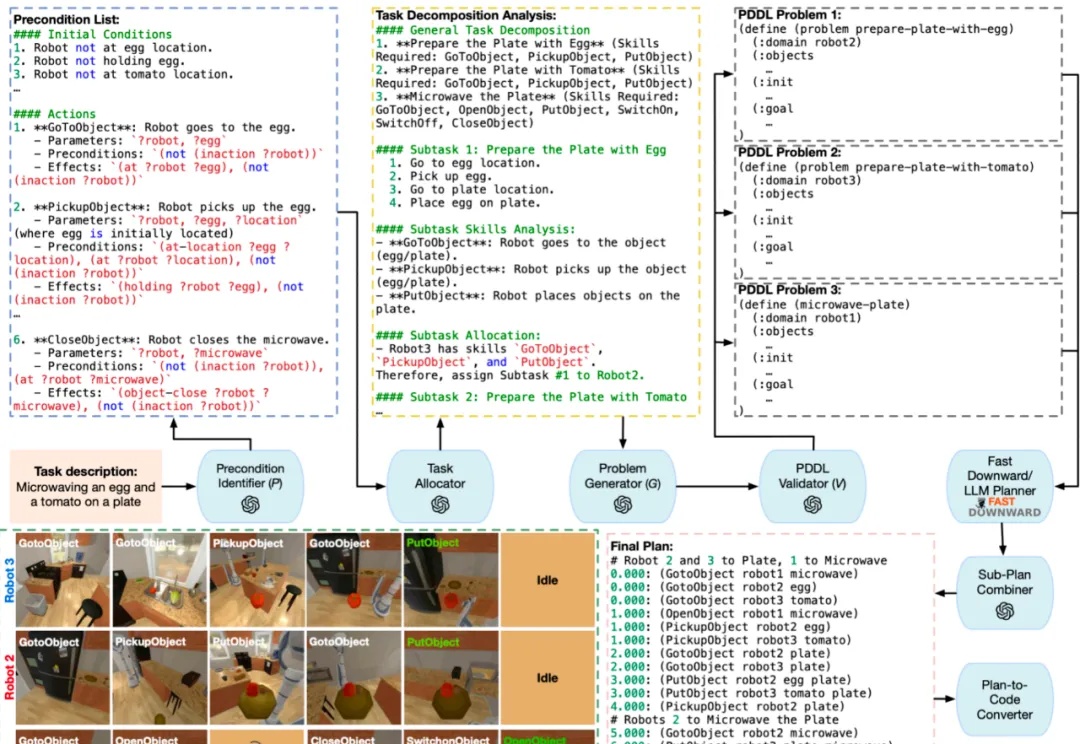

2025 年 5 月,美国加州大学河滨分校 (UC Riverside) 与宾夕法尼亚州立大学 (Penn State University) 联合团队在机器人领域顶级会议 ICRA 2025 上发布最新研究成果 LaMMA-P。

就在刚刚,智源研究员联合多所高校开放三款向量模型,以大优势登顶多项测试基准。其中,BGE-Code-v1直接击穿代码检索天花板,百万行级代码库再也不用怕了!

微软Build 2025全面转向AI Agent,整合OpenAI及xAI模型

太震撼了,有开发者代码实证后发现,谷歌AlphaEvolve的矩阵乘法突破,被证明为真!Claude辅助下,他成功证明,它果然仅用了48次乘法,就正确完成了4×4矩阵的乘法运算。接下来,可以坐等AlphaEvolve更「奇点」的发现了。

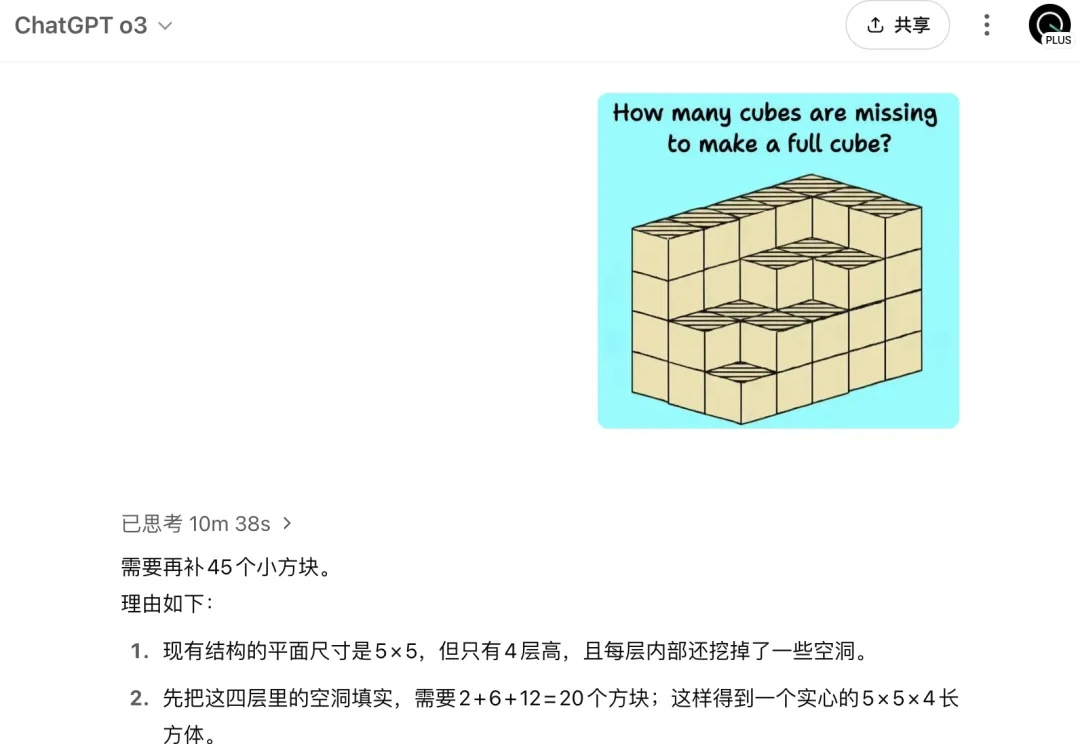

拷打AI的难度还在升级?这不,图像推理又出现了新难题。

在今年,DeepSeek R1火了之后。

如果说AI技术在影视行业的价值,一度被视为“创作辅助”与“降本提效”,那么刚刚收官的仙侠剧《落花时节又逢君》,或许提供了另一种想象路径,困扰行业已久的“积压剧”是否有了重获新生的解决方案?

闺蜜机掀起家庭AI新战场,大厂全都来了

周末和一位在字节做视频 Agent 的 PM 聊天,想到了一个好问题。

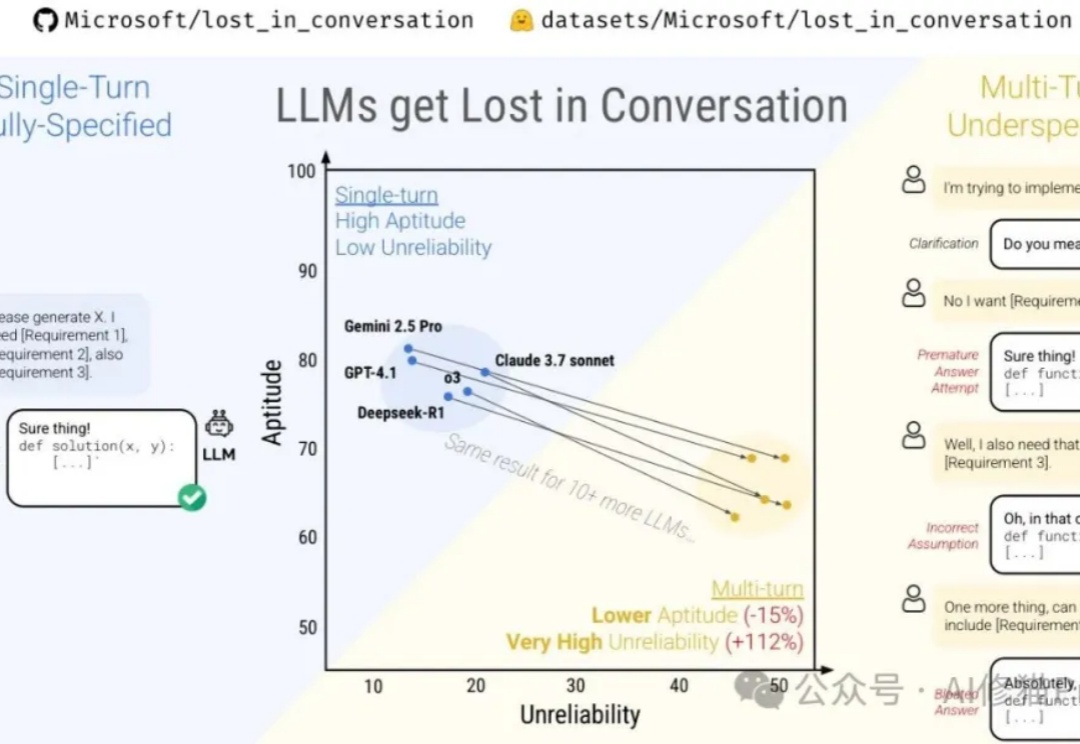

微软最近与Salesforce Research联合发布了一篇名为《Lost in Conversation》的研究,说当前最先进的LLM在多轮对话中表现会大幅下降,平均降幅高达39%。这一现象被称为对话中的"迷失"。文章分析了各大模型(包括Claude 3.7-Sonnet、Deepseek-R1等)在多轮对话中的表现差异,还解析了模型"迷失"的根本原因及有效缓解策略。