7B小模型+3.8万条训练数据,就能让音频理解和推断评测基准MMAU榜单王座易主?

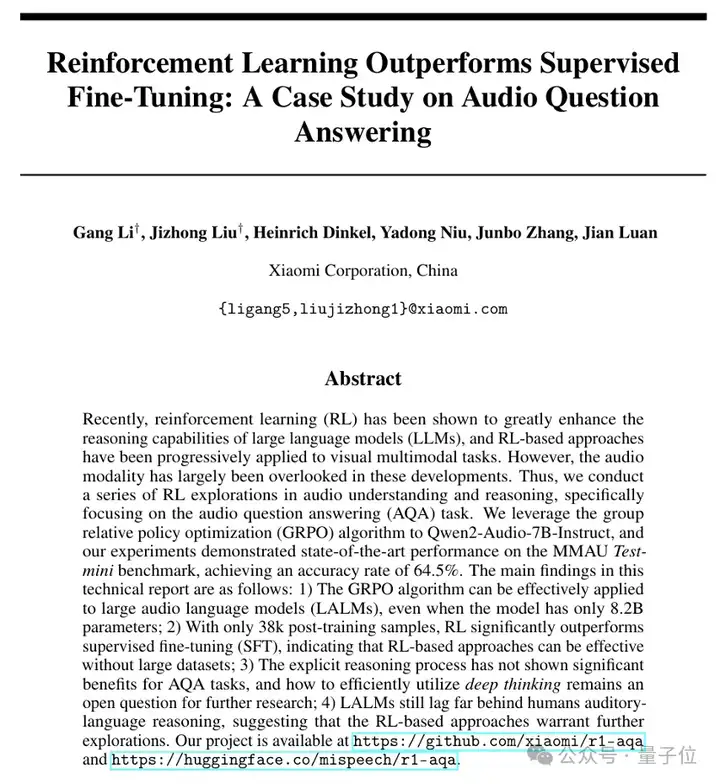

受到DeepSeek-R1中强化学习算法的启发,小米大模型团队对阿里的Qwen2-Audio-7B模型进行了微调。

结果模型在MMAU上的准确率从49.2%提升到了64.5%(涨幅31%),比以前霸榜的GPT-4o还高出近10个百分点。

MMAU是一个由一万条涵盖语音、环境声和音乐的音频样本构成的评测基准,难度非常高,人类专家的成绩为82.2%。

来自阿里的Qwen2-Audio-7B模型在此评测集上的准确率为49.2%,经小米大模型团队用清华大学发布的AVQA数据集,使用SFT微调后提升到了51.8%。

这样的提升并不明显,而当小米团队选择改用DeepSeek-R1的GRPO算法时,发现获得了巨大的性能提升,一举达到了MMAU的新SOTA。

目前,小米大模型团队已经把训练代码、模型参数开源,并提供了技术报告、在线Demo。

如前所述,小米大模型团队通过SFT,使用清华AVQA数据集对选择了来自阿里的Qwen2-Audio-7B进行了微调,成绩提升了2.6个百分点。

直到DeepSeek-R1的发布,为小米在该项任务上的研究带来了启发。

DeepSeek-R1的Group Relative Policy Optimization(GRPO)方法,让模型仅通过”试错-奖励”机制就能使自主进化,涌现出类似人类的反思、多步验证等推理能力。

在同一时间,卡内基梅隆大学发布的预印本论文(arxiv:2503.01067),通过精巧的实验得出了一个有趣的论断:

当任务存在明显的生成-验证差距(Generation-Verification Gap),即任务生成结果的难度远大于验证结果正确性的难度时,强化学习比起有监督微调具有独特优势。

而AQA任务,恰好是完美的生成-验证差距显著的任务。

离线微调方法,如SFT,有点像背题库,你只能根据已有的题目和答案训练,但遇到新题可能不会做;

而强化学习方法,如GRPO,像老师在要求你多想几个答案,然后老师告诉你哪一个答案好,让你主动思考,激发出自身的能力,而不是被“填鸭式”教学。

当然,如果训练量足够,比如有学生愿意花很多年的时间来死记硬背题库,也许最终也能达到不错的效果,但效率太低,浪费太多时间。

而主动思考,更容易快速地达到举一反三的效果。强化学习的实时反馈可能会帮助模型更快锁定高质量答案的分布区域,而离线方法需要遍历整个可能性空间,效率要低得多。

基于上述洞察,小米尝试将DeepSeek-R1的GRPO算法迁移到Qwen2-Audio-7B模型上。

令人惊喜的是,在仅使用AVQA的3.8万条训练样本的情况下,强化学习微调后的模型在MMAU评测集上实现了64.5%的准确率,这一成绩比目前榜单上第一名的商业闭源模型GPT-4o有近10个百分点的优势。

有趣的是,如果在训练中强制要求模型输出包含thinking标签的推理过程时,准确率反而下降至61.1%。这说明显式的思维链结果输出可能并不利于模型的训练。

小米大模型团队的实验揭示了几个和传统认知不同的结论:

尽管当前准确率已突破64%,但距离人类专家82%的水平仍有差距。

小米大模型团队表示,在当前的实验中,强化学习策略还是比较粗糙,训练过程对思维链的引导并不充分,我们会在后续做进一步探索。

此次实验验证了强化学习在音频理解和判断领域的独特价值,也为后续研究打开了一扇新的大门。

小米团队期待,当机器不仅能“听见”声音,还能“听懂”声音背后的因果逻辑时,真正的智能听觉时代将会来临。

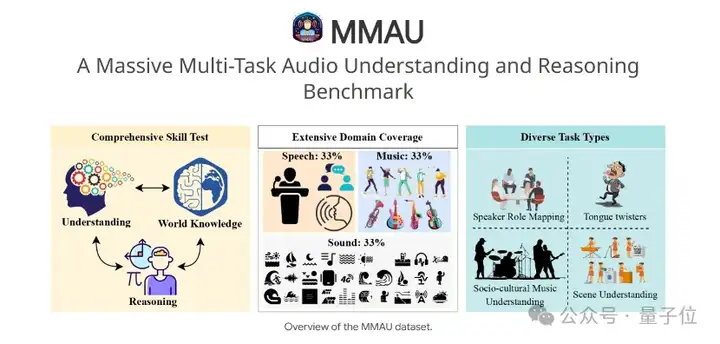

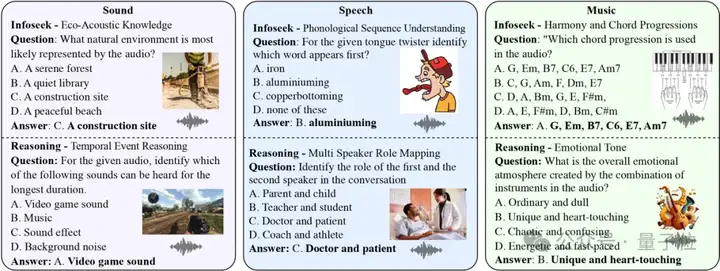

MMAU(Massive Multi-Task Audio Understanding and Reasoning)评测集由美国马里兰大学和Adobe的研究人员于去年联合提出,是音频理解和推断能力的量化标尺。

它通过一万条涵盖语音、环境声和音乐的音频样本,结合人类专家标注的问答对,测试模型在27种技能,如跨场景推理、专业知识等应用上的表现,期望模型达到接近人类专家的逻辑分析水平。

在大模型时代,人们已经不满足于机器仅仅识别说话的内容、声音的种类,更期望机器具备复杂的理解和判断能力,MMAU衡量的就是这种能力。

这是一个很难的评测集,作为基准上限,人类专家在MMAU上的准确率为82.23%。

目前MMAU官网榜单上表现最好的模型是GPT-4o,准确率为57.3%。紧随其后的是谷歌的Gemini 2.0 Flash,准确率为55.6%。

训练代码:

https://github.com/xiaomi-research/r1-aqa

模型参数:

https://huggingface.co/mispeech/r1-aqa

技术报告:

https://arxiv.org/abs/2503.11197

交互Demo:

http://120.48.108.147:7860/

文章来自于“量子位”,作者“允中”。

【免费】ffa.chat是一个完全免费的GPT-4o镜像站点,无需魔法付费,即可无限制使用GPT-4o等多个海外模型产品。

在线使用:https://ffa.chat/

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner