「仅需一次前向推理,即可预测相机参数、深度图、点云与 3D 轨迹 ——VGGT 如何重新定义 3D 视觉?」

3D 视觉领域正迎来新的巨变。

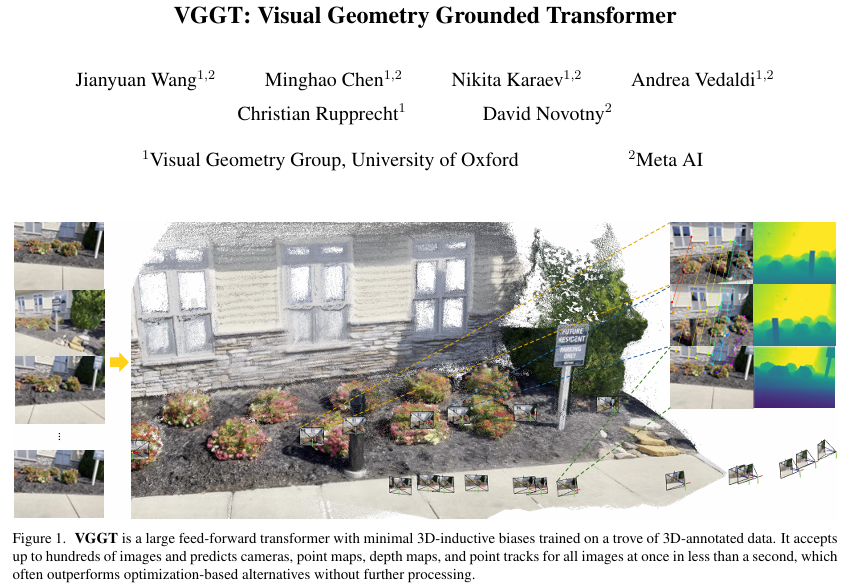

牛津大学 VGG (Visual Geometry Group) 与 Meta AI 团队联合发布的最新研究 VGGT(Visual Geometry Grounded Transformer),

提出了一种基于纯前馈 Transformer 架构的通用 3D 视觉模型,

能够从单张、多张甚至上百张图像中直接推理出相机内参、外参、深度图、点云及 3D 点轨迹等核心几何信息。

无需任何后处理优化,该模型已经在多个 3D 任务中性能显著超越传统优化方法与现有 SOTA 模型,推理速度可达秒级。

这一研究打破了过去 3D 任务依赖繁琐几何迭代优化的传统范式,展示了 “越简单,越有效” 的强大潜力。

传统 3D 重建技术高度依赖束调整(Bundle Adjustment, BA)等几何优化方法,需反复迭代且计算成本高昂。

尽管近年来机器学习被引入辅助优化,但仍难以摆脱复杂后处理的桎梏。

VGGT 开创性地采用纯前馈设计:通过大规模 3D 标注数据与 Transformer 架构的结合,模型在一次前向传播中即可完成全部几何推理任务。

实验表明,即便输入数百张图像,VGGT 仍能在数秒内输出高质量结果,在精度与速度上均超越传统优化方法。

研究团队指出,VGGT 的成功并非源于复杂的结构设计或领域先验,而是得益于 Transformer 架构的通用性与大规模 3D 数据训练的协同效应。

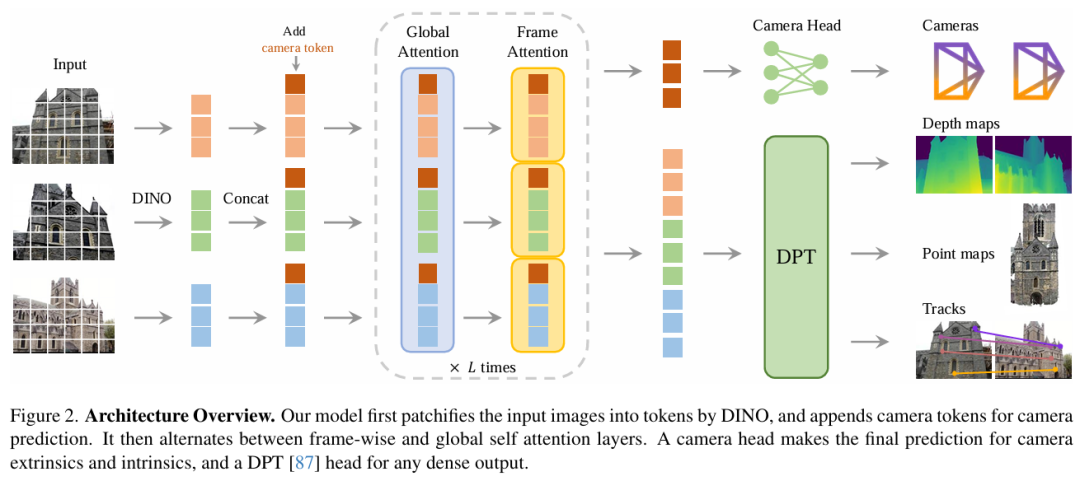

模型将输入图像转化为 Tokens 后,与随机初始化的相机 Tokens 共同输入交替注意力模块(Alternating-Attention),

通过全局与帧级自注意力层的交替堆叠,逐步融合多视图几何信息。

最终,相机参数经专用头部解码,图像 Tokens 则通过 DPT 头部生成密集预测(如深度图与点图)。

值得一提的是,VGGT 仅使用自注意力机制(self attention),未使用跨注意力(cross attention)。

同时,为保持输入图像的置换不变性(改变输入图像顺序不改变预测结果),VGGT 摒弃了帧索引 (frame index) 位置编码。

相反,VGGT 仅通过帧级自注意力机制动态关联同一图像的 Tokens。

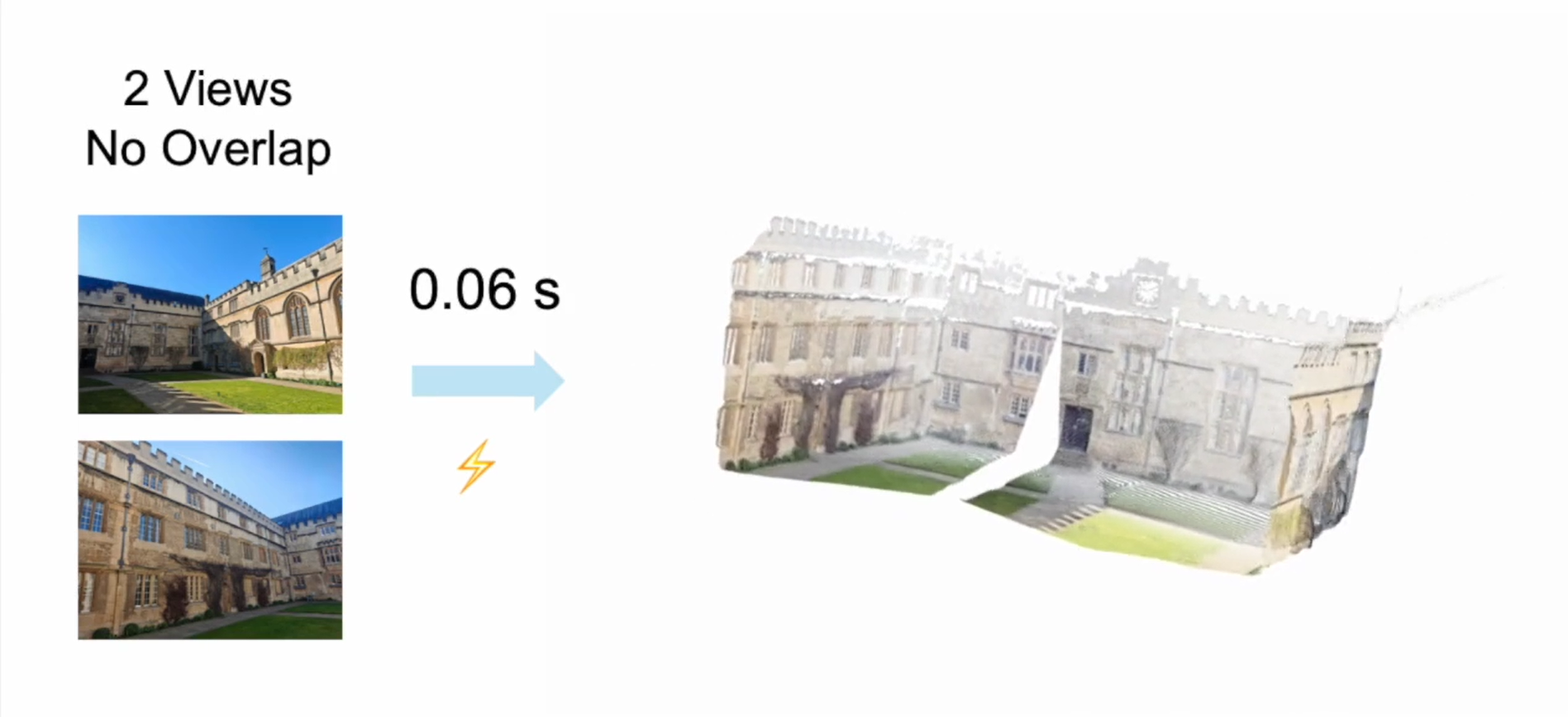

这种设计不仅使得模型无需依赖预设位置信息即可区分多视图数据,更赋予模型强大的泛化能力 —— 即便训练时仅使用 2-24 帧数据,

测试时亦可轻松处理超过 200 帧的输入。VGGT 收集了 17 个大型 3D 数据集一起进行训练,在 64 块 A100GPU 上共耗时 9 天。

性能与泛化性双突破

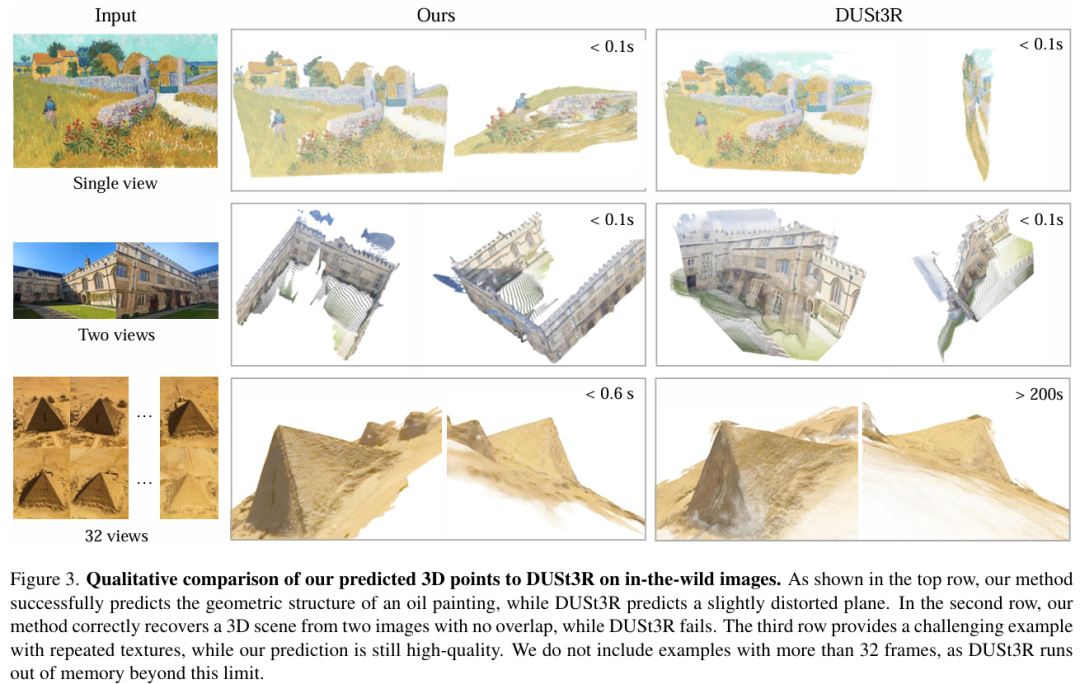

定性演示视频显示,VGGT 能轻松应对不同数量图像及复杂场景的重建。同时,研究人员提供了与过去 SOTA 的定性比较。

VGGT 可精准重建梵高油画等非真实场景的几何结构,甚至能处理无重叠视图或重复纹理的极端案例。

用户可通过 Hugging Face Demo 上传图像,实时体验 3D 重建效果。

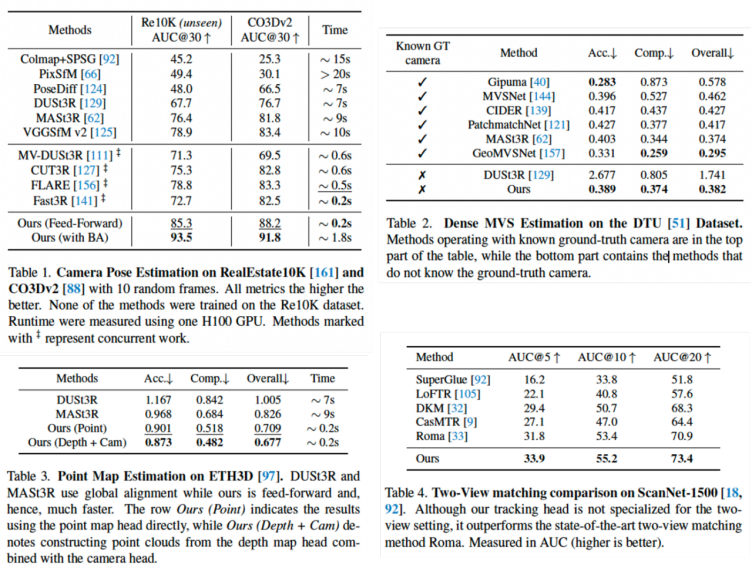

在定量实验中,VGGT 无需任何后处理即在相机姿势估计,多视图深度估计、点云重建等任务中全面领先,其推理速度较传统方法提升近 50 倍。

即便与同期 CVPR 2025 的 Transformer-based 重建模型相比,VGGT 性能优势明显,并与速度最快的 Fast3R 相当。

有趣的是,研究团队还意外发现,利用模型预测的深度图与相机参数反投影生成的点云,

其质量甚至超过直接回归的点图,这一现象揭示了模型对几何一致性内在规律的自发学习能力。

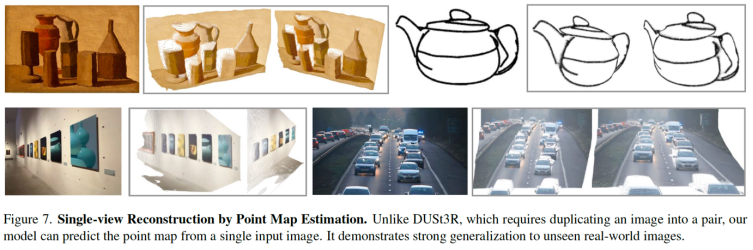

跨任务泛化的潜力 - 单目重建

尽管 VGGT 从未接受单图训练,但仍展现出强大的跨任务泛化能力。研究团队公布的单图重建定性结果显示,VGGT 在未专门训练的单目任务中表现出色。

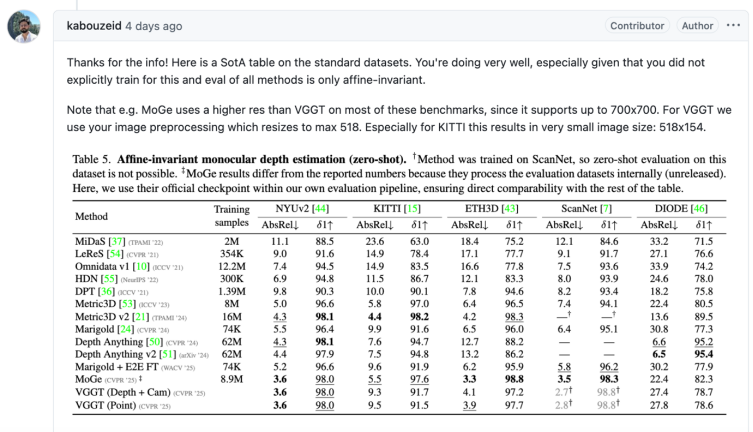

VGGT 的代码和模型公开后,迅速有 github 社区成员跟进,在标准的单目设置下进行测试。

GitHub 社区测试显示,VGGT 在 NYU V2 等数据集上的表现已逼近单目 SOTA 水平,这一「意外之喜」进一步印证了 VGGT 作为通用 3D 基础模型的潜力。

结语

视觉重建作为所有 3D 任务的核心,VGGT 的成功标志着 3D 视觉领域或许即将迎来一个全新的,基础模型的时代。

正如论文作者所述,我们正在见证视觉几何从 「手工设计」到「数据驱动」的范式迁移,而这可能仅仅是个开端。

「简单架构 + 数据驱动」的模式是否能如 2D 视觉和 NLP 领域般彻底重塑 3D 任务?让我们拭目以待。

作者介绍:论文第一作者王建元为牛津大学视觉几何组(VGG)与Meta AI的联合培养博士生(博士三年级),长期致力于3D重建方法研究。

其博士工作聚焦于端到端几何推理框架的创新,曾主导开发PoseDiffusion、VGGSfM,以及本次提出的通用3D基础模型VGGT,

相关成果均发表于CVPR、ICCV等顶级会议,推动了数据驱动式3D重建技术的演进。

文章来自于微信公众号 “机器之心”,作者 :王建元