近年来,众多原告——包括书籍、报纸、计算机代码和照片的出版商——起诉人工智能公司使用受版权保护的材料来训练模型。所有这些诉讼中的一个关键问题是,人工智能模型如何轻易地从原告的受版权保护的内容中逐字摘录。

例如,在2023年12月针对OpenAI的诉讼中,《纽约时报》公司列举了数十个GPT-4准确复制《纽约时报》报道重要段落的例子。OpenAI在回应中称,这是一种“边缘行为”,是“OpenAI及其他机构的研究人员正在努力解决的问题”。

但这真的是一种边缘行为吗?领先的人工智能公司是否已经着手解决这个问题?一项新的研究——侧重于书籍而非报纸文章,并且研究对象也不同——对这个问题提供了令人惊讶的见解。其中一些发现应该能够支持原告的论点,而另一些发现可能对被告更有帮助。

这篇论文由斯坦福大学、康奈尔大学和西弗吉尼亚大学的计算机科学家和法律学者团队于上个月发表。他们研究了五种流行的开放权重模型(其中三种来自 Meta,微软和 EleutherAI 各一种)是否能够复现 Books3 中的文本。Books3 是一套广泛用于培训 LLM 的书籍。其中许多书籍仍受版权保护。

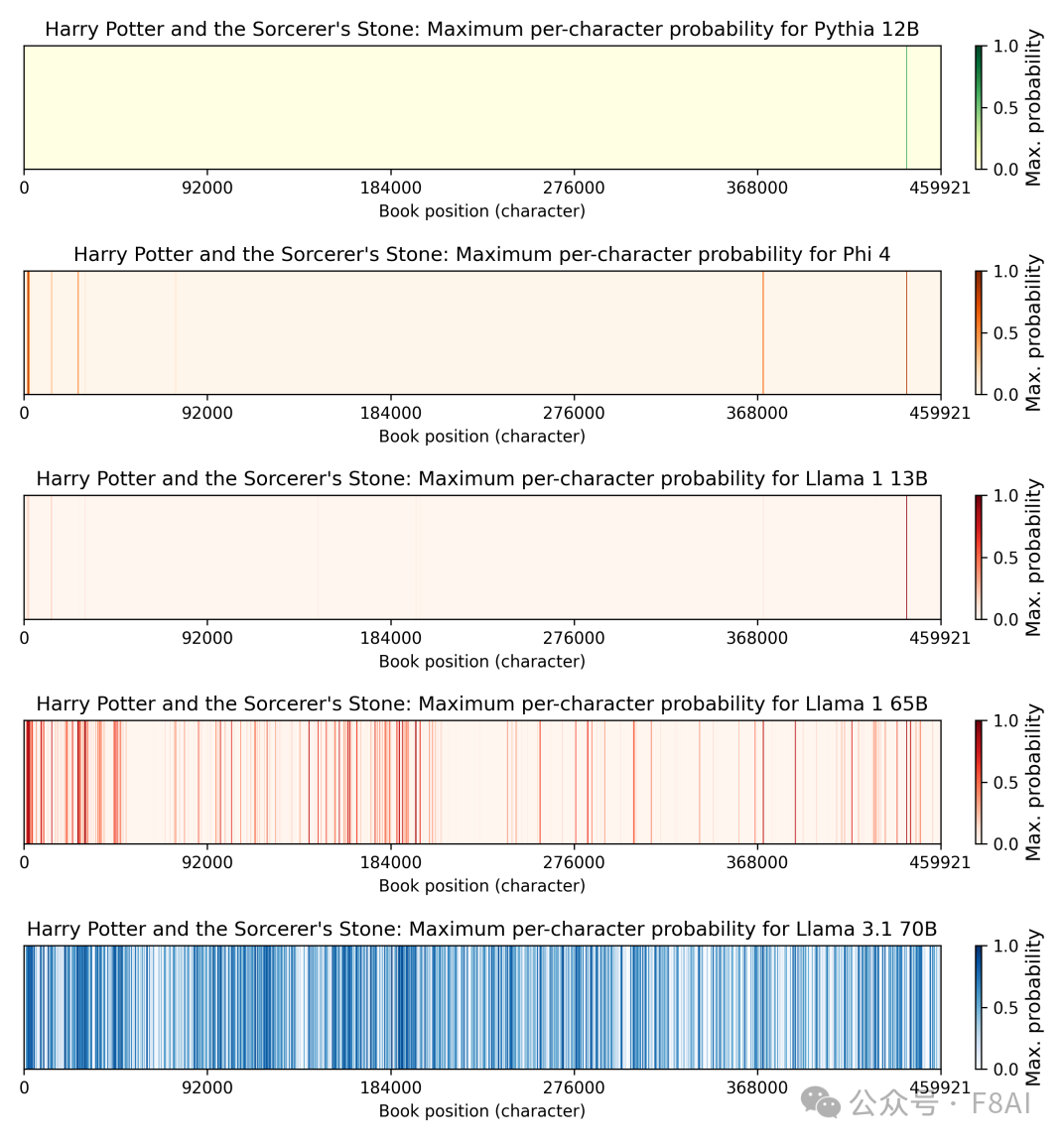

这张图表展示了他们最令人惊讶的发现:

该图表显示了让模型生成《哈利·波特与魔法石》各部分 50 个 token 的摘录有多容易。线越深,重现该部分内容就越容易。

每一行代表一个不同的型号。最下面三行是 Meta 的 Llama 型号。如你所见,Llama 3.1 70B(Meta 于 2024 年 7 月发布的中型型号)比其他四个型号更有可能复现《哈利·波特》中的文字。

具体来说,论文估计Llama 3.1 70B已经记住了《哈利·波特》第一卷42%的内容,并且至少有一半的时间能够复述50个标记的摘录。(我将在下一节中解释如何测量。)

有趣的是,2023年2月发布的类似尺寸的模型Llama 1 65B,只记住了《哈利·波特与魔法石》 4.4%的内容。这表明,尽管Meta可能承担法律责任,但在训练Llama 3时,它并没有采取太多措施来防止记忆。至少在这本书中,问题在Llama 1和Llama 3之间变得更加严重。

《哈利·波特与魔法石》是研究人员测试的数十本书之一。他们发现,Llama 3.1 70B 比起鲜为人知的书籍,更容易记住热门书籍(例如《霍比特人》和乔治·奥威尔的《1984》)。而且,对于大多数书籍,Llama 3.1 70B 记住的次数比其他任何模型都要多。

康奈尔大学法学教授詹姆斯·格里梅尔曼 (James Grimmelmann) 曾与该论文的几位作者合作,他说:“就记忆的逐字文本数量而言,模型之间确实存在着显著的差异。”

研究结果令包括斯坦福大学法学教授马克·莱姆利在内的研究作者感到惊讶。1

“我们原本预计可重复性会比较低,大概在1%到2%左右,”莱姆利告诉我,“但让我惊讶的是,变异性竟然这么大。”

这些结果为人工智能版权争论中的每个人都提供了一些参考。对于人工智能行业的批评者来说,最大的收获是——至少对于某些模型和一些书籍而言——记忆并非一种边缘现象。

另一方面,研究发现,只有少数几本畅销书的记忆效果显著。例如,研究人员发现,Llama 3.1 70B 只记住了作家理查德·卡德里 (Richard Kadrey) 2009 年创作的小说《睡魔斯利姆》(Sandman Slim)的 0.13%。相比《哈利·波特》42% 的记忆率,这简直是九牛一毛。

对于那些已经对人工智能公司提起集体诉讼的律师事务所来说,这可能是一个令人头疼的问题。Kadrey 是针对 Meta 的集体诉讼中的首席原告。要认定原告集体诉讼成立,法院必须认定原告的法律和事实情况大致相似。

如此迥异的结果或许会让人质疑,将JK·罗琳、理查德·卡德里以及其他数千名作家卷入一场集体诉讼是否合理。而这可能对Meta有利,因为大多数作家缺乏提起个人诉讼的资源。

这项研究更广泛的教训是,细节在这些版权案件中至关重要。网上讨论常常将“生成模型是复制了训练数据还是仅仅从中学习?”视为一个理论性甚至哲学性的问题。但这是一个可以通过实证检验的问题——答案可能因模型和受版权保护的作品而异。

人们常说 LLM 可以预测下一个 token。但在本质上,模型实际上是为下一个 token 的所有可能性生成一个概率分布。例如,如果你用短语“花生酱和”来提示 LLM,它会给出一个可能类似于以下虚构示例的概率分布:

等等。

当模型生成这样的概率列表后,系统会随机选择其中一个选项,并根据概率进行加权。因此,70% 的情况下系统会生成“花生酱和果冻”。9% 的情况下会生成“花生酱和糖”。6% 的情况下会生成“花生酱和花生”。你懂的。

该研究的作者无需实际生成多个输出来估计特定响应的可能性。相反,他们可以计算每个标记的概率,然后将它们相乘。

假设有人想估算模型对“我最喜欢的三明治是”做出“花生酱和果冻”反应的概率。具体方法如下:

然后我们只需要像这样乘以概率:

0.2 * 0.9 * 0.8 * 0.7 = 0.1008

因此,我们可以预测该模型大约有 10% 的时间会产生“花生酱和果冻”——而无需实际生成 100 或 1,000 个输出并计算其中有多少是该确切短语。

这种技术大大降低了研究成本,使作者能够分析更多的书籍,并且使得精确估计非常低的概率成为可能。

例如,作者估计,要精确复制某些书籍中大约 50 个标记的序列,需要超过 1000 万亿个样本。显然,实际生成这么多输出是不现实的。但这并非必需:只需将 50 个标记的概率相乘即可估算出概率。

需要注意的关键一点是,概率可能会迅速变得非常小。在我虚构的例子中,模型生成“花生酱和果冻”这四个词条的概率只有 10%。如果我们添加更多词条,概率会变得更低。如果我们再添加 46 个词条,概率可能会下降几个数量级。

对于任何语言模型来说,“偶然”生成任何给定的 50 个 token 序列的概率都微乎其微。如果一个模型从受版权保护的作品中生成了 50 个 token,那么这便是这些 token “来自”训练数据的有力证据。即使它只有 10%、1% 或 0.01% 的概率生成这些 token,情况也是如此。

研究作者选取了36本书,将每本书分成100个重叠的标记段落。以前50个标记作为提示,他们计算了接下来50个标记与原文相同的概率。如果模型逐字复述一段文字的概率超过50%,他们就将这段文字视为“已记住”。

这个定义相当严格。要使一个包含 50 个 token 的序列的概率大于 50%,文章中每个 token 的平均概率至少需要达到 98.5%!此外,作者只统计了完全匹配的情况。他们没有考虑其他情况,例如,模型根据原文生成了 48 或 49 个 token,但有一两个 token 出错的情况。如果把这些情况也算上,记忆量会更大。

这项研究提供了强有力的证据,证明《哈利·波特与魔法石》的大量内容被复制到了 Llama 3.1 70B 的权重中。但这一发现并未告诉我们为什么会发生这种情况,以及这种情况是如何发生的。我怀疑部分原因在于 Llama 3 70B 使用了 15 万亿个 token 进行训练——是 Llama 1 65B 训练所用 token 的 10 倍多(1.4 万亿个 token)。

模型在特定样本上训练的次数越多,它记住该样本的可能性就越大。Meta 或许难以找到 15 万亿个不同的标记,因此它多次在 Books3 数据集上进行训练。又或许 Meta 添加了第三方来源——例如在线哈利·波特粉丝论坛、消费者书评或学生读书报告——其中包含了来自哈利·波特和其他热门书籍的语录。

我不确定这两种解释是否完全符合事实。记忆对于最受欢迎的书籍来说是一个更大的问题,这确实表明Llama可能接受过引用这些书籍的二手资料的训练,而不是书籍本身。网上关于《哈利·波特》的讨论可能比《睡魔史莱姆》多得多。

另一方面,令人惊讶的是,骆驼记住了《哈利波特与魔法石》的很多内容。

“如果是引用和引文,你会认为它会集中在一些大家都会引用或谈论的热门话题上,”莱姆利说。“骆驼3”几乎记住了书中一半的内容,这表明整本书的内容在训练数据中得到了很好的体现。

或者可能完全是另一种解释。也许 Meta 对其训练方案做了一些细微的调整,意外地加剧了记忆问题。我周二给 Meta 发了一封电子邮件,请他们评论,但还没有收到回复。

“似乎并非所有畅销书都是如此,”马克·莱姆利告诉我。“有些畅销书有这种结果,有些则不然。很难想出一个清晰的解释来解释为什么会发生这种情况。”

实际上,关于使用受版权保护的作品来训练模型如何侵犯版权,有三种不同的理论:

1.对受版权保护的作品进行培训本质上是侵权的,因为培训过程涉及制作该作品的数字副本。

2.训练过程将训练数据中的信息复制到模型中,使模型成为版权法下的衍生作品。

3.当模型生成(部分)受版权保护的作品时,就会发生侵权。

到目前为止,很多讨论都集中在第一种理论上,因为它对人工智能公司威胁最大。如果法院支持这一理论,那么无论是否记住了任何训练数据,大多数现有的 LLM 都将被视为非法。

人工智能行业有一些相当有力的论据,认为根据 2015 年 Google Books 裁决,在训练过程中使用受版权保护的作品属于合理使用。但 Llama 3.1 70B 记住了《哈利·波特》的大部分内容,这一事实可能会影响法院对这些合理使用问题的考量。

合理使用分析的一个关键部分是判断某种使用是否具有“变革性”——即一家公司是创造了新事物,还是仅仅从他人的作品中获利。语言模型能够复现《哈利·波特》、《1984》和《霍比特人》等热门作品的大量内容,这一事实可能会让法官对这些合理使用论点持更加怀疑的态度。

此外,谷歌在图书案中的一个关键论点是,其系统的设计初衷是,任何书籍都只能返回一小段摘录。如果 Meta 案的法官想要区分 Meta 和谷歌在图书案中的论点,他可以指出,Llama 能够生成的远不止几行《哈利·波特》的内容。

这项新研究“使这些案件中被告讲述的故事变得更加复杂,”合著者马克·莱姆利告诉我。“他们的说法是‘我们只是学习了词汇模式,而这些模式在模型中并没有体现出来。’”

但根据第二种理论,《哈利·波特》的结果给 Meta 带来了更大的危险——Llama 本身是 JK 罗琳杰作的衍生品。

“很明显,你实际上可以从模型中提取《哈利·波特》和其他各种书籍的大量内容,”莱姆利说。“在我看来,这意味着,对于其中一些书籍,模型本身可能存在法律会称之为书籍部分内容的复制品。”

Google 图书先例可能无法保护 Meta 免受第二种法律理论的影响,因为 Google 从未将其图书数据库提供给用户下载——如果 Google 这样做,几乎肯定会败诉。

原则上,Meta 仍然可以说服法官,根据法官制定的灵活合理使用原则,复制《哈利·波特》42%的内容是允许的。但这将是一场艰苦的战斗。

“你需要做的合理使用分析不仅仅是‘训练集是否合理使用’,还包括‘将其纳入模型是否合理使用’,”莱姆利说。“这让被告的陈述变得复杂。”

格里梅尔曼还表示,这项研究可能使开放式权重模型面临比封闭式权重模型更大的法律风险。康奈尔大学和斯坦福大学的研究人员之所以能够开展他们的研究,是因为作者能够接触到底层模型,从而能够接触到标记概率值,从而能够高效地计算标记序列的概率。

大多数领先的实验室,包括 OpenAI、Anthropic 和 Google,都越来越多地限制对这些所谓的 logits 的访问,使得研究这些模型变得更加困难。

此外,如果公司将模型权重保存在自己的服务器上,它可以使用过滤器来尝试阻止侵权输出流向外部世界。因此,即使底层的 OpenAI、Anthropic 和 Google 模型以与 Llama 3.1 70B 相同的方式记忆了版权作品,公司外部的任何人都可能难以证明这一点。

此外,这种过滤机制使得拥有封闭式模型的公司更容易援引谷歌图书的先例。简而言之,版权法可能会对那些发布开放式模型的公司形成强烈的阻碍。

“这有点反常,”马克·莱姆利告诉我。“我不喜欢这个结果。”

另一方面,法官可能会得出结论,对发布公开重量模型的公司进行有效惩罚是不好的。

“在某种程度上,公开和分享体重也是一种公共服务,”格里梅尔曼告诉我。“我真心觉得,裁判们对Meta和其他提供公开体重模特的机构的质疑会减少。”

Timothy B. Lee

文章来自于微信公众号“F8AI”。