随着 GPT-4o 展现出令人印象深刻的多模态能力,将视觉理解和图像生成统一到单一模型中已成为 AI 领域的研究趋势(如MetaQuery 和 BLIP3-o )。

南洋理工大学 S-Lab 和商汤科技的研究团队推出 OpenUni,一个开源版 MetaQuery,仅用 1.1B 参数达到 8B 模型性能,更将代码、权重、数据全部开源!

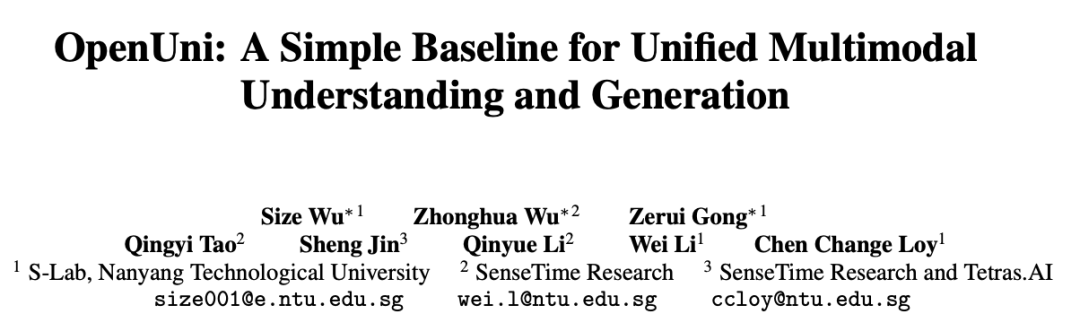

架构图,OpenUni 架构:通过 256 个可学习查询和 6 层轻量连接器,桥接冻结的 InternVL(理解)与 SANA(生成)

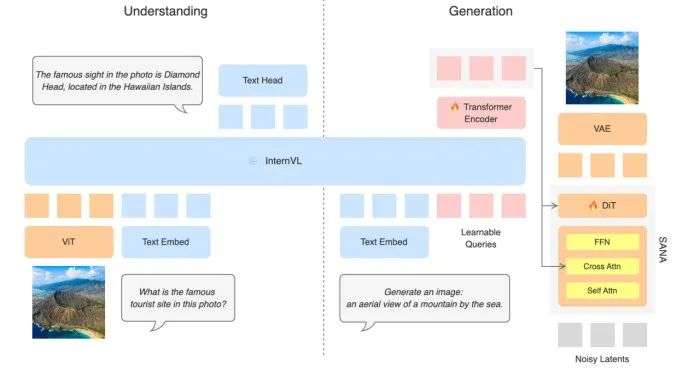

图 1:OpenUni 在生成任务上的性能表现,展示了其高效的参数利用

1. 架构极简

仅 6 层连接器,相比 MetaQuery 的 24 层大幅精简

2. 参数高效

1.1B 参数达到 GenEval 0.84 分,与 BLIP3-o-8B 模型性能相当

3. 完全开源

模型权重 + 训练代码 + 2300 万数据集全部公开

OpenUni 遵循 MetaQuery 的设计理念,包含四个核心组件:

1.256 个可学习查询 - 从用户指令中提取条件信息

2. 冻结的 InternVL - 保持原有理解能力

3.6 层 transformer 连接器 - 基于 ViT 架构

4.SANA 扩散模型 - 高效图像生成

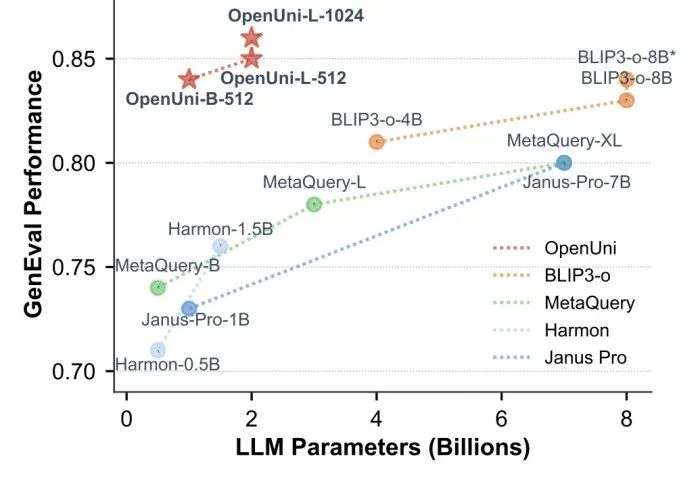

模型对比

* 对于 BLIP3-o,将预测 CLIP 特征的 DiT 视为连接器

关键特点: - 连接器参数大幅减少 - 使用更小的 MLLM 和扩散模型 - 训练数据完全公开

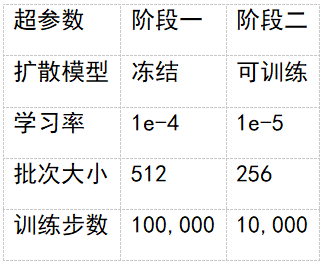

两阶段训练策略

第一阶段:预训练(2300 万图文对)

第二阶段:微调(6 万图文对)

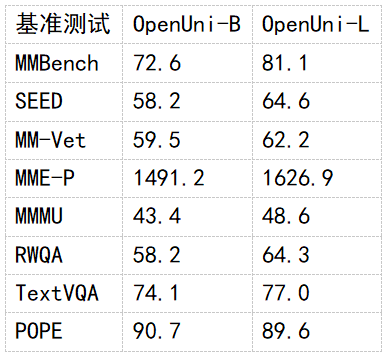

OpenUni 在参数效率上表现出色:

其他基准测试

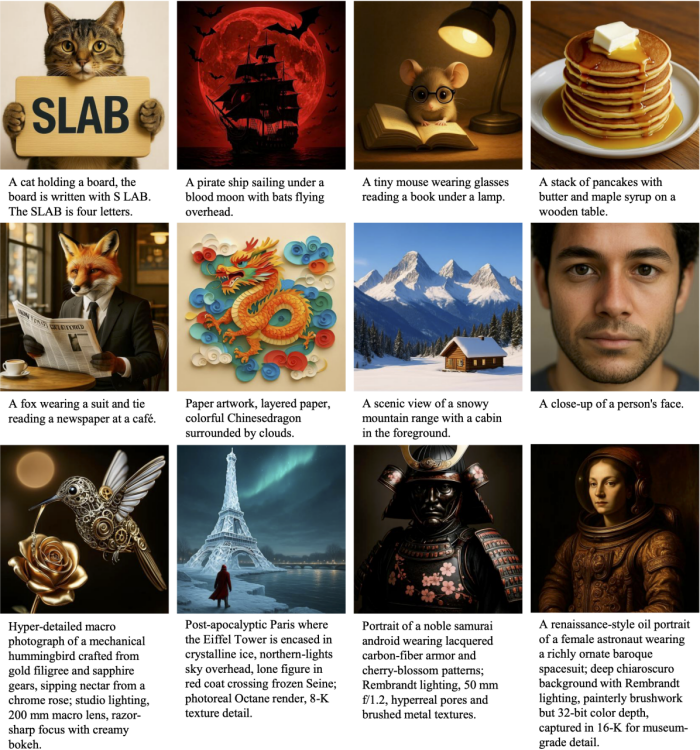

生成效果展示

图 2:OpenUni-L-1024 生成的多样化高质量图像

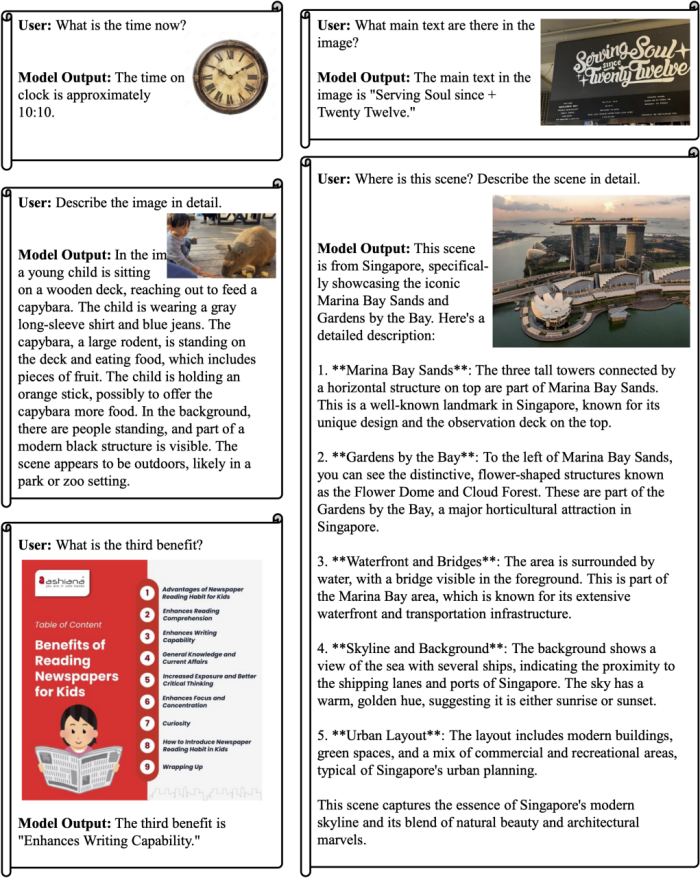

由于采用冻结 InternVL3 的策略,OpenUni 继承了其理解能力:

图 3:OpenUni-L 的多模态理解能力展示

理解基准测试

应用前景与开源贡献

OpenUni 提供完整的开源资源:

模型权重 - 所有训练阶段的 checkpoint

训练代码 - 完整训练 pipeline

2300 万训练数据 - 包含重新生成的 caption

详细文档 - 训练配置和复现指南

研究团队指出了当前的局限:

OpenUni 为统一多模态模型提供了一个简单但强大的基线。通过极简的架构设计和高效的参数利用,OpenUni 展示了:

作为一个持续进行的项目,OpenUni 为研究社区提供了清晰、可复现、易扩展的基线实现。

文章来自于微信公众号“机器之心”。

【免费】ffa.chat是一个完全免费的GPT-4o镜像站点,无需魔法付费,即可无限制使用GPT-4o等多个海外模型产品。

在线使用:https://ffa.chat/

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner

【开源免费】LangGPT 是一个通过结构化和模板化的方法,编写高质量的AI提示词的开源项目。它可以让任何非专业的用户轻松创建高水平的提示词,进而高质量的帮助用户通过AI解决问题。

项目地址:https://github.com/langgptai/LangGPT/blob/main/README_zh.md

在线使用:https://kimi.moonshot.cn/kimiplus/conpg00t7lagbbsfqkq0