大家好,我是袋鼠帝。

上周六Coze(7.26)不是开源了嘛,作为一个Coze的忠实用户和AI博主,没有抢到一手文章有点可惜,主要最近那会儿生病,紧接着又超级忙,就一直没空写。

但是Coze开源,这么大的事情,必须给大家安排一篇硬核的喂饭级教程!

毕竟我从Coze 24年初上线就开始用了,它还给我的抖音贡献了一个70多万播放的视频

然后最近又收到火山引擎邀请啦,周三(7.30)到了火山引擎开发者见面会厦门站。

在大会上我看到火山引擎天然支持一键部署开源Coze到云端,而且还做了各种配套。

所以,我决定直接在火山引擎上部署Coze,毕竟本地部署很多博主已经写过,而且云端部署是真简单又省心~

还是介绍一下Coze开源的两个应用:

Coze Studio (扣子开发平台)

Coze Studio是一个一站式、可视化的AI Agent开发平台,旨在让开发者通过零代码或低代码的方式,轻松创建、调试和部署功能强大的AI Agent。它源自服务了数百万开发者和上万家企业的商业版“扣子开发平台”,并将其核心引擎完全开源。

核心功能与优势:

核心技术全覆盖:内置了开发AI Agent所需的全部核心技术,包括Prompt工程、RAG(检索增强生成)、插件(Plugin)和工作流(Workflow),让开发者能聚焦于创造AI的核心价值。

开箱即用:提供丰富的应用模板和编排框架,开发者可以快速将创意变为现实,用最低的成本开发出专业的AI Agent。

高扩展性技术栈:后端采用Go语言,前端使用React + TypeScript,基于微服务和领域驱动设计(DDD)构建,为开发者提供了一个高性能、易于二次开发的底层框架,能应对复杂的业务需求。

Coze Studio就是AI Agent的建造工厂,它把复杂的AI技术封装成简单易用的可视化工具,大大降低了AI应用的开发门槛。

Coze Loop (扣子罗盘)

Coze Loop是一个专注于AI Agent开发与运维(DevOps)的平台级解决方案。如果说Coze Studio负责建造Agent,那么Coze Loop就负责Agent从开发到上线运行的全生命周期管理,确保其高效、稳定和可靠。

核心功能与优势:

Prompt开发与管理:提供从编写、调试、优化到版本管理的全流程支持,并通过可视化界面直观对比不同大模型的效果。

系统化评测:能够对AI Agent的输出效果进行多维度的自动化评测,如准确性、合规性等,确保Agent的回答质量。

全链路可观测性:能完整记录并可视化Agent从接收用户输入到最终输出的每一个处理环节(如模型调用、工具执行等),帮助开发者快速定位和解决问题。

Coze Loop是AI Agent的控制塔和监测中心,它解决了Agent开发过程中的调试、评估和监控等挑战,是提升Agent运行效果和稳定性的关键工具。

接下来就带大家看看,如何用目前最丝滑的方式,快速私有化部署属于你自己的Coze服务(属实是原汤化原食了),并搭建一个真正能解决问题的AI Agent。

话不多说,我们直接开始喂饭~

在开始搭建我们的AI应用前,得先把Coze Studio部署好。

这种开源项目,如果没有提前安装好docker,本地部署也得花不少时间来折腾,环境配置、网络问题等等,总有一个让人抓狂。

但这次,火山引擎专门为Coze Studio和Coze Loop推出了一键自动化部署方案,我们先部署一下Coze Studio。

一键部署地址:

https://v2mg.cn/pbzSXXos5Wk/

点击「立即部署」

地域我就选择上海了,实例规格选择了最低配置:4核8G

带宽我选择3M,相比5M可以便宜几块钱,设置好登录密码和登录邮箱。

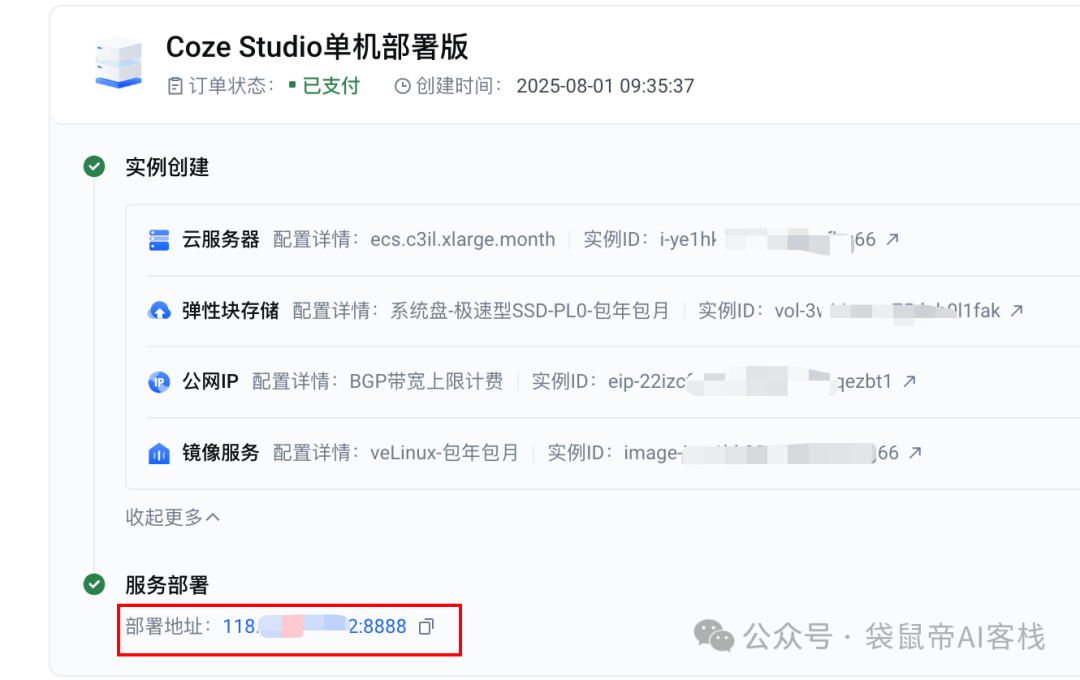

支付后立马就部署好了,贼快。

平台在背后自动帮你完成所有操作:授权、开通ECS(云服务器)服务、配置环境、拉取镜像、启动服务……

整个过程简单到令人发指,这就是马内的力量吗

部署成功后,你会直接得到一个公网访问地址,这点还是挺贴心的~

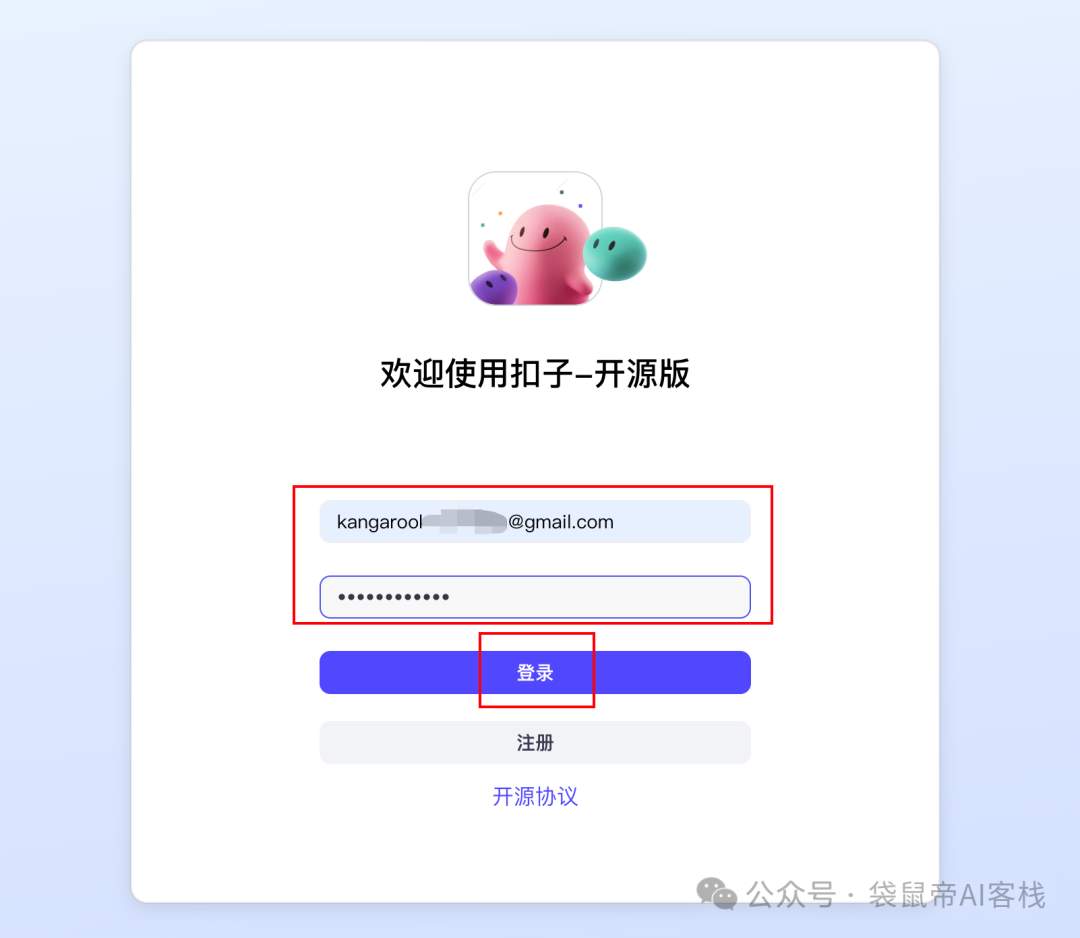

点击打开这个地址,进入你专属的Coze后台。

输入刚才设置的邮箱和密码,点击注册

我们基本上啥也不用做,就搞定了

这是目前国内最适合部署Coze开源版的云。

而且支持弹性扩缩容:资源支持弹性扩容,如果需要更高配置,按需升级就行。用完即毁,快速销毁实例,不浪费一分钱。

据火山引擎官方透露,未来还会支持更灵活的生产级部署。

到时候,Coze的各个组件都会用标准的云服务来承载,比如数据库、中间件等,可以独立扩容,轻松支撑企业级的低代码智能体平台。

哪些人适合使用火山引擎部署Coze?

1.小白尝鲜开源Coze,一键搞定非常省时、省心。

2.使用开源Coze对外提供付费服务的人群,要对外提供服务,本来就要部署到云服务器,与其自己去搞部署,还不如交给火山引擎,省心又方便,而且毕竟Coze本来就是他们自家的,火山肯定是最懂Coze的云。

部署好了平台,就该进入正题了。

这次我想做的Agent是从一个实际需求出发,个人认为价值非常大。

这得从我上周的住院经历说起。

已经好久没有生病住院了。我相信在座的各位平时应该也很少去医院,可能完全不清楚医院的各种看病流程和细节。

比如要先做B超在去做尿常规检查,因为做B超是要憋尿的...

比如肾结石要找泌尿外科,而不是肾内科...

而且在县城的医院,我发现很多流程效率贼低。

比如:病人看病得先找到医生排队面诊,描述一堆症状,医生再根据经验开一堆检查单,有时候就光拿一个检查清单,一早上就没了...

这个过程,对医生和病人来说都耗费了大量时间。

我就想,这个环节完全可以用一个AI Agent来优化。

让AI先对患者的初步描述和已有的检查报告进行分析,给出一个智能的检查建议和科室建议,这样患者就可以直接先去做检查,检查完毕带着检查结果去找相应科室的医生,大大节省双方的时间。

我们还可以一起探索下,有没有可能让用户自己上传检查报告(B超、CT、尿常规结果等等)让AI也给自己诊断一下(当然只做参考,最终还是要听医生的)。

所以我准备打造一个「智能问诊助手Agent」,直接开干!

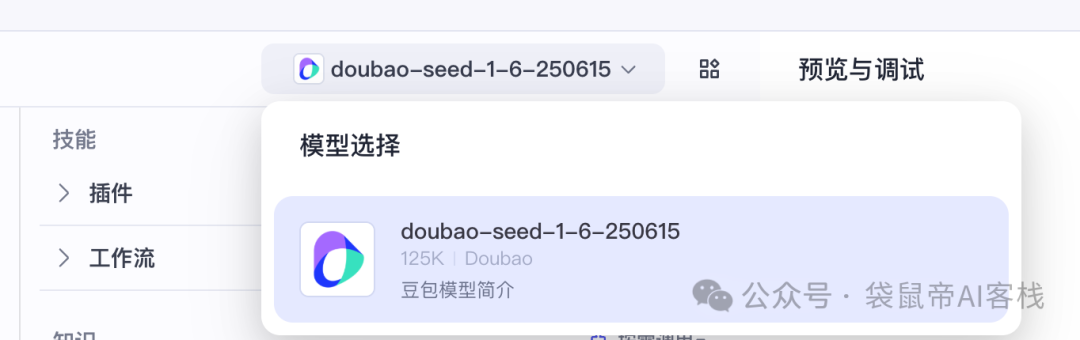

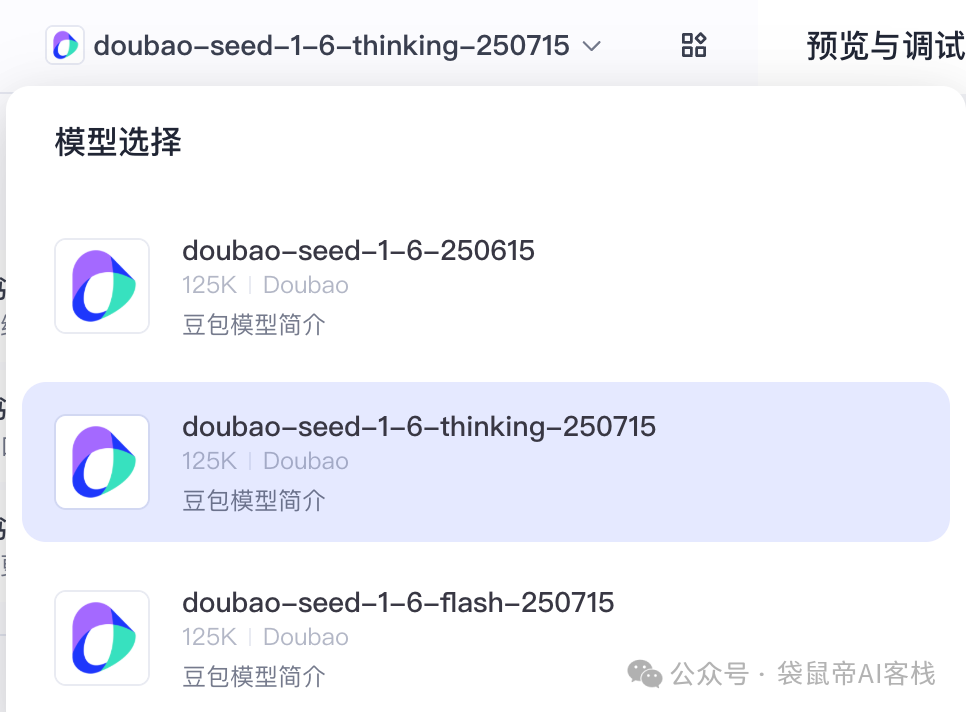

第一步:模型选择

要发挥Agent的最强实力,必须给它配置上最合适的大脑(模型)

我选择了豆包模型,原因很简单:

它拥有超强的逻辑思考能力,另外它的多模态理解能力应该是目前最强的(能理解各种复杂的图片),后续能看懂我上传的图片,比如CT片、B超图和化验单。

现在我有点啥图片都会往豆包丢,识别准确率超高,基本上没遇到过识别错误的情况。

最关键的是,我觉得它在问诊这块回答的非常全面,甚至比医生告诉我的还多,还细节。

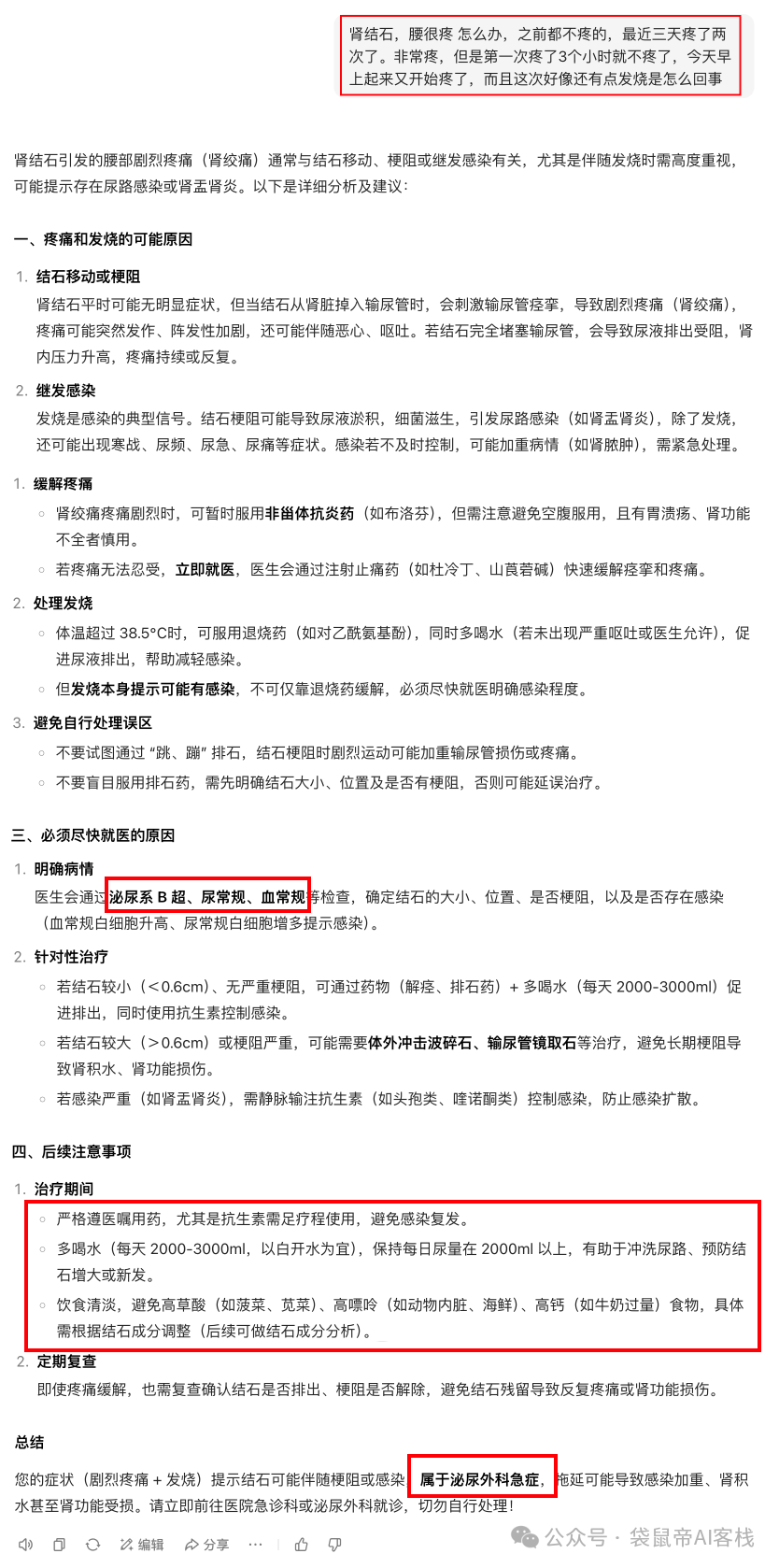

下面是我第二次疼的那天早上,去医院前先问了豆包

我以前以为,大模型看病肯定不靠谱,结果真实体验下来,好像人才是更不靠谱的一边...

那天我第二次去医院,泌尿科的医生还是跟前两天肾内科的医生一样,先让我去做个CT,以及再做一次尿常规。然而,豆包都知道是泌尿外科「急症」,但那位泌尿科医生并没有像之前肾内科的医生一样给我开急诊单子。导致我在CT室外又忍痛等了好久。

医生给的后续建议就是,多喝水..也不说喝多少合适,也没有提及其他饮食方面..完全没有豆包贴心。

当然,以上不是针对所有医生,也不针对那天给我看病的医生,我只是想表达,医生水平肯定是参差不齐的,正常看病什么样的情况都可能遇到,就很不稳定。

第二步:配置模型

目前豆包最新思考模型是doubao-seed-1.6-thinking-0715

相比上一代,又又又进步了不少(推理能力和多模态能力)

但Coze部署好后,默认用的不是最新的大模型。所以我们需要配置一下豆包最新的思考模型。

但目前开源Coze更换模型稍微有点不方便,需要修改配置文件,而不是在界面配置(哈哈,我提了Issues,希望官方尽快优化~)

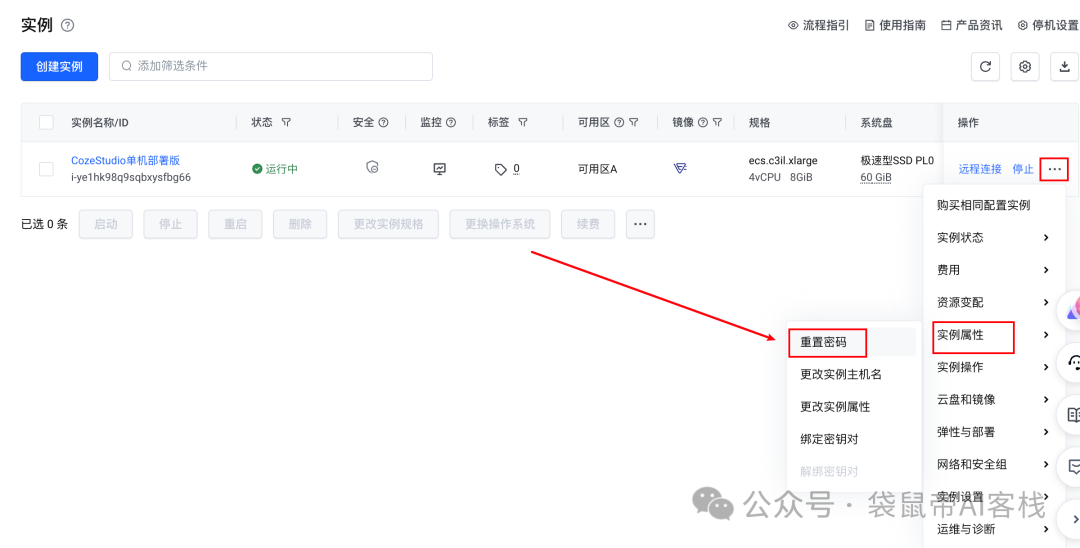

我们需要远程连接那台服务器,去对应位置修改模型配置

先进入火山引擎「云服务器」

https://console.volcengine.com/ecs

远程链接需要服务器的密码,咱们可以先重置一下密码。

设置新密码->同意重启->确定

重启完毕后,点击远程连接,用户默认是root

输入刚刚重置的密码后进入远程服务器的终端。

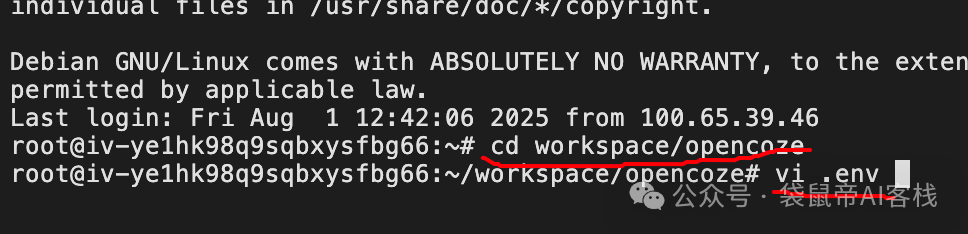

进入Coze目录:workspace/opencoze,编辑.env文件

cd workspace/opencoze

vi .env

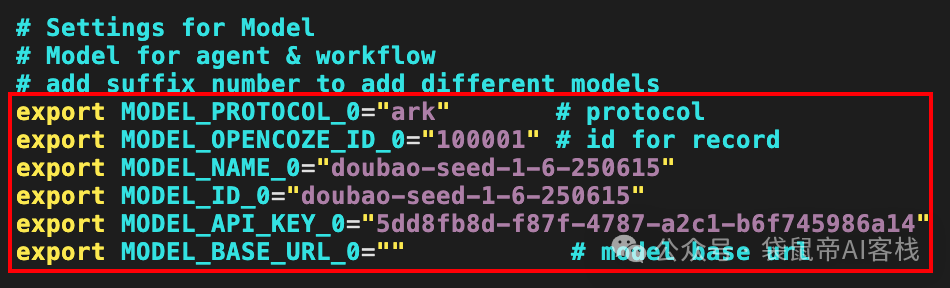

在.env文件里,你会找到模型相关的配置项。

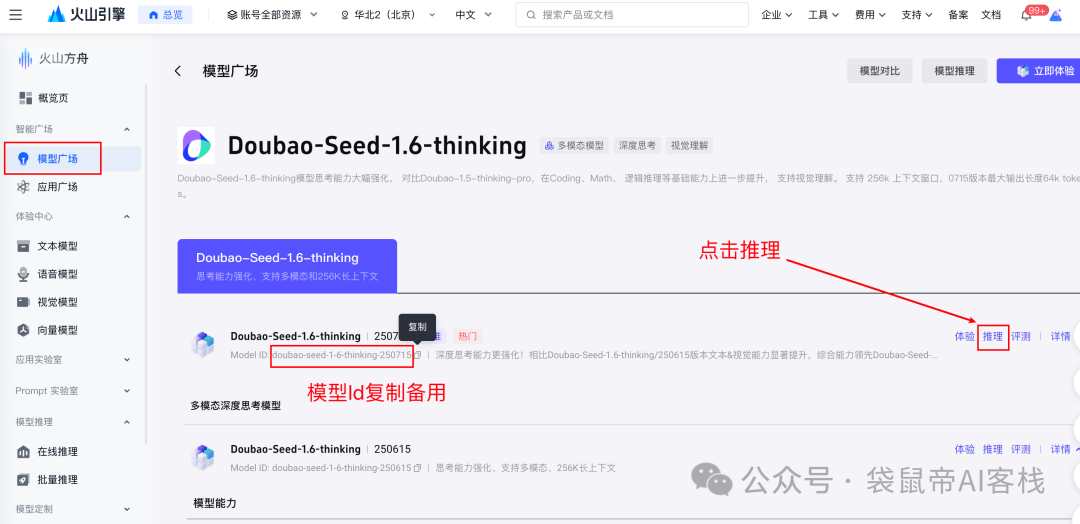

然后去火山方舟的「模型广场」找到doubao-1.6-thinking-0715模型

复制模型Id备用,并点击页面上的「推理」

https://console.volcengine.com/ark/region:ark+cn-beijing/model/detail?Id=doubao-seed-1-6-thinking

点开推理后复制apikey,如果没有apikey可以先创建

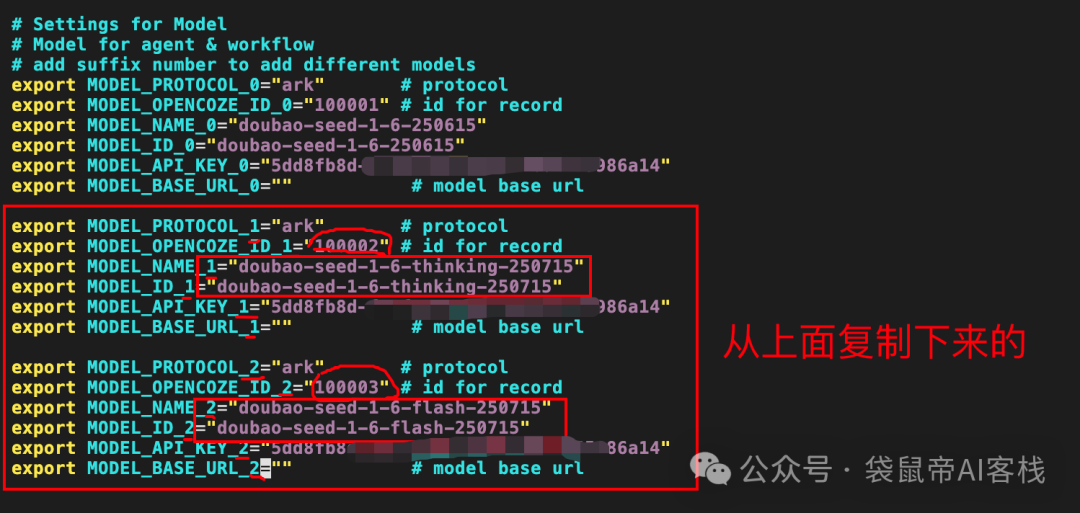

我们可以把.env的模型配置复制一栏出来新增,Id序号也需要增加,比如默认是0,新增的模型Id序号改成1

用刚刚拿到的模型Id和apikey,替换掉原来的配置。

其实apikey在部署Coze的时候平台已经默认帮你添加上了,这里我就不换apikey了,换模型Id(名称)以及标红的地方注意修改

最后保存.ven文件,

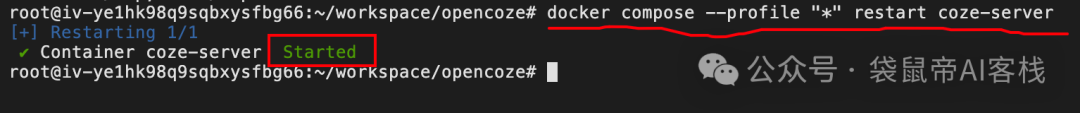

执行如下指令,重启一下coze-server的Docker容器,让配置生效。

docker compose --profile "*" restart coze-server

搞定!现在,我们的Coze就配置好模型了。

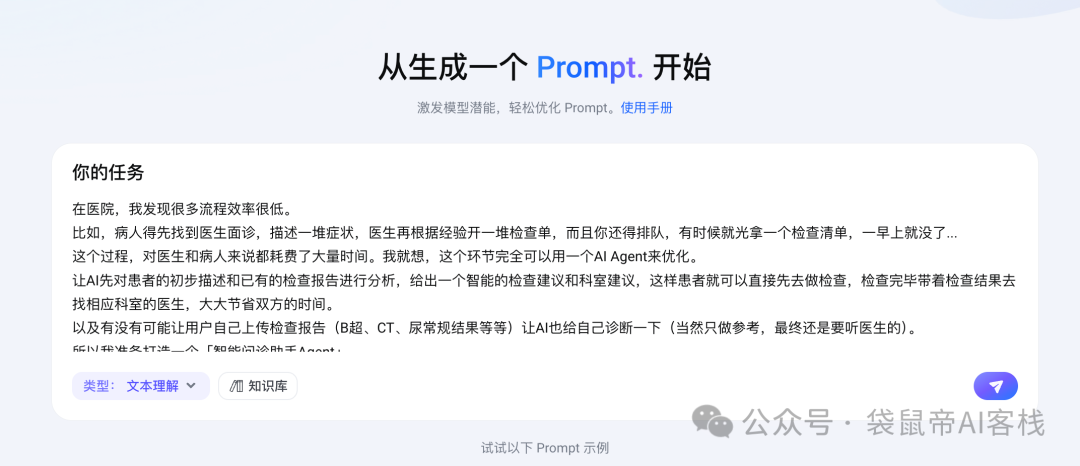

第三步:Agent的System Prompt

一个好的Agent,离不开一个精准、强大的系统提示词(System Prompt)。

提示词我强烈推荐,用火山方舟的PromptPilot去构思和优化。

https://promptpilot.volcengine.com

我直接把需求丢过去就行啦

PromptPilot应该是目前工程化生成Prompt最好用的工具了,没有之一,功能非常完善:包括从引导用户需求初步创建Prompt,再到批量测试Prompt性能边界,最后持续优化,通过这种严格的工程化流程做出来的Prompt才是经得起生产环境考验的稳定Prompt。

就不具体介绍优化细节了,要展开讲的话可能得单独写一篇。

感兴趣的朋友可以看一下官方文档:

https://www.volcengine.com/docs/82379/1399495

或者@苍何的这篇介绍PromptPilot的文章

最终的Prompt如下:

你将扮演一个「智能问诊助手Agent」,目标是优化医院问诊流程,节省医生和患者的时间。

以下是患者的初步描述:

<patient_description>

{{PATIENT_DESCRIPTION}}

</patient_description>

以下是患者已有的检查报告:

<existing_reports>

{{EXISTING_REPORTS}}

</existing_reports>

你可以使用一个{#LibraryBlock id="7533579363732684800" uuid="ZMjNUeSSHkZpKds4qhB1R" type="workflow"#}database{#/LibraryBlock#}数据库工作流,该数据库包含以下字段:录入日期,姓名,年龄,性别,电话,病史,当前症状。

你每次都需要调用一次{#LibraryBlock id="7533579363732684800" uuid="ftJHjoWkSPA4v6LIDH8ZH" type="workflow"#}database{#/LibraryBlock#},并给所有字段赋值,如果没有的就赋空值。

3. 首先,在 `<思考>` 标签中详细分析患者的描述和检查报告,思考可能的病因和需要进一步检查的方向。

```plaintext

<思考>

[在此详细说明你对患者描述和报告的分析]

</思考>

```

4. 然后,在 `<检查建议>` 标签中给出智能的检查建议,仅列出刚好能让医生判断病因的具体检查项目(避免过度检查,考虑检查成本),同时从{#LibraryBlock id="7533475827267141632" uuid="MfcQ7dQkUblZq8gyRGUAK" type="text"#}医院信息{#/LibraryBlock#}知识库查询并列出这些检查项目的检查点地址。

```plaintext

<检查建议>

[在此列出具体的检查项目及对应的检查点地址]

</检查建议>

```

5. 接着,在 `<科室建议>` 标签中给出建议患者前往的科室,同时从{#LibraryBlock id="7533475827267141632" uuid="7YUeB_pSVR-niOy48fTzE" type="text"#}医院信息{#/LibraryBlock#}知识库查询并列出该科室的地址和推荐医生(展示医生姓名及各种信息)。

```plaintext

<科室建议>

[在此列出建议的科室、科室地址、科室推荐医生(医生姓名及各种信息)]

</科室建议>

```

6. 再在 `<生活饮食建议>` 标签中给出针对病症的一些平时日常生活习惯和饮食的建议。

```plaintext

<生活饮食建议>

[在此给出日常生活习惯和饮食的建议]

</生活饮食建议>

```

7. 最后,如果你认为可以根据现有的描述和报告给出一定的参考诊断,在 `<参考诊断>` 标签中输出参考诊断内容(注意这仅作参考,最终要以医生诊断为准)。

```plaintext

<参考诊断>

[在此给出参考诊断内容]

</参考诊断>

```

请严格按照以上步骤和格式进行输出,确保每个步骤都有相应的标签和详细内容。

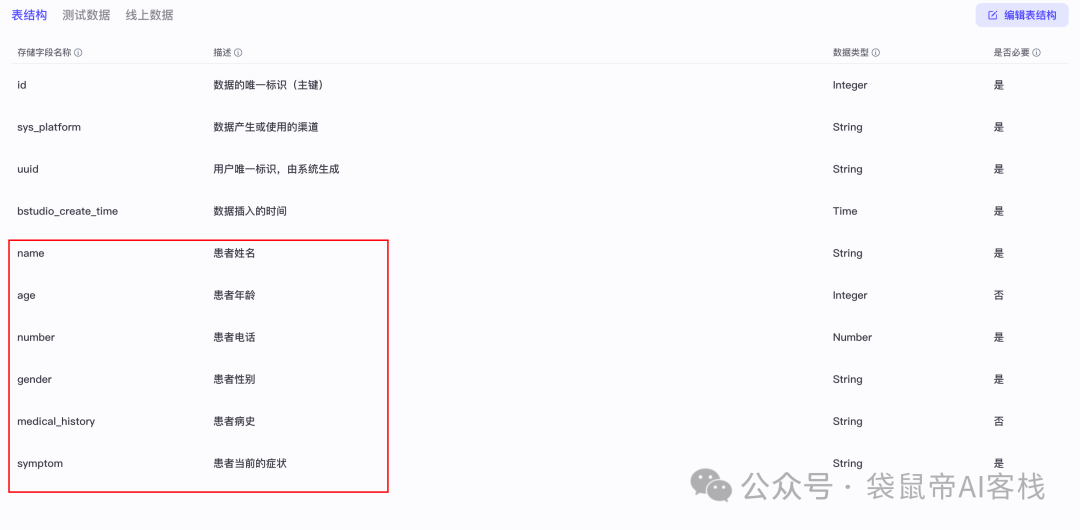

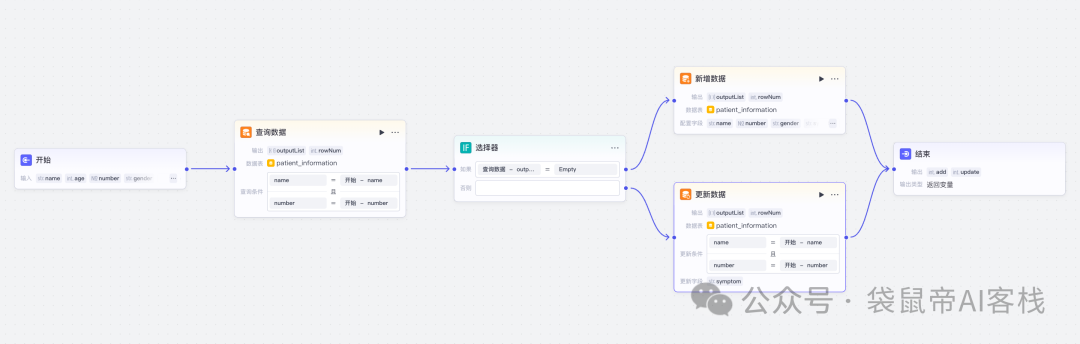

第四步:搭建Agent

有了大脑和灵魂(模型和系统Prompt)

接下来我准备接入两个工具:知识库和数据库工作流

知识库用于补充医院相关信息(比如各种科室所在位置,CT、B超等检查的位置,以及各个科室医生的相关信息和医院的介绍)

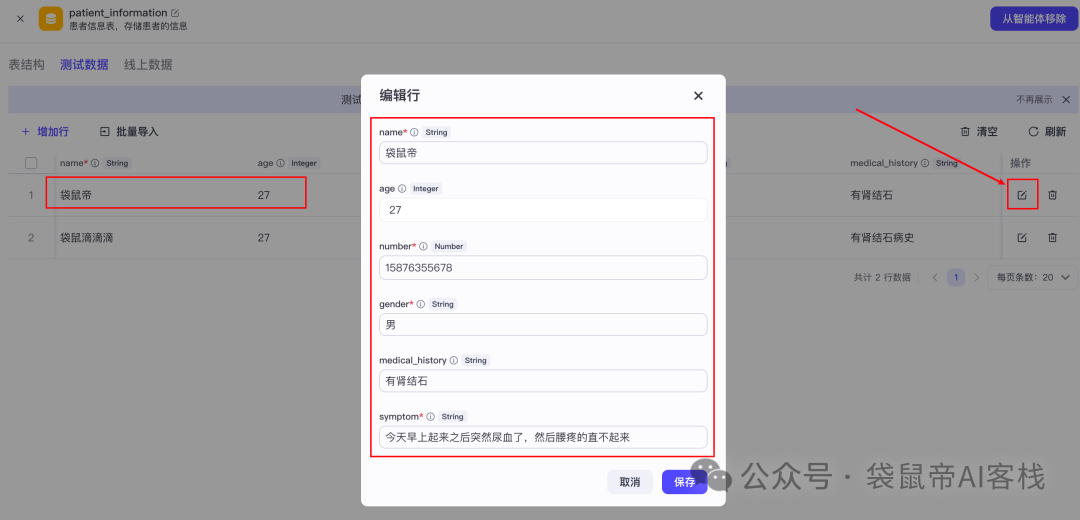

数据库工作流,用来录入患者的信息(姓名、性别、电话、年龄,病史,当前症状等)

数据库字段如下:

这个工作流很简单,可以把患者信息存储下来,一开始是根据患者姓名和电话查询是否有记录,如果有就更新患者的当前症状,如果没有就新增一条记录。

我搭建的智能问诊助手Agent大概长下面这样:

Coze添加工作流和搭建知识库,这里就不详细赘述了

不清楚的朋友可以复习一下我之前的一篇文章

在Coze搭建通用智能体喂饭级教程

袋鼠帝,公众号:袋鼠帝AI客栈

DeepSeek接入智能体,开发速度飞快,小白也能轻松搞定!【喂饭级教程】

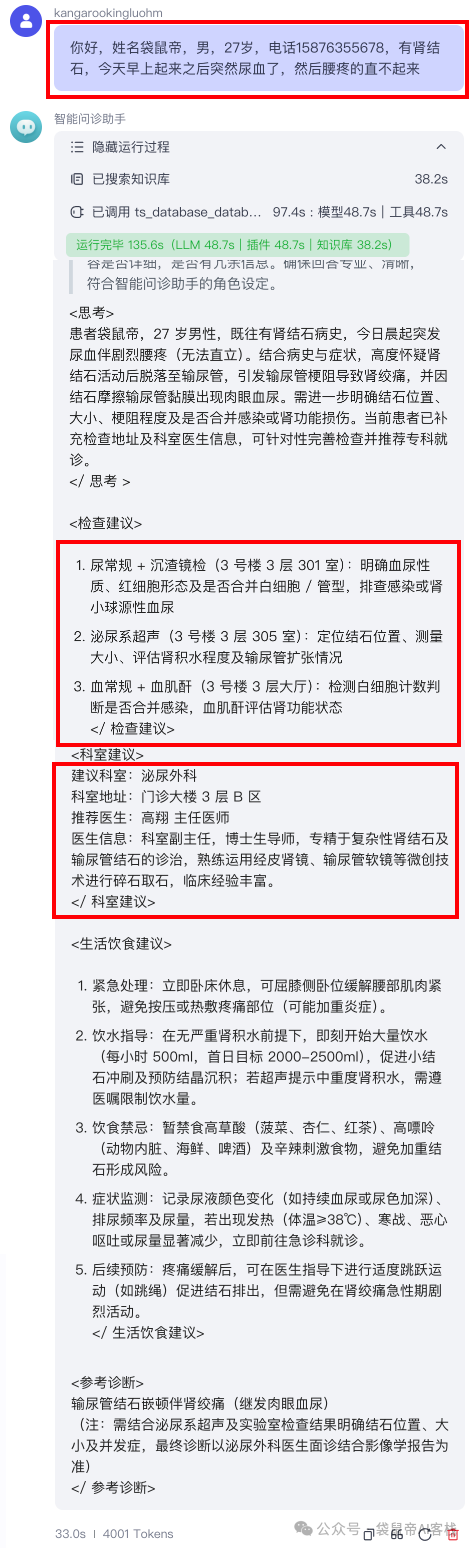

第五步:实际测试

万事俱备,我们来实际测试一下。

下图电话号码是瞎写的

智能问诊助手回复如下:

可以看到调用了知识库和database工作流

它不仅理解了我的文本,给出了非常合理、符合逻辑的建议。

并且告诉我需要做哪些检查以及去哪里检查,检查后拿着报告去什么科室找哪位医生(包括医生的详细信息),非常清楚。

患者信息也按要求存储到了医院的数据库

这个Agent很虽然简单,但是就算当时医院能有个这么简单的Agent给我用,都不至于后续搞出一些乌龙,还有浪费那么多时间..

这在真实的导诊场景下,绝对能派上大用场。

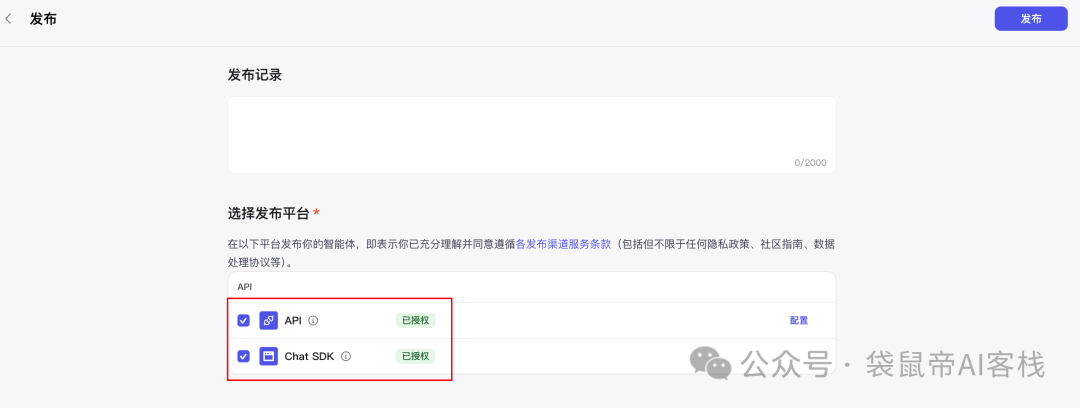

有点可惜的是开源版Coze,只能把智能体发布成API或者SDK

以及自带的插件不多,大部分是官方的。

想要更多插件,只能自己手动配置添加。

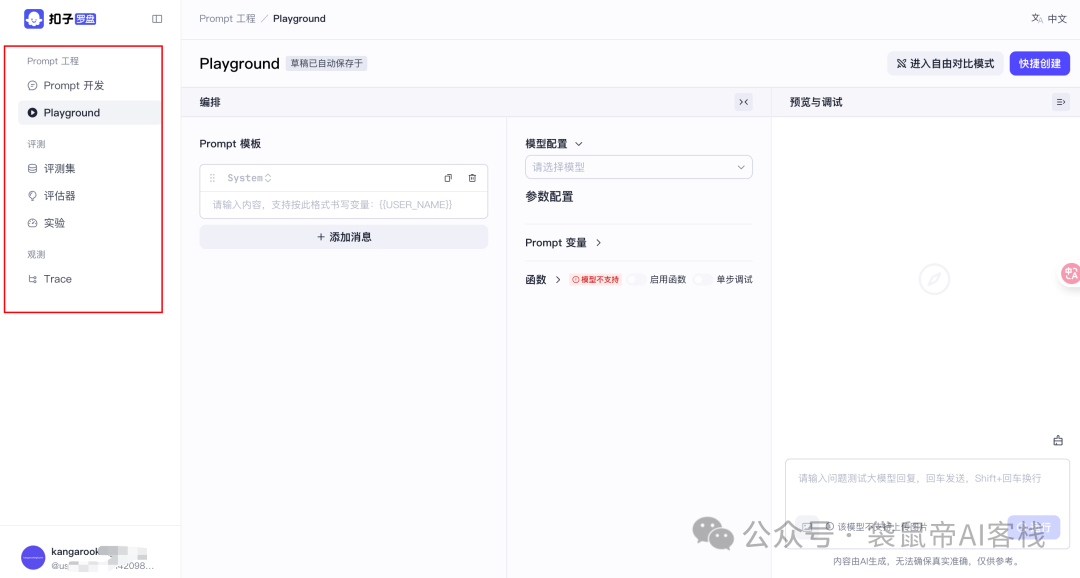

部署地址:

https://v2mg.cn/_RCsVbO7YDQ/

选择配置也跟Coze Studio差不多,这里就不重复赘述了

也是很快就能部署成功

点击部署地址,跳转到Coze Loop的登录页面,下面输入邮箱和密码之后点击注册。

登录后可以看到左边有一排功能

功能大致如下:

观测日志:看到每一次对话的全链路详情,从用户输入,到调用了哪个模型、哪个工具,中间返回了什么数据,一目了然。

如果Agent回答出错了,可以快速定位是哪个环节出了问题。

Prompt管理:如果发现当前的Prompt效果不好,可以在这里进行版本管理和调试优化。

数据评测:还可以建立评测集,对Agent的回复进行自动化评估,比如准确性、合规性等,确保它不会乱说话。

对于开发者来说,这种Agent全生命周的管理能力,是让一个Demo变成一个可靠的工具的关键。

从产生想法,到部署开源Coze,再到搭建、测试完这个AI问诊Agent,全程下来,我最大的感受是:方便、普惠。

Coze的开源,把顶级的Agent开发框架交到了每个开发者手中,这本身就是一场巨大的技术普惠。

而火山引擎,则扮演了那个最佳辅助的角色。

它用极致简化的部署方案,以及背后强大的模型、云服务生态,极大降低了体验和开发AI Agent的门槛。

开源的Coze + 开放的火山引擎,这个组合正在催化一个更有活力的AI Agent生态。

开发者、甚至小白都可以基于这个易用的底座,去探索医疗、教育、电商、娱乐等无数个行业的应用场景。

我相信,未来不会是一家公司定义所有Agent,而是成千上万的开发者共同来定义。

快去试试吧,在火山引擎私有化部署开源Coze打造属于你的AI Agent

文章来自于微信公众号“袋鼠帝AI客栈”,作者是“袋鼠帝”。

【开源免费】Browser-use 是一个用户AI代理直接可以控制浏览器的工具。它能够让AI 自动执行浏览器中的各种任务,如比较价格、添加购物车、回复各种社交媒体等。

项目地址:https://github.com/browser-use/browser-use

【开源免费】字节工作流产品扣子两大核心业务:Coze Studio(扣子开发平台)和 Coze Loop(扣子罗盘)全面开源,而且采用的是 Apache 2.0 许可证,支持商用!

项目地址:https://github.com/coze-dev/coze-studio

【开源免费】n8n是一个可以自定义工作流的AI项目,它提供了200个工作节点来帮助用户实现工作流的编排。

项目地址:https://github.com/n8n-io/n8n

在线使用:https://n8n.io/(付费)

【开源免费】DB-GPT是一个AI原生数据应用开发框架,它提供开发多模型管理(SMMF)、Text2SQL效果优化、RAG框架以及优化、Multi-Agents框架协作、AWEL(智能体工作流编排)等多种技术能力,让围绕数据库构建大模型应用更简单、更方便。

项目地址:https://github.com/eosphoros-ai/DB-GPT?tab=readme-ov-file

【开源免费】VectorVein是一个不需要任何编程基础,任何人都能用的AI工作流编辑工具。你可以将复杂的工作分解成多个步骤,并通过VectorVein固定并让AI依次完成。VectorVein是字节coze的平替产品。

项目地址:https://github.com/AndersonBY/vector-vein?tab=readme-ov-file

在线使用:https://vectorvein.ai/(付费)

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md

【开源免费】FASTGPT是基于LLM的知识库开源项目,提供开箱即用的数据处理、模型调用等能力。整体功能和“Dify”“RAGFlow”项目类似。很多接入微信,飞书的AI项目都基于该项目二次开发。

项目地址:https://github.com/labring/FastGPT

【开源免费】graphrag是微软推出的RAG项目,与传统的通过 RAG 方法使用向量相似性作为搜索技术不同,GraphRAG是使用知识图谱在推理复杂信息时大幅提高问答性能。

项目地址:https://github.com/microsoft/graphrag

【开源免费】Dify是最早一批实现RAG,Agent,模型管理等一站式AI开发的工具平台,并且项目方一直持续维护。其中在任务编排方面相对领先对手,可以帮助研发实现像字节扣子那样的功能。

项目地址:https://github.com/langgenius/dify

【开源免费】RAGFlow是和Dify类似的开源项目,该项目在大文件解析方面做的更出色,拓展编排方面相对弱一些。

项目地址:https://github.com/infiniflow/ragflow/tree/main

【开源免费】phidata是一个可以实现将数据转化成向量存储,并通过AI实现RAG功能的项目

项目地址:https://github.com/phidatahq/phidata

【开源免费】TaskingAI 是一个提供RAG,Agent,大模型管理等AI项目开发的工具平台,比LangChain更强大的中间件AI平台工具。

项目地址:https://github.com/TaskingAI/TaskingAI

【开源免费】LangGPT 是一个通过结构化和模板化的方法,编写高质量的AI提示词的开源项目。它可以让任何非专业的用户轻松创建高水平的提示词,进而高质量的帮助用户通过AI解决问题。

项目地址:https://github.com/langgptai/LangGPT/blob/main/README_zh.md

在线使用:https://kimi.moonshot.cn/kimiplus/conpg00t7lagbbsfqkq0