从“模型即服务”(MaaS)到“智能体即服务”(AaaS)的转变,标志着AI行业进入了新的发展阶段。我们不再满足于AI的“对话能力”,而是期望它能成为自主完成复杂任务的“全能机器人”。但当我们兴奋地将这些能力强大的Agent部署到生产线上时,却发现传统软件工程的“确定性”基石已不复存在。随机性,这个曾经在实验室里被视为“创造力”的特性,如今正成为生产环境中最大的不稳定因素。

如何驾驭这头充满力量却难以预测的“猛兽”?来自中科院与清华大学的研究者们给出了他们的答案「AgentOps」。这份分量十足的研究报告,第一次为Agent Systemm全生命周期运维提供了系统性的方法论。

在深入“翻车”现场之前,咱们得先对齐一下,现在我们常聊的“智能体系统”(Agent Systemm)到底是什么。根据研究者的定义,它是一个能感知环境、做决策、并自主完成任务的智能系统,挺像一个数字世界里的机器人。我之前写过一篇类似的文章,感兴趣您可以看下《Context Engineering不是造新词,IBM揭示LLM推理的认知秘密》如今基于大语言模型的智能体,更是有四项核心能力,像它的“四肢大脑”一样:

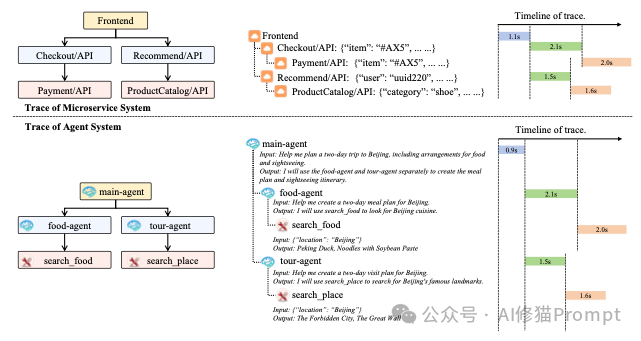

同时,根据团队规模,智能体系统也分为两种:一种是单智能体系统(SAS),一个人单打独斗,适合处理推理、对话、或与简单环境交互的任务。另一种是多智能体系统(MAS),一个团队协同作战,适合玩角色扮演、模拟社会现象、或者合作开发软件这种复杂任务。搞清楚了这些,我们再来看它为什么会出问题,就清晰多了。

在解决任何复杂问题时,首要任务是准确地定义它。就如爱因斯坦所言

The formulation of the problem is often more essential than its solution, which may be merely a matter of mathematical or experimental skill.

对一个问题的阐述和构造,往往比它的解决方案更重要。解决方案或许仅仅是数学或实验上的技巧问题。

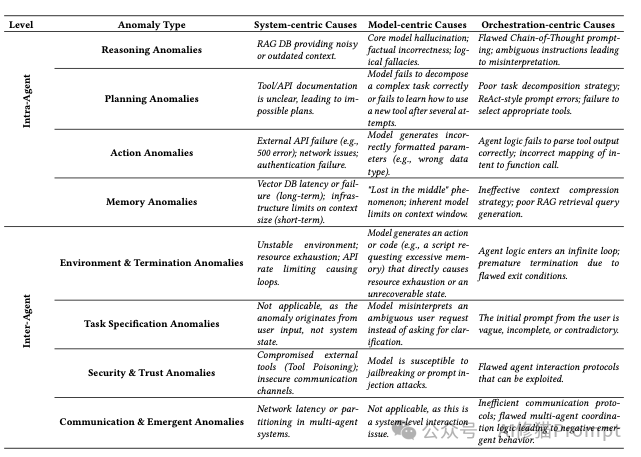

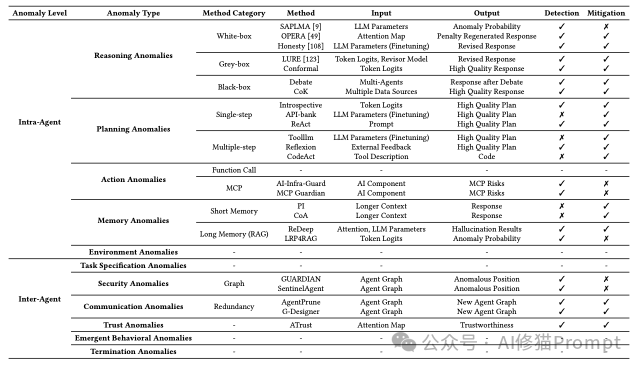

研究者们干的第一件事,就是给智能体的各种“不正常”行为做了个系统性的分类,他们称之为“异常(Anomalies)”。这个定义挺有意思的,它不只是说程序崩溃才算异常,而是把从任务开始前(比如给的指令不清不楚)、到执行中、再到任务结束后(比如答案对了但过程是瞎蒙的)所有导致任务失败或效果不佳的情况,都算了进去。

研究者把异常分成了两大类,第一种叫“Agent内部异常Intra-Agent Anomalies”,说白了就是单个智能体自己内部出了问题,像是“大脑短路”了。这种情况其实最常见,具体来说,大概有这么几种:

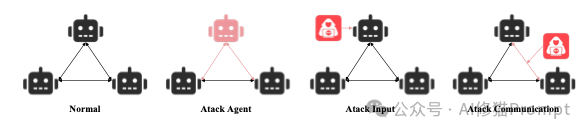

如果说内部异常是“单兵作战”失误,那“智能体间异常Inter-Agent Anomalies”就更像是团队协作时出的问题,处理起来也更麻烦。这种情况发生在多个智能体需要互相配合完成一个大任务的场景里,真的像一个项目团队,会遇到各种沟通和协作上的坑。研究者们也总结了几种典型情况:

智能体的行为是内在的概率性和不确定性(inherently probabilistic and non-deterministic),复杂自适应系统(complex adaptive system) 运行,其全局行为是无数局部交互的涌现属性。面对上面那么多异常,研究者们提出了一个系统性的解决方案,也就是“AgentOps”框架。您可以把它理解成一套专门为AI智能体系统量身打造的“运维和保障体系”,它不再把Agent当成一个简单的程序,而是当成一个有“心智”的、需要全生命周期管理的对象。这个框架主要分成四个环环相扣的阶段,咱们来详细拆解一下。

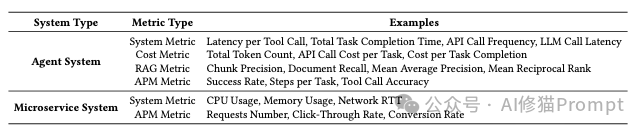

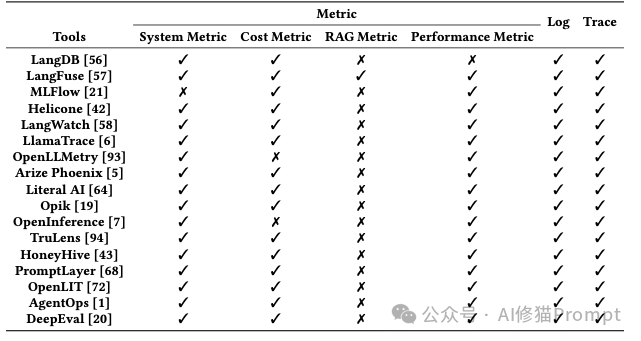

您知道吗,AgentOps的监控和我们传统搞的运维监控,思路很不一样。传统监控看的是CPU、内存这些“生理指标”,而AgentOps更关心Agent的“心理活动”,它要监控的数据也更特别。

这张表格对比了市面上多种用于LLM或智能体系统的可观测性工具(如Langfuse, MLFlow, OpenLLMetry等),展示了它们在监控指标、日志、追踪等功能上的支持情况。

传统运维的异常检测,通常是等系统出了问题,比如服务宕机或者接口报错了,我们才能发现。但是,AgentOps的异常检测要主动得多,它追求的是在问题还没造成严重后果之前就把它揪出来。它的核心思路是从“监控系统死活”转变为“判断Agent的想法对不对”,比如通过分析模型内部数据,在Agent刚要产生幻觉、还没输出错误答案的时候,就及时发现并干预。

当异常发生后,找到根本原因(Root Cause)是关键,不然就是治标不治本。传统运维找原因,可能最后定位到的是一段代码bug或者一个服务器配置错误。但AgentOps的RCA要复杂得多,因为问题可能出在一些“软逻辑”上,为了解决这个问题,研究者提出了一个非常精彩的RCA三维归因框架。

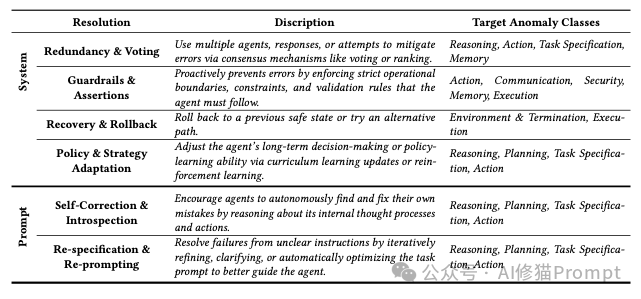

找到了原因,就该解决了。但和传统软件打补丁不一样,修复Agent系统的问题不能搞“一锤子买卖”,因为它的行为是概率性的,你改了一个地方,可能会像蝴蝶效应一样引发其他意想不到的问题。所以,研究者提出,解决方案必须是持续的、迭代的,并主要分为两大类。

诚然,AgentOps目前还是一张蓝图,完美落地前仍有诸多挑战。研究作者坦言我们缺乏统一的算法来同时检测五花八门的异常。我们难以在由模型、系统、编排逻辑交织成的“因果迷宫”中,精准地归因。更麻烦的是,对一个局部异常的修复,很可能引发不可预见的“蝴蝶效应”,造成更广泛的系统性失衡。

这是一张信息量很大的总表,它系统地梳理了针对论文中提到的各类异常(如推理异常、规划异常等)的现有检测和缓解方法。感兴趣您可以停留片刻,仔细看一下。

我们正试图用管理“确定性系统”的思路,去应对一个“概率性、自适应”的复杂系统,而这种方法正在失效。这是基于Transform架构的AI时代贯穿始终的核心矛盾。

这些挑战共同指向一个结论:管理Agent系统,就像在管理一个复杂多变的生命体。但正是因为挑战如此艰巨,AgentOps框架的提出才显得尤为珍贵。它让我们第一次拥有了一张可以按图索骥的蓝图,去系统性地思考和构建AI产品的稳定性和可靠性。

文章来自于微信公众号“AI修猫Prompt”。

【开源免费】Browser-use 是一个用户AI代理直接可以控制浏览器的工具。它能够让AI 自动执行浏览器中的各种任务,如比较价格、添加购物车、回复各种社交媒体等。

项目地址:https://github.com/browser-use/browser-use

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md

【开源免费】FASTGPT是基于LLM的知识库开源项目,提供开箱即用的数据处理、模型调用等能力。整体功能和“Dify”“RAGFlow”项目类似。很多接入微信,飞书的AI项目都基于该项目二次开发。

项目地址:https://github.com/labring/FastGPT

【开源免费】graphrag是微软推出的RAG项目,与传统的通过 RAG 方法使用向量相似性作为搜索技术不同,GraphRAG是使用知识图谱在推理复杂信息时大幅提高问答性能。

项目地址:https://github.com/microsoft/graphrag

【开源免费】Dify是最早一批实现RAG,Agent,模型管理等一站式AI开发的工具平台,并且项目方一直持续维护。其中在任务编排方面相对领先对手,可以帮助研发实现像字节扣子那样的功能。

项目地址:https://github.com/langgenius/dify

【开源免费】RAGFlow是和Dify类似的开源项目,该项目在大文件解析方面做的更出色,拓展编排方面相对弱一些。

项目地址:https://github.com/infiniflow/ragflow/tree/main

【开源免费】phidata是一个可以实现将数据转化成向量存储,并通过AI实现RAG功能的项目

项目地址:https://github.com/phidatahq/phidata

【开源免费】TaskingAI 是一个提供RAG,Agent,大模型管理等AI项目开发的工具平台,比LangChain更强大的中间件AI平台工具。

项目地址:https://github.com/TaskingAI/TaskingAI

【开源免费】LangGPT 是一个通过结构化和模板化的方法,编写高质量的AI提示词的开源项目。它可以让任何非专业的用户轻松创建高水平的提示词,进而高质量的帮助用户通过AI解决问题。

项目地址:https://github.com/langgptai/LangGPT/blob/main/README_zh.md

在线使用:https://kimi.moonshot.cn/kimiplus/conpg00t7lagbbsfqkq0