Gemini奥数金牌,实至名归!ETH Zurich博士在大学生国际数学竞赛(IMC)中,测试了Gemini的三种模式,表现远高于前8%的金牌门槛,远超普通大学生。

大学生数学不如AI?

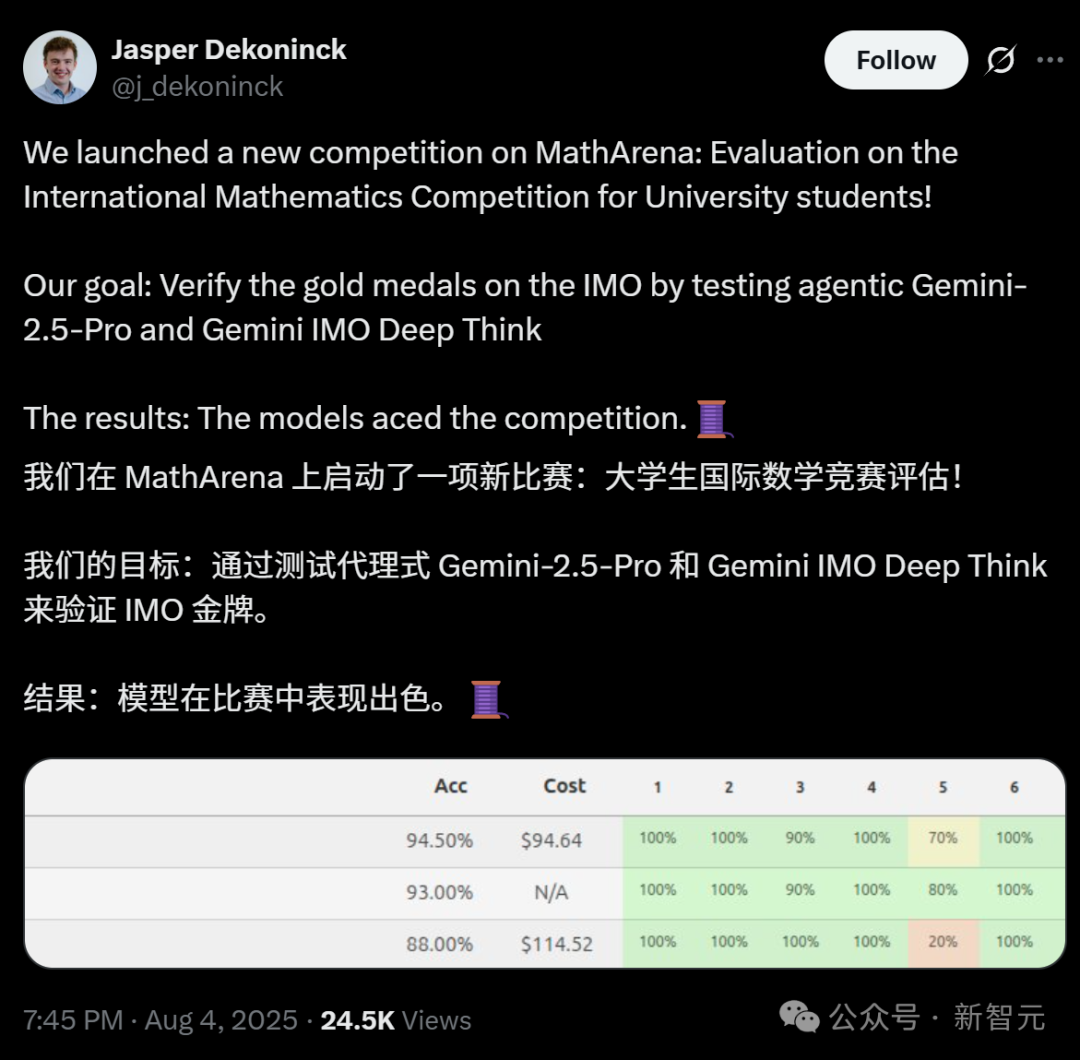

近日,在MathArena上,苏黎世联邦理工学院SRI实验室博士生Jasper Dekoninck,启动了一项新比赛:大学生国际数学竞赛(IMC)。

刚刚,他公布了测试结果:

最终,LLM以高分胜出:语言模型在国际数学竞赛中拔得头筹。

国际数学奥林匹克竞赛(IMO)一直被研究人员视为AI系统数学推理能力的试金石。

前不久,在刚刚举行的IMO竞赛中,谷歌、OpenAI等相继宣布其旗下LLM获得IMO金牌级成绩。

但由于获奖的AI系统不透明以及在结果上可解释性有限,这些金牌引发广泛的质疑和关注。

这次在MathArena上,首次评估了AI本科生数学竞赛上的表现,不仅仅为了证明AI的确有能力拿下IMO金牌,也为了验证AI在高中级别竞赛(如IMO)中的出色表现是否能够转化为在大学级别竞赛中的成功。

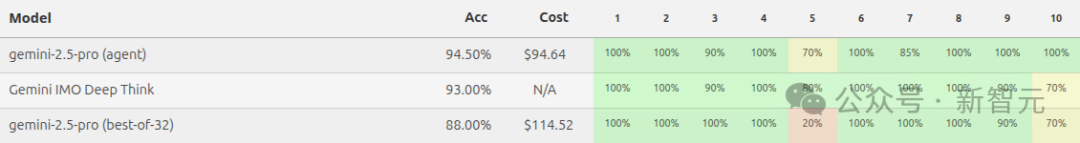

此次测试一共评估了三个系统:Gemini Deep Think IMO(IMO 2025金牌得主)、Gemini-2.5-Pro,以及Gemini-2.5-Pro Best-of-32基线。

由于OpenAI获得金牌的模型尚未发布,无法对其进行评估。

测试结果显示,三个系统均获得了极高的分数,远超前8%的金牌门槛。

Gemini Deep Think和Gemini Agent均成功解决了所有问题,仅出现了少量小错误。这些错误通常是由于中间步骤的论证不完整或对已知定理的引用不正确造成的。

有趣的是,Gemini Best-of-32的表现远比在IMO 2025上的表现好,仅在一道题目(P5)上犯了一个重大错误。这可能因为IMC的知识密集度更高,而大型AI模型往往在这种环境下表现出色。

这次得出了三大结论:

结论1:三个模型在IMC比赛中均获得高分,Gemini Deep Think和Gemini Agent在所有问题中都给出了大部分正确的答案。它们的得分足以媲美人类优等大学生参赛者。

结论2:综合考虑证明质量和清晰度,评委们对模型的排名如下:Gemini Deep Think>Gemini Agent>Gemini Best-of-32。

结论3:对结果进行的定性分析表明,Gemini Deep Think表现尤为出色,它给出的证明比其他模型清晰有趣得多。它有时会提出真正有趣的方法,而其他自主系统通常使用计算密集型的方法。

但由于这次评估是临时增加的,所以评估规模稍小,每个模型在每个问题上只被评估一次,并且只有一个裁判。

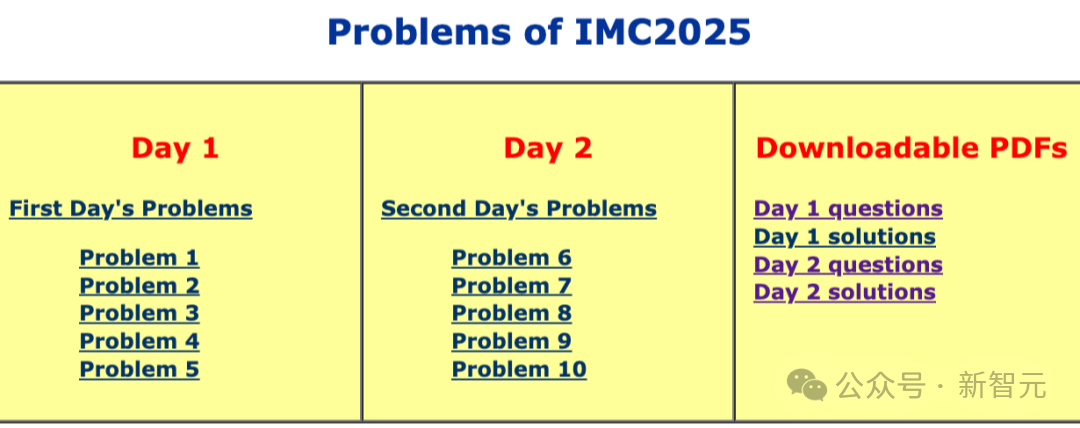

国际大学生数学竞赛IMC由英国伦敦大学学院主办,保加利亚美国大学承办,比赛将在2025年7月28日至8月3日于保加利亚的布拉戈耶夫格勒举行。

本次竞赛面向正在攻读大学本科阶段(1至4年级)的学生,参赛者年龄上限为23岁,特殊情况可酌情考虑。不设最低年龄限制。

试题涵盖的领域包括代数、分析(实分析与复分析)、几何与组合数学。比赛语言为英文。

IMC为期两天,每天有5道题目,每题10分。

IMC竞程:https://www.imc-math.org.uk/?year=2025&item=problems

这次采用了类似于下列2025年美国数学奥林匹克竞赛评估的方法,只进行了少许调整。

论文链接:https://arxiv.org/abs/2503.21934

招募了两名经验丰富的评委来评估模型提交的作品。

为了避免污染,评分工作在公布IMC 2025题目后立即开始。每位评委独立为题目制定了评分标准,并对匿名提交的作品进行了评分,满分10分。

每个模型都使用相同的评分标准对全部问题进行了单独评估。

解题时长决定着算力和大模型的使用成本。为此,Jasper Dekoninck回答了三个系统各自耗时情况。

由于时间有限,暂时不会对其他模型进行测评,但这些模型也很可能会在这场比赛中取得优异成绩。

新的评估对于真正测试模型的能力至关重要,有网友已经迫不及待想要看到o3-Pro、Claude、Kimi K2在IMC考试中的表现。

除了量化评分,研究人员还从模型的输出中提取了许多定性的观察与见解,帮助更全面地理解各模型在数学推理任务中的表现。

Gemini Deep Think:清晰性最强的证明者

对于数学推理而言,表达清晰不仅是评审者打分的依据,也反映了模型对问题理解的深度。虽然Gemini Best-of-32的很多解答在技术上是正确的,但表达往往混乱,结构不清,缺乏有效的逻辑组织,令人难以跟进其思路。

相比之下,Gemini Agent的逻辑性更好,但它的证明往往过于冗长、密集。这种啰嗦的风格可能源于其「自验证反馈机制」(self-verifying feedback loop),即模型倾向于对每一步骤过度解释。

而Gemini Deep Think的表现则更为出色:它提供的证明语言简练、结构清晰、步骤合理,能够针对每一步安排恰当的详细程度,使读者更容易理解其推理过程。

Gemini Deep Think:展现了真正的原创思维

AI模型常见的做法是依赖「暴力运算」(bashing),即用繁复的代数操作代替数学洞察力。这一点在Gemini Agent和Gemini Best-of-32的解答中表现尤为明显,特别是在第9题上。

而Gemini Deep Think的策略更加优雅与创新:

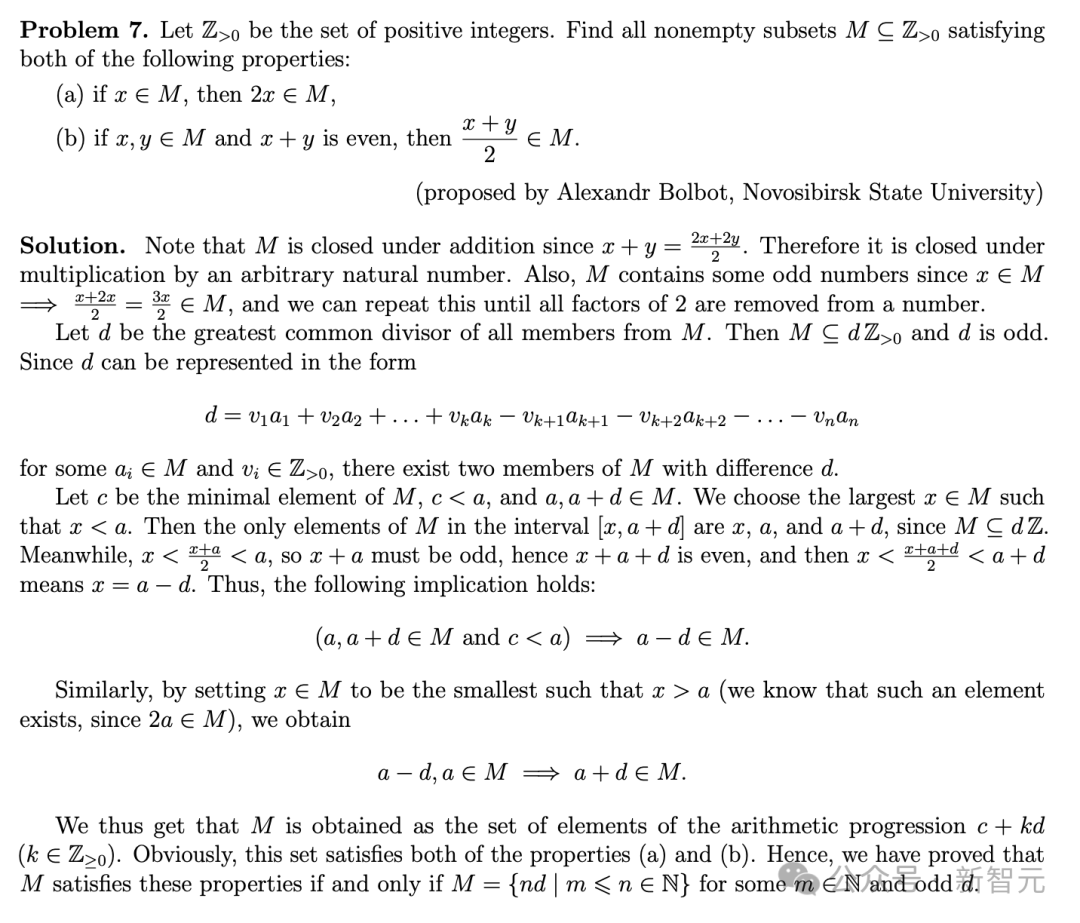

第7题的证明也因其高度的简洁性与美感而脱颖而出,远胜其他模型; 在第9题中,它给出了一个比官方解更为简洁且更具启发性的思路; 在第10题中,它更是运用了更为高级的数学工具,对某个关键变量给出了更强的上界。不过,它也因为跳过了若干推理细节,导致该题只得到了7分(满分10分)。

官方相关解答:https://www.imc-math.org.uk/imc2025/imc2025-day2-solutions.pdf

高阶数学知识的调动能力

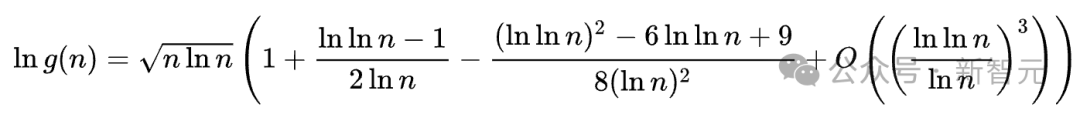

模型在第5题上的表现也值得关注。该题涉及一个函数的不等式证明,虽然题干并未给出函数名称,但实际上是著名的Landau函数。

令人惊喜的是,三个模型都能准确识别出该函数,并调用其已知性质构建完整证明,体现了它们在知识调用方面的深度与准确性。

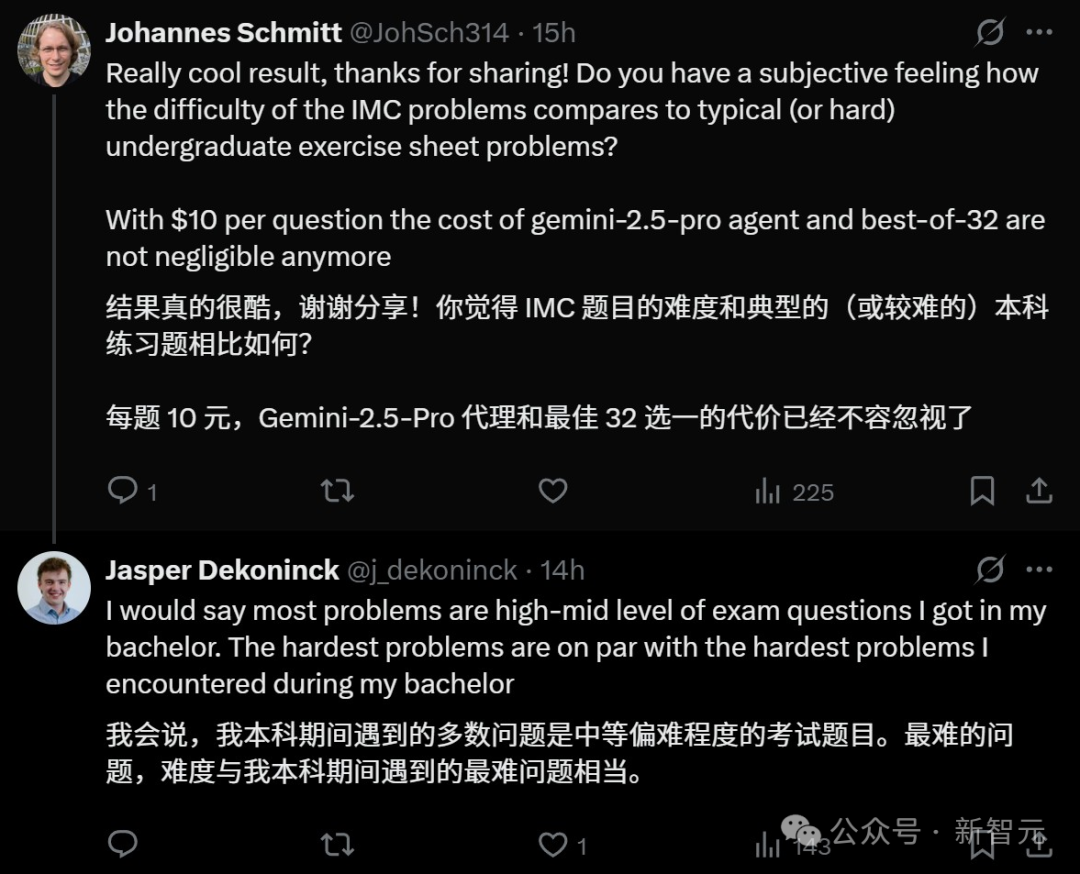

关于IMC题目的难易程度,Jasper Dekoninck认为IMC的题目中最难的问题难度,与本科期间遇到的最难问题相当。

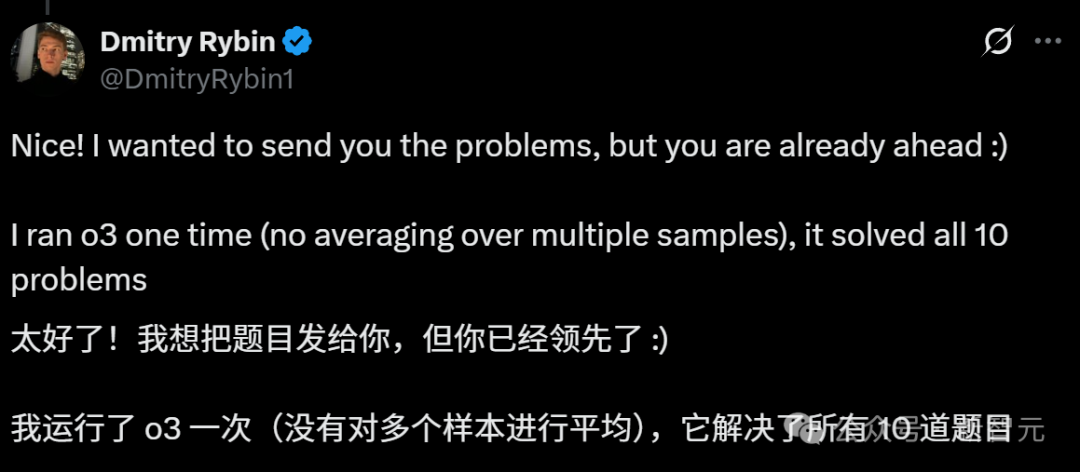

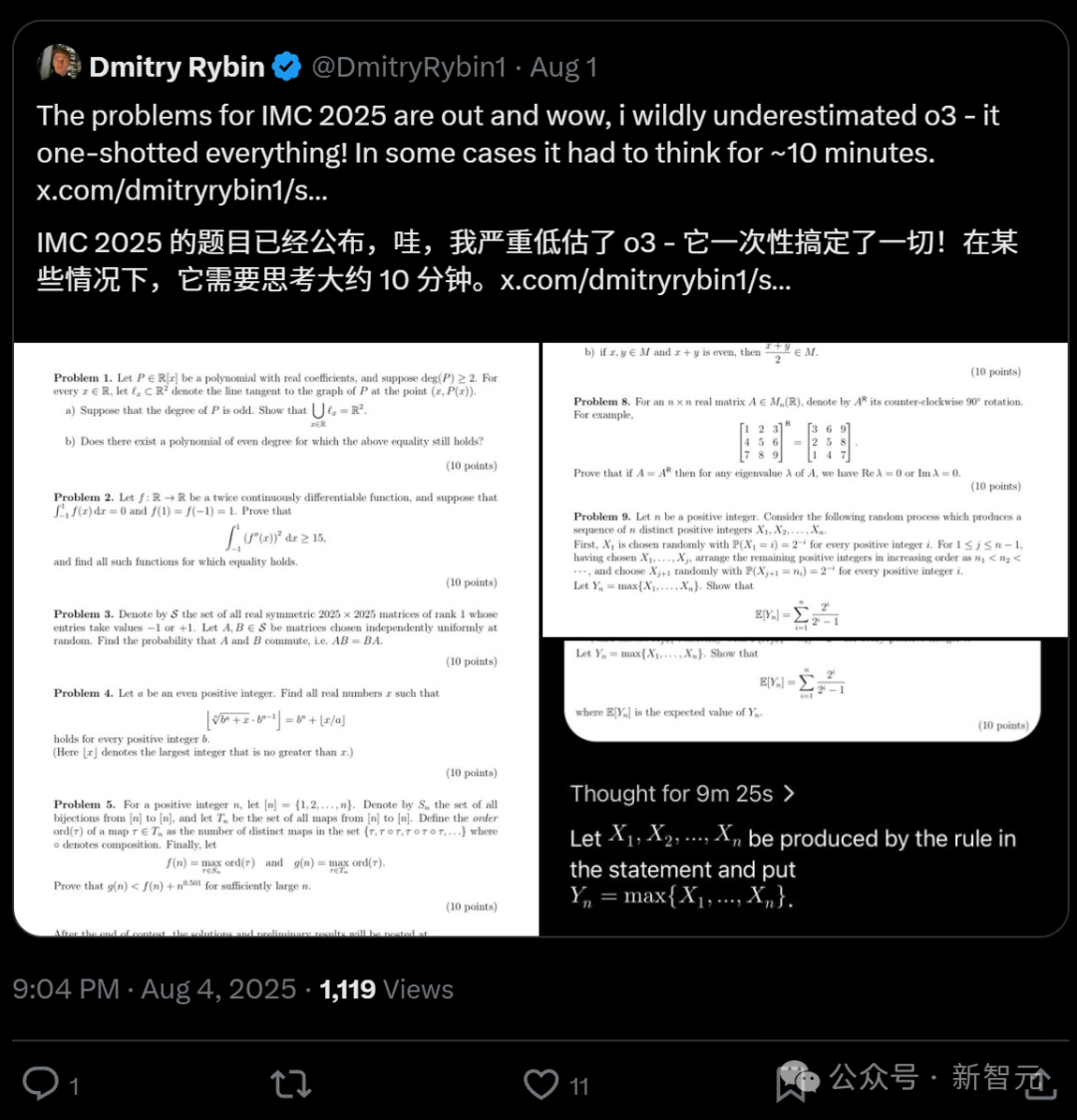

网友Dmitry Rybin表现出了对测试的极大热情:「太好了,本来我想把题目发给你,但你已经做了」。

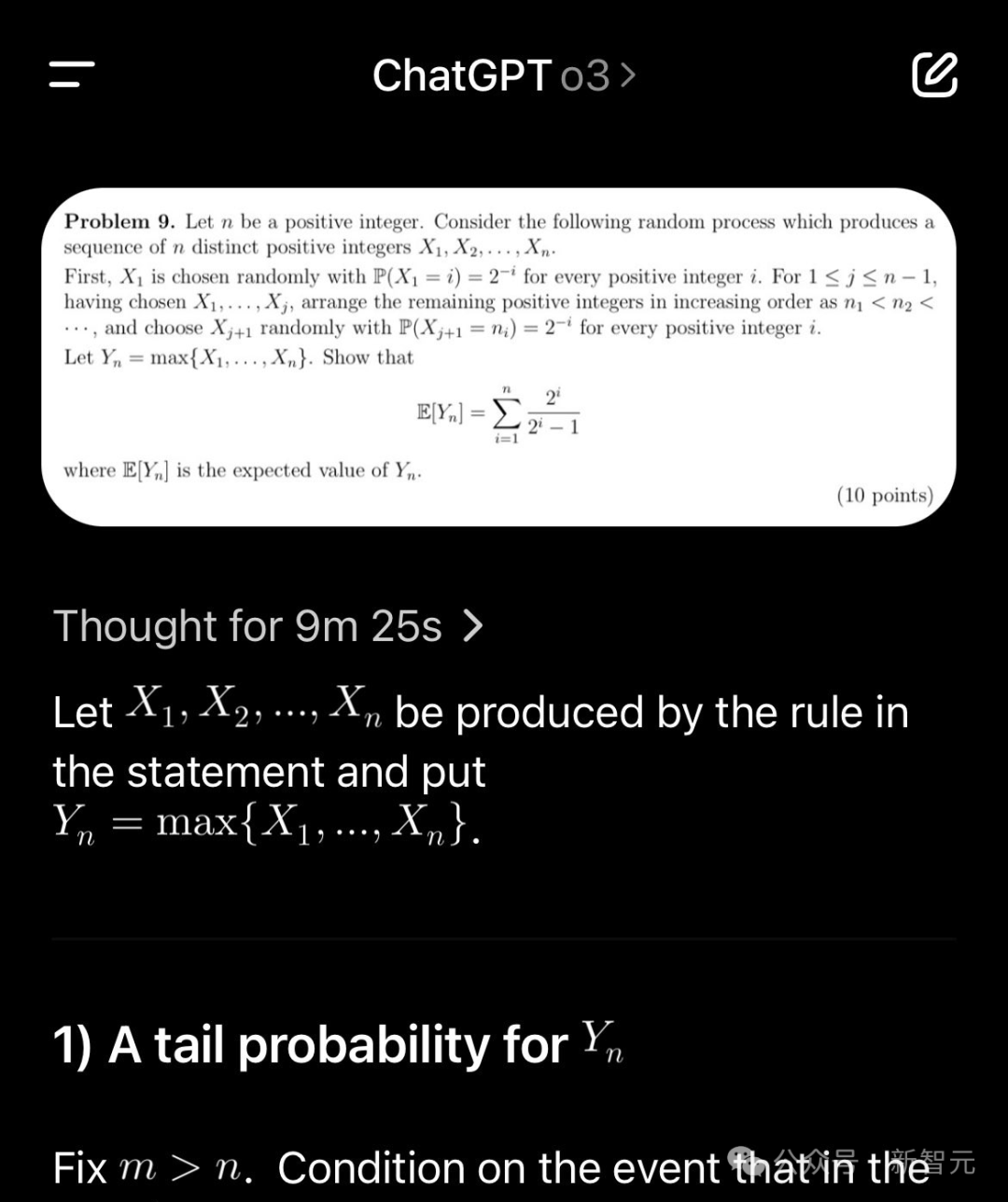

他还用o3测试了IMC2025年全部试题,大约十分钟它就搞定了10道题目。

但网友Jasper Dekoninck认为o3输出的第5题答案似乎有些瑕疵,可能会被扣分。

与IMO相比,IMC题目通常需要更高级的数学知识和形式化技巧。然而,IMO往往更注重创造力和独创性,尤其是在解题方法方面。

连Jasper Dekoninck自己也认为IMC这些更侧重知识的竞赛题目似乎太简单了。

网友Acer对此亦有同感。

他认为目前IMO(国际数学奥林匹克竞赛)、Putnam(普特南数学竞赛,美国大学生数学竞赛)、Miklós Schweitzer(施魏策尔·米克洛什数学竞赛,匈牙利大学生本科数学竞赛)的难度比较适合,但模型仍能解决其中大部分问题。

尽管IMC可能更多依赖数学知识,但AI日益强大的数学推理能力,已经令人无法忽视。

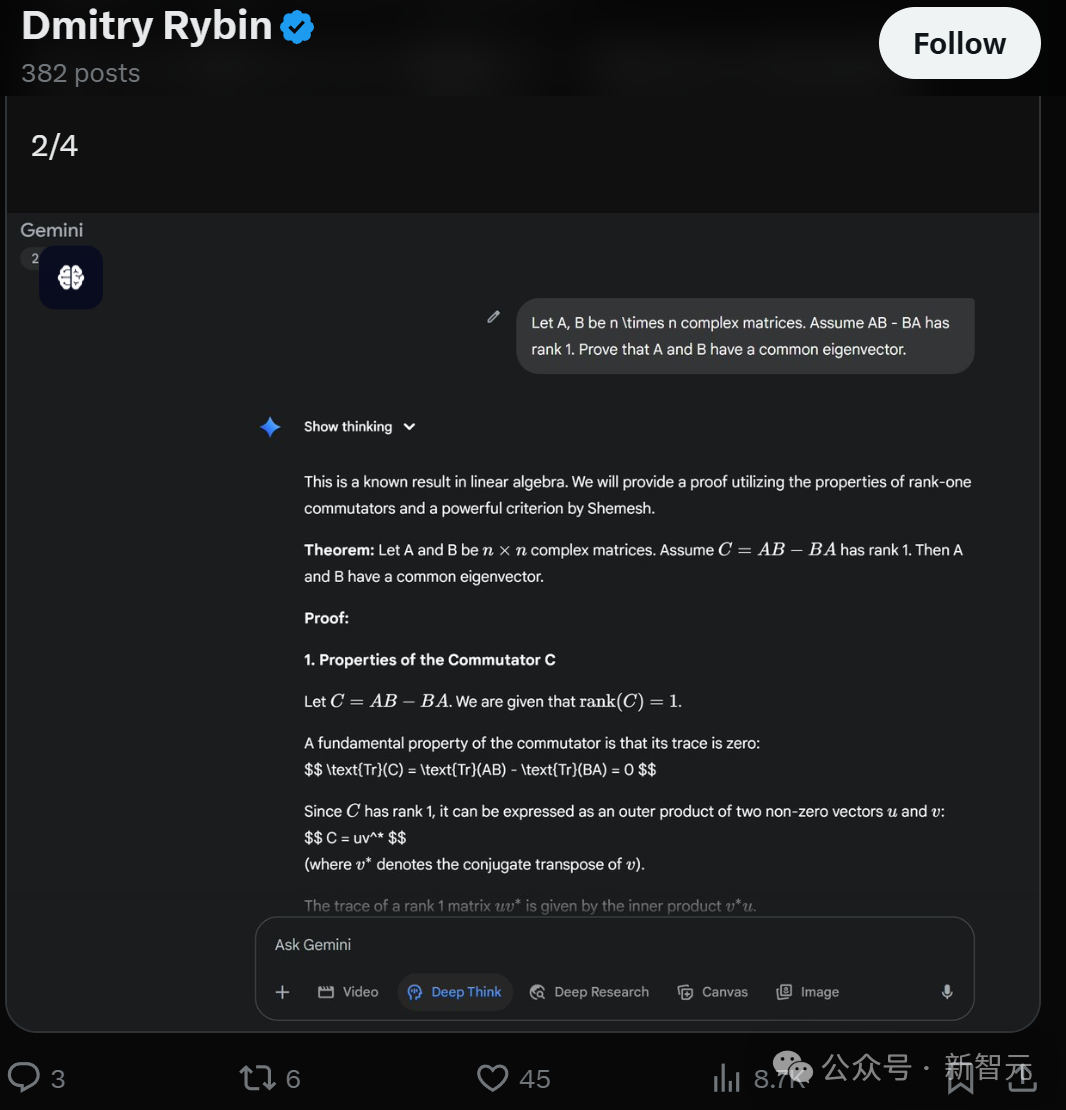

比如,Dmitry Rybin提出了一个困难但已知的线性代数结果:

如果AB - BA的秩为1,那么矩阵A和B有共同的特征向量。

Deep Think 使用Shemesh定理给出了一个Dmitry Rybin以前从未见过的证明。

与数学关系密切的信息学竞赛上,AI表现非常夺目。

在玻利维亚第37届国际信息学奥林匹克竞赛(IOI 2025),ryanbAI在与其他人类选手完全相同的条件下参赛,以第七名的成绩位列总榜。

随着更多AI在国际性数学竞赛中脱颖而出,它们可以挑战越来越难的数学竞赛,甚至可以给出新的证明思路,这些均表明AI在数学推理能力上日益强大。

而且AI相比较人类,在计算和数据处理方面能力更强,也更不容易出错误。网友Jason Lee表示,找到AI的错误非常困难。

参考资料:

https://x.com/j_dekoninck/status/1952335201431937445

https://matharena.ai/imc/

文章来自于微信公众号“新智元”。

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md

【开源免费】graphrag是微软推出的RAG项目,与传统的通过 RAG 方法使用向量相似性作为搜索技术不同,GraphRAG是使用知识图谱在推理复杂信息时大幅提高问答性能。

项目地址:https://github.com/microsoft/graphrag

【开源免费】Dify是最早一批实现RAG,Agent,模型管理等一站式AI开发的工具平台,并且项目方一直持续维护。其中在任务编排方面相对领先对手,可以帮助研发实现像字节扣子那样的功能。

项目地址:https://github.com/langgenius/dify

【开源免费】RAGFlow是和Dify类似的开源项目,该项目在大文件解析方面做的更出色,拓展编排方面相对弱一些。

项目地址:https://github.com/infiniflow/ragflow/tree/main

【开源免费】phidata是一个可以实现将数据转化成向量存储,并通过AI实现RAG功能的项目

项目地址:https://github.com/phidatahq/phidata

【开源免费】TaskingAI 是一个提供RAG,Agent,大模型管理等AI项目开发的工具平台,比LangChain更强大的中间件AI平台工具。

项目地址:https://github.com/TaskingAI/TaskingAI