想象一个虚拟人,他不仅能精准地对上你的口型,还能在你讲到关键点时做出恍然大悟的表情,在你讲述悲伤故事时流露出同情的神态,甚至能根据你的话语逻辑做出有意义的手势。

这不再是科幻电影的场景。8 月底,字节跳动数字人团队推出了 OmniHuman-1.5,提出了一种全新的虚拟人生成框架,让虚拟人真正拥有了「思考」和 「表达」的能力。

数月前 OmniHuman-1 上线时,曾引发国内外热潮。相比前作,1.5 版本有了更多突破,不仅可以根据文字指令让虚拟人在对口型之余做出指定动作、表情,还支持在多人场景中控制发言者以外的角色做出具体动作。据悉,新版本很快也将上线即梦 AI。

传统虚拟人总感觉差了点「灵魂」,动作机械、重复,而 OmniHuman-1.5 首次将诺贝尔奖得主丹尼尔・卡尼曼的「双系统理论」引入 AI,通过一个由多模态大语言模型(MLLM)驱动的「思考大脑」,让虚拟人学会了深思熟虑。

在深入技术细节之前,先用最直观的方式,感受一下这个框架创造出的虚拟人,究竟有何不同:

超越简单的模仿,模型展现了逻辑推理能力。它能准确理解指令,按顺序拿出红蓝药丸,执行复杂的动作意图。

虚拟人精准地根据语音内容规划动作,实现了「先画眼线,再介绍眼影盘」这样的逻辑序列,展现了对内容的理解。

挑战长视频与多人互动。模型不仅能生成稳定的长时间双人对唱,还能驾驭丰富的运镜效果,同时角色的动作、表情和互动极为多样,告别了单调重复。

虚拟人学会了「倾听」。它可以在对话和倾听状态间自如切换,说话时的情绪与内容匹配。

除了高动态场景,还是需要细腻情感表达的独白,模型都能拿捏,展现出了表演张力。

近年来,视频虚拟人技术发展迅猛,从最初的口型合成,进化到了半身乃至全身的动画生成。大家的目标也越来越宏大:创造一个与真人无异,既能理性行动又能真实表达情感的「数字生命」。

然而,尽管现有方法(尤其是基于 Diffusion Transformer 的模型)能够生成与音频同步的流畅视频,但它们更像一个出色的「反应机器」。仔细观察你会发现,这些模型捕捉到的仅仅是音频信号与身体动作之间的浅层、直接关联。结果就是,虚拟人能精准地对上口型,做一些简单的、跟随节奏的摆动,但一旦涉及更复杂的、需要理解对话内容的交互,就立刻「露馅」了。它们的行为缺乏长期规划和逻辑一致性,离真正的「以假乱真」还有很长的路要走。

为什么会这样?研究者们从认知科学中找到了答案。人类的行为被认为由两个系统主导:

显然,要让虚拟人「活」起来,就必须为它装上「系统 2」这个深思熟虑的大脑。因此,本文的核心思路应运而生:利用多模态大语言模型(MLLM)强大的推理能力来显式地模拟「系统 2」的决策过程,并将其与模拟「系统 1」的反应式生成模块相结合。

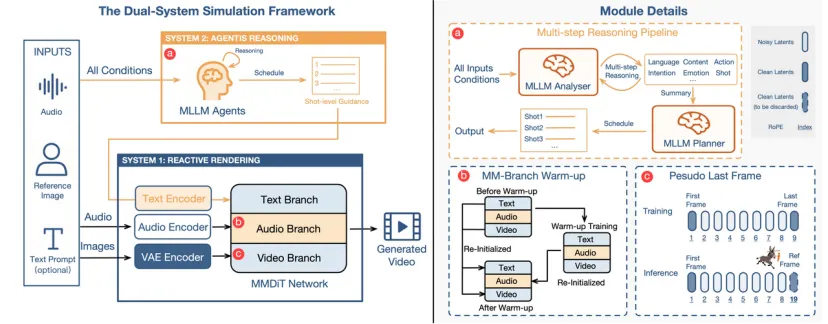

为了实现这一构想,研究者们设计了一个精巧的「双系统模拟框架」。它主要由两部分构成:一个负责规划的「系统 2」大脑,和一个负责渲染的「系统 1」身体。

图注: 框架流程图。左侧为总体流程,展示了「系统 2」如何利用 MLLM 智能体对所有输入(音、图、文)进行推理,生成一个宏观的「行为规划表」(Schedule)。这个规划表随后指导「系统 1」的 MMDiT 网络,后者在其专用的文本、音频和视频分支中融合信息,最终合成视频。右侧是关键模块的细节图。

1. 系统 2:MLLM 智能体进行深思熟虑的规划

这部分是整个框架的「大脑」和「指挥中心」。研究者设计了一个由两个 MLLM 组成的智能体(Agent)推理流程:

通过这种「分析 - 规划」的协作,模型得以生成一个全局一致、逻辑连贯的行动计划,为虚拟人的行为提供了「顶层设计」。

2. 系统 1:多模态融合网络进行反应式渲染

有了「大脑」的规划,还需要一个强大的「身体」来执行。这部分由一个特殊设计的多模态扩散模型(MMDiT)承担,它负责将「系统 2」的高层文本规划与「系统 1」的底层音频信号(用于口型同步等)完美融合,生成最终视频。

然而,将文本、音频、参考图这几种完全不同的信息(模态)塞进一个模型里,极易引发「模态冲突」,导致模型顾此失彼。为此,研究者提出了两大核心技术创新来解决这个难题。

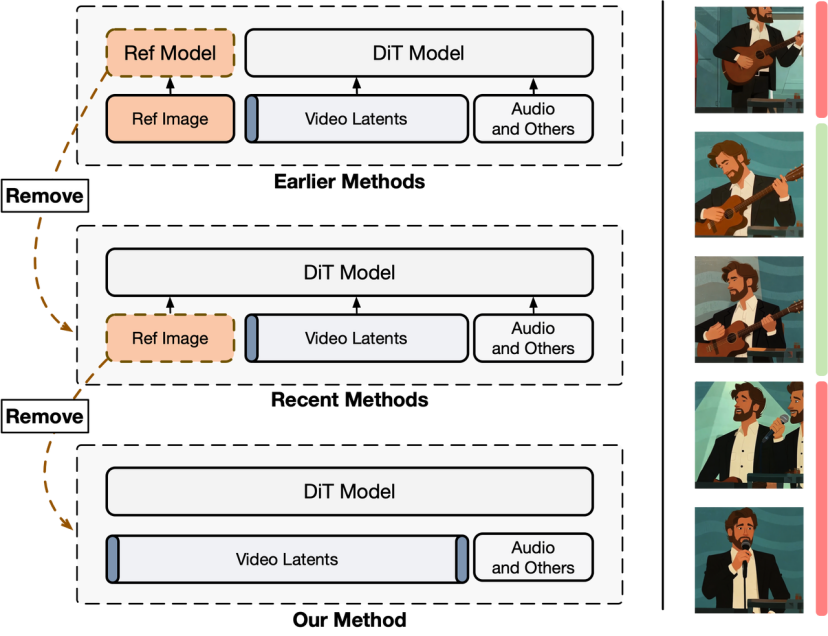

1. 重新思考身份维持:「伪最终帧」的设计

传统方法为了让虚拟人保持固定的身份(长相),通常会在模型中输入一张参考图。但研究者敏锐地发现,这会带来一个严重的问题:模型会错误地学习到「生成的视频里必须出现和参考图一模一样的画面」,这极大地限制了角色的动态范围,导致动作僵硬。

图注: 该图解释了为什么需要 “伪最终帧”。右侧揭示了核心困境:当参考图与目标片段内容高度相关时(绿色区域),会限制动作多样性;而当二者不相关时(红色区域),又会导致生成内容与参考图出现预期外的偏差。

为此,他们提出了一个名为伪最终帧(Pseudo Last Frame)的解决方案。

这个「伪最终帧」就像一根「挂在驴子眼前的胡萝卜」:它引导着模型朝参考图的身份特征生成,但从不强迫模型必须一模一样地复现它。实验证明,这种方法完美地在「身份一致性」和「动作多样性」之间取得了平衡。

2. 解决模态冲突:「对称融合」与「两阶段预热」

为了让文本(系统 2 规划)和音频(系统 1 信号)更好地协作,研究者为音频信号也设计了一个独立的、与视频和文本分支结构对称的「音频分支」。这三个分支在模型的每一层都通过共享的自注意力机制进行深度融合,确保信息充分对齐。

但新的问题来了:音频信号在时间上非常密集,模型在联合训练时会偷懒,倾向于只依赖音频来做所有预测,从而忽略了文本提供的高层语义指导。这就是「模态冲突」。

研究者的解决方案是「两阶段预热(Two-stage Warm-up)」训练策略:

通过这种方式,每个分支都带着自己最擅长的「先验知识」进入最终的训练,从而有效避免了模态冲突,让「大脑」的指令和「身体」的反应都能得到忠实执行。

除了直观的效果展示,硬核的量化数据和直接的 SOTA 对比更能说明问题。

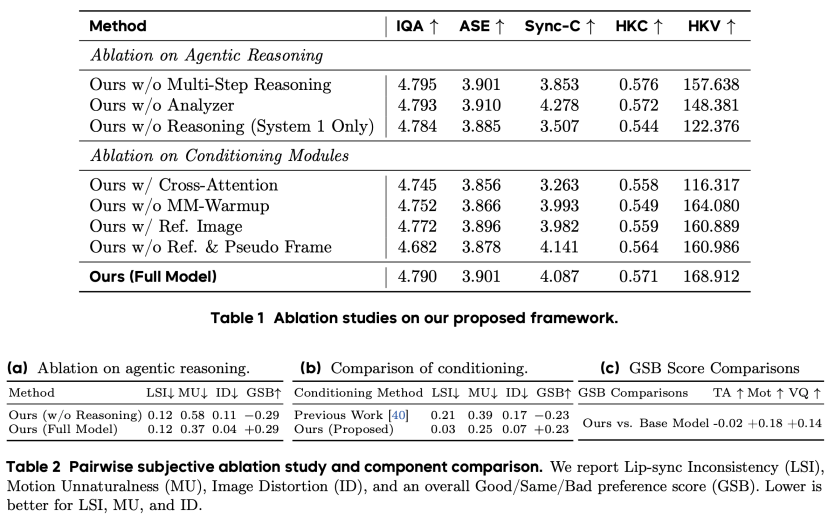

1.Agent 推理 + MMDiT 架构的有效性验证

图注: 消融实验(Ablation Study)的结果清晰地证明了框架中两大核心设计的有效性。从数据中可以看到,无论是负责 “思考” 的 Agent 推理模块,还是负责 “执行” 的 MMDiT 架构,都对最终的生成质量,尤其是在逻辑性和语义连贯性上,做出了不可或缺的贡献。

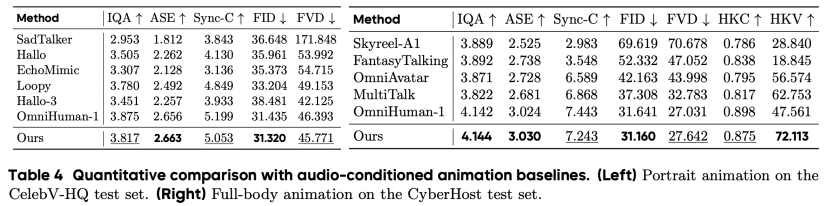

2. 全面超越 SOTA 模型

图注: 在与当前最先进(SOTA)的多个公开模型进行的全方位对比中,本方法在所有关键指标上都取得了显著优势或极具竞争力的表现。

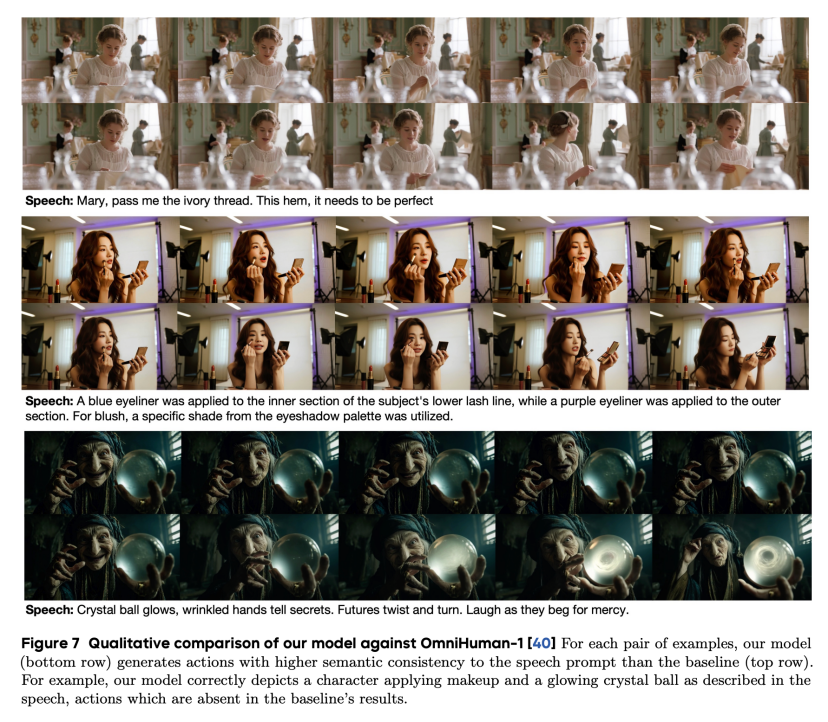

图注: 这张可视化对比图直观地展示了「思考能力」的价值。相比于没有推理能力加持、只会做简单说话和重复性动作的模型方案,OmniHuman-1.5 显示了更高的动态范围和更有逻辑性的动作效果,实现了从「动嘴」到 「表达」的飞跃。

Omnihuman-1.5 为虚拟人领域提供了一个全新的、极具启发性的视角。它通过借鉴认知科学的「双系统理论」,巧妙地利用 MLLM 作为「系统 2」的推理核心,并设计了一套创新的多模态融合架构来解决关键的技术瓶颈,最终实现了虚拟人行为从「反应式」到「思考式」的飞跃。

目前即梦 AI 视频生成中对口型能力的大师模式是基于 Omnihuaman-1.0,依靠一张图 + 一段音频就能生成流畅自然的虚拟人视频。很快 OmniHuman-1.5 也将上线即梦 AI。相比 1.0 版本,Omnihuaman-1.5 不仅可以生成更加真实、灵动的虚拟人,也为人机交互、影视制作、虚拟社交等领域带来新的可能。

文章来自于微信公众号“机器之心”。

【开源免费】Browser-use 是一个用户AI代理直接可以控制浏览器的工具。它能够让AI 自动执行浏览器中的各种任务,如比较价格、添加购物车、回复各种社交媒体等。

项目地址:https://github.com/browser-use/browser-use

【开源免费】Fay开源数字人框架是一个AI数字人项目,该项目可以帮你实现“线上线下的数字人销售员”,

“一个人机交互的数字人助理”或者是一个一个可以自主决策、主动联系管理员的智能体数字人。

项目地址:https://github.com/xszyou/Fay

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner

【开源免费】VideoChat是一个开源数字人实时对话,该项目支持支持语音输入和实时对话,数字人形象可自定义等功能,首次对话延迟低至3s。

项目地址:https://github.com/Henry-23/VideoChat

在线体验:https://www.modelscope.cn/studios/AI-ModelScope/video_chat

【开源免费】Streamer-Sales 销冠是一个AI直播卖货大模型。该模型具备AI生成直播文案,生成数字人形象进行直播,并通过RAG技术对现有数据进行寻找后实时回答用户问题等AI直播卖货的所有功能。

项目地址:https://github.com/PeterH0323/Streamer-Sales