医生还没开口,AI已经替你决定好了——

根据模型预测,该患者倾向于放弃抢救。

这不是电影的剧本,而是美国华盛顿大学正在进行的一项真实研究。

当患者陷入昏迷、无法发声的时候,AI将替他向医生传达是否接受抢救的医院。

实验中,研究人员将其称之为「AI代理人」(AI surrogates)。

这听上去像一场科技的人道主义实验:在生死交界处,让算法解读人类的意愿。

可问题是AI真懂吗?还是它仅仅理解那些与患者相似的数据?

在这个系统的底层,算法并没有「聆听灵魂」,它只是浏览历史病历、人口学特征、医疗选择模式,然后推断:与你相似的人通常如何抉择。

于是,人类的意愿被模型化,个体生命的价值被平均化。

当AI开始预测生死,它做出的已不再是技术判断,反而成了社会偏见的延伸。

医生按下Enter键,人生被AI判了生死

在生死关头,患者失去语言与意识,往往需要靠家属、代理人乃至医师替其做出关键的「是否继续抢救」决定。

但是,现实中我们真的知道患者想要什么吗?这个问题仍然困扰着医疗体系。

就在此时,UW Medicine创伤科研究员Muhammad Aurangzeb Ahmad提出的「AI代理人」(AI surrogate)概念应运而生。

Ahmad所在的创伤科团队,正尝试利用「以往伤情、病史、既往医疗选择、人口学数据」为基本资料,通过机器学习模型预测患者在失去表达能力时如果能选择,会怎么做。

这种研究的逻辑内核,是当患者不能自己说话时,以算法为参照,协助医生、伦理委员会、家属判断「这位患者如果清醒了,他/她会同意继续抢救吗?」

研究团队的目标之一,是实现大约三分之二的预测正确率,并且为模型的运作模拟了流程。

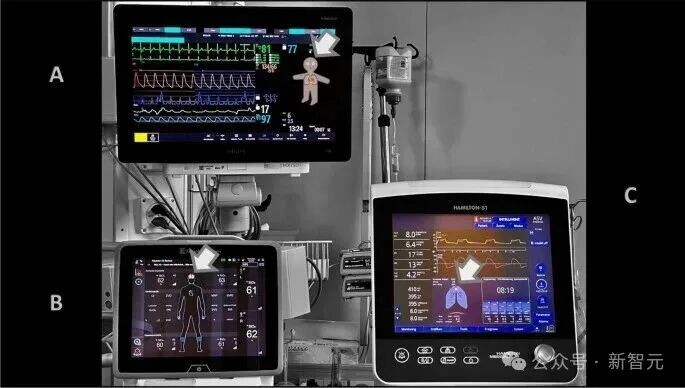

首先,收集患者的伤情严重程度、医学历史、人口统计特征。

之后,将这些变量输入机器学习模型,回顾性地观察模型对历史病例的预测准确度。

团队对模型的未来有着长远的打算:让患者一生与系统互动,记录医患对话、家属短信、生活偏好等文本数据,随着时间不断更新患者的数字档案。

不过,目前该系统仍是一个概念,尚未实际用于病人交互,也未进入决策流程。

正如UW Medicine发言人所说:

在推出前,需要完成多阶段审核。

「让算法帮你决定是否被救」不再是科幻话题,而正在成为医学伦理与AI交叉的新实验场。

算法的盲区:AI预测的不是意愿,而是偏见

「患者的选择」听起来像是个人性化的表达,但在机器学习里,它会被简化成一串概率。

在华盛顿大学的AI代理人项目中,这个概率是靠历史数据喂出来的:谁被抢救过、谁签署过放弃治疗指令、谁在哪种情况下「选择死亡」。

而问题也正出在这里。在医学数据的世界里,没有真正的「中立样本」。

老年人、少数族裔、低收入群体,在既有数据中往往出现更高的放弃治疗比例。

算法从这些模式里学到的「意愿」,其实是社会结构的投影。

医生Emily Moin在接受采访时就指出:

这些决策是动态、情境性的。若你让AI去预测一个昏迷者的意愿,它依赖的只是「方便的真值」,并非真实的地面现实。

她提醒道,AI代理人可能最先被用于「没有家属、无法沟通」的患者——而这样的人群永远无法验证真相。

这意味着,模型无法被校正,也无法证明它有没有偏见。

更危险的是,医院和医生在高压环境下很可能过度信任模型输出。

久而久之,算法就不再只是参考,而成为一种默认答案。

这种「技术性放弃」,在医疗体系中极具诱惑。AI代理人看似在解放医生的心理负担,实际上却在让系统更高效地复制不平等。

研究者Ahmad自己也承认,模型要想真正做到「公平」,不能只看预测结果,而要考虑「患者的道德宇宙」:

两个临床情况相似的患者,一个以宗教为核心,另一个以个人意志为导向。如果算法以相同方式对待他们,就是一种道德抹除。

这场技术实验,表面在探索如何更懂患者,但在底层逻辑里,它其实在问:谁有资格被救,谁又可以被默认放弃。

当人类依赖AI,偏见才真正开始生长

AI代理人并不直接篡夺生死权,它靠的是一种更隐秘的力量——信任。

医生、家属、伦理委员会都在试图逃避那个最难的问题:「该不该救?」而AI正好填补了这份心理真空。

在医院的日常节奏里,医生要处理几十个危重病人,每一次沟通都要耗费巨大的情绪与时间。

AI模型的出现,让一切变得「高效」——它能立刻输出一个判断,一个结论,一种确定感。

于是,那行「模型预测:患者倾向放弃复苏」的文字,开始变成一块伦理的挡箭牌。

Emily Moin说:

如果家属拒绝对话、医生时间不够,所有人都可能默许去看AI的结论

这种默许正是偏见流传的起点。算法的结论看似客观,并因其冷静、快速、无情绪而更具说服力。

慢慢的,人们不再争论、不再怀疑、也不再负责,AI就成了那个最权威、也最无法追责的决策者。

伦理学者Robert Truog警告:

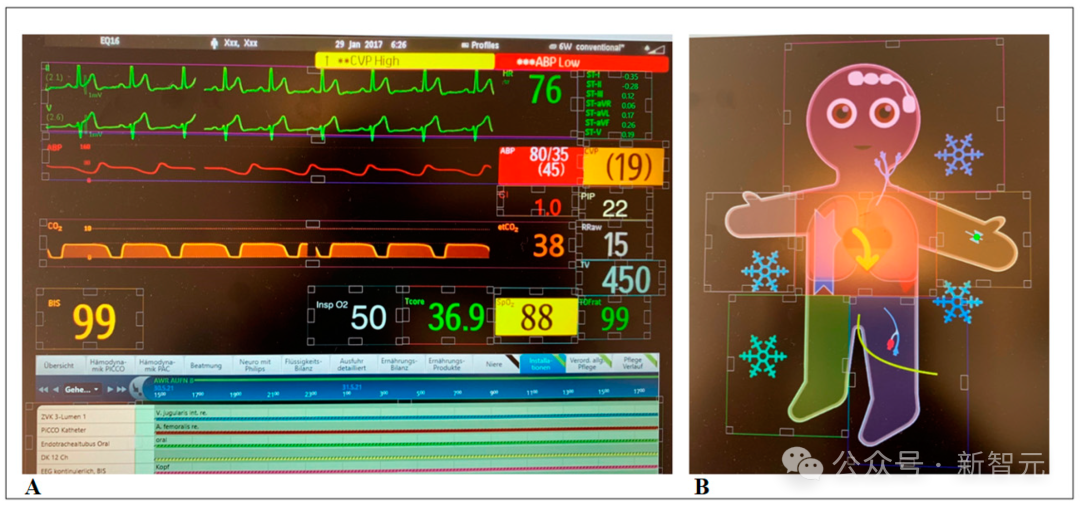

在现实世界里,CPR并不是一个二元问题——几乎所有情况的答案都要看情境。

但AI无法理解「情境」,它只知道「YES」或「NO」。

当医院依赖这种二元逻辑时,灰色地带被挤压,模糊性被视为错误,而确定性被误认为公正。

这就是偏见的第二次生成:第一次发生在算法学习数据时;第二次发生在人们决定相信算法时。

最终,医生得以卸下心理负担,医院获得效率,社会得到一种假象的理性。

代价是,真正的「意愿」被悄悄掩藏在模型里。

人的价值,被写进算法

AI代理人的危险,并不只在于预测错了谁的意愿,而在于——它正在决定什么样的生命更「值得」被拯救。

Ahmad在即将发表的论文中写道:

AI代理人的公平性,不仅是结果平等,更是对患者世界观、宗教、家庭关系的忠实呈现。

他举了一个极具争议的例子:

一名怀孕女性,旧记录显示她曾勾选「不愿意被接上呼吸机」;但如果她后来成为坚守「生命神圣」信念的宗教信徒,那段旧数据就可能被AI误读成她「仍然想被拔管」。

人类代理人或许会替她辩护,而AI不会。

因为在算法的世界里,没有悔悟与改变,有的只是一致性。

Ahmad称,这种一视同仁反而是一种「道德抹除」。

两个临床情况相似的患者,一个以宗教为核心,另一个以个人意志为导向。如果算法以相同方式对待他们,就是一种道德抹除。

那意味着,即便AI看似公平,它也可能在无声地抹去差异。而差异,正是人之为人的起点。

更深层的问题在于:算法的道德水平是谁决定的?是工程师写进去的?是数据统计出来的?还是社会共识默认的?

当AI开始替人发声,它其实在模仿某种特定文化的声音:可能是西方的个人主义、也可能是医疗体系的效率逻辑。

医学伦理学的系统性综述早已指出:

AI若被用于临床伦理决策,包括代理决策,可能提升预测准确性,但同样可能复制既有偏见与不平等。

于是,那些无法被数字化的价值——宗教信仰、家庭伦理、文化差异就被安静地排除在模型之外。

AI看似在预测人的意愿,实则在不断重构「意愿」的定义。

Ahmad在论文结尾写了一句耐人寻味的话:

最公正的AI代理人,不是那个最确定的,而是那个会犹豫、会邀请人类重新讨论的系统。

也许这才是所有讨论的起点——当AI开始学着替人发声,我们更需要重新学会倾听。

在AI代理人的讨论里,人类最常说的一句话是: 「我们只是想让决策更科学一点。」

但科学从来不等于中立。当算法开始学习谁想活、谁想死,它学到的从来不是人的意志,而是社会的态度。

也许真正该被质疑的,从来不是AI能不能预测死亡意愿,而是我们为什么希望有人替我们做这个决定。

AI不会替人赎罪。它不会安慰,也不会承担后果。它只是把人类逃避的那部分——责任、模糊、犹豫整齐地收纳成数据输出。

当医生按下Enter键,当家属点下确认,那一瞬间被释放的,也许不是患者,而是我们自己。

参考资料:

https://arstechnica.com/features/2025/10/should-an-ai-copy-of-you-help-decide-if-you-live-or-die/

文章来自于微信公众号 “新智元”,作者 “新智元”

【开源免费】OWL是一个完全开源免费的通用智能体项目。它可以远程开Ubuntu容器、自动挂载数据、做规划、执行任务,堪称「云端超级打工人」而且做到了开源界GAIA性能天花板,达到了57.7%,超越Huggingface 提出的Open Deep Research 55.15%的表现。

项目地址:GitHub:https://github.com/camel-ai/owl

【开源免费】Browser-use 是一个用户AI代理直接可以控制浏览器的工具。它能够让AI 自动执行浏览器中的各种任务,如比较价格、添加购物车、回复各种社交媒体等。

项目地址:https://github.com/browser-use/browser-use