在 3D 视觉领域,如何从二维图像快速、精准地恢复三维世界,一直是计算机视觉与计算机图形学最核心的问题之一。从早期的 Structure-from-Motion (SfM) 到 Neural Radiance Fields (NeRF),再到 3D Gaussian Splatting (3DGS),技术的演进让我们离实时、通用的 3D 理解越来越近。

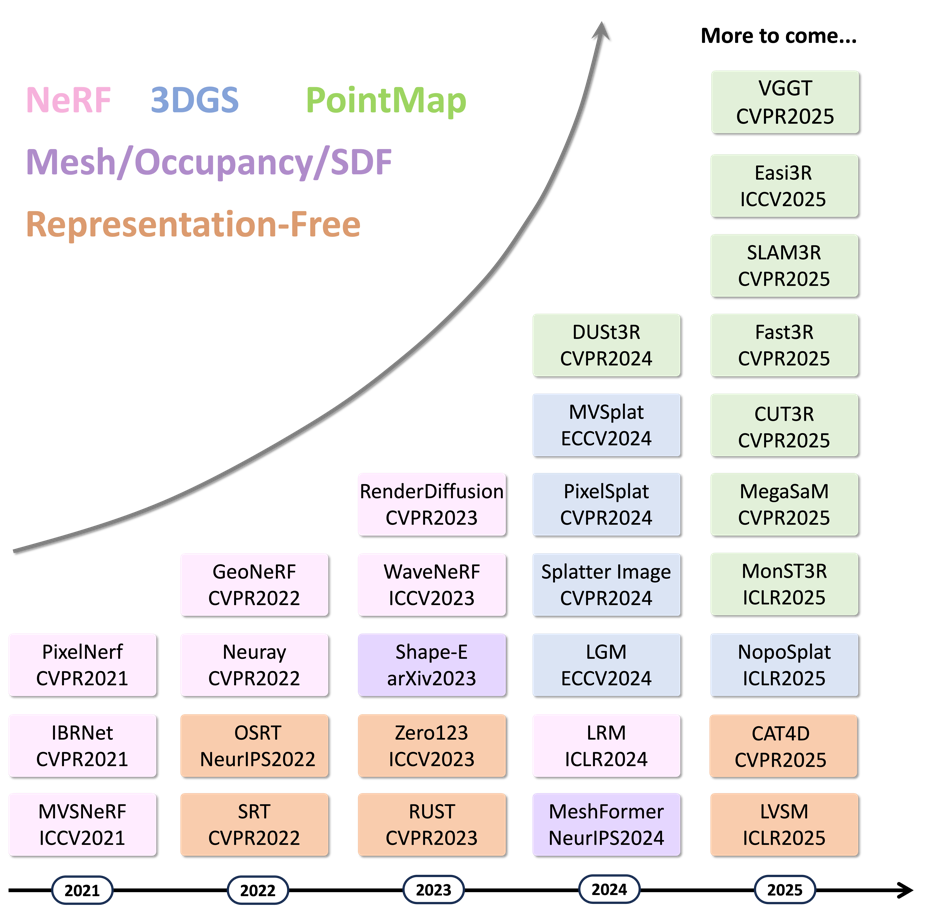

然而,以往的方法往往依赖于每个场景的反复优化(per-scene optimization),既慢又缺乏泛化能力。在 AI 驱动的新时代,一个全新的范式正在崛起 —— Feed-Forward 3D。

这篇由 NTU、Caltech、Westlake、UCSD、Oxford、Harvard、MIT 等 12 所机构联合撰写的综述论文,主要总结了过去五年(2021–2025)间涌现的数百项创新工作,首次建立了完整的 Feed-Forward 3D 方法谱系与时间线。

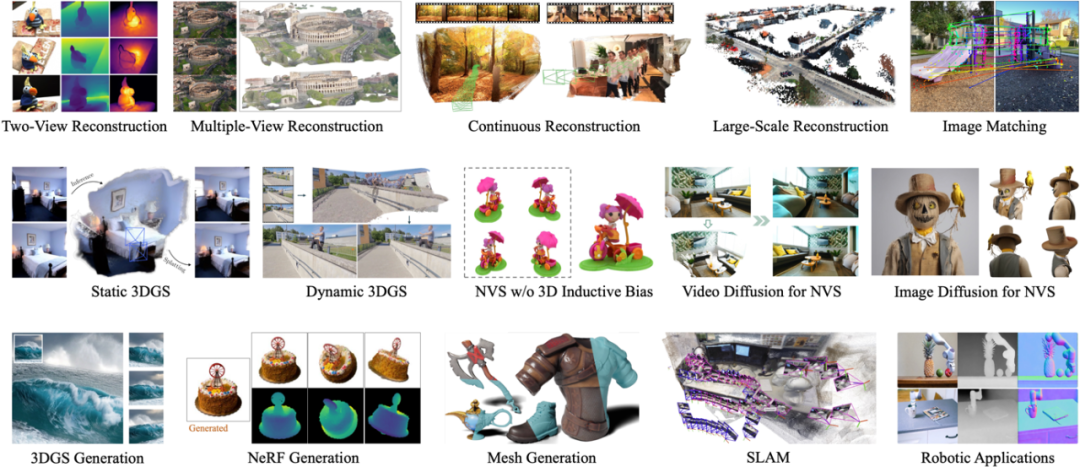

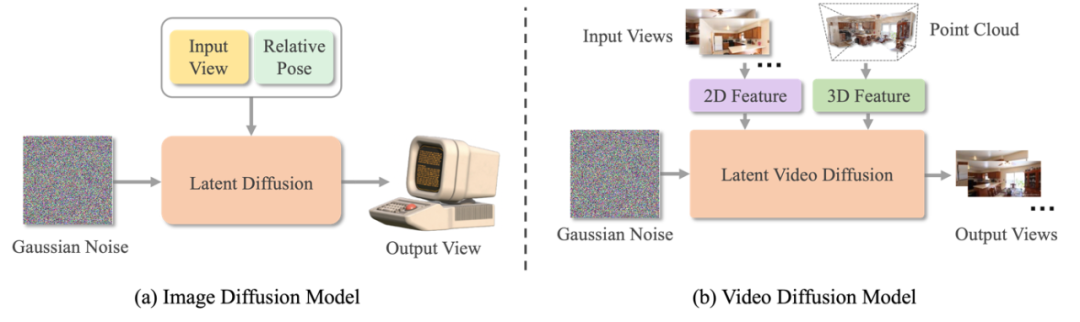

综述将所有 Feed-Forward 3D 方法划分为五类主流架构,每一类都推动了该领域的关键进展:

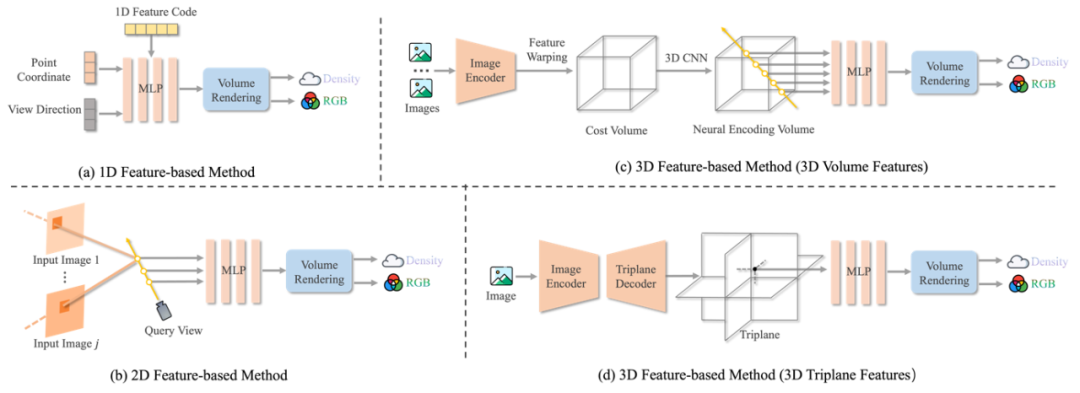

NeRF-based Models

Neural Radiance Fields (NeRF) 提出了体积渲染的可微分框架,但其「每个场景都要优化」的缺点导致效率低下。自 PixelNeRF [CVPR ’21] 起,研究者们开始探索「条件式 NeRF」,让网络直接预测辐射场。这一方向发展出多个分支:

PointMap Models

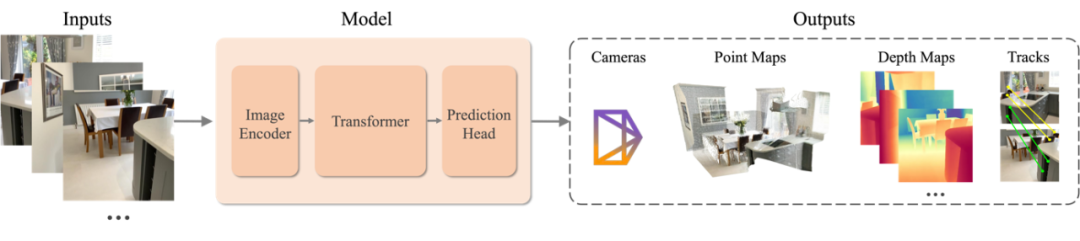

这一分支由 DUSt3R (CVPR ’24) 引领,直接在 Transformer 中预测像素对齐的 3D 点云(pointmap),无需相机姿态输入。后续工作 MASt3R、Fast3R、CUT3R、SLAM3R、VGGT 等相继提出更高效的多视整合、长序列记忆机制,以及大场景处理能力等。

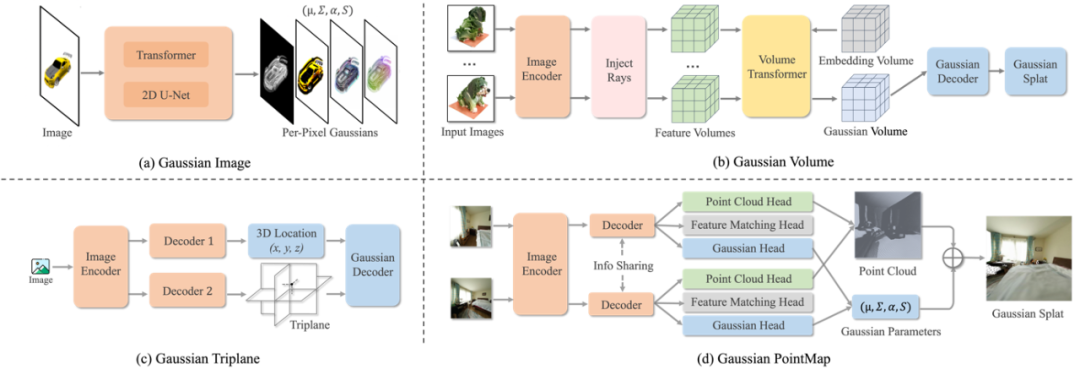

3D Gaussian Splatting (3DGS)

3DGS 是近年来最具突破性的表示之一,将三维场景表示为高斯点云,兼顾了体积渲染的质量与光栅化的速度。然而原始 3DGS 仍需优化。Feed-Forward 研究者通过引入神经预测器,实现了「直接输出高斯参数」的能力,主要方法包括:

Mesh / Occupancy / SDF Models

这一类方法延续了传统几何建模思路,并与 Transformer 与 Diffusion 模型结合:

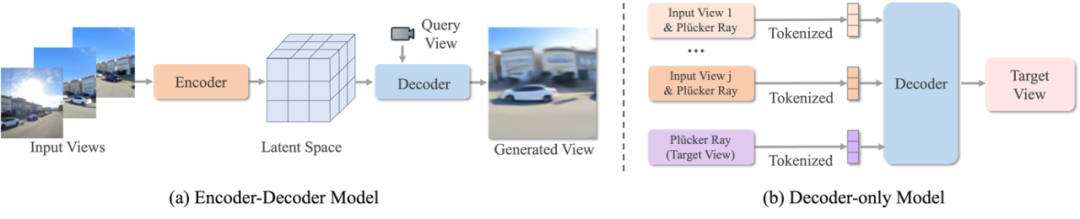

3D-Free Models

这类方法不再依赖显式三维表示,而是直接学习从多视图到新视角的映射。

论文系统总结了 Feed-Forward 模型在多个方向的应用:

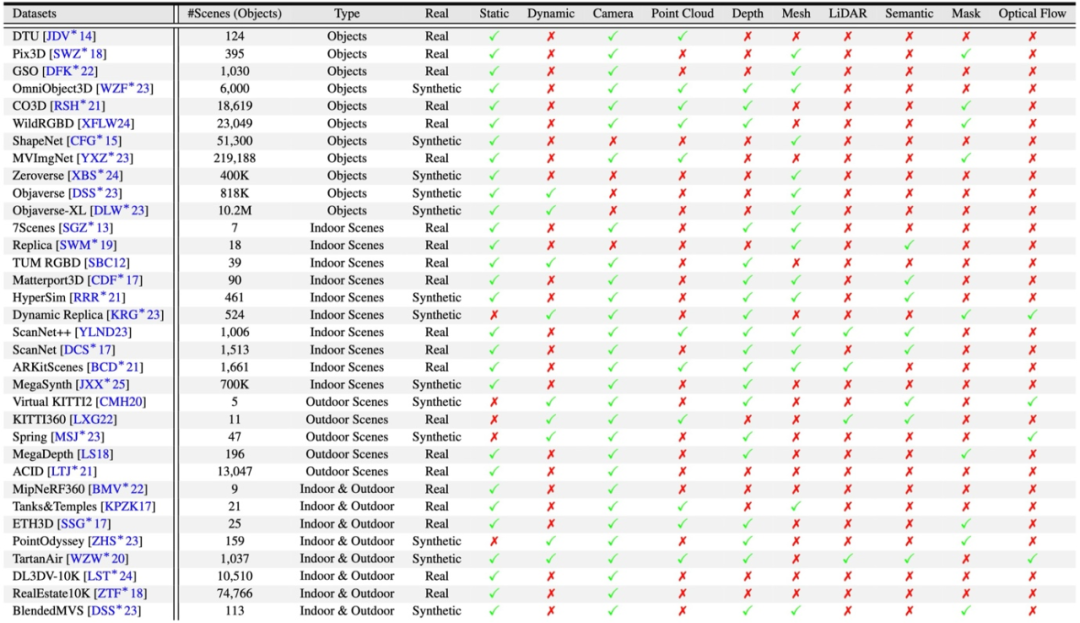

论文收录了超过 30 个常用 3D 数据集(见第 13 页表 1),涵盖对象级、室内、室外、静态与动态场景,标注模态包括 RGB、深度、LiDAR、语义与光流等。

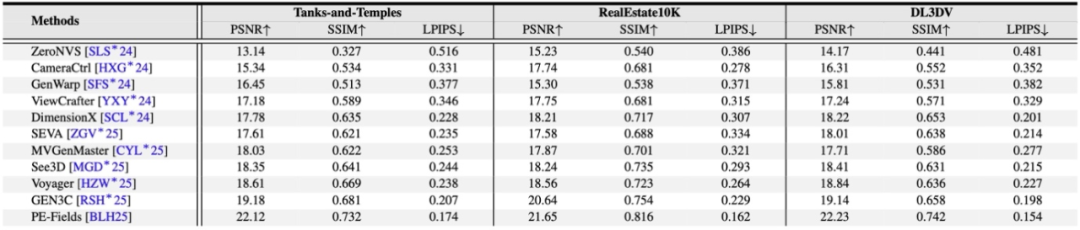

同时总结了 PSNR / SSIM / LPIPS(图像质量),Chamfer Distance(几何精度),AUC / RTE / RRA(相机姿态)等标准指标体系,为未来的模型比较提供统一基线。

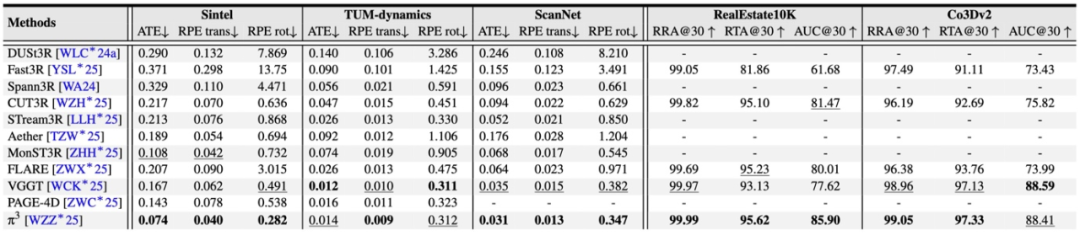

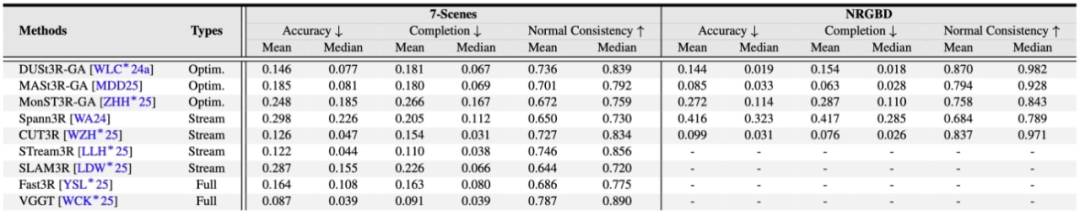

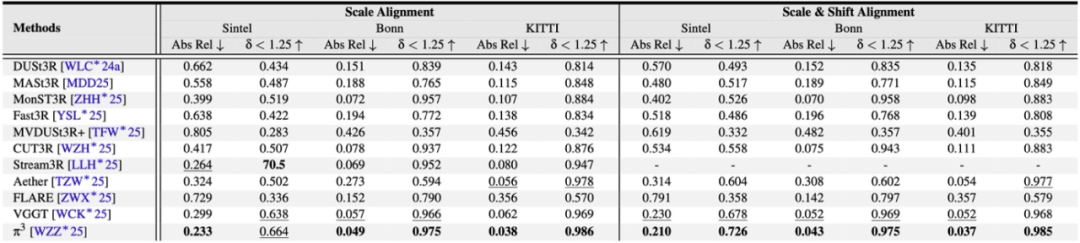

根据 Table 2–5 的结果,本综述对多项任务进行了系统对比:

论文在第 5 章提出四大开放问题:

未来方向包括:Diffusion Transformers 与长程注意力结构;可扩展的 4D 记忆机制;多模态大规模数据集构建(RGB + Depth + LiDAR + 语义);同时具有生成和重建能力的 Feed-Forward 模型。

文章来自于“机器之心”,作者 “机器之心”。

【开源免费】Fay开源数字人框架是一个AI数字人项目,该项目可以帮你实现“线上线下的数字人销售员”,

“一个人机交互的数字人助理”或者是一个一个可以自主决策、主动联系管理员的智能体数字人。

项目地址:https://github.com/xszyou/Fay

【开源免费】VideoChat是一个开源数字人实时对话,该项目支持支持语音输入和实时对话,数字人形象可自定义等功能,首次对话延迟低至3s。

项目地址:https://github.com/Henry-23/VideoChat

在线体验:https://www.modelscope.cn/studios/AI-ModelScope/video_chat

【开源免费】Streamer-Sales 销冠是一个AI直播卖货大模型。该模型具备AI生成直播文案,生成数字人形象进行直播,并通过RAG技术对现有数据进行寻找后实时回答用户问题等AI直播卖货的所有功能。

项目地址:https://github.com/PeterH0323/Streamer-Sales