如果说「摩尔定律」认为计算能力每18个月翻倍,如今大模型推理成本的下降速度,已远超「摩尔定律」关于计算能力迭代速度的预测。

这并非只是芯片性能提升之功,更重要的是来自推理系统的自身进化。而加速这一进化的,源自一个在DistServe系统中首次提出并实践的「解耦推理」理念。

该系统由加州大学圣地亚哥分校的「Hao AI Lab」于2024年3月推出,并提出了一个简单而大胆的设想:

将大模型的推理过程拆分为「预填充」和「解码」两个阶段,并让它们分别在独立的计算资源池中进行伸缩与调度。

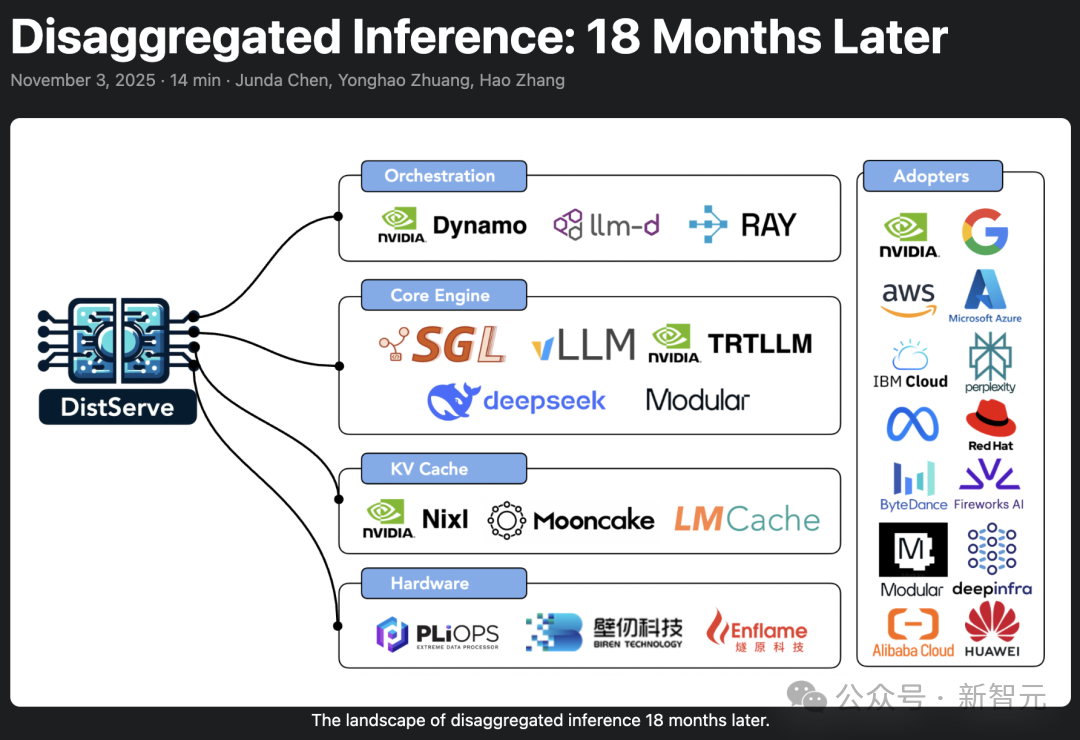

如今,这种解耦推理架构已被NVIDIA、llm-d、vLLM、MoonCake等主流大模型推理框架采用,并开始在大规模、真实推理场景中发挥强大力量。

推出DistServe系统的「Hao AI Lab」,由加州大学圣地亚哥分校助理教授Hao Zhang领导,他也是2025年谷歌机器学习与系统青年教师奖的获得者。

加州大学圣地亚哥分校助理教授Hao Zhang

「Hao AI Lab」团队,2025年还获得了NVIDIA赠送的DGX B200系统,用于强化AI研究基础设施。

「Hao AI Lab」团队获得NVIDIA赠送的DGX B200系统

Hao Zhang团队以「解耦推理」的最初设计者身份,详细回顾了「预填充-解码」解耦架构(prefill-decode disaggregation)如何从研究概念走向生产系统,以及在大模型推理持续扩展的背景下,解耦推理又将如何演进。

从同址部署到解耦推理

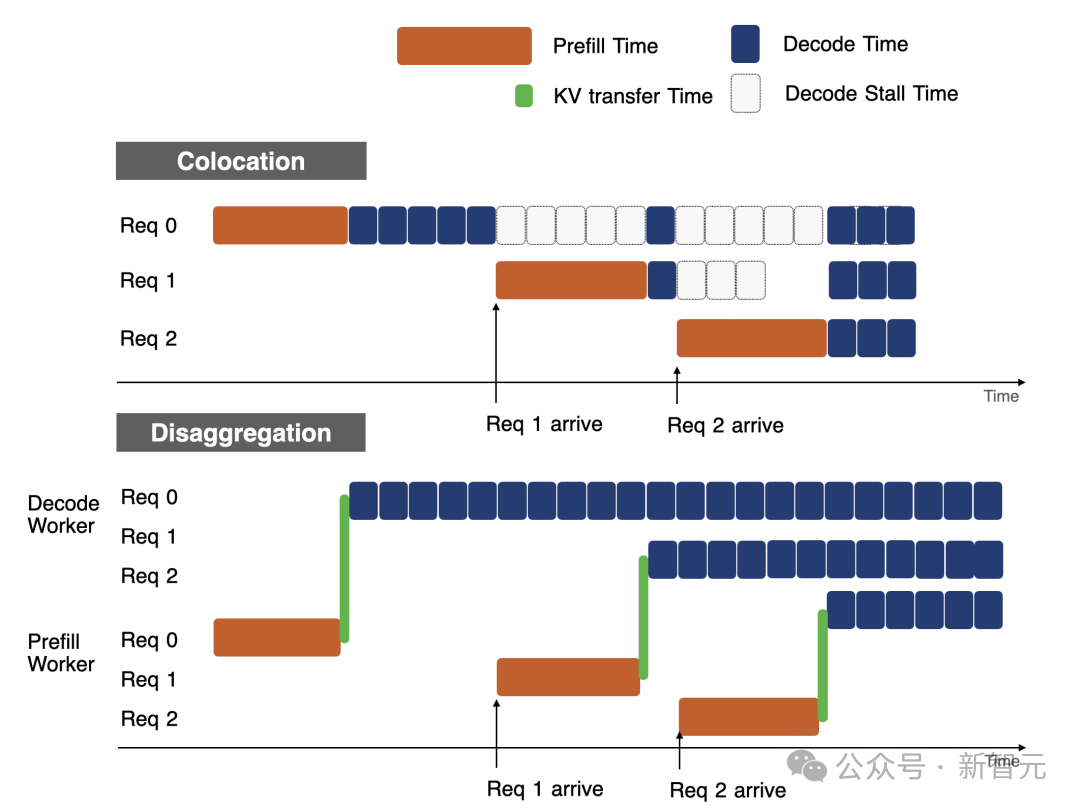

在DistServe出现之前,大多数推理框架都采用「同址部署」方式:

即在同一块GPU上同时执行「预填充」(prefill)和「解码」(decode)阶段。

在每一次推理迭代中,调度器会尽可能将多个用户请求打包成一个批次,运行一轮计算,然后为这些请求各生成一个输出token。

这种称为「连续批处理」技术最早由Orca提出,后由vLLM推广。

这种方法曾因其先进性而成为业界标准做法,但它同时也有两个根本性的限制。

一是干扰。

「prefill」和「decode」共享同一块GPU,它们的延迟(latency)会不可避免地相互干扰。

即使采用了「分块预填充」等缓解措施,一个大型预填充请求仍可能让TPOT(time-per-output-token)膨胀2到3倍,尤其在负载突发时更为明显。

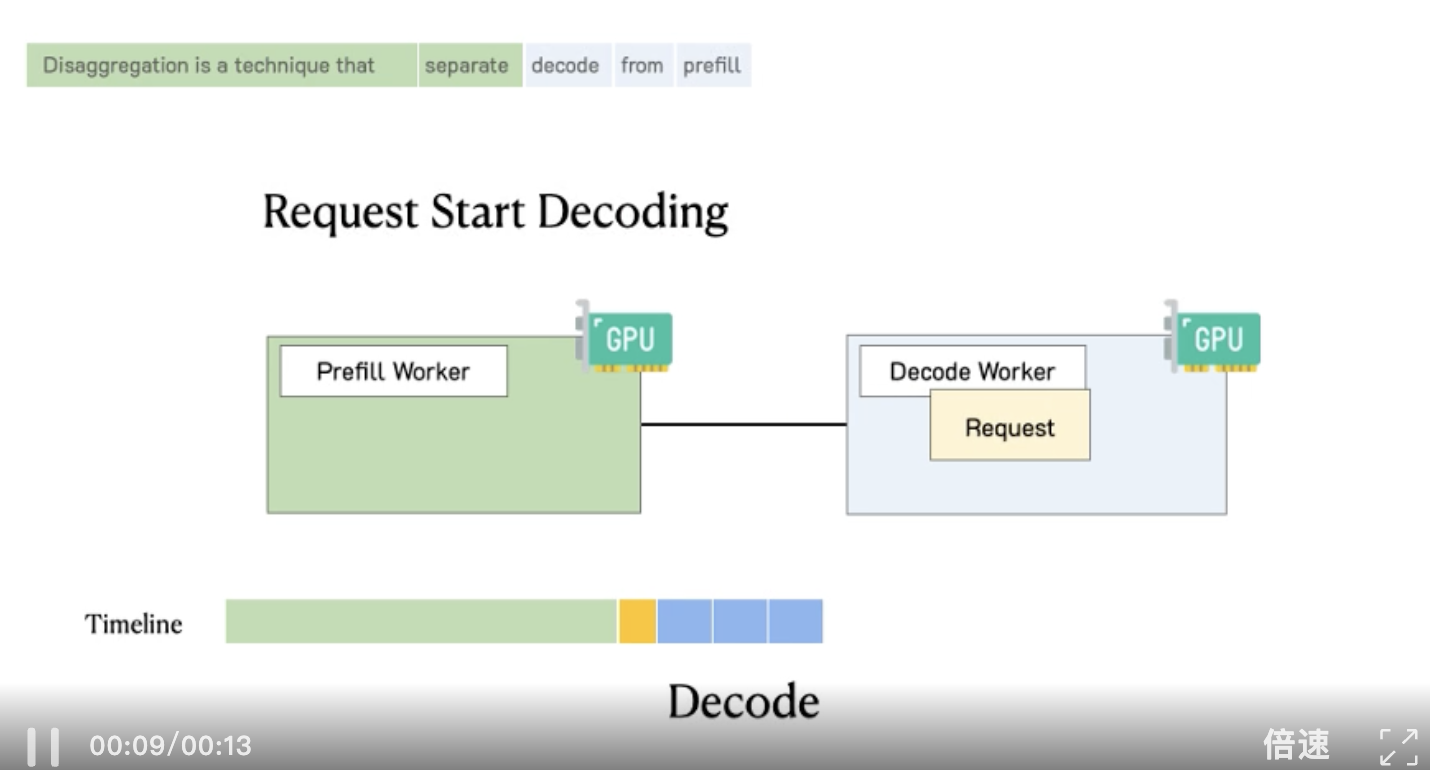

如上图(上),当prefill(橙色)与decode(蓝色)同址部署时,两者互相干扰,导致decode阶段停滞;上图(下),当将prefill与decode分离到不同机器时,两者即可无干扰地顺畅运行。

二是耦合伸缩。

在实际生产环境中,企业级应用通常将TTFT(time-to-first-token)和TPOT视为关键的用户体验延迟指标。

当prefill和decode被部署在同一组GPU上时,资源分配器必须同时满足两种最坏情况的延迟需求。

这意味着系统需要过度预留资源,导致计算资源利用率低下,整体效率不佳。

随着部署规模不断扩大、延迟要求日益严格,以上两个问题产生的成本也随之剧增。

正是这些现实痛点推动了DistServe的出现。

DistServe通过将prefill与decode拆分为独立的计算池,彻底打破二者的干扰,并首次实现了独立伸缩,使其可以各自独立地满足TTFT和TPOT的延迟要求,同时保持高整体效率。

最初推出DistServe时,Hao Zhang团队便认为这将是一个具有颠覆性的想法。

但出乎意料的是,它最初并未获得广泛采用。

在2024年的大部分时间里,开源社区都对这一思路持保留态度,因为对原有推理系统进行深度的架构重构,需要大量工程投入。

然而到了2025年,局面突然发生逆转:几乎所有主流的大模型推理栈都将「解耦」视为默认方案。

首先,主要是由于越来越多企业将大模型作为其核心业务组件,「延迟控制」成为决定业务增长乃至生死存亡的关键因素。

而DistServe正好击中了这一痛点:它让prefill和decode的延迟易于观测和控制,且在真实生产环境中可持续优化。

其次,随着模型体量急剧扩大、访问流量激增,推理系统必须扩展到数百乃至上千张GPU才能支撑这些庞大且变化剧烈的负载。

在这种规模下,「解耦架构」的优势完全显现:它可以为不同阶段独立分配资源,并灵活配合多种并行策略,实现极高的资源利用率。

第三,「解耦」意味着系统架构的可组合性大大增强。

当下的解耦推理

如今,曾被视为激进的架构理念,已经成为大模型推理的主要设计原则之一。

几乎所有与大模型推理相关的生产级框架——从编排层、推理引擎、存储系统,甚至到新兴的硬件架构,都以某种形式采用了这一解耦推理的思想。

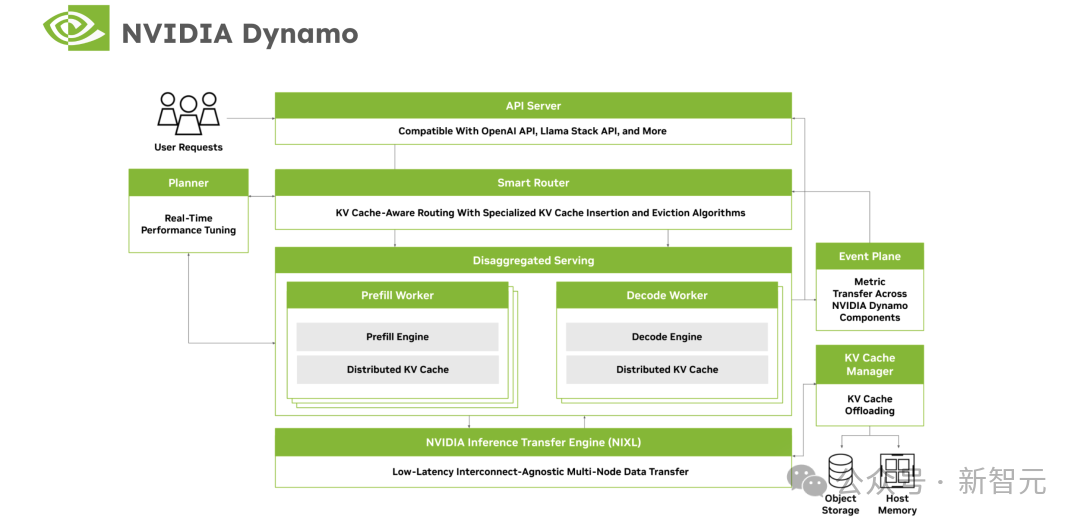

在编排层,最有代表性的是NVIDIA Dynamo。

NVIDIA Dynamo架构示意图

NVIDIA Dynamo是目前最先进、最成熟的开源数据中心级分布式推理框架之一,专为P/D解耦而设计。

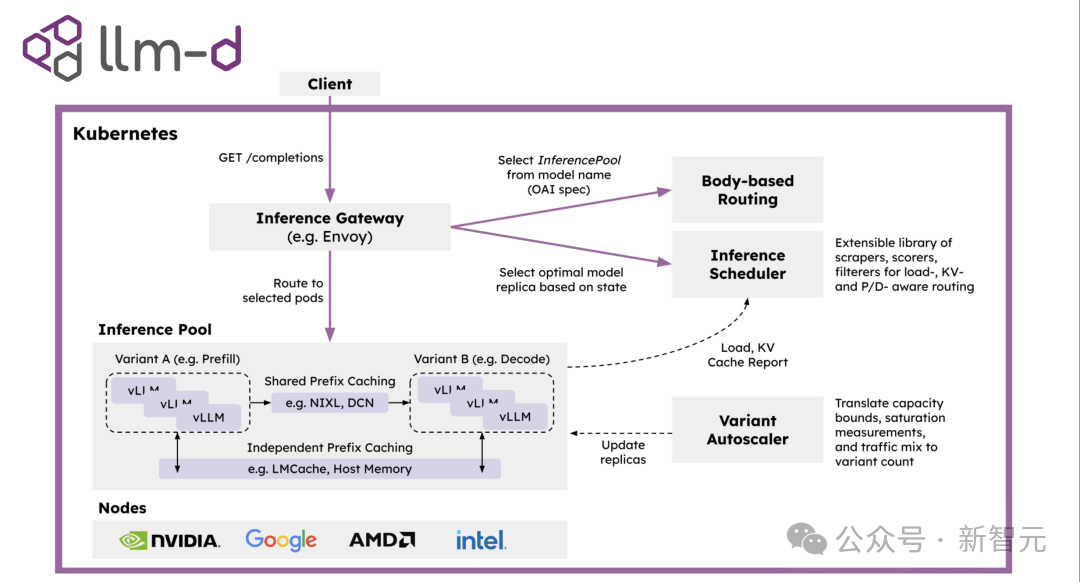

此外,还有llm-d、Ray Serve等都是基于解耦推理架构。

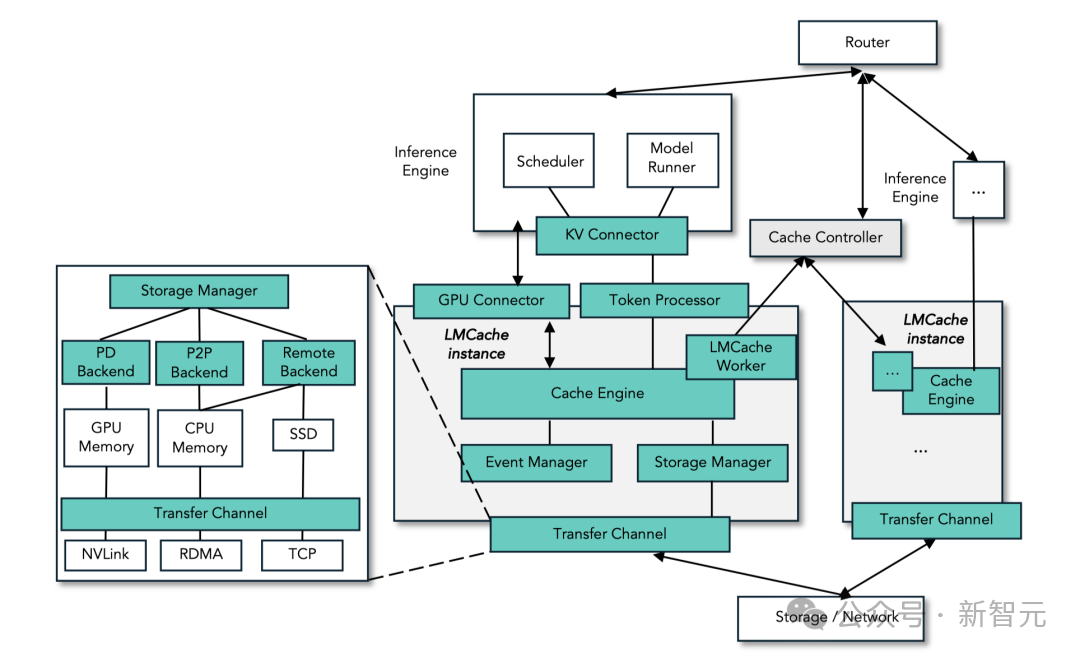

在存储层,由芝加哥大学团队开发的LMCache通过加速从prefill实例到decode实例的KV缓存移动来优化P/D解耦过程。

LMCache架构示意图

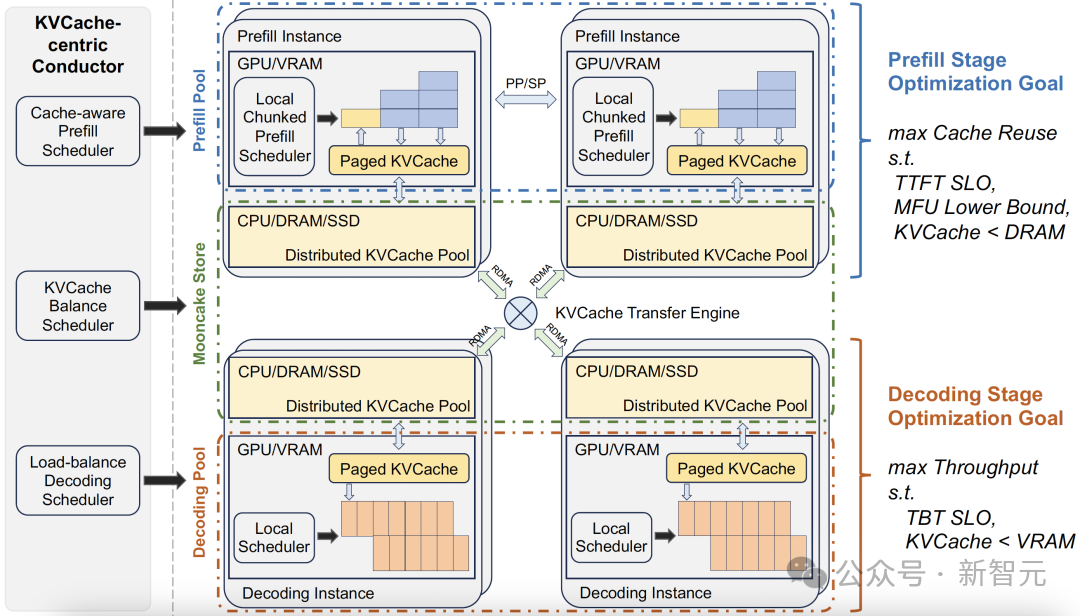

Kimi AI团队开发的MoonCake,以「KVCache中心化」为核心思想,构建了一个面向P/D解耦的LLM推理平台。

它将系统中未充分利用的存储介质统一抽象为一个集中式KV缓存池,从而使prefill实例可以无缝将缓存传输给集群中decode实例。

MoonCake架构示意图

如今,LMCache与MoonCake已成为大规模LLM推理系统的标准存储后端。

在核心引擎层,几乎所有开源的LLM推理引擎,如SGLang与vLLM,都已原生支持「解耦推理」。

解耦推理的未来

「预填充-解码解耦」的推理理念,在2025年已逐渐成熟。

然而,这仅仅是一个起点。

从更长远的角度看,解耦不仅是一种「架构技巧」,更是一种更深层次的系统哲学:

打破神经网络推理中的「计算单体」结构,让系统能够在计算、存储与通信之间实现自由重组。

而学术界和工业界也正在探索多种新方向,推动解耦架构迈向「通用分解式推理(Generalized Disaggregated Inference)」阶段。

计算层面的解耦

1. Attention-FFN解耦(Attention-FFN Disaggregation)

以往的P/D解耦主要解决了「上下文输入与自回归输出」的阶段性分离问题,但模型内部结构仍然被视为不可拆解的整体。

如今,研究者开始尝试在模型层级上细化解耦粒度。

2025年,MIT CSAIL与DeepSeek Research提出了「Attention–FFN Disaggregation」框架,将Transformer的注意力模块(Attention)与前馈层(Feed Forward Network,FFN)分别放置于不同计算节点。

这种架构可以使不同节点利用异构硬件优势。

这意味着未来的推理系统可能不再是「每个节点运行完整模型副本」,而是每个节点运行模型的一个功能子模块。

2. 流水线解耦(Pipeline Disaggregation)

解耦架构的另一种自然延伸,是跨层级的流水线分解。目前已有多个研究团队提出框架,如:

这些系统都尝试让推理过程在不同节点之间以「阶段流」的方式流动,从而实现全局流水线化推理。

这种方式能让不同阶段的计算使用不同类型的加速器,更适合未来多芯片异构系统。

跨模态与多模型的解耦

1. 模态分解

随着多模态大模型的出现,推理系统正面临更复杂的资源编排问题,将它们全部塞入同一推理流程会导致资源利用率显著下降。

因此,未来的趋势是将多模态推理解耦为多个模态子推理流,再在编排层通过调度器进行异步融合。

2. 多模型协同

在推理系统中同时运行多个LLM或专用子模型也变得常见,这些架构天然适合解耦化设计。

内存与缓存体系的解耦

当前的解耦体系仍依赖于「集中式KV缓存池」或「共享SSD集群」,未来的研究方向在于让缓存体系本身也实现多层解耦与自治调度。

1. 层级化缓存架构

MIT与ETH Zürich的研究者提出HiKV(Hierarchical KV Cache)框架,将KV缓存划分为三个层次:

系统根据上下文热度自动迁移KV片段,从而使解耦推理的内存管理更具弹性。

2.存算协同

一些硬件厂商已开始探索原生支持解耦架构的芯片,这意味着未来的「解耦推理」不仅是软件架构问题,而将演化为软硬件一体化体系。

迈向模块化智能

如Google Brain Zürich与FAIR等一些研究团队,提出更加大胆的设想:

既然推理可以解耦,那么训练与持续学习是否也能被解耦?

他们将模型的学习过程被分为多个相互独立的子任务,每个子任务在不同硬件上运行,并通过共享梯度缓存与语义路由器实现跨任务通信。

这种理念被称作「解耦学习」,被视为解决大模型「灾难性遗忘」与「持续适应」问题的潜在关键路径:

目前,Google Zürich团队的内部项目「Hope」模型就是在该思想指导下诞生的。

过去十年,深度学习系统的趋势是「从分散到集中」,所有计算汇聚在单体模型中。

而如今的趋势正在反转:从集中到解耦。

这种演进并非倒退,而是一种成熟的标志,AI系统也正在走向模块化智能,不同功能模块可独立演化、独立扩展、独立优化。

而「解耦推理」正是这一趋势的起点。

未来,或许将看到「解耦学习」「解耦推理」「解耦认知」三者融合的智能架构体系。

参考资料:

https://hao-ai-lab.github.io/blogs/distserve-retro/

文章来自于微信公众号 “新智元”,作者 “新智元”