当我们谈论大型语言模型(LLM)的"强化学习"(RL)时,我们在谈论什么?从去年至今,RL可以说是当前AI领域最炙手可热的词汇。

在过去很长一段时间里,这个词几乎等同于 RLHF(人类反馈强化学习)一种用于"对齐"的技术,它教会模型拒绝有害问题、生成更符合人类偏好的回答。

但最近一年,情况变得微妙起来。

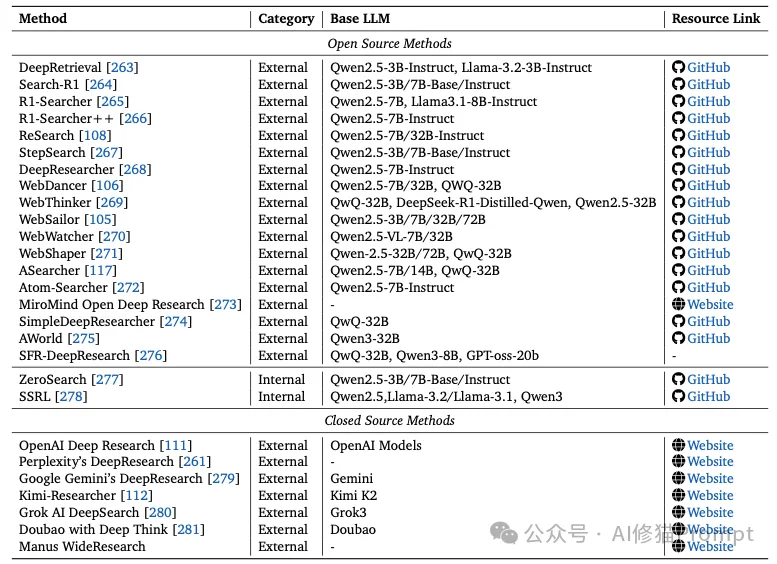

OpenAI的o1/o3、DeepSeek-R1爆火了。它们被称为"推理模型",似乎比以往的GPT更"聪明"。紧接着Kimi-Researcher也火了,它能自己搜索、阅读几十篇文献、写出完整报告。很多人会说:"这不就是模型变强了吗?或者给模型加了搜索功能?这和Agent有什么关系?"

这个疑问,恰恰触及了当前AI领域最核心、也最容易被误解的一个问题:

o1、R1 这些"推理模型",它们到底是"更聪明的LLM",还是已经跨越了某个界限,成为了某种"智能体"?它们背后的RL训练,和传统的RLHF,究竟是不是一回事?

牛津大学9月份发布了一份综合了500多篇近期著作的重磅综述 《The Landscape of Agentic Reinforcement Learning for LLMs: A Survey》 给出了响亮而清晰的回答:它们不是一回事。而且,o1、R1这些模型,从技术本质上看,已经是"智能体"了。尽管它们看起来"只是在对话"。

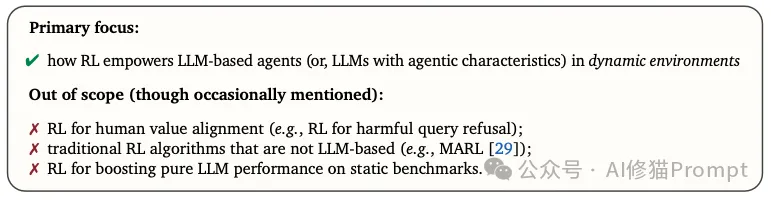

这篇综述的核心价值,就在于它首次为这个正在爆发的新领域进行了严格的“划界”。研究者们在引言中明确了本文的“研究范围”(Scope):

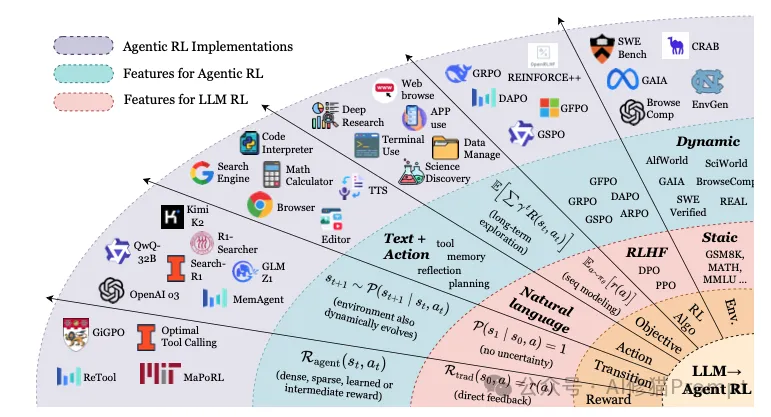

这篇综述将这个新领域定义为“智能体强化学习”(Agentic RL),一个将LLM从“被动生成器”转变为“自主决策者”的全新范式。本文将继昨天的《LLM为什么能替你操作电脑?4个关键技术让AI拥有"操作系统级"能力|Agent和工作流的区别就在这》为您深度剖析这份奠基性的综述,揭示 Agentic RL 是如何系统性地构建规划、工具使用、记忆和反思等核心智能的。

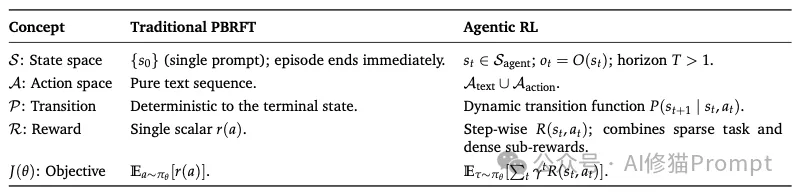

这篇综述的第一个重大贡献,就是在理论上严格区分了“传统 LLM-RL”和“Agentic RL”。

我们熟知的 RLHF(人类反馈强化学习)或 DPO(直接偏好优化)属于前者,它们的目标是“对齐”模型的单次输出。而 Agentic RL 的目标,是训练一个能在动态环境中持续决策的“策略”。

论文通过马尔可夫决策过程(MDP)的形式化语言,精准地揭示了两者在“世界模型”上的根本差异。

核心局限:这种范式本质上仍是“序列建模”,它优化的是“输出质量”,而不是“决策过程”。它无法处理需要多步骤交互、使用工具或适应环境变化的任务。

范式飞跃:Agentic RL 不再是“对齐”一个静态答案,而是在训练一个自主的“策略”。这个策略必须学会在一个充满不确定性的动态世界中,通过一系列思考、行动和观察,来完成一个长期的目标。这正是“智能体”的真正含义。

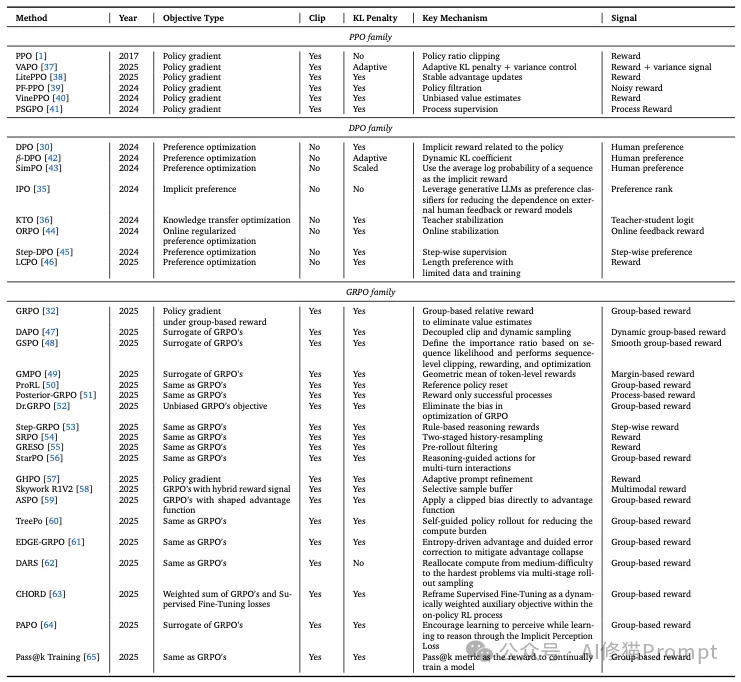

在区分了理论模型后,综述深入探讨了实现 Agentic RL 的核心算法。虽然 PPO、DPO等算法在传统LLM-RL中被广泛使用,但它们在 Agentic RL 范式下,其功能和挑战发生了质的变化。

上表详细对比了 PPO、DPO 和 GRPO 三大家族的几十种变体(如 DAPO, GSPO, Step-DPO 等),清晰地展示了学术界和工业界在“优化效率”和“性能”之间进行的持续权衡。

这篇综述最精彩的部分在于它系统性地回答了一个问题:RL 如何将 LLM 智能体的各个核心能力,从“静态模块”转变为“动态策略”?

这是 Agentic RL 最重要、最成功的应用之一。论文清晰地勾勒了其发展三阶段:

1.ReAct 风格的工具调用:

2.工具集成 RL (Tool-integrated RL, TIR):

3.未来挑战:长时序 TIR (Long-horizon TIR):

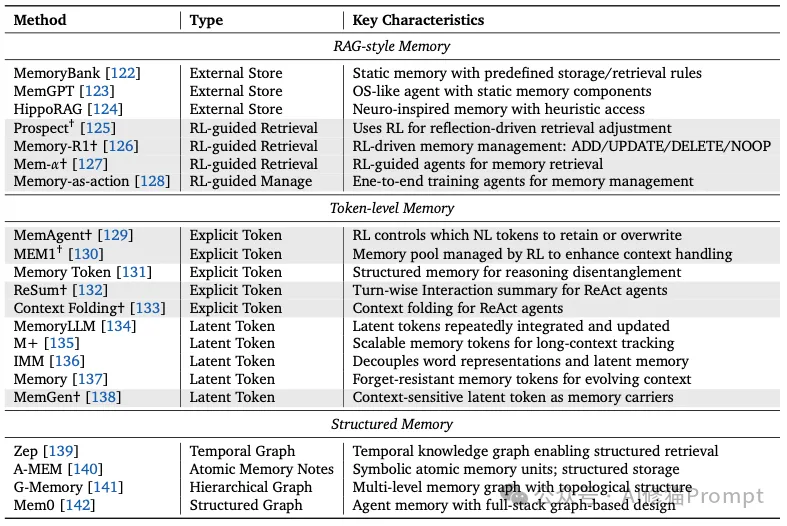

LLM 的“上下文窗口”是有限的。Agentic RL 致力于将“记忆”从一个被动的外部数据库,转变为一个智能体主动学习管理的动态子系统。

1.RL 用于 RAG 风格记忆:

ADD/UPDATE/DELETE/NOOP 等结构化操作,以最大化下游任务(如 QA)的性能。2.RL 用于词元级记忆 (Token-level Memory):

3.未来挑战:RL 用于结构化记忆:

智能体如何“从错误中学习”?RL 提供了将“反思”内化为“本能”的途径。

1.口头自纠 (Verbal Self-correction):

2.内化自纠 (Internalizing Self-correction):

3.迭代自训练 (Iterative Self-training):

对于多模态智能体,RL 不仅用于“看懂”,更用于“主动地看”。

crop, erase, paint 等操作,并通过“好奇心驱动的奖励”来激励其探索。综述继续系统盘点了 Agentic RL 在各大主流任务上的应用。这种分类让我们看到了理论是如何落地为“护城河”的。

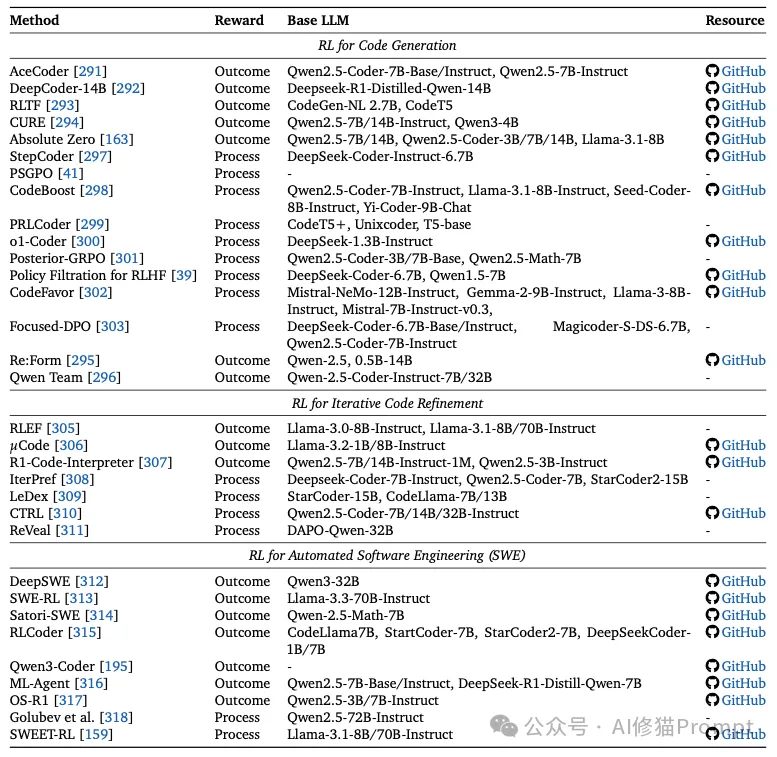

代码任务是 Agentic RL 的“理想试验场”,因为它提供了即时、可靠、可验证的反馈信号(例如编译、单元测试、运行时错误)。

研究者将此领域的方法清晰地划分为两种奖励设计思路:

1.结果奖励 RL (Outcome Reward RL):

pass@k 或单元测试的通过率。2.过程奖励 RL (Process Reward RL):

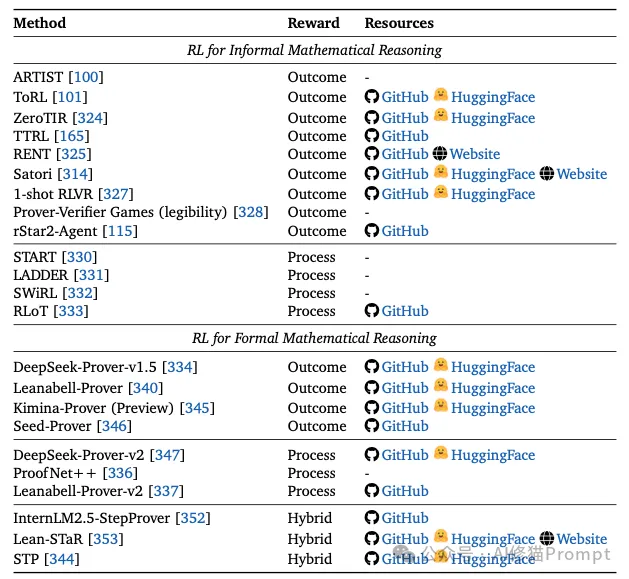

数学推理因其对逻辑一致性和长时序演绎的严格要求,被视为评估智能体推理的“黄金标准”。

1.非形式化数学推理 (Informal Reasoning):

2.形式化数学推理 (Formal Reasoning):

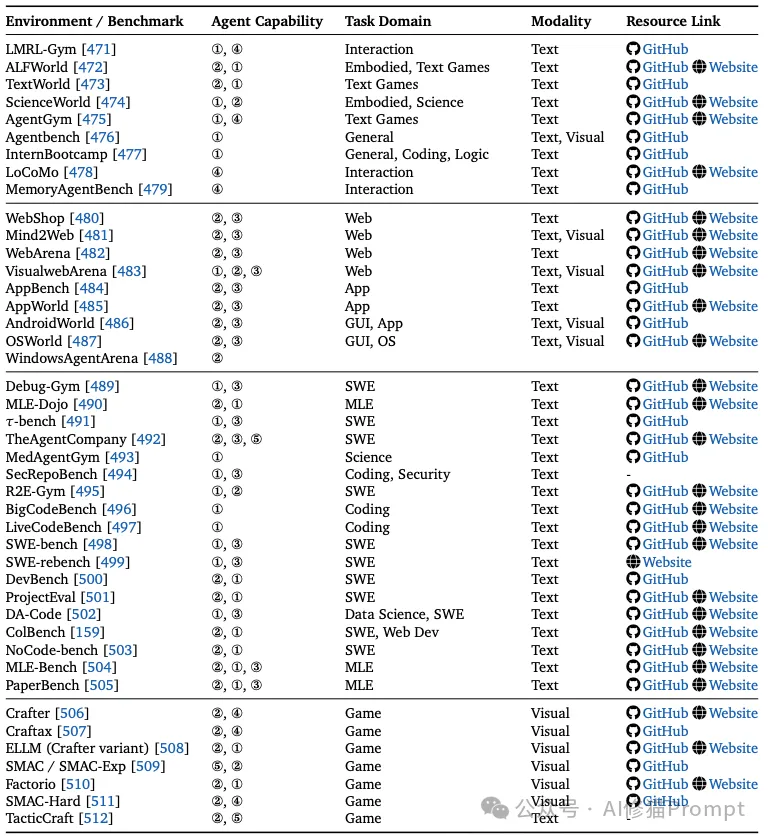

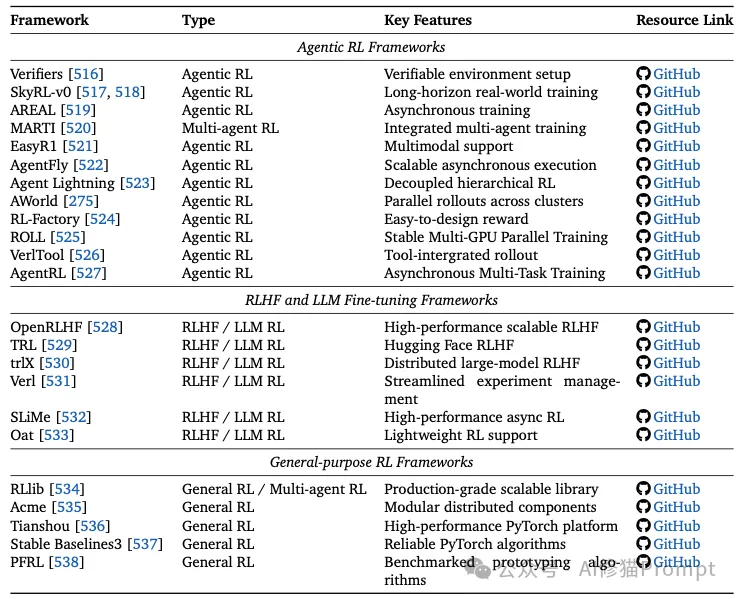

Agentic RL 的蓬勃发展,离不开底层“环境”和“框架”的支持。

这是训练智能体的“健身房”和“考场”。综述将其归纳为几大类:

这是构建智能体的“工具箱”。综述将其分为三类:

1.Agentic RL 专用框架:

2.RLHF & LLM 微调框架:

3.通用 RL 框架:

在绘制了宏伟蓝图之后,综述在快最后的部分以极其冷静和深刻的笔触,指出了 Agentic RL 前进道路上的三大挑战。

Agentic RL 的自主性是一把双刃剑。综述指出,RL 的引入不仅没有解决,反而在某些方面加剧了 LLM 的可信度问题。

1.安全 (Security):

2.幻觉 (Hallucination):

3.逢迎 (Sycophancy):

1.训练规模化 (Scaling up Training):

2.环境规模化 (Scaling up Environment):

在综述的最后,研究者提出了一个关于 Agentic RL 机制的深刻辩论,直指其灵魂:

RL 训练究竟为什么能提升 LLM 的推理能力?

1.“放大器”假说 (The "amplifier" view):

pass@1 的成绩,但模型的“能力边界”(pass@k)并没有真正扩展。2.“新知识”假说 (The "new-knowledge" view):

研究者的结论是:RL 究竟能否真正赋予 LLM 超越其预训练所学的、定性上的新能力,这仍然是一个悬而未决的开放性问题。

这篇综述 以前所未有的广度和深度,为我们系统地绘制了Agentic Reinforcement Learning 这一新兴领域的全景图。它从根本上重新定义了 LLM 的训练目标:从优化“被动的文本生成”(LLM-RL),转向优化“自主的决策策略”(Agentic RL)。

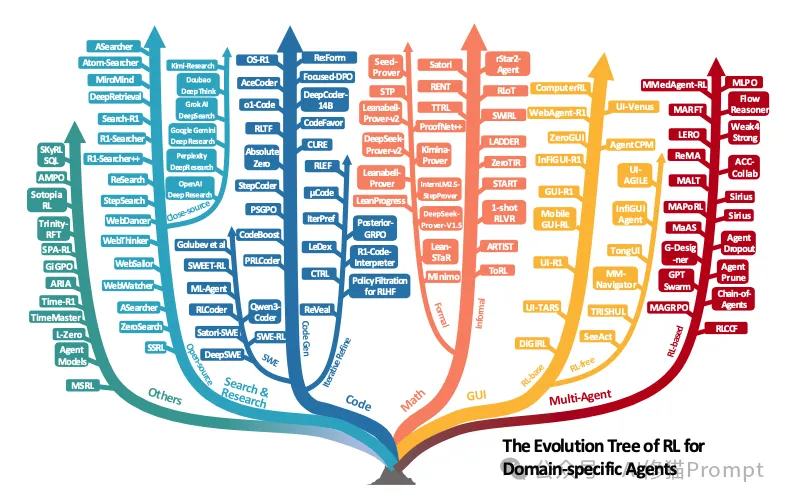

论文通过两大分类法,一个围绕核心智能体能力(规划、工具使用、记忆、反思、感知),另一个围绕关键任务域(搜索、代码、数学、GUI)系统地论证了强化学习(RL)是实现这一范式转变的“关键机制”。

同时,它也深刻地指出了通往这条道路的三大挑战:可信度的内在风险(奖励黑客)、规模化的双重瓶颈(训练与环境),以及机制上的终极疑问(放大器 vs 新知识)。

对于任何希望理解下一代 AI 核心驱动力的工程师、研究者和产品经理而言,这篇综述提供了一张不可或缺的“全景地图”。

文章来自于“Al修猫Prompt”,作者“Al修猫Prompt”。

【开源免费】Browser-use 是一个用户AI代理直接可以控制浏览器的工具。它能够让AI 自动执行浏览器中的各种任务,如比较价格、添加购物车、回复各种社交媒体等。

项目地址:https://github.com/browser-use/browser-use

【开源免费】字节工作流产品扣子两大核心业务:Coze Studio(扣子开发平台)和 Coze Loop(扣子罗盘)全面开源,而且采用的是 Apache 2.0 许可证,支持商用!

项目地址:https://github.com/coze-dev/coze-studio

【开源免费】n8n是一个可以自定义工作流的AI项目,它提供了200个工作节点来帮助用户实现工作流的编排。

项目地址:https://github.com/n8n-io/n8n

在线使用:https://n8n.io/(付费)

【开源免费】DB-GPT是一个AI原生数据应用开发框架,它提供开发多模型管理(SMMF)、Text2SQL效果优化、RAG框架以及优化、Multi-Agents框架协作、AWEL(智能体工作流编排)等多种技术能力,让围绕数据库构建大模型应用更简单、更方便。

项目地址:https://github.com/eosphoros-ai/DB-GPT?tab=readme-ov-file

【开源免费】VectorVein是一个不需要任何编程基础,任何人都能用的AI工作流编辑工具。你可以将复杂的工作分解成多个步骤,并通过VectorVein固定并让AI依次完成。VectorVein是字节coze的平替产品。

项目地址:https://github.com/AndersonBY/vector-vein?tab=readme-ov-file

在线使用:https://vectorvein.ai/(付费)

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md

【开源免费】graphrag是微软推出的RAG项目,与传统的通过 RAG 方法使用向量相似性作为搜索技术不同,GraphRAG是使用知识图谱在推理复杂信息时大幅提高问答性能。

项目地址:https://github.com/microsoft/graphrag

【开源免费】Dify是最早一批实现RAG,Agent,模型管理等一站式AI开发的工具平台,并且项目方一直持续维护。其中在任务编排方面相对领先对手,可以帮助研发实现像字节扣子那样的功能。

项目地址:https://github.com/langgenius/dify

【开源免费】RAGFlow是和Dify类似的开源项目,该项目在大文件解析方面做的更出色,拓展编排方面相对弱一些。

项目地址:https://github.com/infiniflow/ragflow/tree/main

【开源免费】phidata是一个可以实现将数据转化成向量存储,并通过AI实现RAG功能的项目

项目地址:https://github.com/phidatahq/phidata

【开源免费】TaskingAI 是一个提供RAG,Agent,大模型管理等AI项目开发的工具平台,比LangChain更强大的中间件AI平台工具。

项目地址:https://github.com/TaskingAI/TaskingAI

【开源免费】MindSearch是一个模仿人类思考方式的AI搜索引擎框架,其性能可与 Perplexity和ChatGPT-Web相媲美。

项目地址:https://github.com/InternLM/MindSearch

在线使用:https://mindsearch.openxlab.org.cn/

【开源免费】Morphic是一个由AI驱动的搜索引擎。该项目开源免费,搜索结果包含文本,图片,视频等各种AI搜索所需要的必备功能。相对于其他开源AI搜索项目,测试搜索结果最好。

项目地址:https://github.com/miurla/morphic/tree/main

在线使用:https://www.morphic.sh/

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner

【开源免费】LangGPT 是一个通过结构化和模板化的方法,编写高质量的AI提示词的开源项目。它可以让任何非专业的用户轻松创建高水平的提示词,进而高质量的帮助用户通过AI解决问题。

项目地址:https://github.com/langgptai/LangGPT/blob/main/README_zh.md

在线使用:https://kimi.moonshot.cn/kimiplus/conpg00t7lagbbsfqkq0