字节新视频模型Vidi2,理解能力超过了Gemini 3 Pro。

不仅会看还会“剪”,能根据数小时的素材和一个提示,生成JSON剪辑指令。

剪辑位置、台词、字幕、配乐等内容都完整涵盖,“照方抓药”之后效果be like:

这下子,电影里的小帅小美高光时刻,也能用AI批量生成了(手动狗头)。

Vidi2还能像剪辑师一样帮你处理素材。你只需要把一大堆原始素材给它,再说个大概的创意方向,它就能自己去构思剧本。

它会生成一份非常详细的剪辑清单,精确规定好每个镜头截取哪几秒、播放速度是多少、字幕用什么样式,连配合画面的吐槽旁白都会自动写好。

最后你只要照着这份清单渲染,就能直接导出一支有剧情、有配乐、有特效的完整视频。

能够实现这一操作的基础在于,Vidi2在视频理解上的表现确实很突出。

以往的模型可能只能告诉你某个画面大概出现在第几分钟,但Vidi2不仅能把时间段卡得很准,还能直接在画面上画个框,把你要找的人或物体实时圈出来。

这种精细的定位能力在处理长视频时非常关键,哪怕视频长达半小时,或者画面里的物体很小、运动很快,它也能稳稳地跟住。

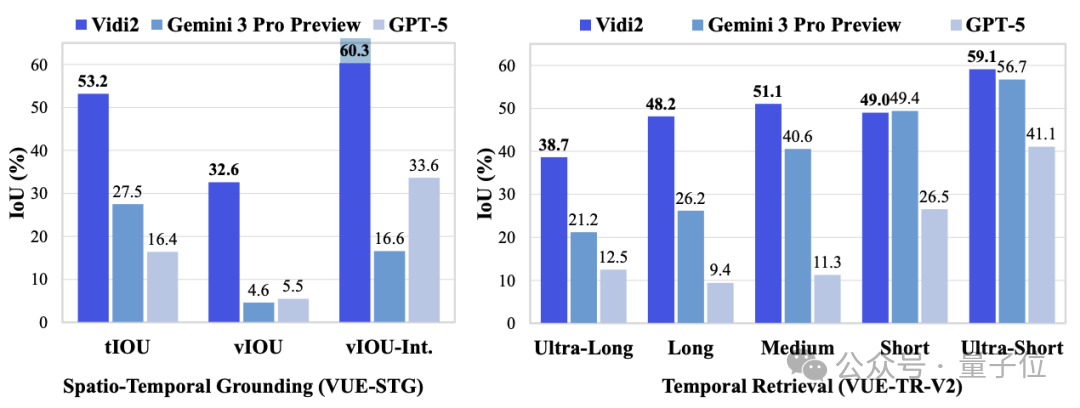

从测试结果来看,它在这些任务上的准确度比GPT-5和Gemini 3 Pro都要高不少,基本解决了长视频里找不到关键细节的问题。

具体来说,Vidi2在核心的时空定位任务上取得了压倒性优势,其衡量时空对齐精度的关键指标(vIoU-Int.)高达60.3%,几乎是GPT-5(33.6%)的两倍,更是远超Gemini 3 Pro Preview(16.6%)。

特别是在超长视频处理上,Vidi2具有极高的稳定性,当视频时长超过一小时,Vidi2依然能保持38.7%的检索精度。

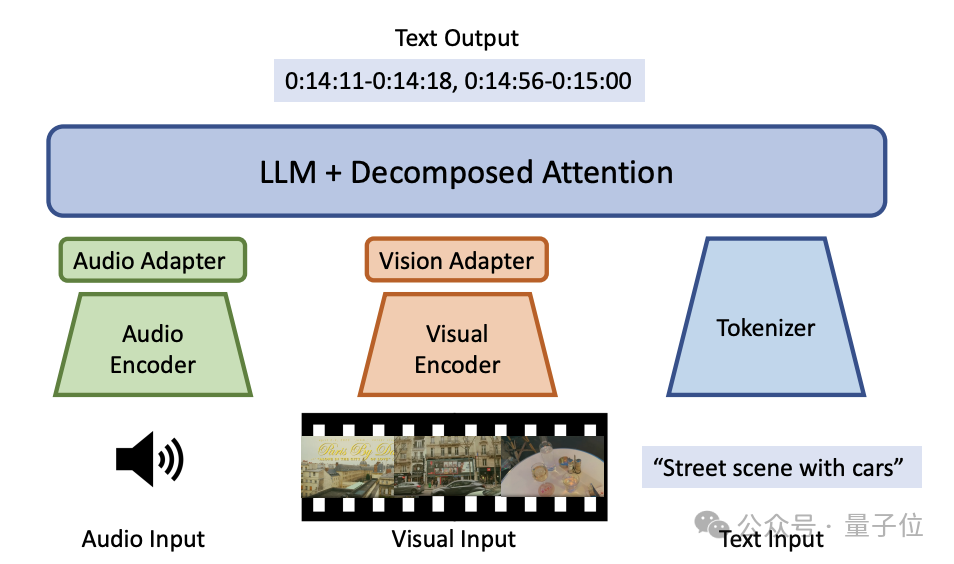

Vidi2最核心的技术突破在于实现了端到端的时空定位能力。

它能够在统一的输出中精准锁定目标事件的时间片段并同步生成空间边界框轨迹,从而解决长视频中复杂对象的持续追踪难题。

数据进入模型后,首先通过统一的编码接口进行处理,单张静态图像被直接视为时长为一秒的静音视频。

针对视频时长从十秒到三十分钟不等的跨度,模型采用了重新设计的自适应Token压缩策略,根据视频总时长动态调节信息密度,在处理短视频时保留高密度特征,面对长视频时则通过压缩降低负载。

经过编码与压缩的特征流随即进入模型核心。

Vidi2以Vidi1的架构为基础,将其中的模型替换成了Google最新的开源模型Gemma-3,并配合增强的视觉编码器构建起参数量达120亿的底座。

其关键是采用了分解注意力(Decomposed Attention)机制,把传统Transformer的全注意力运算拆解为视觉内部的对角注意力、文本自注意力及跨模态注意力三个独立部分。

该机制将多模态Token的计算复杂度从平方级降低为线性级,使模型能以有限显存处理长达一小时的视频流。

为了解决时空定位数据极度稀缺的难题,研发团队还设计了一套独特的数据合成路径,利用现有量图像级空间定位数据,通过滑动窗口算法来处理静态图像,在图像上模拟摄像机的运动轨迹。

这一过程将原始图像中的静态边界框动态映射到生成的每一个视频帧中,从而自动生成了随时间连续变化的边界框序列,在数据构造层面直接实现了将静态的空间定位扩展为动态的时间对齐。

此外,训练流程还引入了大量经过高精度人工标注的真实世界视频数据,以修正合成数据可能带来的分布偏差并进一步提升定位精度。

在最终训练阶段,Vidi2采用了时间感知多模态对齐策略(Temporal-aware Multimodal Alignment)。

这是一种分阶段、双向强化的训练机制,首先在合成与真实数据训练中,利用双向预测任务——根据时间戳预测密集字幕,以及根据文本反推时间范围——来训练模型对时间边界的敏感度。

随后在后训练阶段,融入了大量通用视频问答数据,通过回答开放式问题来验证并强化模型在视觉、听觉与文本之间的深层语义关联。

总之,在Vidi2当中,数据确实扮演了很重要的角色,如这位网友所说,谷歌Gemini和Veo 3做的好,是因为手里有YouTube当中的视频数据。

而手握大量短视频的字节,同样拥有自己的数据优势。

更多的数据,意味着更强大的模型,AI竞争的下一场,就看谁能拥有更多更好的数据了。

项目主页:

https://bytedance.github.io/vidi-website/

技术报告:

https://arxiv.org/abs/2511.19529

文章来自于“量子位”,作者 “克雷西”。