在通往AGI的狂欢中,图灵奖得主Yann LeCun却一直像个执着的「反叛者」。

他不止一次给大语言模型(LLM)泼冷水,直言靠预测下一个字符的概率游戏,永远无法触及真正的智能。

他眼中的未来,属于「世界模型」。

直到李飞飞团队World Labs发布的Marble,当大家亲眼看到那个可以生成、互动且符合逻辑的3D虚拟世界时,LeCun描绘的图景才终于具象化了。

为什么实现AGI需要世界模型

为什么我们如此迫切地需要世界模型?

因为基于大语言模型的AI在物理世界里,是个严重的「偏科生」。

现实数据的采集太苦、太慢了!

教会机器人认识一件红衣服,换成绿色的它可能就「懵」了;

更别提那些极端场景——我们总不能为了训练自动驾驶,真去撞毁一千辆车吧?(还有更多低概率的corner case)

于是,一场围绕物理世界的「数字重构」悄然打响,并分化出三大战场:

而第三个战场——具身智能,则是目前最难啃的「硬骨头」。

这个领域正撞上一堵看似不可逾越的「数据墙」。

长期以来,行业被迫依赖「遥操作」——让人类穿戴设备手把手教机器人。

这种方式不仅效率低、成本高,更致命的是泛化性极差。

而在尝试用AI生成数据时,又会掉进另一个深坑:物理因果一致性。

以往的模型生成的视频,往往只是「看起来像」。

但在机器人眼里,杯子凭空悬浮、水流违背重力,这些缺乏物理常识的画面不仅无用,甚至是毒药。

如何让AI生成的世界既逼真又符合物理定律?

这成了阻挡AGI降临现实的最大路障。

而一家刚刚成立的公司大晓机器人,率先突围,交出了一份颠覆性的答卷——开悟世界模型3.0。

开悟3.0是一种全新范式的确立:多模态理解-生成-预测一体化。

与传统大模型「看图说话」的浅层逻辑不同,开悟3.0拥有极强的物理感知力。

它不仅能输入文字、图片、视频,更能直接输入力学信息与3D轨迹。

大晓的破局

我们有幸直接采访到了商汤联合创始人、执行董事,大晓机器人董事长王晓刚先生。

他毕业于中科大少年班,接着取得香港中文大学的硕士学位和MIT的计算机博士学位。

大晓机器人董事长 王晓刚

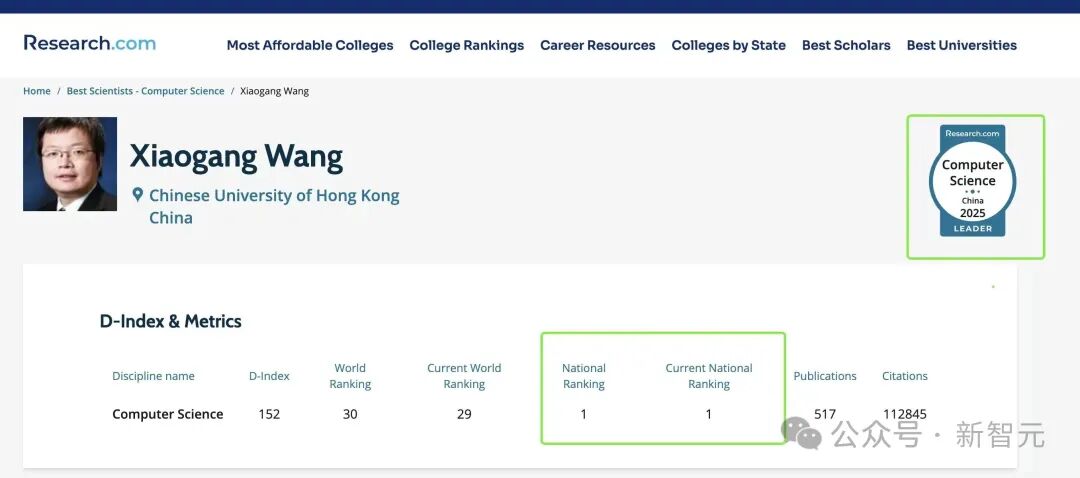

他的论文被引数已超过14万,也是中国的AI学术领军人物之一。

能力越大,责任越大。目前,王晓刚同时担任香港中文大学教授、商汤科技联合创始人、执行董事,以及最新也是最重要的身份:大晓机器人董事长。

具身智能不能依赖「遥操作」

在我们与王晓刚的深度对谈中,他抛出了一个令行业深思的观点:

如果具身智能继续依赖「遥操作」,那我们实际上是倒退回了AI 1.0时代。

目前的机器人训练场上,最常见的画面是:一个穿戴着VR设备和动作捕捉服的人类,「附身」在机器人身上,笨拙地教它叠衣服、拿苹果。

这种被称为「遥操作」的方法,本质上还是「有多少人工,就有多少智能」。

它是线性的、昂贵的,且极度缺乏泛化能力。

王晓刚在采访中一针见血地指出:

你不可能为了教机器人做饭,让几百万人都穿上动捕服去炒菜。

大晓的核心竞争力,在于它率先试图终结这种「提线木偶」式的训练逻辑。

他们提出了一套名为「环境式数据采集」的新范式。

大晓不强求「手把手」教机器人,而是让AI像人类婴儿一样,通过「观察」来学习。

利用第一视角(如AR眼镜)和第三视角(环境摄像头)采集的数据同时生成海量的运动轨迹,配合他们引以为傲的视觉算法,直接从人类的日常行为中提取「操作逻辑」。

这意味着,当AI看了一万遍人类厨师颠勺的各个角度视频后,它学到的不再只是像素的移动,而是手腕发力的角度、锅铲与锅底摩擦的力反馈,以及火焰与食材互动的物理节奏。

开悟3.0:世界第一梯队的世界模型

如果说环境式数采解决了「看」的问题,那么大晓即将发布的开悟3.0,则解决了「想」的问题。

在采访中,王晓刚并没有使用晦涩的术语堆砌,而是用一种近乎哲学的视角,拆解了这个被其称为「全球首个开源且商业落地的世界模型」背后的技术野心。

Puffin:当AI学会「与相机共思」

「传统的视频生成模型,其实是“盲”的。」王晓刚拿起桌上的矿泉水瓶,向我们演示,「AI看到这个瓶子,但它不知道自己是站着看、蹲着看,还是倒立着看。它只是在机械地预测下一帧的像素。」

这种视角的缺失,导致了一个致命问题:空间感的崩塌。

为了解决这个痛点,大晓联合南洋理工大学等机构,祭出了一项名为Puffin的杀手锏技术。

这项技术的核心理念极其浪漫——「与相机共思」。

论文地址:https://arxiv.org/abs/2510.08673

Puffin把「相机的位姿」变成了一种语言。

在它的眼里,光圈、焦距、拍摄角度,和「一只猫」、「一个苹果」一样,都是可以被理解和生成的Token。

「当你给Puffin一张照片,它不仅能看懂照片里有什么,还能像福尔摩斯一样,反推出拍摄者当时站在哪里、相机是怎么运动的。」王晓刚解释道,「这意味着,机器人不再是被动地接收画面,而是能主动“脑补”出——如果我往左走一步,我会看到什么。」

这种能力让具身智能第一次拥有了「预演」的能力。

在真正伸出机械臂去抓那个易碎的玻璃杯之前,机器人已经在脑海中不仅模拟了抓取的动作,还模拟了摄像头在移动过程中看到的光影变化。

WorldMEM:打破「金鱼记忆」的魔咒

除了空间感,具身智能面临的另一大梦魇是「时间」。

现有的视频生成模型,往往有着严重的「健忘症」。

生成的视频超过几秒钟,画面就会开始崩坏:背景里的房子突然消失,或是人物的衣服颜色变来变去。

「想象一下,机器人要帮你整理房间。」王晓刚举了一个非常生活化的例子,「它把一本书放进书架的第二层,然后转身去收拾桌子。十分钟后,当它再转回来时,那本书必须还在那里,不能凭空消失,也不能变成一只猫。」

这看似简单的「物体恒常性」,对AI来说却是巨大的挑战。

因为随着时间的推移,计算量会呈指数级爆炸,AI只能被迫「遗忘」。

为了打破这个魔咒,大晓引入了WorldMEM架构,并采用了创新的线性注意力机制。

论文地址:https://arxiv.org/abs/2504.12369

这就像是给机器人装上了一个「无限容量」的记事本。

通过线性复杂度算法,大晓将计算成本从Transformer架构的指数级降到了线性级。

「我们不仅让机器人“记得住”,还让它知道“记什么”。」王晓刚补充道,这种基于任务导向的长时记忆,让开悟3.0能够生成长达数分钟、甚至更长时间的连贯交互视频。

这一能力被具象化为一组震撼的参数:支持生成1080P高清视频、支持长时交互、甚至可以在动/静态场景下实现精细可控的自由编辑。

大晓生成的不仅仅是视频,而是一个可以被反复推演、试错的平行时空。

对标全球:除了造景,更需要交互

当被问及与李飞飞团队的World Labs有何不同时,王晓刚展现出了技术派特有的自信。

「World Labs发布的Marble,更多是在生成一个静态的、唯美的3D场景,像是一个精美的游戏建模。」王晓刚分析道,「但世界是动态的。你推一下椅子,椅子会倒;你打开冰箱,灯会亮。这种动态的物理交互,才是具身智能的刚需。」

开悟3.0采用了一种独特的「多模态理解-生成-预测」一体化架构。

它不仅把静态的物体(如桌子)和动态的物体(如行人)分离开来,还能直接输入力学信息。

「未来的机器人,要有直觉。」王晓刚说道,「它看到一个玻璃杯,不需要摸就知道它是滑的、易碎的;看到一个哑铃,就知道它是重的。这种物理常识的涌现,只能来自于对真实物理世界的深度模拟。」

在这个意义上,开悟3.0不仅是一个造梦机器,更是一个严谨的物理模拟器。

它让机器人在虚拟世界中经历了成千上万次的「摔打」,从而换来现实世界中的一次精准操作。

软硬一体的「阳谋」

为什么王晓刚要做「大晓机器人」这样一家独立的实体?

这背后藏着王晓刚对AI未来的终极判断:当互联网数据枯竭时,物理世界是唯一的矿藏。

纯粹的软件公司(如OpenAI)就像「缸中之脑」,虽然智商超群,但没有触觉,不懂轻重;

纯粹的硬件公司虽然四肢发达,但缺乏通用的认知能力,往往沦为昂贵的玩具。

大晓的成立,就是为了打破这层次元壁。

他们不仅仅是在做算法,更是在通过自研的「具身超级大脑模组」和四足/通用机器人,去亲自丈量物理世界的摩擦力、重力和反作用力。

这种「软硬一体」并非简单的堆砌,而是一种深度的数据闭环:

这一闭环一旦跑通,大晓就拥有了类似特斯拉那样的「飞轮效应」——机器人用得越多,物理常识越丰富;物理常识越丰富,机器人越好用。

正如王晓刚所言:

未来的机器人,不仅要有聪明的大脑,还要有有趣的灵魂。

而这个灵魂,只能诞生于真实世界泥泞的道路上,而不是凉爽的机房里。

世界模型的「DeepSeek」

在通往具身智能终极形态的征途上,大晓选择了一条更为艰难、但也更为宽广的道路。

当全球科技巨头倾向于构筑技术壁垒时,大晓坚定地高举起开源的旗帜,做出了最具魄力的回应。

开悟3.0的开源,不仅仅是大晓技术自信的体现,更是一场构筑全球具身智能生态的「阳谋」。

正如DeepSeek在大语言模型领域掀起的开源风暴,大晓正立志成为世界模型领域的DeepSeek,打破闭源神话,将最顶尖的物理智能能力赋予全球开发者。

在这场物理世界的智慧革命中,大晓不仅是破局者,更是连接者,与全行业共创具身智能落地的辉煌未来。

大千世界,晓识万象。

文章来自于微信公众号 “新智元”,作者 “新智元”